практическая работа №6

реклама

ПРАКТИЧЕСКАЯ РАБОТА №6

ИНФОРМАЦИОННО-ЭНТРОПИЙНЫЙ АНАЛИЗ

СИГНАЛОВ

Цель работы: изучить понятие информации, энтропии сигналов и

научиться вычислять их количественные значения в системе MATLAB.

Понятие информации

Согласно

общепринятой

терминологии

будем

пользоваться

следующим определением информации.

Слово «информация» имеет различный смысл. Общественнополитическая информация представляет собой совокупность сообщений

об актуальных новостях социальной системы. В кибернетике понятие

информации связано с хранением, обработкой и передачей сигналов. В

теории

вероятностей

информация

вводится

как

аддитивная

количественная мера сравнения вероятностей случайных событий

относительно друг друга. В основе всей теории информации лежит

открытие, что информация

допускает количественную оценку. В

простейшей комбинаторной форме эта идея была выдвинута Р.Хартли в

1928 году, но завершенный вид ей придал К. Шеннон в 1948 году.

Шенноновская теория информации исходит из элементарного

альтернативного выбора между двумя знаками (битами) О и L, где L

может отождествляться с 1, "да", "истина" и т.п., а О с 0, "нет", "ложь".

Такой выбор соответствует приему сообщения, состоящего из одного

двоичного знака, и, тем самым, мы снимаем имеющуюся

неопределенность в выборе.

Количество информации, содержащее в таком сообщении,

принимается за единицу и также называется битом. Так что бит – это и

двоичный знак, и единица измерения количества информации,

определяемая как количество информации в выборе с двумя

взаимоисключающими равновероятными исходами.

Пусть

X {x1 , , xi , , xN }, Y { y1 , , y j , , y N }

(1)

– наборы переменных, характеризующих состояния соответствующих

систем, обозначенных теми же буквами Х, Y. Если P( xi / yi ) – вероятность

того, что при состоянии xi системы X система Y переходит в состояние y j

(условная вероятность), то информация, получаемая Y равна

I xi / yi log Pxi / yi .

(2)

Число I xi xi I xi называется количеством информации I xi ,

заключающейся в событии xi системы X. Величина I всегда положительна,

т.к. 0 P 1 . В зависимости от выбора основания логарифма количество

информации может измеряться в битах, дитах и натах, соответственно, в

случаях двоичных, десятичных и натуральных логарифмов.

Если состояния хi и yi систем Х и Y независимы, то I xi yi = 0:

состояние уi системы Y не несёт в себе никакой информации относительно

Х и наоборот. В этом случае выполняется равенство

I xi y i I y i xi .

Информация от одновременной реализации независимых состояний хi и yi

систем Х и Y определяется как:

I xi y i I xi I y i .

(3)

Выражение (3) можно ввести как условия, выражающее свойство

аддитивности информации. Из (2) следует важный, единственно

универсальный смысл информации: информативными являются события с

малой априорной (теоретической, доопытной) вероятностью. Другими

словами, много информации несут в себе неожиданные события. Этот

вывод не относится к уникальным (редким), неповторяющимся событиям.

Энтропия вычисляется по формуле:

S

P ln P ;

i

i

Pi Pi ( Ei ).

(4)

i

Энтропия, определенная по формуле (4), называется информационной

энтропией. Информация о величине X при задании Y определятся

равенством

I(X) = S(X) – S (X/Y).

(5)

Виды импульсов

Представим импульсный сигнал определенной формы – структуру в

виде

xˆ t

xt T

,

xm T

0 xˆ t 1,

0

t

T

1,

(6)

где xm t – максимальная амплитуда сигнала xt T – длительность импульса

по времени t. Для колебательных процессов с симметрией по t функция

x̂t описывает изменение относительного значения модуля xt внутри

полупериода, т.е. T имеет смысл полупериода.

Реализацию произвольной длительности xt можно представить через

набор структурных функций x j t в виде

xt xˆ j t Tk 1

k

j

(7)

,

k

где k – целые случайные числа. Вид структуры одного типа

определяется как

1 N

k

xt Tk 1

N N

k 1

xˆ t lim

.

(8)

Формулы (7), (8) наглядно иллюстрируют необходимость знания свойств

импульсов (временных структур) для теории и практики актуальных

проблем как выделение сигнала из шума, структурное осреднение и т.д.

Выбор значений Tk представляет отдельную задачу. Мы рассмотрим

общие статистические закономерности импульсов, считая известным Т в

(6).

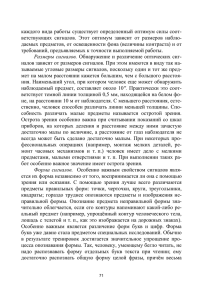

Ниже представлены виды и типы различных импульсов xˆ i t при T =1.

Таблица 1. Виды импульсов

Вид импульса

1 sign(sin(t))

i

2

3

4

5

6

xˆ i t

sin n t ,

n = {0,005; 0,01;

0,025; 0,05; 0,1; 0,2; 0,5}

sin t

arcsin sin t

arcctgtg t

1

t2

2

, const

2

exp

7

ch2 t

8

2 exp at / 2 sin t (4 b b exp at

, a,b=const

9 численные реализации

1

2

Тип импульса

прямоугольны

й

синусоидальны

й,

преобразованн

ый

синусоидальны

й

треугольный

пилообразный

колоколообраз

ный

солитоноподоб

ный

решения

уравнения Вандер-Поля

решения

уравнения ГИН

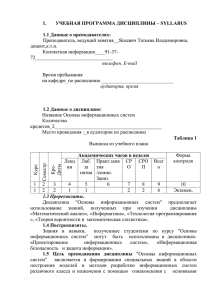

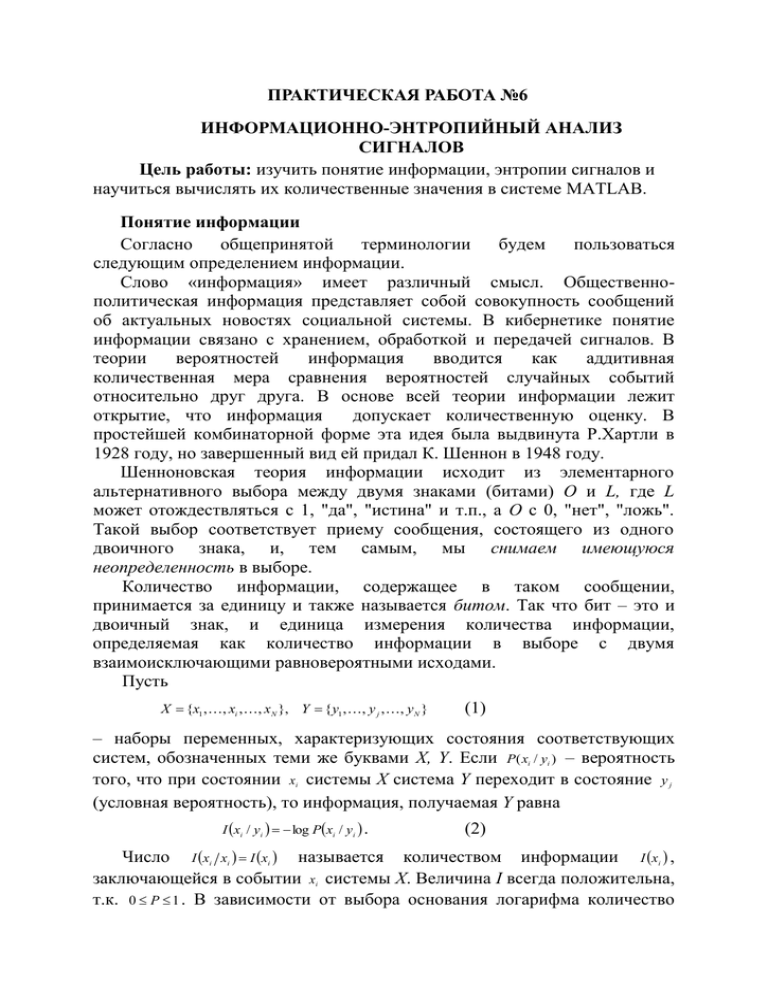

На рис. 1 показаны формы импульсов из табл. 1.

1

2

x/xm

3

4,5

6

7

t/T

Рис. 1. Форма сигналов с их нумерацией в соответствии с табл.1

Можно заметить, что кривые, расположенные выше биссектрисы, в

начальные моменты времени имеют простую форму, а расположенные

ниже биссектрисы – могут иметь простую или сложную форму. Для

количественного описания степени сложности импульсов воспользуемся

определениями коэффициента формы k2(x, t) и информационной энтропии

S в виде

x t

2

k 2 x, t

1/ 2

x t t

t

2

,

1/ 2

S Pi ln Pi ,

(9)

(10)

i

где <|x|> – среднее значение модуля реализации, Pi(δ) – вероятность

реализации x(t) в ячейке δ с номером i,.

Ниже приводится пример программы вычисления коэффициента

формы сигнала и информационной энтропии.

% Листинг файл-программы для чтения файл-функции

% (таблица.1), вычисления коэффициента формы и

% информационной энтропии сигналов. Результаты

% программы записываются в виде текстового файла.

clear;

format long;

h = 0.001;

N = 10000;

% ----- для треугольного сигнала ----Tt = [0:1/N:1];

Tx = asin(sin(pi*Tt));

mxTx = max(Tx);

mnTx = min(Tx);

% график треугольного сигнала

figure(1)

plot(Tt,Tx,'-r');

% ----- энтропия для треуг. сигн. ---xt = [mnTx:h:mxTx];

[nt,xtout] = hist(Tx,xt);

figure(2)

hist(Tx,xt);

ntmx = sum(nt);

pt = nonzeros(nt/ntmx);

Str = - sum(pt .* log(pt));

% коэффициент формы для треуг. сигн.

K2tr = sqrt(mean(Tx.^2))*sqrt(mean(Tt.^2))/mean(abs(Tx.*Tt));

Задание

1. Написать файл-функции для сигналов приведенной в таблице 1.

Литература

1. Николис Г., Пригожин И. Познание сложного. – М.: Мир, 1990. –

344 с.

2. Хакен Г. Информация и самоорганизация. – М.: Мир, 1991. 240 с.