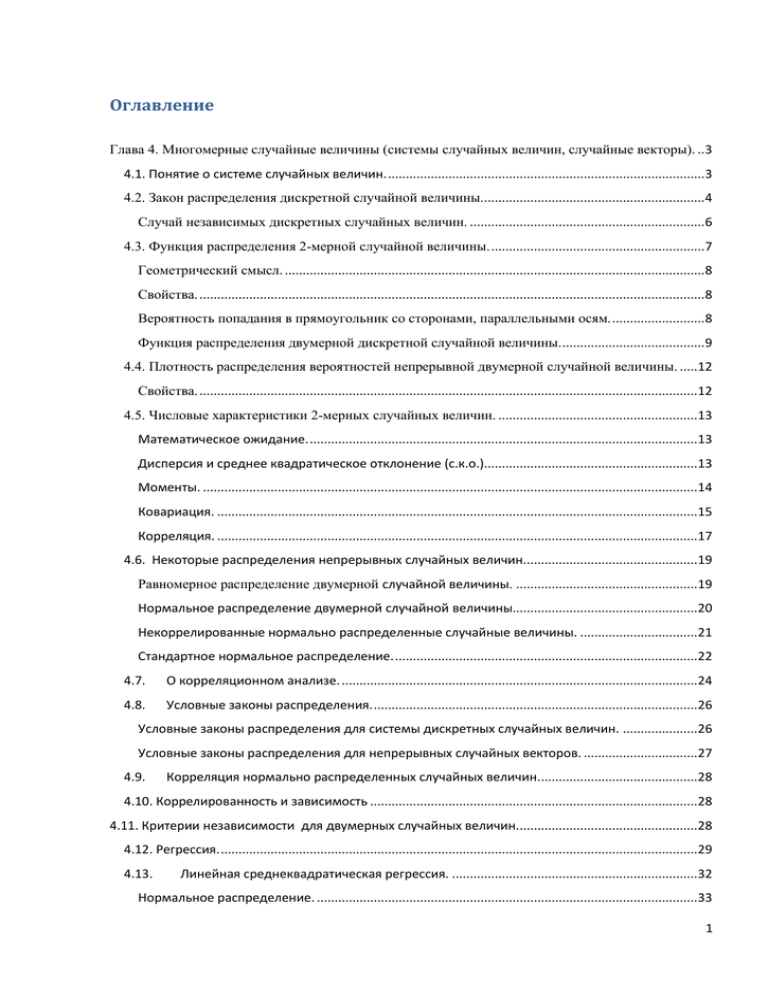

Оглавление

реклама

Оглавление

Глава 4. Многомерные случайные величины (системы случайных величин, случайные векторы). .. 3

4.1. Понятие о системе случайных величин. ......................................................................................... 3

4.2. Закон распределения дискретной случайной величины............................................................... 4

Случай независимых дискретных случайных величин. .................................................................. 6

4.3. Функция распределения 2-мерной случайной величины. ............................................................ 7

Геометрический смысл. ...................................................................................................................... 8

Свойства. .............................................................................................................................................. 8

Вероятность попадания в прямоугольник со сторонами, параллельными осям. .......................... 8

Функция распределения двумерной дискретной случайной величины. ........................................ 9

4.4. Плотность распределения вероятностей непрерывной двумерной случайной величины. .....12

Свойства. ............................................................................................................................................12

4.5. Числовые характеристики 2-мерных случайных величин. ........................................................13

Математическое ожидание. .............................................................................................................13

Дисперсия и среднее квадратическое отклонение (с.к.о.)............................................................13

Моменты. ...........................................................................................................................................14

Ковариация. .......................................................................................................................................15

Корреляция. .......................................................................................................................................17

4.6. Некоторые распределения непрерывных случайных величин.................................................19

Равномерное распределение двумерной случайной величины. ...................................................19

Нормальное распределение двумерной случайной величины....................................................20

Некоррелированные нормально распределенные случайные величины. .................................21

Стандартное нормальное распределение. .....................................................................................22

4.7.

О корреляционном анализе. ....................................................................................................24

4.8.

Условные законы распределения. ...........................................................................................26

Условные законы распределения для системы дискретных случайных величин. .....................26

Условные законы распределения для непрерывных случайных векторов. ................................27

4.9.

Корреляция нормально распределенных случайных величин.............................................28

4.10. Коррелированность и зависимость ............................................................................................28

4.11. Критерии независимости для двумерных случайных величин...................................................28

4.12. Регрессия. ......................................................................................................................................29

4.13.

Линейная среднеквадратическая регрессия. .....................................................................32

Нормальное распределение. ...........................................................................................................33

1

Дополнительный материал. .................................................................................................................35

Линейная регрессия и FOREX............................................................................................................35

О регрессионном анализе. ...................................................................................................................35

Обобщение на многомерный случай ..............................................................................................36

Математическое определение линейной регрессии.....................................................................36

Обобщение для n-мерных случайных величин. .............................................................................36

2

Глава 4. Многомерные случайные величины (системы случайных величин, случайные векторы).

4.1. Понятие о системе случайных величин.

На практике, обычно, приходится решать задачи, связанные с рассмотрением одновременно нескольких случайных величин. Так, например, описать задачу случайного попадания в мишень удобно с помощью координаты попадания в цель: ( X , Y ) - двумерной

случайной величины.

При случайном выборе точки в трехмерном пространстве появляется трехмерная случайная координата ( X , Y , Z ) .

Координаты точек, компоненты которых являются случайными величинами, можно рассматривать как случайные векторы.

Определение. Упорядоченный набор X 1 , X 2 ,..., X n случайных величин X i (i 1,...n.) , заданных на одном и том же пространстве элементарных событий

случайной величиной или системой случайных величин.

, называется n-мерной

Определение. Одномерные случайные величины, образующие случайный вектор, называются компонентами или составляющими n-мерной случайной величины.

Все особенности, связанные с многомерными случайными величинами, проявляются уже

в случае двумерных величин, поэтому далее мы будем рассматривать именно двумерные

случайные величины, затем обобщим введенные понятия на общий случай n-мерных случайных величин.

Определение. Упорядоченная пара ( X , Y ) двух случайных величин X , Y называется двумерной случайной величиной или системой двух одномерных величин X , Y .

( X , Y ) есть функция элементарного события

зацией случайной вектора будет точка ( x, y)

: ( X ,Y )

2

( ) . Значением или реали-

(на вещественной плоскости).

Пример 1. Два игральных кубики. Случайная величина X ={число, выпавшее на первом кубике}, с.в. Y ={число, выпавшее на втором кубике}. Все пространство элементарных исходов будет состоять из 62 элементарных исходов {(1,1),(1,2),…,(6,6)}, они же будут являться реализацией случайного вектора ( X , Y ) для этого примера.

Системы случайных величин могут быть дискретными, непрерывными или смешанными

(в зависимости от типа случайных компонент).

Система с.в. полностью определяется заданием закона распределения вероятностей, который может представлять собой таблицу (для д.с.в.) или функцию плотности вероятности

(для н.с.в.).

3

4.2. Закон распределения дискретной случайной величины.

Рассмотрим дискретную случайную величину X , которая может принимать n значений,

распределение которой задано таблицей:

…

x1

X

P{X

P

x1}

p x1

…

xi

P{X

xi }

xn

p xi

P{X

xn }

p xn

и дискретную случайную величину Y , принимающую m значений:

…

y1

Y

P{Y

P

y1}

p y1

…

yj

P{Y

y j}

ym

p yj

P{Y

ym }

p ym

Закон распределения вероятностей для двумерной дискретной случайной величины ( X , Y )

можно представить в виде таблицы:

X

Y

x1

P{ X

…

xi

{X

xi , Y

x1 , Y

y1 }

p11

…

P{X

…

xn

…

y1

xi , Y

pi1

…

P{X

xn , Y

P{ X

x1 , Y

P{ X

…

xi , Y y j }

P{ X

…

xn , Y

…

y1}

…

…

y1}

pn1

…

…

yj

y j}

p1 j

ym

P{X

ym }

p1m

ym }

pim

ym }

pnm

…

pij

…

P{X

…

y j}

x1 , Y

pnj

…

xi , Y

…

P{X

y j } обозначает одновременность двух случайных событий: { X

xn , Y

xi } {Y

y j }.

Более кратко эту таблицу можно изобразить так:

Y

X

x1

…

y1

xi

p11

…

pi1

…

…

xn

p n1

…

yj

…

p1 j

ym

p1m

… …

… p

…

… …

… p nj

… …

… p nm

ij

…

pim

Вероятности двумерной случайной величины образуют матрицу n m :

4

p11

p n1

p1m

p nm

Как и в случае одномерных с.в. должно выполняться условие нормировки:

n

m

pij

1

i 1 j 1

Это условие вытекает из следующих соотношений:

n

m

n

pij

i 1 j 1

m

n

(

i 1

pij )

m

p xi

j 1

i 1

p yj

1

j 1

m

(при фиксированном i сумма

pij ("свѐртка по j ") представляет собой вероятность

j 1

P{X

сумма

xi }

n

p xi (вероятность i-того значения компоненты X ), при фиксированном j

p ij ("свѐртка по i ") представляет собой вероятность

P{Y

y j}

p yj (вероят-

i 1

ность j-того значения компоненты Y )).

Замечание. Из двумерного распределения для ( X , Y ) мы всегда можем получить одномерные распределения для X и Y .

Удобно использовать расширенную таблицу, представляющую собой комбинированное

задание двумерной и одномерных случайных величин:

Y

X

x1

y1

…

yj

…

ym

p11

…

p1 j

…

p1m

…

…

…

…

…

…

xi

pi1

…

…

xn

p n1

Y

n

i 1

pi1

pij

…

…

p y1

…

…

p nj

n

i 1

pij

…

m

j 1

…

j 1

…

n

pim

p x1

pij

p xi

…

m

p nm

i 1

p1 j

…

m

pim

…

p yj

X

j 1

p ym

pnj

p xn

1

(суммированием по столбцам получаем столбец вероятностей для X, суммированием по

строкам получаем строку вероятностей для Y).

5

Пример 2. В ящике 4 шара: 2 белых, 1 черный, 1 синий. Наугад достают 2 шара. X - число черных шаров в выборке, Y – число синих шаров. Записать двумерное распределение

вероятностей.

Случайные величины X , Y могут принимать значения 0 или 1 (черных и синих шаров по

одному!).

Найдем вероятности:

p11

P{ X

0, Y

0}

C 22

C 42

1

, p12

6

P{ X

0, Y

1}

C 21

C 42

2

,

6

p 21

P{ X

1, Y

0}

C 21

C 42

2

, p 22

6

P{ X

1, Y

1}

C 20

C 42

1

6

Получаем расширенную таблицу для распределения ( X , Y ) :

Y

X

0

1

Y

0

1

X

1/6

2/6

3/6

2/6

1/6

3/6

3/6

3/6

1

Случай независимых дискретных случайных величин.

Ранее мы ввели понятие независимости двух случайных величин: случайные величины

X , Y независимы, если независимы случайные события {X xi } и {Y y j } для всех

i

1,..., n и j

1,..., m . Для независимых величин мы можем вычислить вероятности дву-

мерного распределения по заданным одномерным:

pij

P{ X

xi , Y

y j}

P{ X

xi } P{Y

y j}

p xi p yj ,

i 1,..., n;

j 1,..., m.

6

Пример 3. Подбрасывают две монеты. X – выпадение герба на первой монете, Y – выпадение герба на второй монете.

Выпадение герба на одной из монет ни как не зависит от того, что выпало на другой.

Поэтому мы получаем распределения для двух независимых случайных величин:

1

X 0

P 1/2 1/2

1

Y 0

P 1/2 1/2

Вероятности двумерного распределения согласно правилу (2) есть произведение соответствующих вероятностей:

X

Y

0

(1 / 2) (1 / 2) 1 / 4

1/4

0

1

1

1/4

1/4

Пример 4. Пусть A и B – два независимых случайных события. Случайные величины

X=I(A), Y=I(B) – индикаторы событий. Вероятности событий A и B есть соответственно p A и p B . Распределения для индикаторов:

0

1

X

P qA 1 pA pA

Тогда распределение для системы ( X , Y ) :

X

Y

0

1

Y

Y

P

qB

0

1

q A qB

p A qB

qB

q A pB

p A pB

pB

0

1 pB

1

pB

X

q A (q B

pB )

qA

pA

1

4.3. Функция распределения 2-мерной случайной величины.

Наиболее универсальным способом задания закона распределения, как и в случае одномерных случайных величин, является функция распределения. Будем обозначать функцию распределения в двумерном случае как FX ,Y ( x, y ) или F ( x, y) .

Определение 3. Функцией распределения двумерной случайной величины ( X , Y ) называется

F ( x, y)

P{X

x, Y

y}

- вероятность совместного выполнения случайных событий { X

( x, y)

2

x} и {Y

y} для

.

7

Геометрический смысл.

Вероятность попадания в заштрихованную область:

Свойства.

1. 0 F ( x, y) 1 ;

2. x 2

x1

F ( x2 , y)

F ( x1 , y ) ; y 2

дому аргументу;

3. F ( x, ) F ( , y)

4.

F(

5.

F ( x,

,

F(

,

)

y1

F ( x , y2 )

F ( x , y1 ) - неубывание по каж-

0;

) 1;

)

F1 ( x)

FX ( x ) ; F (

, y)

F2 ( y )

FY ( y ) - при обращении одного из ар-

гументов в бесконечность становится функцией одного аргумента;

6. lim F ( x, y ) F ( x0 , y ) ; lim F ( x, y ) F ( x, y 0 ) - односторонняя непрерывность.

x

x0 0

y

y0 0

Замечание 1. Из свойства 5, в частности, следует, что из двумерной функции распределения всегда можно получить одномерную функцию распределения.

Замечание 2. F ( x, y) представляет собой некоторую поверхность.

Вероятность попадания в прямоугольник со сторонами, параллельными осям.

В одномерном случае задание функции распределения позволяло вычислять вероятность

попадания в интервал на вещественной оси. В двумерном случае можно вычислить вероятность того, что ( X , Y ) примет значения в прямоугольнике со сторонами, параллельными

осям:

P{x1

X

x2 , y1

Y

y 2 } F ( x2 , y 2 ) F ( x1 , y 2 ) [ F ( x2 , y1 ) F ( x1 , y1 )]

На рисунке показана схема "обхода" вершин прямоугольника при подстановке координат

вершин в двумерную функцию распределения:

8

Функция распределения двумерной дискретной случайной величины.

В одномерном случае функция распределения дискретной случайной величины представляла собой сумму вероятностей. В двумерном случае ее можно задать так:

F ( x, y )

pij

xi x y j y

Схематично это можно представить так:

Y

X

x1

y1

y2

…

yj

…

ym

p11

p12

…

p1 j

…

p1m

x2

p 21

p 22

…

…

…

xi

pi1

…

pij

…

pim

…

…

p n1

…

p nj

…

…

xn

…

…

- для вычисления F ( xi , y j )

P( X

xi , Y

p nm

y j ) находим сумму вероятностей выделенной

части таблицы распределения (столбец y j и строку xi не включаем!).

Функцию распределения в двумерном случае удобно представлять в виде таблицы:

9

Y

X

x

x1

xi

y

x1

x

1

x2

x

…

x

xn

xi

y1

y1

y

y2

…

yj

1

…

y yj

y

ym

0

0

…

0

…

0

0

p11

…

…

…

…

m

…

0

…

F ( x, y )

pij

xi x y j y

…

…

…

n

pij

0

i 1 yj y

pij

xi x j 1

…

…

n

m

pij =1

i 1 j 1

- первая строка и первый столбец заполняются нулями, в нижней правой клетке будет 1.

Получаем неубывающую по каждому аргументу функцию, изменяющуюся от 0 до 1.

Найдем функцию распределения для рассмотренного примера 2.

10

Пример 2. В ящике 4 шара: 2 белых, 1 черный, 1 синий. Наугад достают 2 шара. X - число черных шаров в выборке, Y – число синих шаров. Записать двумерное распределение

вероятностей.

Ранее мы нашли двумерное и одномерные распределения для этого примера:

Y

X

0

1

Y

0

1

X

1/6

2/6

1/2

2/6

1/6

1/2

1/2

1/2

1

Одномерные функции распределения:

0, x

F1 ( x)

0

1 / 2, 0

0, y

x 1

F2 ( y )

0

1 / 2, 0

1, x 1

y 1

1, y 1

Двумерная функция распределения:

Y

X

x 0

0 x 1

x 1

y

0

0

0

0

0

y 1

0

p11 =1/6

p11 p 21

=1/6+2/6=1/2

y 1

0

p11 p12

=1/6+2/6=1/2

1

11

4.4. Плотность распределения вероятностей непрерывной двумерной случайной величины.

Определение. 2-мерная случайная величина называется непрерывной, если ее функция

распределения F ( x, y) непрерывна, дифференцируема по каждому аргументу и существует смешанная производная Fxy ( x, y) .

Определение. Плотностью распределения вероятностей (или совместной плотностью) непрерывной случайной величины ( X , Y ) называется смешанная производная еѐ

функции распределения:

2

f ( x, y )

F ( x, y )

x y

Fxy ( x, y )

Замечание. Плотность представляет собой вероятность попадания в бесконечно малый

прямоугольник {x0

lim {

x

y

Замечание.

0

0

1 F ( x0

(

y

P{x

X

x, y 0

x

x

x0

x; y0

y ) F ( x0 , y 0

x

x; y

Y

y

y)

y}

y

F ( x0

y0

y} :

x, y 0 ) F ( x 0 , y 0 )

)} .

x

f ( x. y ) x y - элемент вероятности с.в.

( X ,Y ) .

Свойства.

1. Вероятность попадания в область D

P{( X , Y )

2

D}

:

f ( x, y)dxdy ;

D

2. Неотрицательность плотности :

f ( x, y)

0 ;

3. Функция распределения через плотность:

x y

F ( x, y)

f (u, v)dudv ;

4. Условие нормировки:

f ( x, y)dxdy 1 ;

5. Одномерные плотности распределений:

12

f ( x, y)dy

f X ( x)

f 1 ( x) ;

f ( x, y)dx

f Y ( y)

f 2 ( y) .

Замечание. Из совместной плотности f ( x, y) всегда можно получить одномерные плотности f1 ( x) и f 2 ( y ) . Обратное утверждение в общем случае неверно.

Пример 5. Система случайных величин ( X , Y ) задана плотностью

f ( x, y )

Найти A , F ( x, y) , P{X

A

x )(1

2

(1

y2)

1, Y 1} , f1 ( x) , f 2 ( y ) .

4.5. Числовые характеристики 2-мерных случайных величин.

Математическое ожидание.

Математическим ожиданием дискретной двумерной случайной величины ( X , Y ) называется совокупность математических ожиданий одномерных случайных величин:

n

MX

m

mx

n

xi pij

n

xi pxi ,

i 1 j 1

MY

m

my

m

y j pij

i 1

i 1 j 1

Математическое ожидание функции случайной величины

n

m

i 1

j 1

M ( ( X , Y ))

y j p yj ,

j 1

( X ,Y ) :

( xi , y j ) pij

Математическим ожиданием непрерывной двумерной случайной величины ( X , Y ) называется совокупность математических ожиданий одномерных случайных величин:

MX

mx

x f ( x, y)dxdy

x f1 ( x)dx,

MY

my

y f ( x, y)dxdy

y f 2 ( y)dy

Точка с координатами (mx , m y ) называется центром рассеивания.

Математическое ожидание функции непрерывной случайной величины

M ( ( X , Y ))

( X ,Y ) :

( x, y) f ( x, y)dxdy

Дисперсия и среднее квадратическое отклонение (с.к.о.)

Дисперсией двумерной дискретной случайной величины называется совокупность двух

дисперсий ("одномерные" дисперсии!):

13

n

m

DX

n

( xi

mx ) 2 pij

( xi

i 1 j 1

n

i 1

m

DY

mx ) 2 p xi ,

m

(yj

m y ) 2 pij

i 1 j 1

(yj

m y ) 2 p yj ,

j 1

Дисперсией двумерной непрерывной случайной величины называется совокупность двух

дисперсий ("одномерных"!):

( x mx ) 2 f ( x, y)dxdy

DX

( x mx ) 2 f1 ( x)dx,

( y my ) 2 f ( x, y)dxdy ( y my ) 2 f 2 ( y)dy

DY

Среднее квадратическое отклонение (стандартное отклонение):

X

DX ,

Y

DY

Моменты.

Начальные

Начальным моментом

k ,s

порядка k+s системы ( X , Y ) называется

M ( X kY s )

k ,s

Замечания.

mx

1, 0

,

my

0,1

Смешанное мат. ожидание

Начальный момент 2-го порядка

1,1

mXY

MXY ("смешанное мат. ожидание")

вычисляется как:

n

mXY

m

MXY

xi y j pij

- для д.с.в

i 1 j 1

mXY

MXY

xy f ( x, y)dxdy

- для н.с.в.

14

Центральные

Центральным моментом

порядка k+s системы ( X , Y ) называется

k ,s

Замечание. DX

2, 0

, DY

MX ) k (Y

M (( X

k ,s

MY ) s )

0, 2

Отдельно рассмотрим важный для приложений смешанный центральный момент 2-го порядка

1,1 .

Ковариация.

Определение. Ковариацией cov( X , Y ) или корреляционным моментом K XY называется:

K XY

cov( X , Y )

M [( X

MX )(Y

MY )]

Ковариацию удобнее вычислять по формуле:

K XY

{

M [( X

MX )(Y

MY )]

M ( XY ) 2 MX MY

M [ XY

X MY

MX MY

MXY

MX Y

MX MY

MX MY ]

M ( XY ) MX MY

}

Свойства ковариации.

1. K XY

K YX

2. K XX DX , KYY DY

3. Для независимых случайных величин K XY

0

{следует из того, что для независимых с.в. M ( XY )

4.

MXY

5.

D( X

K XY или в другой форме записи:

MX MY

Y)

DX

DY

MX MY }

mxy

cov XY mx my

2 K XY

Доказательство.

{

D( X Y )

M [( X Y ) M ( X Y )]2

M (X

MX ) 2 M (Y MY ) 2 2M [( X

M [( X

MX ) (Y MY )]2

MX )(Y MY )]

}

6.

cov(cX , Y ) c cov( X , Y ) cov( X , cY )

7. cov( X c, Y ) cov( X , Y c) cov( X c, Y C )

8.

| K XY |

DX DY

Доказательство. Рассмотрим с.в. Z

Вычислим ее м.о.: MZ

M(

Y

X

Y

X

Y)

X

X

Y

Y.

MX

x

MY

Вычислим ее дисперсию:

15

M ( Z MZ ) 2

DZ

... 2

2

x

2

Y

2

x

M(

Y

K XY

X

Y

X

0

Y

Y

K XY

MX

x

Вычисляя мат. ожидание и дисперсию для Z

Получаем | K XY |

x

Y

x

MY ) 2

M(

(X

MX )

Y , найдем: K XY

x

Y

x

(Y MY ))2

Y

Y

X

X

Y

.

.

Ковариация системы дискретных случайных величин:

n

m

K XY

( xi

MX )( y j

MY ) pij

i 1 j 1

Ковариация системы непрерывных случайных величин:

K XY

x y f ( x, y)dxdy MX MY

Определение. Ковариационной матрицей называется матрица

K

K XX

KYX

K XY

KYY

DX

K XY

DY

2

X

K XY

2

Y

Матрица K – симметричная, на главной диагонали – дисперсии.

Замечание. Ковариация (от англ. covariation - "совместная вариация") - мера линейной

зависимости двух величин.

Ковариация показывает, есть ли линейная взаимосвязь между двумя случайными величинами, и может рассматриваться как "двумерная дисперсия". Ковариация зависит от

единиц измерения и масштаба случайных величин.

Знак ковариации указывает на вид линейной связи между переменными величинами, в зависимости от знака можно разбить на три случая:

ковариация > 0: прямая связь между переменными (если растет "Х", "У"-растет);

ковариация < 0: прямая связь между переменными (если растет "Х", "У" уменьшается);

ковариация = 0: линейная связь между переменными отсутствует.

16

Более удобно пользоваться безразмерным коэффициентом корреляции (иногда его называют просто корреляцией).

Корреляция.

— статистическая взаимосвязь двух или нескольких случайных величин (либо величин, которые можно с некоторой допустимой степенью точности считать таковыми). При

этом, изменения одной или нескольких из этих величин приводят к систематическому изменению другой или других величин. Математической мерой корреляции двух случайных величин

служит коэффициент корреляции

Для метрических величин применяется коэффициент корреляции Пирсона, точная формула которого была введена Фрэнсисом Гальтоном.

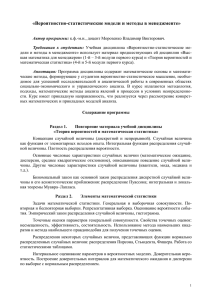

Сэр Фрэнсис Гальтон (Sir Francis Galton) (16 февраля 1822

– 17 января 1911) – английский ученый-статистик. Был

возведен в звание рыцаря в 1909 году. Является автором

статистической концепции корреляции и регрессии. Был

первым, кто применил статистические методы к изучению

человеческого общества на основе генеалогических, антропометрических и прочих данных.

Карл Пирсон (Karl Pearson) (27 марта 1857 – 27 апреля

1936) считается основателем математической статистики

как математической дисциплины. В 1911 основал первый

отделение математической статистики в University College

London. Был учеником и биографом Фрэнсиса Гальтона.

Определение. Коэффициентом корреляции называется

rXY

K XY

X

где

DX ,

X

Y

cov( X , Y )

Y

X

,

Y

DY - средние квадратические отклонения (стандартные откло-

нения).

Свойства.

1.

Следствием | K XY |

2.

Если случайные величины независимы, то

x

Y

является: rXY

1 .

rXY

0

(обратное утверждение в об-

щем случае неверно!)

3. Если Y

aX b (случайные величины связаны линейной зависимостью), то

rXY

1

17

( rXY

{

2

Y

K XY

rXY

D(aX b) a2 DX

DY

1 при a 0 и rXY 1 при a 0 )

a2

2

X

a

Y

X

2

X

cov( X ,Y ) cov( X , aX b) cov( X , aX ) a cov( X , x) a

a

X

2

X

a

1}

X

Определитель ковариационной матрицы K :

det K

DX DY

2

( K XY ) 2

X

1 rXY

2

Y

(rXY

X

det K

2

X

Y

)2

2

X

2

Y

2

(1 rXY ) ,

.

Y

Матрица, составленная из коэффициентов корреляции называется корреляционной:

R

1

rXY

1 rXY

rYX

1

1

Замечание. Корреляция (так же, как и ковариация) может быть положительной и отрицательной (возможна также ситуация отсутствия статистической взаимосвязи —

например, для независимых случайных величин).

Отрицательная корреляция — корреляция, при которой увеличение одной переменной

связано с уменьшением другой переменной, при этом коэффициент корреляции отрицателен.

Положительная корреляция — корреляция, при которой увеличение одной переменной

связано с увеличением другой переменной, при этом коэффициент корреляции положителен.

18

4.6. Некоторые распределения непрерывных случайных величин.

Равномерное распределение двумерной случайной величины.

Определение. Случайная величина ( X ,Y ) равномерно распределена в области D площадью SD , если ее плотность распределения задается так:

f ( x, y )

c

const , ( x, y )

0, ( x, y )

D

D

Значение константы однозначно определяется условием нормировки:

f ( x, y)dxdy 1

Отсюда:

c

1/ S D .

График плотности 2-мерного равномерного распределения:

D {0

x 5,0

y 5} , z

f ( x, y) 1/ 25

График функции распределения 2-мерного равномерного распределения:

z

F ( x, y)

xy / 25

19

Нормальное распределение двумерной случайной величины.

Определение. Нормальным законом распределения на плоскости называют распределение двумерной случайной величины ( X ,Y ) , определяемое функцией двумерной плотности:

1

1

f ( x, y )

2

X

Y

1 rXY

2

2 (1 rXY 2 )

e

[

( x m X ) 2 ( y mY ) 2

2

2

X

2 rXY

Y

( x mX )( y mY )

X

]

Y

Как это видно из определения, нормальное распределение двумерной случайной величины определяется уже 5 параметрами: N (mx , my , x , y , rxy ) .

Эта функция удовлетворяет условию нормировки:

f ( x, y )dxdy 1

Из двумерной плотности можно получить одномерные плотности – плотности одномерных компонент случайного вектора ( X , Y ) :

f1 ( x)

1

f ( x, y )dy

2

X

e

( x mx )2

2 X2

;

f 2 ( y)

f ( x, y )dx

Y

Плотность 2-мерного нормального распределения z

Максимум функции плотности zmax

1

2

e

( y mY )2

2 Y2

;

f ( x, y) представляет собой поверхность:

1

max f ( x, y)

2

X

Y

2

1 rXY

достигается в точке (m X , mY ) .

Замечание. Сечение плоскостью

z

z0 , 0

z0

zmax

:

20

( x mX ) 2

( y mY ) 2

2

X

где

h2

2(1 r 2 ) ln( 2

X

2 rXY

2

Y

Y

2

1 rXY

z0 )

( x mX )( y mY )

X

h

2

Y

, определяет эллипс в проекции на плоскость (0xy).

Этот эллипс называется эллипсом рассеяния. Центр эллипса

( mx , m y )

- центр рассеяния.

Замечание. Плотность можно записать через определитель ковариационной матрицы:

f ( x, y )

2

1

e

det K

1

[

2 det K

2

Y

( x mX )2

2

X

( y mY )2 2 K XY ( x mX )( y mY )]

Некоррелированные нормально распределенные случайные величины.

Для некоррелированных случайных величин rXY

f ( x, y )

1

2

e

X

0:

1 ( x mX )2 ( y mY )2

[

]

2

2

2

X

Y

f1 ( x) f 2 ( y )

Y

где f1 ( x), f 2 ( y ) - плотности одномерных компонент двумерной с.в. ( X , Y ) . Получили

f ( x, y)

f1 ( x) f 2 ( y )

- критерий независимости. Следовательно, некоррелированные нормально распределенные

случайные величины являются также и независимыми.

Замечание. Для нормально распределенных случайных величин

независимость

некоррелированность.

Уравнение эллипса рассеяния для некоррелированных случайных величин:

( x mx ) 2

(h x ) 2

( mx , my - центр, h

x,

h

y

( y my ) 2

(h

y

)2

1

- полуоси эллипса). В частности, при h 1 :

21

Y

mY

X

mX

Стандартное нормальное распределение.

Для стандартных (центрированных и нормированных) независимых случайных величин, для которых mX mY 0 и X

1 , можно записать функцию плотности двумерного стандартного

Y

распределения (частный случай кругового рассеяния):

1

e

2

f ( x, y )

1 2

(x

2

y2 )

Вероятность попадания в прямоугольник для стандартных независимых случайных величин:

P{a X b, c Y d} (

где

0

0

(b)

0

(a)) (

0

(d )

0

d

mY

(c)) ,

( x) - функция Лапласа.

В общем случае, для двух независимых случайных величин

P{a

X

b, c

Y

d}

(

0

(

b mX

X

)

0

(

a mX

X

)) (

0

(

Y

)

0

(

c mY

))

Y

График функции распределения 2-мерного нормального распределения:

22

23

4.7.

О корреляционном анализе.

Корреляционный анализ — метод обработки статистических данных, заключающийся в

изучении коэффициентов корреляции между переменными. При этом сравниваются коэффициенты корреляции между одной парой или множеством пар признаков для установления между ними статистических взаимосвязей.

Цель корреляционного анализа — обеспечить получение некоторой информации об одной переменной с помощью другой переменной. В случаях, когда возможно достижение

цели, говорят, что переменные коррелируют. В самом общем виде принятие гипотезы о

наличии корреляции означает, что изменение значения переменной X, произойдет одновременно с пропорциональным изменением значения Y: если обе переменные растут то

корреляция положительная, если одна переменная растѐт, а вторая уменьшается, корреляция отрицательная.

Замечание. Корреляция отражает лишь линейную зависимость величин, но не отражает их

функциональной связности. Например, если вычислить коэффициент корреляции между

величинами A = sin(x) и B = cos(x), то он будет близок к нулю, т. е. зависимость (корреляционная) между величинами отсутствует. Между тем, величины A и B очевидно связаны

функционально по закону sin2(x) + cos2(x) = 1 .

4.7.1. Ограничения корреляционного анализа

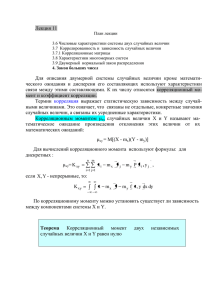

Графики распределений пар (x,y) с соответствующими коэффициентами корреляций x и y для

каждого из них. Обратите внимание, что коэффициент корреляции отражает линейную зависимость (верхняя строка), но не описывает наклон линейной зависимости (средняя строка), и совсем не подходит для описания сложных, нелинейных (функциональных) зависимостей (нижняя

строка).

1. Применение корреляционного анализа возможно в случае наличия достаточного количества случаев для изучения: для конкретного вида коэффициента корреляции составляет от 25

до 100 пар наблюдений.

2. Второе ограничение применения корреляционного анализа вытекает из гипотезы линейной зависимости переменных. Во многих случаях, когда достоверно известно, что зависимость существует, корреляционный анализ может не дать результатов просто ввиду того,

что зависимость нелинейна (выражена, например, в виде параболы).

24

3. Сам по себе факт корреляционной зависимости не даѐт основания утверждать, какая из переменных предшествует или является причиной изменений, или что переменные вообще

причинно связаны между собой, например, ввиду действия третьего фактора.

4.7.2. Область применения

Данный метод обработки статистических данных весьма популярен в экономике и социальных науках (в частности в

психологии и социологии), хотя сфера применения коэффициентов корреляции обширна: контроль качества промышленной продукции, металловедение, агрохимия, гидробиология, биометрия и прочие.

Популярность метода обусловлена двумя моментами: коэффициенты корреляции относительно просты в подсчете,

их применение не требует специальной математической подготовки. В сочетании с простотой интерпретации, простота применения коэффициента привела к его широкому распространению в сфере анализа статистических данных.

4.7.3. Ложная корреляция

Часто заманчивая простота корреляционного исследования подталкивает исследователя делать ложные интуитивные выводы о наличии причинно-следственной связи между парами признаков, в то время как коэффициенты корреляции устанавливают лишь статистические взаимосвязи.

В современной количественной методологии социальных наук, фактически, произошел отказ от попыток установить

причинно-следственные связи между наблюдаемыми переменными эмпирическими методами. Поэтому, когда исследователи в социальных науках говорят об установлении взаимосвязей между изучаемыми переменными, подразумевается

либо общетеоретическое допущение, либо статистическая зависимость.

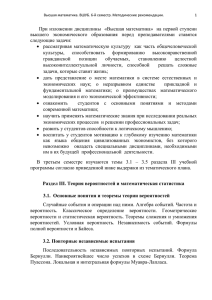

4.7.4. Корреляция в математической статистике

Корреляция в математической статистике, вероятностная или статистическая зависимость, не имеющая, вообще говоря, строго функционального характера. В отличие от

функциональной, корреляционная зависимость возникает тогда, когда один из признаков

зависит не только от данного второго, но и от ряда случайных факторов или же когда среди условий, от которых зависят и тот и другой признаки, имеются общие для них обоих

условия. Пример такого рода зависимости даѐт корреляционная таблица. Из таблицы видно, что при увеличении высоты сосен в среднем растет и диаметр их стволов; однако сосны заданной высоты (например, 23 м) имеют распределение диаметров с довольно большим рассеянием. Если в среднем 23-метровые сосны толще 22-метровых, то для отдельных сосен это соотношение может заметным образом нарушаться. Статистическая корреляция в обследованной конечной совокупности наиболее интересна тогда, когда она указывает на существование закономерной связи между изучаемыми явлениями.

Диаметр,

см

14-17

18-21

22-25

26-29

30-33

34-37

38-41

42-45

46-49

50-53

17

2

1

1

18

2

3

1

19

5

3

1

20

1

12

3

21

15

18

7

1

Высота, м

22 23 24 25

9

24

18

5

1

4

29

30

18

3

2

14

43

29

17

2

3

7

31

35

33

10

4

3

1

26

27

28

3

18

26

19

13

7

4

2

7

12

16

6

6

4

1

6

4

8

2

2

29

30

1

1

1

Итого

10

47

98

134

114

98

53

32

22

12

25

54-57

58 и более

Итого

Средний

диаметр

1

1

1

1

3

1

4

6

9

16

41

57

86

108 124 91

55

24

2

1

624

18,

5

18,

6

17,

7

20,

0

22,

9

25,

0

27,

2

30,

1

40,

0

41,

8

49,

5

43,

5

31,2

32,

7

38,

3

Таблица 1 Корреляция между диаметрами и высотами 624 стволов северной сосны

В основе теории корреляции лежит предположение о том, что изучаемые явления подчинены определѐнным вероятностным закономерностям. Зависимость между двумя случайными событиями проявляется в том, что условная вероятность одного из них при наступлении другого отличается от безусловной вероятности. Аналогично, влияние одной случайной величины на другую характеризуется законами условных распределений первой

при фиксированных значениях второй.

Наиболее употребителен при измерении степени зависимости коэффициент корреляции

r XY между Х и Y, который мы ввели ранее. Однако, практическое использование коэффициента корреляции в качестве меры зависимости оправдано лишь тогда, когда совместное

распределение пары (X, Y) нормально или приближѐнно нормально; употребление r XY как

меры зависимости между произвольными Y и Х приводит иногда к ошибочным выводам,

т. к. r XY может равняться нулю даже тогда, когда Y строго зависит от X.

a) Случайные величины - корреляция

Зашумленная функциональная зависимость - регрессия

4.8.

Условные законы распределения.

Условные законы распределения для системы дискретных случайных величин.

Для зависимых случайных величин, образующих двумерную систему ( X , Y ) можно найти

условные законы распределения и соответствующие им условные математические ожидания.

Определение. Условным законом распределения одной из случайных величин, входящих

в систему двумерных случайных величин, называется закон ее распределения, найденный

при условии, что другая случайная величина приняла определѐнное значение:

26

P{Y

yj | X

xi }

P{ X

xi , Y

P{ X

y j}

xi }

, i 1,2,..., n; j

1,2,...m

или:

p ( y j | xi )

pij

p xi

Получаем условный закон распределения для каждого X

Y

y j |X

xi

p( y j | xi )

xi :

y1

y2

…

ym

pi1 / p xi

pi 2 / p xi

…

pim / p xi

Определение. Условное математическое ожидание:

m

M (Y | X

xi )

yj

j 1

Для каждого значения X

ние M (Y | X

pij

p xi

xi можно вычислить соответствующее математическое ожида-

xi ) . В результате получаем зависимости M (Y / x)

( x) .

Функция (x) называется регрессией. Более подробно о регрессии поговорим далее.

Замечание. Аналогичным образом можно находить условные математические ожидания

при y y j .

Условные законы распределения для непрерывных случайных векторов.

Пусть X – непрерывная случайная величина с плотностью распределения f 1 ( x ) , Y – непрерывная случайная величина с плотностью распределения f 2 ( y ) , f ( x, y) - плотность распределения непрерывной двумерной случайной величины ( X , Y ).

По известной двумерной плотности распределения f ( x, y) можно однозначно восстановить одномерные плотности распределения:

f 1 (x )

f (x , y )dy

f 2 ( y)

Если случайные величины X и Y независимы, то f ( x, y )

f ( x, y)dx

f 1 ( x) f 2 ( y ) .

Для зависимых условных величин можно ввести понятие условного распределения.

Определение. Плотность вероятности условного распределения непрерывной случайной величины Y при условии X x (условная плотность):

27

f ( y | x)

f ( x, y )

, где f 1 ( x)

f1 ( x)

0

Плотность вероятности условного распределения непрерывной случайной величины X

при условии Y y :

f ( x | y)

f ( x, y )

, где f 2 ( y )

f 2 ( y)

0

Отсюда

f (x , y ) f 1 (x ) f ( y | x ) f 2 ( y ) f (x | y )

4.9.

Корреляция нормально распределенных случайных величин.

Теорема. Если двумерная случайная величина ( X , Y ) распределена по нормальному закону, то

случайные величины

X и Y связаны линейной корреляционной зависимостью.

Доказательство. Нужно показать, что M (Y | x)

По определению M (Y | x)

( x) - линейная функция.

f ( x, y )

.

f1 ( x)

y f ( y | x)dy , где f ( y | x)

( x)

Подставив выражения для плотностей, получим:

[ y ( my r

Y

( x mx ))]2

X

1

f ( y | x)

2

Y

1 rXY

2

e

2(

y

1 rXY 2 )2

Получили нормальный закон с условным мат.ожиданием:

M (Y | x)

my

rXY

Y

( x mX )

X

( x)

и условной дисперсией: D(Y | x)

2

Y

(1 rXY ) 2 - где

(x) есть линейная функция.

4.10. Коррелированность и зависимость

1. Коррелированность случайных величин ( K XY

ных величин.

2. Независимость случайных величин

0)

зависимость случай-

некоррелированность ( K XY

0 ).

3. Некоррелированность нормально распределенных случайных величин

зависимость.

не-

4.11. Критерии независимости для двумерных случайных величин.

1. Случайные величины X и Y независимы, если для

тия {X x i } и {Y

y j }.

i , j независимы собы28

2. Случайные величины независимы, если условный и безусловный законы распределения совпадают.

3. Дискретные случайные величины независимы, если для

i 1, n; j 1, m :

pij pxi p yj

4. Случайные величины X и Y независимы, если :

F ( x, y ) F1 ( x) F2 ( y)

5. Случайные величины X и Y независимы, если :

f ( x, y )

f1 ( x) f 2 ( y )

4.12. Регрессия.

Термин «регрессия» ввел Ф. Гальтон в своей статье «Регрессия к середине в наследовании роста»

(1885 г.), в которой он сравнивал средний рост детей Y со средним ростом их родителей X (на

основе данных о 928 взрослых детях и 205 их родителях). Гальтон заметил, что рост детей у высоких (низких) родителей обычно также выше (ниже) среднего роста популяции, но при этом

отклонение от среднего у детей меньше, чем у родителей. Другими словами, экстремумы в следующем поколении сглаживаются, происходит возвращение назад (регрессия) к середине. По существу, Гальтон показал, что зависимость Y от X хорошо выражается уравнением

Y Y

(2 / 3)( X

X)

Позднее регрессией стали называть любую функциональную зависимость между случайными величинами, даже в тех ситуациях, когда предикторные переменные являются неслучайными.

«Можно предположить, что удивительная устойчивость термина регрессия связана с переосмыслением его значения. Постепенно исходная антропометрическая задача, занимавшая Гальтона, была забыта, а интерпретация вытеснилась благодаря ассоциативной связи с понятием

«регресс», т. е. движение назад. Сначала берутся данные, а уж потом, задним числом, проводится их обработка.

Такое понимание пришло на смену традиционной, еще средневековой, априорной модели, для которой данные были лишь инструментом подтверждения. Негативный оттенок, присущий понятию «регресс», думается и вызывает психологический дискомфорт, поскольку воспринимается

одновременно с понятиями, описывающими такой прогрессивный метод, как регрессионный анализ».

Изучение регрессии в теории вероятностей основано на том, что случайные величины Х

и Y, имеющие совместное распределение вероятностей, связаны вероятностной зависимостью: при каждом фиксированном значении Х = х величина Y является случайной величиной с определѐнным (зависящим от значения х) условным распределением вероятностей.

Регрессия величины Y по величине Х определяется условным математическим ожиданием Y, вычисленным при условии, что Х = х:

M (Y / x)

( x) .

Уравнение y

(x) , в котором х играет роль «независимой» переменной, называется

уравнением регрессии, а соответствующий график — линией регрессии величины Y по X.

29

Функция

( x ) называется функцией регрессии Y на X .

Функции регрессии в случае непрерывных случайных величин есть условные математические ожидания:

( x)

M (Y | x)

y f ( y | x)dy

,

( y)

M ( X | y)

x f ( x | y)dx

,

где f ( y | x) и f ( x | y) - условные плотности распределения.

Замечание. Пусть mY MY — безусловное математическое ожидание Y. Если величины

независимы, то все условные математические ожидания Y не зависят от х и совпадают

с безусловными:

( x)

M (Y | X

x)

MY

my .

Обратное заключение не всегда справедливо.

В отличие от чисто функциональной зависимости у = f(х), когда каждому значению

независимой переменной х соответствует одно определѐнное значение величины у,

при регрессионной связи одному и тому же значению х могут соответствовать, в

зависимости от случая, различные значения величины у.

Функция регрессии показывает зависимость средних значений одной случайной

величины от значений, принимаемых другой случайной величины.

Точность, с которой уравнение регрессии Y по Х отражает изменение Y в среднем при изменении х, измеряется условной дисперсией величины Y, вычисленной для каждого значения Х = х:

D(Y | x)

2

Y|X

M [Y M (Y | X

x)]2

2

( x) .

Если 2(х) = 0 при всех значениях х, то можно с достоверностью утверждать, что Y

и Х связаны строгой функциональной зависимостью Y

(X ) .

2

Если (х) = 0 при всех значениях х и (x) не зависит от х, то говорят, что регрессия Y по Х отсутствует.

Замечание. При строгой функциональной зависимости величина Y при данном Х = х принимает лишь одно определенное значение, то есть условная дисперсия (рассеяние около

линии регрессии) равно нулю.

Свойство линий регрессии. Линии регрессии обладают следующим замечательным

свойством: среди всех действительных функций f (х) минимум математического ожидания

M [Y f ( x)]2 достигается для функции f ( x)

( x) , т. е. регрессия Y по Х даѐт наилучшее,

в указанном смысле, представление величины Y по величине X.

Это свойство используется для прогноза Y по X: если значение Y непосредственно не наблюдается и эксперимент позволяет регистрировать лишь компоненту Х вектора (X, Y), то

в качестве прогнозируемого значения Y используют величину (X ) .

30

Замечание. Линия регрессии может быть приближѐнно восстановлена по достаточно

обширной корреляционной таблице: за приближѐнное значение у(х) принимают среднее из

тех наблюдѐнных значений Y, которым соответствует значение Х = х.

В случае корреляции двух количественных случайных признаков обычным показателем

концентрации распределения вблизи линии регрессии служит корреляционное отношение

2

1

Y|X

2

где

Y

между

2

Y |X

2

и

X |Y

2

Y |X

сия имеет вид

2

/

2

Y

,

2

— дисперсия Y (аналогично определяется корреляционное отношение

Величина

Y |X

2

Y|X

X |Y

, но

нет какой-либо простой зависимости).

, изменяющаяся от 0 до 1, равна нулю тогда и только тогда, когда регрес-

( x)

my (

равняется единице (

Y|X

Y |X

Y

) , в этом случае говорят, что Y некоррелирована с X,

0) в случае точной функциональной зависимости Y от X.

Нормальное распределение.

Если двумерное распределение (X, Y) нормально, то линии регрессии Y по Х и Х по Y суть

прямые y

mY

Y

( x mX ) и x

mX

X

( y mY ) , где

rXY

Y

Y

и

X

rXY

X

Y

и

X

- коэффициенты регрессии, причѐм rXY

2

X

Y

X

;

Y

.

2

2

2

x( y)) 2

Так как в этом случае M (Y y( x)) 2

Y (1 rXY ) и M ( X

X (1 rXY ) , то очевидно, что r XY полностью определяет степень концентрации распределения вблизи линий регрессии.

Наиболее простым является случай, когда регрессия Y по Х линейна.

31

4.13. Линейная среднеквадратическая регрессия.

Рассмотрим ( X ,Y ) , где X и Y - зависимые с.в. Допустим мы хорошо знаем поведение X .

Наша задача – приближенно выразить Y через X . Наиболее простым приближением будет линейное: Y g ( x)

X.

Будем искать наиболее точное линейное приближение с помощью метода наименьших

квадратов:

и

g ( X )]2

должны быть такими, чтобы математическое ожидание M [Y

было минимальным. Найденную при таком условии функцию g (x) называют линейной

среднеквадратической регрессией Y на X .

Теорема. Линейная среднеквадратическая регрессия Y на X имеет вид:

g( X )

mY

X

rXY

(X

mX )

Y

(где mY , m X - математические ожидания,

X

,

- с.к.о., rXY - коэффициент корреляции).

Y

Доказательство. Введем функцию F ( , )

X )]2 . Возведем в квадрат выра-

M [Y (

жение в квадратных скобках, упростим выражение, получим:

2

F( , )

2

2

Y

2rXY

X

X

mX )2

(mY

Y

{F ( , )

M [Y

)]2

( X

M [Y 2

MY

2 XY

2

2

2

Y

2

2 Y

mY

mY

2

mY

2

2

2

2

mY }

X2

2

2

2

(

X

(

X

mX mY

r XY

MX

2

2

mX

2

mX } 2 M ( XY ) 2

2

2

mX ) 2 rXY

Y

2

MX

mX mY } 2 mX mY

2

2

]

2

mX ) 2 {mXY

X

2

X

2

X

)2 ]

) ( X

2

{MX 2

(использовали выражения

M [ XY ]

2Y ( X

2 M ( XY ) 2 MY

{MY 2

Y

M [Y 2

X

mX ) 2

(mY

Y

2

2

M [ X 2 ] mX ,

mX

2

2

mX

mX

2

2 mY

2

2 mY

2 mY

2

}

2

M [Y 2 ] mY ,

Y

).

Находим частные производные по

и

F

F

, приравниваем нулю и решаем систему:

2(mY

2

2

X

mX )

2rXY

X

0

0

Y

Получаем:

rXY

Y

X

,

mY

rXY

Y

mX

.

X

32

Определение. Коэффициент

rXY

называется коэффициентом регрессии Y на X.

Y

X

Определение. Уравнение y mY

rXY

Y

( x m X ) определяет прямую среднеквадрати-

X

ческой регрессии Y на X.

Подставляя в выражение для функции, найдем ;

min F ( , )

2

2

Y

2

(1 rXY )

2

Определение. Величину Y (1 rXY ) называют остаточной дисперсией случайной величины Y относительно случайной величины X.

Остаточная дисперсия характеризует ошибку, которую допускают при замене Y линейной

функцией от X.

При rXY

1 остаточная дисперсия равна нулю, а Y и X связаны линейной функциональ-

ной зависимостью.

Аналогично можно получить прямую среднеквадратической регрессии X на Y:

x mX

rXY

X

(y

mY )

Y

Обе прямые проходят через точку (mX ,mY ) , которая называется центром совместного

распределения величин X и Y.

33

В предельном случае r XY = ± 1 прямые регрессии сливаются в одну, что соответствует

строгой линейной зависимости между Y и X, при r XY = 0 величины некоррелированы.

34

Дополнительный материал.

Линейная регрессия и FOREX.

Применительно к рынку Форекс, линейная регрессия представляет собой математический метод определения дальнейшего движения цены на основе статистических данных за

определенный период. В основе построения линии регрессии заложен метод определения

минимального квадратичного отклонения от текущих цен. Наибольшей популярностью

среди трейдеров пользуется канал линейной регрессии, представляющий собой линию

регрессии, дополненную еще двумя параллельными ей линиями на расстоянии стандартного отклонения. Сама линия регрессии в данном исполнении является серединой канала,

а две параллельные ей линии – его границами.

По статистике, стандартное отклонение в размере 1 охватывает около 68% всех ценовых движений, стандартное отклонение в размере 2 – около 95% всех ценовых движений,

а на стандартное отклонение в размере 3 приходится примерно 99,7% всех ценовых движений. По умолчанию, используется стандартное отклонение в размере 2, поскольку при

использовании трех стандартных отклонений, касание границ канала происходит довольно редко.

Торговля с использованием одного канала линейной регрессии без дополнительных

фильтров. Открытие позиции происходит в момент касания ценой одной из границ канала

в направлении противоположной границы. В данном случае фильтром ложных сигналов

является наклон самого канала линейной регрессии – к примеру, если канал направлен

вверх, то реагировать стоит лишь на касания нижней границы и открывать только длинные позиции (покупать).

Использование нескольких каналов линейной регрессии с различными размерами

стандартных отклонений. К примеру, используют несколько каналов линейной регрессии

одного периода, но со стандартными отклонениями в размере 1,2 и 3. В этом случае, границы каналов образуют полосы, попадание цены в каждую из которых говорит о сигналах

различной силы и трейдер, по возможности, варьирует размер торгового лота в зависимости от силы сигнала.

Каналы линейной регрессии являются неплохим инструментов для фиксации прибыли. Крайние границы каналов со стандартным отклонением в размере 2-3 и более могут

предвещать о завершении тенденции и дальнейшей консолидации или же развороте.

О регрессионном анализе.

Регрессионный анализ по праву может быть назван основным методом современной математической статистики.

Н. Дрейлер, Г. Смит

К регрессионному анализу относятся задачи выявления искаженной случайным «шумом» функциональной зависимости интересующего исследователя показателя Y от измеряемых переменных Х\,... ,Х т. Данными служит таблица экспериментально полученных «зашумленных» значений Y на разных наборах x i , . . . , x m . Основной целью обычно является как можно более точный прогноз (предсказание) Y на основе измеряемых (предикторных ) переменных.

Замечание. При изучении связи между несколькими случайными величинами X1,..., Xn

пользуются множественными и частными корреляционными отношениями и коэффициентами корреляции.

35

Основной характеристикой зависимости являются коэффициенты ij — простые коэффициенты корреляции между Xi и

Xj, в совокупности образующие корреляционную матрицу ( ij) (очевидно, ij = ji и kk = 1). Мерой линейной корреляции

между X1 и совокупностью всех остальных величин X2,..., Xn служит множественный коэффициент корреляции, равный, например, при n = 3

2

2

12

2

13

1 23

12

13

23

.

2

1

23

Обобщение на многомерный случай

Регрессионный анализ (линейный) — статистический метод исследования зависимости между зависимой переменной

Y и одной или несколькими независимыми переменными

X1 ,..., X p . Независимые переменные иначе называют рег-

рессорами или предикторами, а зависимые переменные — критериальными. Терминология зависимых и независимых переменных отражает лишь математическую зависимость переменных, а не причинно-следственные отношения.

Цели регрессионного анализа

1.

2.

3.

4.

Определение наличия и характера (математического уравнения, описывающего зависимость) связи между переменными

Определение степени детерминированности вариации критеральной переменной предикторами

Предсказать значение зависимой переменной с помощью независимой

Определить вклад независимых переменных в вариацию зависимой

Математическое определение линейной регрессии

Строго регрессионную зависимость можно определить следующим образом. Пусть

Y , X 1 , X 2 ,..., X p — случайные

величины с заданным совместным распределением вероятностей. Если для каждого набора значений

X1

x1 , X 2

M (Y | X1

x2 ,..., X p

x1 , X 2

xp

определено условное математическое ожидание

x2 ,..., X p

величины Y по величинам

xp )

( x1 , x2 ,..., x p ) , то функция ( x1 , x2 ,..., x p )

называется регрессией

X1 , X 2 ,..., X p , а ее график — линией регрессии Y по X1 , X 2 ,..., X p , или уравнением

регрессии.

Зависимость Y от

X1 , X 2 ,..., X p проявляется в изменении средних значений Y при изменении X1 , X 2 ,..., X p . Хотя

при каждом фиксированном наборе значений

X1

x1 , X 2

x2 ,..., X p

x p величина Y остается случайной вели-

чиной с определенным рассеянием.

Для выяснения вопроса, насколько точно регрессионный анализ оценивает изменение Y при изменении

используется средняя величина дисперсии Y при разных наборах значений

X1 , X 2 ,..., X p

X1 , X 2 ,..., X p

(фактически речь идет о

мере рассеяния зависимой переменной вокруг линии регрессии).

Обобщение для n-мерных случайных величин.

Особенно часто встречается случай уравнения регрессии, выражающегося линейной комбинацией тех или иных заданных функций:

у = (Х) =

0 0(x)

+

1 1(x)

+ ... +

m m(x).

Наиболее важное значение имеет параболическая (полиномиальная) регрессия, при которой

m

m(x) = x .

0(x)

=1,

1(x)

= x, ...,

36

Простым примером регрессии Y по Х является зависимость между Y и X, которая выражается соотношением:

, где ( x) M (Y | X

Y

(X )

x) ,

а случайные величины Х и

функциональной связи y

независимы. Это представление полезно, когда планируется эксперимент для изучения

(x) между неслучайными величинами у и х.

На практике обычно коэффициенты регрессии в уравнении

тальным данным.

y

(x)

неизвестны и их оценивают по эксперимен-

Первоначально термин «регрессия» был употреблен английским статистиком Ф. Гальтоном (1886) в теории наследственности в следующем специальном смысле: «возвратом к среднему состоянию» (regression to mediocrity) было названо

явление, состоящее в том, что дети тех родителей, рост которых превышает среднее значение на а единиц, имеют в

среднем рост, превышающий среднее значение меньше чем на а единиц.

Регрессия в математической статистике – зависимость среднего значения одной величины (y) от другой величины (или

нескольких величин) x. В отличие от строгой функциональной зависимости y = f(x) в регрессионной модели одному и

тому же значению величины x могут соответствовать несколько значений величины y, иными словами, при фиксированном значении x величина y имеет некоторое случайное распределение.

Регрессионный анализ используется для определения общего вида уравнения регрессии (наиболее часто используется

линейная модель), оценки параметров этого уравнения, а также проверки различных статистических гипотез относительно регрессии.

Регрессионная модель основана на предположении о том, что величина x является контролируемой величиной, значения

которой задаются во время эксперимента, а величина y является наблюдаемой в ходе эксперимента.

Необходимо отметить, что в том случае, если величина x также является случайной, то для изучения связи между величинами используются методы корреляционного анализа.

В аналитической химии линейный регрессионный анализ используется при построении градуировочной модели. В качестве величины x выбирается содержание определяемого компонента (которое является установленной величиной для

серии образцов сравнения), а в качестве наблюдаемой величины y выступает аналитический сигнал, который подчиняется случайному распределению. В аналитической химии также применяется множественный регрессионный анализ при исследовании многомерных зависимостей (например, при построении многокомпонентной градуировки используется множественная регрессия и т.д.)

37