Нейросетевая аппроксимация регулярных фракталов

реклама

Нейросетевая аппроксимация

регулярных фракталов

А. Ю. Дорогов, М. Ю. Щестопалов

Санкт-Петербургский государственный электротехнический университет1

Предложены аналитические модели кратномасштабного представления

регулярных фракталов и мультифракталов и показано их применение для

описания одномерных и двумерных фракталов Кантора и Лебега. Исследована связь аналитических моделей с системами итерирующих функций.

Представлена стратифицированная модель быстрой нейронной сети и показана возможность ее использования для аппроксимации регулярных фракталов. Рассмотрены инварианты самоподобия и их нейросетевая интерпретация. Приведены примеры.

1.

Введение

Язык фрактальной геометрии занимает ведущее место в современном арсенале средств исследования физических процессов.

Фрактальные методы применяются для анализа механизмов рассеивания и поглощения излучения в пористых средах, для исследования сильно развитой турбулентности в жидкостях и газах, для описания диэлектрического пробоя и молнии, при анализе процессов

усталостного разрушения материалов, для описания геометрической структуры волновых функций в квантовой механике и т. п. [1].

Современные исследования показали, что в ряде случаев предельным состоянием динамической системы является фрактальная

структура — фрактальный аттрактор [2]. Фрактальные аттракторы

связаны с так называемыми сценариями динамического хаоса [3],

определяющего границы возможного прогнозирования поведения

динамических систем. В работах [4, 5] было показано, что многослойные нейронные сети могут служить генераторами фрактальных объектов и использоваться в этом качестве как инструмент

моделирования и анализа нелинейных явлений. Вид фрактала накладывает определенные ограничения на структуру, топологию и

параметры нейронной сети. Характерным свойством регулярных

фракталов является самоподобие или инвариантность при измене1 А.

c

Ю. Дорогов, М. Ю. Щестопалов, 2006

254

нии масштабов. Таким же качеством должны обладать и моделирующие нейронные сети. Для нейронных сетей свойство самоподобия

оказалось эквивалентным понятию слабой связанности [6]. Структурный и топологический синтез слабосвязанных регулярных сетей

рассматривался в работе [7]. Данный класс сетей близок по структуре к алгоритмам быстрого преобразования Фурье, поэтому сети данного класса получили название “быстрые нейронные сети”

(БНС). В данной работе представлены аналитические модели регулярных фракталов и методы их аппроксимации в классе быстрых

нейронных сетей. Приведена математическая формулировка инварианта самоподобия и представлена его интерпретация в нейросетевой модели.

2.

Регулярные фракталы и мультифракталы

Масштабная инвариантность предполагает неизменность основных геометрических особенностей фракталов при масштабных переходах. Количественной оценкой масштабной инвариантности является дробная метрическая размерность фрактального объекта.

Мультифракталы отличаются от обычных фракталов наличием зависимости геометрических свойств от масштабного уровня. Эта зависимость может быть детерминированной или стохастической и

приводит к тому, что метрические свойства мультифрактала характеризуются не одиночной дробной размерностью, а спектром

размерностей [8]. Условие масштабной инвариантности для мультифракталов получает расширенное толкование и формулируется

на уровне структурных моделей [15]. В настоящей работе на примере фракталов Кантора и Лебега рассматриваются аналитические

модели кратномасштабного представления регулярных фракталов

и мультифракталов.

2.1.

Фрактал Кантора

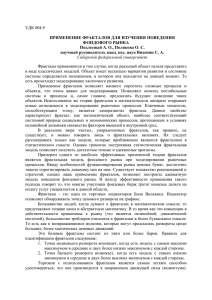

Построим аналитическую модель для фрактала Кантора, а затем обобщим ее на более широкий класс регулярных мультифракталов. На рис. 1 показаны три последовательных итерации одномерного фрактала Кантора. На каждой итерации из непрерывной

255

области удаляется средняя треть, что эквивалентно масштабной деформации исходной функции в отношении 1 : 3.

Рис. 1: Фрактал Кантора.

Будем полагать, что фрактал Кантора задан на непрерывном

интервале U = [0, 1). Любую точку данного интервала u ∈ U можно записать в троичной системе счисления в виде дроби (в общем

случае бесконечной):

u = 0, u1 u2 . . . un . . . ,

(1)

где разрядные числа ui ∈ {0, 1, 2} следует рассматривать как дискретные переменные различных масштабных уровней, определяющие положение точки на интервале определения. Введем также

непрерывные переменные ũi ∈ [0, 3). Очевидно, что последовательность разрядных чисел (1) можно в любом месте оборвать, завершив ее непрерывной переменной, в результате точка интервала будет представлена в виде:

u = 0, u1 u2 . . . un−1 ũn .

Будем полагать, что целые числа ui являются результатом действия оператора выделяющего целую часть из непрерывной переменной ũi . Операцию масштабирования можно рассматривать

256

как изменение правила представления точек интервала. Например,

для базовой функции Кантора аргумент определяется правилом

u = h0, ũ1 i = 3−1 ũ1 . Для функции второй итерации: u = h0, u1 ũ2 i =

3−1 u1 + 3−2 ũ2 . Для функции третьей итерации: u = h0, u1 u2 ũ3 i =

3−1 u1 + 3−2 u2 + 3−3 ũ3 , и т. д. На непрерывном интервале [0, 3) введем функцию:

1 if ũ ∈ [0, 1) ,

0 if ũ ∈ [1, 2) ,

ϕ (ũ) =

1 if ũ ∈ [2, 3) .

Нетрудно видеть, что фрактал Кантора в аналитическом виде

можно записать в виде бесконечного произведения:

f (u) = ϕ (ũ1 ) ϕ (ũ2 ) ϕ (ũ3 ) . . . ϕ (ũn ) . . . ,

где правило вычисления точки интервала задается выражением

(1). Учитывая это обстоятельство, непрерывные аргументы в последнем выражении можно заменить их дискретными аналогами,

в результате получим аналитическое выражение для регулярного

фрактала в дискретной форме:

f (u) = ϕ (u1 ) ϕ (u2 ) ϕ (u3 ) . . . ϕ (un ) . . . .

Оба выражения в пределе эквивалентны, но имеют существенное различие, когда фрактал аппроксимируется конечным произведением. В первом случае аппроксимирующая функция определена

на непрерывном интервале с числом точек равным континууму, а

во втором – на дискретном интервале с конечным числом точек.

Выбор той или иной формы зависит от условий задачи.

Для мультифрактала вид образующей функции ϕ (.) зависит от

масштабного уровня. Обобщенная аналитическая форма мультифрактала в дискретной форме может быть записана в виде:

f (u) = ϕi1 (u1 ) ϕi2 (u2 ) ϕi3 (u3 ) . . . ϕin (un ) . . . ,

(2)

где индексы i1 , i2 , i3 , . . . , in , . . . определяют множества допустимых

функций для каждого шага фрактальной итерации. Правило выбора функций из множества может быть детерминированным или

случайным. Например, возможно следующее детерминированное

правило:

i1 = 0,

i2 = hu1 i ,

i3 = hu1 u2 i ,

...,

in = hu1 u2 . . . un−1 i , . . . .

Угловые скобки, как и прежде, определяют поразрядное представление индекса в многоосновной системе счисления.

257

2.2.

Ковер Кантора

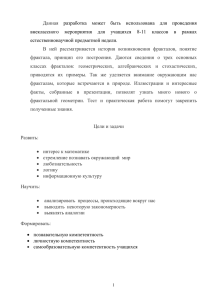

Двумерным вариантом фрактала Кантора являются плоская

фигура, заданная на непрерывных интервалах U = [0, 1), V = [0, 1).

На рис. 2. показана одна из итераций двумерного фрактала. Координаты точки в плоскости фигуры определяются бесконечными

дробями:

u = 0, u1 u2 . . . un . . . , ui ∈ {0, 1, 2} ,

v = 0, v1 v2 . . . vn . . . , vi ∈ {0, 1, 2} .

Обозначим через ũi ∈ [0, 3) и ṽi = [0, 3) соответствующие непрерывные переменные, тогда ковер Кантора в непрерывной аналитической форме можно записать в виде бесконечного произведения:

Рис. 2: Ковер Кантора.

f (u, v) = ϕ (ũ1 , ṽ1 ) ϕ (ũ2 , ṽ2 ) ϕ (ũ3 , ṽ3 ) . . . ϕ (ũn , ṽn ) . . . .

Дискретная форма для ковра Кантора соответственно имеет вид:

f (u, v) = ϕ (u1 , v1 ) ϕ (u2 , v2 ) ϕ (u3 , v3 ) . . . ϕ (uκ−1 , vκ−1 ) . . . ,

258

где все функции-сомножители являются

следующего вида:

1 1

ϕ (ui , vi ) = 1 0

1 1

2.3.

дискретными функциями

1

1 .

1

Фрактал Лебега

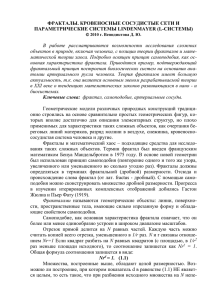

Фрактал Лебега строиться на стороне основания равностороннего треугольника. Каждая сторона треугольника делиться пополам. Линии, соединяющие точки деления вместе с основанием базового треугольника образуют два равносторонних треугольника

меньших размеров. Далее процедура повторяется над вновь образованными треугольниками, в результате на основании образуется

пилообразная линия, которая в пределе является фракталом. На

рис. 3 показаны три последовательных итерации фрактала Лебега.

В непрерывном варианте фрактал Лебега определен на интервале

U = [0, 1) . Каждая точка интервала u ∈ U может быть представлена в виде бесконечной дроби в системе счисления по основанию 2:

u = 0, u1 u2 . . . un . . . ,

где ui ∈ {0, 1}. Обозначим, как и прежде через ũi ∈ [0, 2) — непрерывные переменные. На непрерывном интервале [0, 2) определим

функцию:

ci ũ,

если ũ ∈ [0, 1) ,

(3)

ϕi (ũ) =

ci (2 − ũ) , если ũ ∈ [1, 2) ,

где ci = 2−i tgπ/3. Тогда фрактал Лебега может быть записан в

виде бесконечного логического произведения:

f (u) = ϕ1 (ũ1 ) ◦ ϕ2 (ũ2 ) ◦ . . . ◦ ϕn (ũn ) ◦ . . . ,

где символ ◦ обозначает операцию вычисления минимума, которую

обычно называют логическим произведением (a ◦ b = min (a, b)).

Основание системы счисления в представлении (1) определяется

структурной базой фрактального объекта; для фрактала Кантора

это значение равно 3, а для фрактала Лебега — 2. В непрерывном варианте основание системы счисления может быть выбрано

259

Рис. 3: Фрактал Лебега.

произвольно-кратным структурной базе. Значение основания влияет только на форму представления функций масштабного уровня.

Например, при основании системы счисления равным p, функции

сомножители (3) фрактала Лебега трансформируются к виду:

ci ũ,

если ũ ∈ [0, p/2) ,

ϕi (ũ) =

где ci = p−i tgπ/3.

ci (p − ũ) , если ũ ∈ [p/2, p) ,

При дискретной аппроксимации фрактала основание системы счисления играет существенную роль, поскольку определяет точность

представления функций масштабного уровня.

2.4.

Ковер Лебега

На рис. 4 показаны две итерации двумерного фрактала Лебега. Основанием объемной фигуры является квадрат, заданный на

непрерывных интервалах U = [0, 1), V = [0, 1). Координаты точки

в плоскости основания определяются бесконечными дробями:

u = 0, u1 u2 . . . un . . . ,

v = 0, v1 v2 . . . vn . . . ,

ui ∈ {0, 1} ,

vi ∈ {0, 1} .

260

Аналитическим выражением для ковра Лебега является бесконечное логическое произведение:

f (u, v) = ϕ1 (ũ1 ṽ1 ) ◦ ϕ2 (ũ2 , ṽ2 ) ◦ . . . ◦ ϕn (ũn , ṽn ) ◦ . . .

где ϕi (ũi , ṽi ) = ϕi (ũi ) ◦ ϕi (ṽi ).

Рис. 4: Ковер Лебега.

3.

Системы итерирующих функций

Простой алгоритм построения фрактальных объектов был предложен в середине 80-х годов американским математиком М. Барнсли [9]. Сущность метода заключается в описании итеративной фрактальной последовательности конечным набором (коллажом) сжиp

S

мающих отображений F (B) =

Fi (B). Каждая компонента наi=1

бора, независимо действуя на текущую итерацию B, порождает

компоненту следующей итерации. Для одномерного случая, фрактальная итерация Bk представляется функцией y = fk (u). Коллаж

сжимающих отображений воздействует на точки плоскости u, y для

которых y = fk (u), и порождают функцию y = fk+1 (u), определяющую следующую, Bk+1 итерацию фрактала. Для одномерно-

261

го фрактала Кантора (см. рис. 1) систему итерирующих функций

можно записать в виде:

u

T1 (u)

T2 (u)

T3 (u)

=

∪

∪

,

y

ϕ (u)

0

ϕ (u)

где T1 (u) = u3−1 , T2 (u) = u3−1 + 1 · 3−1 , T3 (u) = u3−1 + 2 · 3−1 ,

а функция ϕ (u) представляет собой первую итерацию фрактала

Кантора. Данную систему итеративных функций можно обобщить,

представив ее следующим образом:

u

y

k+1

3 [

Ti (u)

=

,

fk (Ti (u)) ϕ (u)

i=1

где fk (u) — это k-я итерация фрактальной последовательности.

Для k = 1 следует принять f1 (u) = 1. Последнее выражение явным образом определяет связь предшествующей итерации фрактала с последующей. Это форма удобна тем, что она допускает дальнейшее обобщения для мультифракталов. Мультифракталы отличаются тем, что базовая функция ϕ (u) изменяется в зависимости

от номера в коллаже итерирующих функций. В результате для описания мультифракталов может быть использована форма:

u

y

k+1

p [

Ti (u)

.

=

fk (Ti (u)) ϕi (u)

i=1

В общем случае образующие функции ϕi (u) могут изменяться от

итерации к итерации, также может быть переменным и количество отображений в коллаже. В этом случае обобщенная форма

для мультифрактала примет вид:

u

y

k+1

pk [

Tik (u)

.

=

fk Tik (u) ϕki (u)

i=1

Нетрудно заметить, что рассмотренная выше аналитическая форма

(2) для фрактала может быть получена бесконечным итерированием последнего выражения.

262

4.

Быстрые нейронные сети

Быстрая нейронная сеть (БНС) представляет собой многослойную регулярную сеть прямого распространения с топологией алгоритма быстрого преобразования. Каждый слой БНС состоит из набора однослойных персептронов (нейронных ядер) с непересекающимися рецепторными полями. Парадигма БНС объединяет в себе

идеологию многослойных модульных сетей и быстрых перестраиваемых преобразований. В подклассе быстрых спектральных преобразований нейронному ядру отвечает базовая операция (например, операция “бабочка” для БПФ размерности 2κ ). Базовая операция задается матрицей небольшой размерности, которая в терминах нейронной сети интерпретируется как синаптическая карта

нейронного ядра. В регулярных многослойных сетях все нейронные ядра в пределах одного слоя имеют одинаковые размерности

для одноименных терминальных полей, а число ядер и число слоев жестко связаны с размерностью нейронной сети. В разделе 6.2

будет показано, что БНС принадлежат к классу слабосвязанных

сетей и обладают самоподобной структурой.

4.1.

Топологическая модель БНС

Каждое нейронное ядро слоя λ представляет собой однослойный

персептрон с размерностью рецепторного поля pλ и числом нейронов gλ . Обозначим через uλ = [0, 1, . . . , pλ − 1] локальный номер рецептора (в пределах нейронного ядра), а через vλ = [0, 1, . . . , gλ − 1]

локальный номер аксона. Для определенности будем полагать, что

для входного слоя БНС глобальный номер рецептора (номер в пределах слоя) связан с локальными номерами взаимнооднозначным

соотношением:

U = huκ−1 uκ−2 . . . u0 i = uκ−1 pκ−2 pk−3 . . . p0 +

+uκ−2 pκ−3 pk−4 . . . p0 + . . . + u1 p0 + u0 ,

(4)

Аналогично положим, что для последнего слоя БНС глобальный

номер аксона связан с локальными номерами соотношением:

V = hvκ−1 vκ−2 . . . v0 i = vκ−1 gκ−2 gk−3 . . . g0 +

+vκ−2 gκ−3 gk−4 . . . g0 + . . . + v1 g0 + v0 .

(5)

263

Рис. 5: Топологическая реализация “с прореживанием по времени”.

Возможны и другие виды взамнооднозначных соответствий. Выражения (4) и (5) представляют собой ничто иное, как формулы

перехода от позиционного представления числа в многоосновной

системе счисления к его значению. Для скрытых слоев связь между глобальными и локальными номерами рецепторов и аксонов в

БНС определяется лингвистическими выражениями:

U λ = huκ−1 uκ−2 . . . uλ+1 uλ vλ−1 vλ−2 . . . v1 v0 i ,

V λ = huκ−1 uκ−2 . . . uλ+1 vλ vλ−1 vλ−2 . . . v1 v0 i ,

(6)

где λ = 0, 1, 2, . . . κ − 1 — номер нейронного слоя. Выражения (6)

удобно трактовать как грамматику слов формального языка с алфавитом из двух подмножеств букв u и v. Данные выражения определяют топологию сети, которая в теории быстрых алгоритмов получила название “с прореживанием по времени” [10]. На рис. 5 показан граф сети для случая, когда для всех слоев выполнено условие

pλ = gλ = 2. Вершинами графа являются нейроны, а дуги определяют синаптические связи. Сетевому графу соответствует следующая пара лингвистических предложений полученных при развертывании выражений (6) при условии κ = 4

[U ] = [hu3 u2 u1 u0 i hu3 u2 u1 v0 i hu3 u2 v1 v0 i hu3 v2 v1 v0 i],

[V ] = [hu3 u2 u1 v0 i hu3 u2 v1 v0 i hu3 v2 v1 v0 i hv3 v2 v1 v0 i].

(7)

264

Из соотношений (6) следует, что V λ = U λ+1 , поэтому при построении графа нейронной сети аксон и рецептор смежных слоев объединяются между собой дугой, когда значения одноименных

разрядов в соответствующих словах топологических предложений

совпадают. Возможны и другие варианты топологических реализаций. Общесистемные инварианты быстрых преобразований рассмотрены в работе [11].

4.2.

Структурная модель БНС

Если из выражений (6) удалить локальные переменные uλ и vλ ,

определяющие номера рецепторов и аксонов в нейронном ядре, то

оставшееся разрядное представление:

iλ = huκ−1 , uκ−2 . . . uλ+1 vλ−1 vλ−2 . . . v0 i

(8)

будет определять номер ядра в слое λ. Для описания структурной модели будем использовать алфавит состоящий из линейноупорядоченного набора букв с двумя видами родовых имен “i” и

“j”:

A = hhiiI ⊕ hjiJ i .

Здесь I и J — упорядоченные множества букв типа “i” и “j” соответственно. Число букв каждого вида в данном алфавите одинаково и

равно κ − 1. Поставим во взаимнооднозначное соответствие каждой

букве вида “i” данного алфавита букву вида “u” алфавита топологической модели, и аналогично, каждой букве вида “j” букву вида

“v”. Соответствие может быть произвольным, для определенности

выберем следующий вариант:

iλ = u λ ,

jλ = vλ ,

λ = 1, . . . , κ − 1,

λ = 0, . . . , κ − 2.

В этом случае выражение (8) преобразуется к виду:

iλ = hiκ−1 iκ−2 . . . iλ+1 jλ−1 jλ−2 . . . j0 i .

Откуда в частности следует:

i0 = hiκ−1 iκ−2 . . . i1 i ,

κ−1

i

= hjκ−2 jκ−3 . . . j0 i, а в общем виде:

iλ = hiiIλ ⊕ hjiJλ ,

(9)

265

где Iλ и Jλ подмножества букв каждого вида для слова с порядковым номером λ. Выражения в угловых скобках интерпретируются

как слова формального языка. Из этого набора слов составляются

предложения, в которых слова упорядочены по номеру λ. В соответствии с данным правилом число слов в предложении всегда

равно κ. Лингвистическое предложение структурной модели можно получить из любого лингвистического предложения топологической модели, удалив в словах с номером λ букву uλ (или vλ )

и выполнив переход к алфавиту структурной модели. Например,

два топологических предложения (7) трансформируются к одному

предложению структурного уровня:

[hi3 i2 i1 i

hi3 i2 j0 i

hi3 j1 j0 i

hj2 j1 j0 i] .

По этому предложению можно построить граф структурной модели. Каждое слово в предложении соответствует ядрам одного

нейронного слоя, численное значение слова определяет номер ядра

(вершину графа) в слое, вершины смежных слоев соединяются дугой, если в поразрядном представлении номеров вершин общие одноименные разрядные переменные имеют совпадающие значения.

Дуги графа соответствуют линейным операторам, связывающим

нейронные ядра смежных слоев. Для БНС ранги операторов межядерной связи всегда равны единице [11]. На рис. 6 показан граф

структурной модели для рассматриваемого примера.

Пусть числа λ и λ + 1 определяют порядковые номера двух

смежных слов в предложении. Тогда грамматическое правило для

допустимых предложений структурного уровня можно сформулировать следующим образом:

Iλ ⊃ Iλ+1 ,

Jλ ⊂ Jλ+1 ,

где I0 = I,

Iκ−1 = ∅, Jκ−1 = J,

J0 = ∅.

Построенная грамматика формального языка не связана ни с

видом преобразования, ни с его размерностью, ни с его топологией,

ни со структурными характеристиками и представляет собой инвариант морфологического уровня для всевозможных структурных

моделей быстрых алгоритмов.

266

Рис. 6: Граф структурной модели нейронной сети.

4.3.

Параметрическая модель БНС

Рассмотрим вариант нейронной сети с линейными функциями

активации. В этом случае оператор нейронного ядра представляет

собой линейное преобразование и описывается системой уравнений:

X

yiλλ (vλ ) =

xλiλ (uλ ) wiλλ (uλ , vλ ),

(10)

uλ

где iλ — номер ядра в слое λ, x (uλ ) — значение на входе рецептора,

y (vλ ) — значение на выходе аксона, wiλλ (uλ , vλ ) — синаптический

вес. При нулевых смещениях и линейных функциях активации действие оператора нейронной сети определяется матричным выражением Y = XH (здесь Y и X — строчные векторы). Элементы

матрицы преобразования H можно выразить частными производными:

∂y κ−1

κ−1 (vκ−1 )

.

(11)

h (U, V ) = i 0

∂xi0 (u0 )

267

Рассматривая yiκ−1

κ−1 (vκ−1 ) как сложную функцию от переменных предшествующего слоя можно записать:

∂yiκ−1

∂xiκ−1

∂yiκ−2

∂yiκ−1

κ−1 (vκ−1 )

κ−1 (uκ−1 )

κ−2 (vκ−2 )

κ−1 (vκ−1 )

·

·

=

.

κ−1

κ−2

0

∂xi0 (u0 )

∂x0i0 (u0 )

∂xiκ−1 (uκ−1 ) ∂yiκ−2 (vκ−2 )

Из (10) получим:

∂yiκ−1

κ−1 (vκ−1 )

∂xiκ−1

κ−1 (uκ−1 )

= wiκ−1

κ−1 (uκ−1 , vκ−1 ) .

Из топологии графа следует, что

∂xiκ−1

κ−1 (uκ−1 )

когда V κ−2

= 1,

∂yiκ−2

κ−2 (vκ−2 )

= iκ−2 ⊕ vκ−2 = iκ−1 ⊕ uκ−1 = U κ−1 и

∂xiκ−1

κ−1 (uκ−1 )

∂yiκ−2

κ−2 (vκ−2 )

=0

для остальных случаев. Многократно повторяя подобное разложение для последних сомножителей, получим в результате, что элементы матрицы H представимы выражением:

h (U, V ) = wi00 (u0 , v0 ) wi11 (u1 , v1 ) . . . wiκ−1

κ−1 (uκ−1 , vκ−1 ) ,

(12)

где U = huκ−1 uκ−2 . . . u0 i, V = hvκ−1 vκ−2 . . . v0 i,

iλ = huκ−1 , uκ−2 . . . uλ+1 vλ−1 vλ−2 . . . v0 i. Алгоритмически это означает, что для каждой пары U, V однозначно определяются разрядные переменные {uλ } , {vλ }, значения которых управляют выбором

номеров нейронных ядер iλ в выражении (12).

5.

Дискретная аппроксимация фракталов

В дискретном варианте итерации фрактала строятся на последовательности расширяющихся дискретных интервалах:

Ui = {0, 1, 2, . . . , Ni − 1} ,

i = 0, 1, 2, . . . , κ − 1,

268

где точки интервалов определяются правилом u = hui−1 ui−2 . . . u0 i.

В общем случае разрядные переменные имеет различные по размеру области определения: ui ∈ {0, 1, . . . , pi − 1}. На локальных

интервалах определены кусочно-постоянные дискретные функции

ϕi (ui ). Аппроксимация фрактальной итерации записывается в виде конечного произведения: f (u) ≈ ϕi0 (u0 ) ϕi1 (u1 ) . . . ϕiκ−1 (uκ−1 ) .

Например, для фрактала Кантора все дискретные образующие функции одинаковы и имеют вид:

если u = 0,

1,

0,

если u = 1,

ϕ (u) =

1,

если u = 2.

В приведенном варианте аппроксимации, интервалы постоянства функций совпадают с интервалами масштабирования. В общем случае можно задать более детальное представление функций

за счет увеличения основания системы счисления кратно структурной базе. Эта же цель может быть достигнута и использованием аппроксимирующих функций с двумя аргументами: ϕi hui si i,

где младшие разрядные переменные si , с областью определения

{0, 1, . . . , di − 1} устанавливает необходимую точность представления на интервалах масштабирования, а старшие сохраняют структурную базу фрактала. В этом случае дискретные точки на интервале Ui будет определяться выражением:

u = huκ−1 sκ−1 uκ−2 sκ−2 . . . u0 s0 i .

Такой вариант эквивалентен увеличению основанию системы счисления, но кратность основания со структурной базой поддерживается автоматически.

5.1.

Аппроксимация для ковра Кантора

Дискретная аппроксимация для итераций ковра Кантора (см.

рис. 2) представляет собой конечное произведение:

f (u, v) ≈ ϕ (u1 , v1 ) ϕ (u2 , v2 ) ϕ (u3 , v3 ) . . . ϕ (uκ−1 , vκ−1 ) ,

(13)

где все дискретные образующие функции имеют вид:

1 1 1

ϕ (ui , vi ) = 1 0 1 .

1 1 1

269

Нетрудно заметить, что полученное выражение по форме совпадает с представлением (12) для элементов матрицы H нейронной

сети. Сравнивая (12) и (13) получим следующие правила вычисления параметров нейронных ядер:

wiλλ (uλ , vλ ) = ϕ (uλ , vλ ) .

На рис. 7 показана нейросетевая аппроксимация для фрактальной итерации ковра Кантора на интервалах длиной N = 32 . Аппроксимирующая нейронная сеть имеет два слоя, каждой матрице сомножителю отвечает один нейронный слой. Все непоказанные

элементы матриц равны нулю. Контуром выделены нейронные ядра. Из рисунка видно, что результирующая матрица подобна ковру

Кантора.

Рис. 7: Нейросетевая аппроксимация для двумерного фрактала

Кантора.

5.2.

Аппроксимация для ковра Лебега

Дискретная аппроксимация для фрактальной итерации ковра

Лебега представляет собой конечное логическое произведение

h (U, V ) = wi00 (u0 , v0 ) ◦ wi11 (u1 , v1 ) ◦ . . . ◦ wiκ−1

κ−1 (uκ−1 , vκ−1 ) ,

где U = {0, 1, 2, . . . , N − 1}, V = {0, 1, 2, . . . , N − 1}, N = pκ .

270

Для дискретной аппроксимации используется нечеткая нейронная сеть “OR” типа,

реализующая базовые операции вида

y (v) = ⊕ w (u, v) ◦ x (u), где символ ⊕ обозначает операцию лоu

гического суммирования (a ⊕ b = max (a, b)).

Пример. Рассмотрим аппроксимацию для ковра Лебега при основании системы счисления p = 4. При переходе к дискретной форме представления возникает неопределенность в выборе значений

функций в пределах шага дискретизации. Если не наложены какиелибо ограничения, то допустим любой вариант. На рис. 8 показаны

выбранные точки аппроксимации для рассматриваемого примера.

В этом варианте две первых аппроксимирующих функции определяются следующими наборами значений:

1 π 1 3 3 1

,

ϕ1 (u) = tg

4 3 8 8 8 8

1 π 1 3 3 1

ϕ2 (u) =

tg

.

16 3 8 8 8 8

Рис. 8: Точки аппроксимации.

В дискретном представлении аппроксимация по первым двум

функциям строится на целочисленном интервале длиной N = 16.

В нейронной сети нумерация слоев начинается с нуля и имеет индексацию противоположную индексации функций сомножителей

в непрерывной форме фрактала. Для наглядности представления

271

приведем значения функций к целому виду, умножив их на величину 16 · 8/tg (π/3). Меняя также индексацию функций, получим:

ϕ0 (u) = (1, 3, 3, 1) ,

Для ковра Лебега

1

1

W0 =

1

1

ϕ1 (u) = (4, 12, 12, 4) .

нейронные ядра будут определяться матрицами:

1 1 1

4 4 4

4

3 3 1

, W1 = 4 12 12 4 .

4 12 12 4

3 3 1

1 1 1

4 4 4

4

На рис. 9 показана топологическая реализация нейронной сети, аппроксимирующей вторую итерацию ковра Лебега. Нечеткая нейронная сеть имеет два слоя. Матрицы сомножители соответствующие нейронным слоям связаны операцией матричного логического

умножения.

Рис. 9: Нейросетевая аппроксимация для второй итерации двумерного фрактала Лебега.

6.

Инварианты самоподобия

Ключевое слово, характеризующее фракталы это самоподобие.

Свойство самоподобия отражает независимость основных геометрических особенностей фрактального объекта от изменения масштаба. Большинство природных объектов утрачивают детали, когда их приближают, т. е. уменьшают масштаб для более детального

рассмотрения. Фрактал же можно приближать до бесконечности.

272

Для фракталов допустимые изменения масштаба всегда кратны

некоторому целому числу. Это целое определяет число частей в разбиении масштабной единицы носителя фрактала. На каждой части

разбиения фрактал повторяет себя по геометрическим свойствам.

Таким образом, свойство самоподобия фракталов характеризуется двумя моментами: во-первых, последовательным итерационным

разбиением масштабной единицы и, во-вторых, повторением геометрии фрактала на каждой составной части. Последнее влечет за

собой условие тождественности образуемых составных частей. Если не связывать свойство самоподобия с фракталами, то условие

масштабной тождественности составных частей при итерационном

разбиении не является обязательными. Инвариантом самоподобного процесса является только последовательное разбиение масштабной единицы на более мелкие составные компоненты.

6.1.

Нейросетевая интерпретация

Реализация свойства самоподобия в структуре нейронных сетей приводит к понятию слабосвязанной модульной сети. Условие

слабой связанности [12, 13, 14] выражает собой отношение между

окрестностями вершин (модулей) и их проекциями на терминальные слои сети. Введем необходимые определения для формализации этого условия. В терминах нейронных сетей входной терминальный слой называется афферентом, а выходной — эфферентом.

Под афферентной проекцией некоторой вершины B (далее обозначается Af r (B)) понимается подмножество вершин афферентного

слоя, связанных дугами с этой вершиной. Аналогично под эфферентной проекцией вершины B (далее обозначается Ef r (B)) понимается подмножество вершин эфферентного слоя связанных дугами с этой вершиной. Определим также рецепторную окрестность

Γ−1 (B) как множество вершин непосредственно предшествующего слоя, связанных дугами с вершиной B и аксоновую окрестность

Γ (B), как множество вершин последующего слоя, связанных дугами с вершиной B. На рис. 10 показан пример структурной модели

трехслойной слабосвязанной нейронной сети. Для вершины B1 данного примера терминальные проекции имеют следующий состав:

Af r (B1 ) = {A3 , A4 , A5 } ,

Ef r (B1 ) = {C0 , C1 } .

273

Рис. 10: Слабосвязанная многослойная нейронная сеть.

На основе введенных определений принцип слабой связанности

может быть выражен парой симметричных условий:

P

Af r (A),

Af r (B) =

A∈Γ−1 (B)

P

Ef r (B) =

Ef r (C),

C∈Γ(B)

P

где символ

обозначает прямую сумму соответствующих множеств. Первое выражение устанавливает, что в слабосвязанной сети

для любой вершины B афферентные проекции вершин ее рецепторной окрестности не пересекаются, второе - устанавливает аналогичное условие для эфферентных проекций. Фактически оба выражения двойственны друг другу и если выполняется одно из них,

то обязательно будет выполнено и другое [15]. Данные выражения

в математической форме определяют морфологический инвариант

самоподобия сети при ограниченном числе слоев. Каждому нейронному слою соответствует одна итерация самоподобного процесса порождения сети. Бесконечному процессу отвечает растущая нейронная сеть с неограниченным числом слоев и числом вершин в слое.

274

Характерной особенностью слабосвязанных сетей является отсутствие параллельных путей между вершинами. Более детально механизм порождения слабосвязанной сети представлен в работе [13].

6.2.

Самоподобие быстрых нейронных сетей

Докажем теперь, что введенная выше для БНС грамматика

формального языка порождает слабосвязанные регулярные структуры. В интерпретирующем графе регулярной сети номер вершины

в слое λ определяется выражением (9). Номер вершин начального

и конечного слоя можно тождественно представить в виде:

D

E

D

E

i = hiiIλ ⊕ hiiI\Iλ ,

j = hjiJλ ⊕ hjiJ\Jλ ,

(14)

где I\Iλ и J\Jλ обозначают разность множеств. По принципу построения интерпретирующего графа, вершины двух смежных слоев связаны дугой, если одноименные переменные в смежных словах лингвистического предложения имеют совпадающие значения.

Выполняя индукцию по номеру слоя, нетрудно показать, что вершина iλ будет связана с теми вершинами начального и конечного

слоя, для которых одноименные разрядные переменные в выражениях (14) будут иметь те же значения, что и в выражении (9). Следовательно, терминальные проекции вершины iλ можно выразить

следующими параметрическими формами:

E

E

D

D

Ef r iλ = hjiJλ ⊕ hjiJ\Jλ .

Af r iλ = hiiIλ ⊕ hiiI\Iλ ,

Здесь круглыми скобками выделены варьируемые разряды терминальных слов. Тогда для афферента вершины iλ−1 слоя λ−1 можно

записать:

E

D

(15)

Af r iλ−1 = hiiIλ−1 ⊕ hiiI\Iλ−1 .

Будем полагать, что вершины iλ и iλ−1 связаны между собой

дугой графа. По правилам порождающей грамматики Iλ ⊂ Iλ−1 ,

причем разность множеств Iλ−1 \Iλ для БНС состоит точно из одной

буквы (разряда). Из взаимной однозначности поразрядного представления числа и его значения следует:

(16)

Af r iλ = ⊕ Af r iλ−1 ,

Iλ−1 \Iλ

275

где прямая сумма подмножеств берется по всем значениям разрядного числа Iλ−1 \Iλ . Аналогично для эфферентов вершин смежных

слоев λ и λ + 1 можно получить:

Ef r iλ = ⊕ Ef r iλ+1 .

(17)

Jλ+1 \Jλ

Выражения (16), (17) показывают, что интерпретирующий граф

представляет собой слабосвязанную сеть.

7.

Заключение

Использование аналитических моделей регулярных фракталов

и мультифракталов позволяет строить приближенные аналитические решения, описывающие поведение фрактальных объектов в

разных масштабных представлениях. В работе [11] было показано, что любая дискретная функция также может быть представлена в виде мультифрактального произведения. Это означает, что

предложенные аналитические модели могут быть применены для

исследования физических объектов смешанного типа, в которых

фрактальные свойства проявляются только в некоторых областях

фазового пространства.

Список литературы

[1] Шредер М. Фракталы, хаос, степенные законы. Миниатюры из

бесконечного рая. Ижевск: НИЦ “Регулярная и хаотическая

динамика”. 2001. 528 с.

[2] Малинецкий Г. Г., Потапов А. Б. Современные проблемы

нелинейной динамики. М.: Эдиториал УРСС. 2000. 336 с.

[3] Кроновер Р. М. Фракталы и хаос в динамических системах. М.:

Постмаркет. 2000. 350 с.

[4] Макаренко Н. Г. Фракталы, аттракторы, нейронные сети и все

такое // Материалы 4-й Всероссийской науч. техн. конф. “Нейроинформатика 2002”. 23-25 января 2002 г. Москва. / Лекции

по нейроинформатике. Часть 2. C. 136–169.

276

[5] Stark J. Iterated function systems as neural networks // Neural

Networks. 1991. V. 4. P. 679–690.

[6] Дорогов А. Ю., Алексеев А. А. Пластичность многослойных

слабосвязанных нейронных сетей // Нейрокомпьютеры: разработка и применение. № 11. 2001. C. 22–40.

[7] Дорогов А. Ю. Структурный синтез быстрых нейронных сетей

// Нейрокомпютер. № 1. 1999. С. 11–24.

[8] Божокин С. В., Паршин Д. А. Фракталы и мультифракталы. Ижевск: НИЦ “Регулярная и хаотическая динамика”. 2001.

128 с.

[9] Barnsley M. Fractals Everywhere. Academic Press. Boston. 1987.

[10] Рабинер Л., Гоулд Теория и примененение цифровой обработки сигналов / Пер. с англ. М.: Мир. 1978. 848 с.

[11] Дорогов А. Ю. Быстрые нейронные сети: Проектирование,

настройка, приложения // Лекции по нейроинформатике

Часть 1. Материалы школы семинара “Современные проблемы нейроинформатики”. 6 Всерос. научн. техн. конф. “Нейроинформатика 2004”. М.: МИФИ. 2004. С. 69–134.

[12] Дорогов А. Ю. Структурный анализ слабосвязанных нейронных сетей // Управление в социальных, экономических и технических системах. Кн. 3. Управление в технических системах:

Труды Межресп. научной конф. г. Кисловодск. С. 75–80.

[13] Дорогов А. Ю. Структурный синтез модульных слабосвязанных нейронных сетей. Часть 1. Методология структурного синтеза модульных нейронных сетей // Кибернетика и системный

анализ. 2001. № 2. С. 34–42.

[14] Дорогов А. Ю. Структурный синтез модульных слабосвязанных нейронных сетей. Часть 2. Ядерные нейронные сети //

Кибернетика и системный анализ. 2001. № 4. С. 13–20.

[15] Дорогов А. Ю. Фракталы и нейронные сети // Проблемы нейрокибернетики (материалы Юбилейной межд. конф. по нейрокибернетике посв. 90-летию со дня рождения проф. А. Б. Когана 23-29 октября 2002 г. Ростов-на-Дону). Т. 2. Ростов-на-Дону.

2002. С. 9–14.

277