Вопросы. Нейроинформатика

реклама

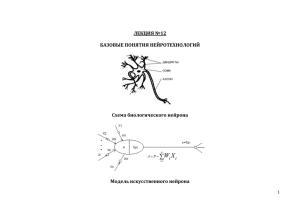

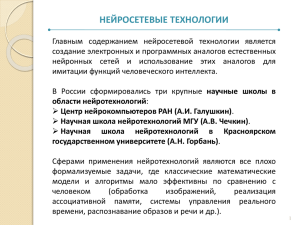

ВОПРОСЫ К ЭКЗАМЕНАМ по ИНС Часть 1. Тема 1. Введение в теорию искусственных нейронных сетей (ИНС) 1.1. Нейрокомпьютеры и нейротехнологии: современное состояние и перспективы развития. 1.2. Базовые понятия и определения теории ИНС. Биологические прототипы и искусственный интеллект. 1.3. Искусственный нейрон (ИН). Математическая модель нейрона. Модель возбуждения ИН. Динамическая модель ИН. 1.4. Типовые модели ИН. Базовая модель формальгого нейрона (ФН) (Мак-Калока-Питтса). Модели Фукушима, Адалин, Хопфилда, Рекурентная дискретная модель (хопфилда), модель Гроссберга. Простой персептрон. Звезды Гроссберга. Обобщенная модель ФН. 1.5. Искусственные нейронные сети (ИНС). Однослойные и многослойные ИНС. Линейные и нелинейные ИНС. Архитектуры ИНС: прямого распространения, рекурентные, «ячеистые». 1.6. Цели и задачи обучения ИНС. Типовая модель обучения Обучение с учителем и без учителя. Обучение по Хэббу. Тема 2. Математические основы теории ИНС 2.1. Обучение ИНС как задача оптимизации. Постановка задачи и формализация критерия. Классификация методов оптимизации. Специфика проблемы оптимизации с т.з. обучения. 2.2. Детерминированные методы оптимизации. Градиентные методы: наискорейшего спуска, крутого восхождения, релаксационные. 2.2. Детерминированные методы поиска экстремума. Методы Ньютона и Квазиньютона. Метод сопряженного градиента. 2.3. Методы стохастического поиска экстремума. Проблема локальных и глобального минимума. Принцип стохастического поиска глобального минимума. 2.4. Алгоритмы стохастической оптимизации. Обучение по Больцману. Метод отжига.Метод Бранина. 2.5. Общая характеристика генетических алгоритмов обучения. Две идеологии в синтезе алгоритмов обучения: популяционная и генетическая. 2.6. Структура генетического алгоритма Генетический подход к выбору базиса.Иллюстрирующий пример. 2.4. Вычислительные аспекты и алгоритмизация методов обучения ИНС. Вычисление градиента сложной функции и принцип двойственного функционирования. Тема 3. Персептроны – простейшие нейронные сети. 3.1. Зарождение теории ИНС. Простейшие модели ИНС: однослойный перспептрон. Анализ персептронной модели ИНС. Понятие представляемости и обучаемости. 3.2. Основы теории пороговой логики. Задача линейной разделимости функций и ее ограничения. 3.3. Проблема ограничений на линейную разделимость функций. Число различимых комбинаций для однослойного персептрона. Преодаление ограничений на линейную разделимость. Многослойные персептроны. 3.4. Проблема ограничений на выпуклость границы разделимости. Преодоление ограничений на выпуклость. 3.5. Механизмы запоминания в Персептроне. Обучающее правило. Алгоритмы обучения персептронов. Дельта правило. 3.7. Тестовые примеры моделирования Персептрона ( в пакете Матлаб). Тема 4. Сети прямого распространения 4.1. Адаптивныя линейная фильтрация. АДАЛИН-сети. Проблема минимизации ошибки обучения персептронов. Дельта-правило. 4.2. Сети прямого распространения. Архитектура и алгоритм работы сети. 4.3. РБФ-сети. Проблема РБФ-аппроксимации. Архитектура и работа сети. Стратегия и алгоритмы обучения РБФ-сети. Тестовые примеры моделирования РБФ-сети ( в пакете Матлаб). Тема 5. Обучение с учителем в сетях прямого распространения 5.1. Обучение однослойного персептрона. Обучающее правило Розенблата. 5.2. Минимизация ошибки обучения. Обучение адаптивной линейной сети (ADALINE-сети). Обучающее правило Уидроу-Хопфа (дельта-правило). 5.3. Алгоритмизация и программирование обучения однослойной сети в среде LabVIEW. 5.4. Обучение многослойной сети прямого распространения. Базовая процедура обучения - BackPropagation и ее алгоритмизация среде LabVIEW. 5.5. Ускоренная процедура Back-Propagation. Часть П. Самообучающиеся и самоорганизующиеся нейронные сети. Введение. Самообучающиеся и самоорганизующиеся нейронные сети. Обучение без учителя. Самообучение на обучающихся выборках. Тема 1. Принципы самоорганизации и самообучения в нейронных сетях 1.1. Постановка задачи самообучения. Извлечение информации из данных. Нормализация, кластеризация и аппроксимация данных. 1.2. Нейросетевая модель интерпретации данных. Обучение нейронной сети как задача оптимизации. Правило Ойя. Модифицированное правило Ойя. 1.3. Нейросетевые модели извлечения многомерной информации. Тема 2. Нейросетевые модели автоматической кластеризации данных. 2.1. Кластер-анализ разнородных данных. Критерии однородности данных. 2.2. Нейросетевая модель кластеризации на основе конкурирующих нейронов. Динамика конкурирующих нейронов. Тема 3. Нейросетевые модели аппроксимации и извлечения скрытых закономерностей. 3.1. Многомерный регрессионный анализ разнородных данных. Метод главных компонент. 3.2. Нейросетевая модель адаптивной аппроксимации в базисе главных компонент. 3.3. Адаптивная аппроксимация в базисе сингулярного разложения. Тема 4. Нейросетевые модели снижения размерности и визуализации данных. 4.1. Топологическое упорядочивание на многомерных данных. Топология структуры данных. 4.2. Нейросетевая модель самоорганизации с настраиваемой топологией. Самоорганизующиеся карты Кохонена. 4.3. Линейная векторная классификация. LVQ-сети. Обучающее правило LVQ –сетей. 4.4. Сети встречного распространения – общие положения и характеристика. Обобщенная структура сети. Стратегия обучения сети, обучающее правило. Тема 5 . Нейросетевые модели ассоциативной памяти. 5.1. Природа ассоциативной памяти. Динамические ассоциации. Динамическая модель ассоциативной памяти (Операторно-матричная модель дискретной системы с обратными связями). 5.2. Нейросетевая модель с ассоциативной динамикой. Энергетическое состояние сети (энергетическая теория устойчивости). 5.3. Рекуррентная модель Хопфилда с ассоциативной динамикой. Обучение сети Хопфилда. 5.4. Проблема ускоренной классификации. Рекуррентная сеть Хэмминга. 5.5. Темпоральная ассоциативная память. Рекуррентная сеть Элмана 5.6. Модели авто- и гетероассоциаций. Двунаправленная ассоциативная память (ДАП). Архитектура ДАПсетей. Функционирование сети и восстановление запомненных ассоциаций. Обучение ДАП-сетей. Анализ ДАП-сети: информационная емкость памяти. Алгоритмическая реализация рекурентной ДАПсети. Иллюстрирующие примеры пакета MatLab. 5.7. Статистические рекурентные сети. Общие положения теории статистических рекурентных сетей. Статистические сети Хопфилда. Машина Больцмана. Обучение статистической сети. Тема 6. Нейросетевые модели контекстно-зависимых ассоциаций. 6.1. Восприятие через ассоциацию: контекстно-зависимый анализ. Информационная емкость сети. Дилемма стабильности-пластичности. Контекстно-зависимые ассоциации. Упрощенная модель алгоритма контекстно-зависимой ассоциации. 6.2. Теория адаптивного резонанса (АРТ). Структура АРТ-сети. Основные элементы сети. 6.3. Функционирование АРТ-сети. Фазы инициализации, распознавания, сравнения, поиска. Обучение АРТсети..