ПЗ №2 Вариант-3.

реклама

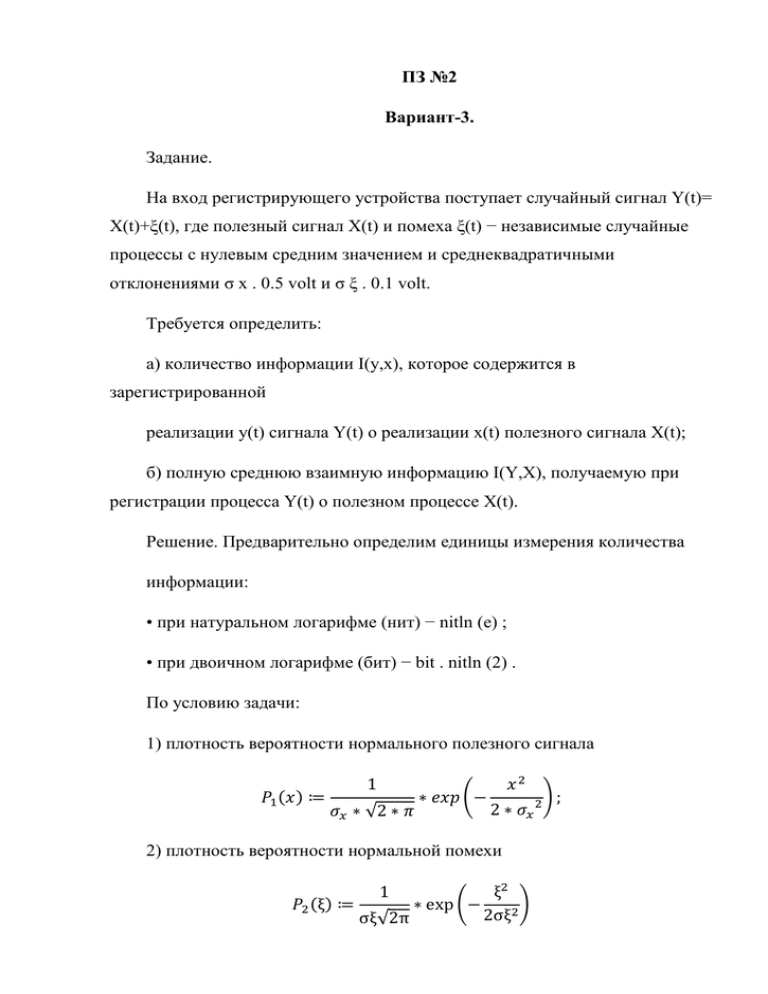

ПЗ №2 Вариант-3. Задание. На вход регистрирующего устройства поступает случайный сигнал Y(t)= X(t)+ξ(t), где полезный сигнал X(t) и помеха ξ(t) − независимые случайные процессы с нулевым средним значением и среднеквадратичными отклонениями σ x . 0.5 volt и σ ξ . 0.1 volt. Требуется определить: а) количество информации I(y,x), которое содержится в зарегистрированной реализации y(t) сигнала Y(t) о реализации x(t) полезного сигнала X(t); б) полную среднюю взаимную информацию I(Y,X), получаемую при регистрации процесса Y(t) о полезном процессе X(t). Решение. Предварительно определим единицы измерения количества информации: • при натуральном логарифме (нит) − nitln (e) ; • при двоичном логарифме (бит) − bit . nitln (2) . По условию задачи: 1) плотность вероятности нормального полезного сигнала 𝑃1 (𝑥) ≔ 1 𝜎𝑥 ∗ √2 ∗ 𝜋 ∗ 𝑒𝑥𝑝 (− 𝑥2 2 ∗ 𝜎𝑥 2 2) плотность вероятности нормальной помехи ξ2 𝑃2 (ξ) ≔ ∗ exp (− ) 2σξ2 σξ√2π 1 ); Сумма Y(t) двух нормальных процессов X(t) и ξ(t) является также нормальным процессом. Так как X(t) и ξ(t) − независимы, то дисперсия суммарного случайного сигнала D y:= σ 𝑥 2 +σ ξ2, а его среднеквадратичное отклонение σ y:=√𝐷𝑦 . При этом закон распределения нормального случайного сигнала Y(t) будет: 𝑦2 𝑃3 (𝑦) ≔ exp(− ) 2𝜎𝑦 2 𝜎𝑦 √2𝜋 1 С другой стороны, композиция законов распределения суммы двух независимых величин определяется интегралом свертки их плотностей вероятности ∞ 𝑃3 (𝑦) ≔ ∫−∞ 𝑃1 (𝑥)𝑃2 (𝑦 − 𝑥)𝑑𝑥,т.е. ∞ 1 𝑥2 (𝑦 − 𝑥)2 𝑃3 (𝑦) ≔ ∫ exp(− )𝑒𝑥𝑝 [− ] 𝑑𝑥; 2𝜎𝑥 2 2𝜎ξ 2 −∞ 2𝜋(𝜎𝑥 𝜎ξ ) 𝑃3 (𝑦) ≔ 1 2 exp[ 𝑦2 −1 2 (𝜎ξ 2 + 𝜎x 2 )] √𝜋 √2 √𝜎ξ 2 + 𝜎x 2 − результат интегрирования. Совместная плотность вероятности независимых сигналов X(t) и ξ(t) 𝑞1 (𝑥, ξ) ≔ 𝑝1 (𝑥)𝑝2 (ξ), т.е. 1 𝑥2 ξ2 𝑞1 (𝑥, ξ) ≔ exp(− − ) 2𝜋(𝜎𝑥 𝜎ξ ) 2𝜎𝑥 2 2𝜎ξ 2 Введем понятие условной плотности вероятности, например, p1(ξ/x) для случайной величины ξ при заданной (известной) величине x − pусл1 (x, ξ): = q1 (x,ξ) p1 ∞ , где 𝑝1 ≔ ∫−∞ 𝑞1 (𝑥, ξ)𝑑ξ (x) Для условной плотности вероятности должно выполняться условие нормировки ∞ ∫ 𝑃усл1 (𝑥, ξ)𝑑ξ = 1 −∞ Рассмотрим условную плотность вероятности p2(y/x)=q2(y,x)/p1(x) для реализации y(t) при известной реализации x(t). В общем случае знание x(t) дает также некоторую информацию о реализации y(t). Условная плотность вероятности p2(y/x) содержит больше (по крайней мере, не меньше) сведений о y(t), чем безусловная плотность вероятности p3(y), так как 𝑃3 (𝑦) = ∫ 𝑞2 (𝑦, 𝑥)𝑑𝑥. Насколько увеличивается информация о y(t) в результате того, что стала известной реализация x(t), зависит от конкретных условий. В нашем случае, когда y(t)=x(t)+ξ(t), информация о y(t) вообще не прибавляется, какой бы ни оказалась реализация x(t). Другими словами, при известной величине "x" неопределенность (случайный характер) величины "y" полностью определяется случайной помехой ξ. Это значит, что условная плотность вероятности p2(y/x)равна закону распределения помехи p2(ξ) при ξ=y-x, т.е. 𝑃усл1 (𝑦, 𝑥) ≔ 1 𝜎ξ √2𝜋 𝑒𝑥𝑝 [− (𝑦 − 𝑥)2 2𝜎ξ 2 ]. Из определения условной плотности вероятности следует совместная плотность вероятности сигналов Y(t) и X(t) 𝑞2 (𝑦, 𝑥) ≔ 𝑝1 (𝑥)𝑝усл2 (y, x), т.е. 𝑞2 (𝑦, 𝑥) ≔ 1 𝜎x √2𝜋 exp (− 𝑥2 2𝜎x 2 )[ 1 𝜎ξ √2𝜋 𝑒𝑥𝑝 [− (𝑦 − 𝑥)2 2𝜎ξ 2 ]] ; или после преобразований 1 𝑥2 𝑦2 𝑦𝑥 𝑥2 𝑞2 (𝑦, 𝑥) ≔ exp (− − + − ) 2𝜋(𝜎x 𝜎ξ ) 2𝜎x 2 2𝜎ξ 2 𝜎ξ 2 2𝜎ξ 2 Найдем на основании (2.8) или (2.7) при замене вероятностей P(yj/xi), P(yj) соответствующими плотностями вероятности p2(y/x), p3(y) количество информации I(y,x), которое содержится в зарегистрированной реализации y(t) сигнала Y(t) о реализации x(t) полезного сигнала X(t) [ 𝐼(𝑦, 𝑥) ≔ 𝑙𝑛 [ 1 (𝑦−𝑥)2 𝑒𝑥𝑝[− ]] 𝜎ξ √2𝜋 2𝜎ξ 2 1 𝑦2 exp(− ) 𝜎y √2𝜋 2𝜎y 2 ; I(2 volt . 2 volt ) = .13.448 bit. ] После преобразований можно получить 𝜎𝑦 𝑦2 𝑥2 𝑦𝑥 𝑦2 𝐼(𝑦, 𝑥) ≔ 𝑙𝑛 ( ) + − + − 𝜎ξ 2𝜎y 2 2𝜎ξ 2 𝜎ξ 2 2𝜎ξ 2 Усреднение этого частного количества взаимной информации по множеству реализаций дает полную взаимную информацию I(Y,X)=M[I(y,x)], получаемую при регистрации процесса Y(t) о полезном процессе X(t). Здесь M −знак математического ожидания. Раскрывая знак математического ожидания, имеем ∞ ∞ 𝐼𝑌𝑋 (𝜎x , 𝜎ξ ) ≔ ∫ ∫ 𝑞2 (yx)I(yx)dxdy −∞ −∞ Интегрирование дает 1 (−2 ln(𝜎ξ ) 2𝜎y 2 + 2 ln(𝜎y ) 2𝜎y 2 − 2𝜎y 2 + 2𝜎ξ 2 + 2𝜎x 2 ) 𝐼𝑌𝑋 (𝜎x , 𝜎ξ ) ≔ 2 𝜎y 2 𝐼𝑌𝑋 (𝜎x , 𝜎ξ ) ≔ 1 2 𝜎𝑦 [2𝜎y 2 (𝑙𝑛 ( 𝜎 )) − 2𝜎y 2 + 2𝜎ξ 2 + 2𝜎x 2 ] ξ 𝜎y 2 Таким образом, полное количество информации в сигнале Y(t) о сигнале X(t) будет 𝐼𝑌𝑋 𝜎ξ 2 𝜎𝑦 1 𝜎х 2 ≔ 𝑙𝑛 ( ) − + + 𝜎ξ 2 2𝜎y 2 2𝜎y 2 и составляет I = YX 2.35 bit . Выполнив подстановку(𝜎х 2 + 𝜎ξ 2 )вместо 𝜎y 2 , полученное выражение для I(Y,X) можно упростить √𝜎х 2 + 𝜎ξ 2 𝐼𝑛 𝜎ξ ( 1 2 𝜎ξ 2 1 𝜎x 2 − + + ; 2 2 ∗ (𝜎х 2 + 𝜎ξ 2 ) 2 ∗ (𝜎х 2 + 𝜎ξ 2 ) ) ln(𝜎х 2 + 𝜎ξ 2 ) − ln(𝜎ξ )− результат упрощения. Следовательно, в окончательном виде полное количество информации будет: 𝐼𝑌𝑋 𝜎х 2 + 𝜎ξ 2 1 1 𝜎х 2 ≔ 𝐼𝑛 ( ) или𝐼𝑌𝑋 ≔ 𝐼𝑛 ( 2 ) + 1 2 𝜎ξ 2 2 𝜎ξ