lab_practx

реклама

ФЕДЕРАЛЬНОЕ АГЕНТСТВО ПО ОБРАЗОВАНИЮ

ТОМСКИЙ ГОСУДАРСТВЕННЫЙ УНИВЕРСИТЕТ СИСТЕМ

УПРАВЛЕНИЯ И РАДИОЭЛЕКТРОНИКИ.

О.И. ЧЕРЕПАНОВ

ИДЕНТИФИКАЦИЯ И ДИАГНОСТИКА СИСТЕМ

ЛАБОРАТОРНЫЙ (ВЫЧИСЛИТЕЛЬНЫЙ) ПРАКТИКУМ

ТОМСК

1

Лабораторная работа № 1(2).

Применение метода максимального правдоподобия (метода наименьших квадратов)

для построения моделей систем: исследование связи между двумя или несколькими

случайными величинами.

Основные теоретические сведения

Математическая постановка задачи планирования экспериментов.

Следуя результатам работ [1,2], рассмотрим основы теории планирования

экспериментов. Пусть контролируемые переменные x , которые описывают состояние

моделируемой системы, при функционировании этой системы преобразуются в выходную

переменную y . Эксперимент с системой или моделью системы заключается в том, что

контролируемой переменной x последовательно присваиваются некоторые значения

,

Пусть точная аналитическая зависимость между переменными x и y неизвестна,

для которых получаются соответствующие значения выходной переменной y .

и пусть цель экспериментов – оценка этой зависимости. Такая постановка задачи типична

для многих исследований. От выбора значений контролируемой переменной x , то есть

, и количества опытов, в значительной степени зависит точность оценки этой

неизвестной зависимости y f (x ) .

Набор значений , которые принимает в ходе эксперимента контролируемая

переменная x , и представляет собой план имитационного эксперимента.

Эксперимент, для которого множество возможных значений содержит не

величин

менее двух различных элементов, называется активным, так как в этом случае

экспериментатор может управлять выбором элементов из множества , подчиняя этот

выбор каким-то своим целям. Если множество не определено или состоит из одного

элемента, то эксперимент называется пассивным.

Математическая постановка задачи планирования эксперимента такова. Пусть

заданы два множества объектов: { x} F1 и { y} F2 и предполагается, что существует

(пока не известный) оператор A : F1 F2 , преобразующий множество { x} F1 в

{ y} F2 , y Ax . Многие прикладные задачи заключаются в том, чтобы восстановить

неизвестный оператор A по экспериментальным данным.

В результате эксперимента объекту x ставится в соответствие некоторое значение

y Ax , которое из-за погрешностей эксперимента отличается от точного значения

y Ax . При восстановлении оператора A экспериментатор априори выбирает некоторое

множество операторов A , определенных на { x} F1 . Предполагается, что среди

операторов в A можно найти оператор A0 , близкий к А. Задачей оптимального

планирования эксперимента и является поиск оператора A0 .

Если искомый оператор А – функция, известная с точностью до конечного числа

неизвестных параметров (коэффициентов), то задач сводится к классической задаче

планирования регрессионных экспериментов. Смысл. который вкладывается в термин

регрессионный поясним несколько позже.

Регрессионные модели экспериментов и их статистический анализ.

2

Рассмотрим основные положения теории планирования эксперимента,

изложенные в [1-4]. Пусть выходная переменная y зависит от контролируемых

x {x1 , x 2 ,..., x k } . В результате выполнения n имитационных

переменных

экспериментов будет получен вектор

матрицы

y { y (1) , y ( 2) ,..., y ( n ) } , который зависит от

x11 ... x1k

F ( xij ) ... ... ... .

x

n1 ... x nk

(1.1)

Здесь первый индекс i – номер эксперимента, j – номер переменной, так что xij - значение

j – й контролируемой переменной в i – м эксперименте.

(1)

( 2)

(n)

В теории планирования экспериментов вектор y { y , y ,..., y } называется

вектором результатов измерения, а матрица F называется матрицей плана эксперимента.

При постановке экспериментов принимается априори (лат. a priori – из

предшествующего, до опыта) предположение, что зависимость между выходной и

управляемыми переменными имеет вид:

у f ( x , ) ,

(1.2)

причем функция f ( x , ) считается известной с точностью до конечного числа

неизвестных параметров (коэффициентов) { 1 , 2 ,..., m } . Другими словами, вид

функции также задается исследователем априори. Например, эта функция может быть

задана в виде полинома, тригонометрической функции и т.п.

Из-за погрешностей эксперимента, влияния случайных факторов, вектор

(1)

( 2)

(n)

результатов измерений y { y , y ,..., y } и матрица плана F связаны не точной

зависимостью (1.2), а стохастической зависимостью

у (i ) f ( x (i ) , ) (i ) , i 1,2,..., n, ,

(1.3)

где y

(i )

- измеренная в i-м эксперименте величина y (выходной сигнал),

(i )

(i ) - случайная

ошибка «измерений» этой величины в i-м эксперименте, x {x1 , x 2 ,..., x k } .

Следуя основам теории измерений, примем предположение о том, что случайные

ошибки распределены по нормальному закону, то есть плотность вероятности

1

e

распределения случайной величины x есть f ( x)

2

(i )

(i )

(i )

( x )2

2 2

. Это предположение

называют также основной гипотезой теории измерений. Принятие этого предположения

означает, что средние значения ошибок, т. е. математическое ожидание случайной ошибки

(i )

(i )

измерений , равно нулю ( E ( ) 0 ), ошибки в разных опытах некоррелированы (

E( (i ) , ( j ) ) 0 при i j ), и дисперсия D( ) ( ) , где

отклонение (разброс) случайной величины.

(i )

Учитывая, что E ( ) 0 , выражение (1.3) запишем в виде:

E ( у (i ) ) ( x (i ) , ) f ( x (i ) , ), ( i 1,2,..., n.)

(i )

(i ) 2

(i )

(i ) - стандартное

(i )

В теории планирования эксперимента функция ( x , ) f ( x , ) называется

поверхностью (имеется в виду её графическое изображение) отклика или функцией

регрессии.

3

Задача регрессионного анализа заключается в том, чтобы оценить значения

{ 1 , 2 ,..., m } по выборке экспериментальных значений y { y (1) , y ( 2) ,..., y ( n ) } .

Наиболее изученным в теории планирования экспериментов является случай, когда

функция f ( x , ) линейна по параметрам { 1 , 2 ,..., m } . В этом случае зависимость

у f ( x , ) имеет вид:

у (i ) f ( x (i ) ) ( i ) , i 1,2,..., n.

(1.4)

Здесь функция f ( x ) { f 1 ( x ), f 2 ( x ),..., f m ( x )} рассматривается как заданная

векторная непрерывная функция своих аргументов.

Наконец, частным случаем зависимости (1.4) является случай, когда выходной

сигнал y линейно зависит не только от коэффициентов (параметров) { 1 , 2 ,..., m } ,

но и контролируемые переменные также линейно входят в правую часть (1.4). Тогда

выражения (1.4) преобразуется к виду:

(1.5а)

у (i ) 1 x1(i ) 2 x2(i ) ... m xm(i ) (i ) , i 1,2,..., n.

В матричной форме записи это уравнение имеет вид:

у F ( { (1) , ( 2) ,..., ( n ) }.

(1.5b)

Здесь F - матрица вида (1.1) размером nm (k=m в 1.1).

Теперь рассмотрим линейные оценки значений параметров

которые получаются на основе экспериментов и имеют вид:

~

Tу ,

{ 1 , 2 ,..., m } ,

(1.6)

где T – матрица размера mn.

~

Оценка называется наилучшей линейной несмещенной оценкой, если она

2

имеет наименьшие дисперсии D( i ) ( i ) среди всех оценок вида (1.6). Естественно,

возникает вопрос, как найти матрицу Т и наилучшую линейную несмещенную оценку?

Ответ дает теорема Гаусса-Маркова и её следствия. Но прежде чем перейти к их

изучению, рассмотрим общие основы теории наблюдений (см., например, [5]),

необходимые для лучшего понимания методов статистического анализа регрессионных

экспериментов.

Метод максимального правдоподобия. Пусть целью экспериментов является

измерение некоторой величины x (скалярный случай). Пусть истинное значение этой

величины равно x0. Будем пока считать, что это точное значение измеряемой величины

известно. Тогда ошибка наблюдения будет равна x x 0 . Примем предположение,

что, как случайные ошибки измерения, так и результаты измерений неизвестной

величины x, распределены по нормальному закону. Мы уже говорили, что это

предположение называют также основной гипотезой теории измерений. Тогда плотность

вероятности распределения величины x есть

1

p ( x)

e

2

( x x0 ) 2

2 2

с математическим ожиданием, равным истинному значению x0, и дисперсией D( x) .

Это значит, что результат отдельного измерения является элементом бесконечного

множества измерений (его называют генеральной совокупностью), которые выполняются

в одинаковых условиях со средней ошибкой (равноточные измерения). Среднее

2

4

арифметическое этой совокупности равно математическому ожиданию x0, то есть

истинному значению измеряемой величины. На практике количество наблюдений

(1)

( 2)

( n)

ограничено. Поэтому ряд {x , x ,..., x } экспериментальных значений измеряемой

величины x рассматривается как случайная выборка из генеральной совокупности. Здесь

верхний индекс (n) означает номер опыта, в котором измерена неизвестная величина x.

Закономерен вопрос: как распорядиться такой выборкой, чтобы наиболее точно оценить

истинное значение x0 измеряемой величины, когда оно неизвестно, и достоверность

полученного результата? Ответ является итогом следующих рассуждений.

Так как результаты измерений можно рассматривать как взаимно независимые, то

(1)

( 2)

( n)

плотность вероятности реализации в n экспериментах всей выборки {x , x ,..., x }

равна произведению плотностей вероятностей реализации каждого отдельного измерения:

p( x (1) , x ( 2) ,..., x ( n ) ) p( x (1) ) p( x ( 2) )... p( x ( n ) )

1

1 n (i )

exp( 2 ( x x0 ) 2 )

n

2 i 1

2

(1.7)

Напомним, что наша цель – оценить неизвестное истинное значение x0 и при этом

2

обеспечить минимальную среднюю ошибку , где D( x) - дисперсия. Это значит,

что нас интересуют экстремумы плотности вероятности (1.7), которую теперь будем

рассматривать как функцию двух переменных x0 и . Понятно, что наибольшую точность

(1)

( 2)

( n)

оценки неизвестной величины по результатам измерений (выборки) {x , x ,..., x }

при минимальной погрешности может обеспечить выбор x0, при котором будут

выполнены необходимые условия экстремума функции

p( x0 , )

1

2

n

exp(

n

1

( x (i ) x0 ) 2 )

2 i 1

(1.8)

2

Такими условиями, как это следует из курса математического анализа, в нашем

случае будут условия:

1 p

1 n

2 ( x ( i ) x0 ) 0,

p x0 i 1

(1.9)

1 p

n

1 n (i )

2

3 ( x x 0 ) 0.

p

i 1

(1)

( 2)

( n)

Из (1.9) следует, в свою очередь, что выборке {x , x ,..., x } , которая

реализовалась в n экспериментах, будет поставлено в соответствие наибольшее значение

(1)

( 2)

(n)

плотности вероятности p( x , x ,..., x ) p( x0 , ) при

x 0 x ср

и любом значении

, а также при

1 n (i )

x

n i 1

1 n (i )

( x x0 ) 2

n i 1

2

2

n

(1.10)

(1.11)

и любом значении x0.

Иными словами, при нормальном законе распределения ошибок измерения,

наиболее вероятной оценкой измеряемой величины x0 является среднее арифметическое

(1)

( 2)

( n)

выборки {x , x ,..., x } , а наилучшей оценкой средней ошибки определения

величины x0 является среднеквадратическое отклонение.

5

Метод, которым получены формулы (1.10)-(1.11) называют методом

максимального правдоподобия.

Метод наименьших квадратов (метод максимального правдоподобия) в случае

косвенного измерения нескольких величин.

Рассмотрим поставленную ранее задачу экспериментального определения

коэффициентов в уравнении (модели) (1.4). Сформулируем задачу следующим образом.

Пусть целью экспериментов является определение m неизвестных параметров

{ 1 , 2 ,..., m } , которые непосредственным измерениям не

(1)

( 2)

(n)

поддаются, по результатам измерений величины y { y , y ,..., y } в n

(коэффициентов)

экспериментах. Компоненты векторной функции f ( x ) { f 1 ( x ), f 2 ( x ),..., f m ( x )} как

функции управляемых (контролируемых) переменных x {x1 , x 2 ,..., x k } при каждом

(i )

заданном в i-м эксперименте наборе значений компонент вектора x {x1 ,..., x k }

образуют матрицу f (x ) размера nm с элементами следующего вида:

f1 ( x (1) ) f 2 ( x (1) ) ... f m ( x (1) )

( 2)

(i )

f1 ( x ) f 2 ( x ( 2) ) ... f m ( x ( 2) )

(1.12)

{ f ij } { f j ( x )}

...

...

...

...

f ( x ( n ) ) f ( x ( n ) ) ... f ( x ( n ) )

2

m

1

Напомним, что здесь индекс i означает номер эксперимента, а индекс j

соответствует номеру компоненты вектора параметров {1 , 2 ,..., m } . Под

результатами измерений далее можно понимать как результаты измерений в каких-то

физических экспериментах, так и результаты имитационного моделирования, в которых

(1)

( 2)

(n)

роль измеряемой величины y { y , y ,..., y } будет играть величина выходного

сигнала.

Теперь уравнение (модель) (1.4) запишем в виде:

m

f ij j

у (i ) , (i 1,2,..., n)

(i )

(i )

(1.13)

j 1

Эту систему нельзя непосредственно разрешить относительно неизвестных

j , ( j 1,2,..., m) , так как правые части вместо точных значений y 0(i ) содержат

y 0(i ) (i ) со случайными ошибками (i ) .

Можно сформулировать проблему оценки коэффициентов j , ( j 1,2,..., m) и

результаты измерений этих величин y

(i )

следующим образом: какие преобразования нужно выполнить с уравнениями (1.13), чтобы

(i )

(i )

(i )

по результатам измерений y y 0 , содержащим случайные ошибки, получить

максимально достоверную оценку истинных значений коэффициентов этих уравнений?

Оказывается, если количество опытов n больше количества неизвестных m (n>m), то по

(i )

результатам y измерений на основании принципа наибольшего правдоподобия можно

найти такую совокупность значений { 1 , 2 ,..., m } , которая с наибольшей

вероятностью удовлетворяет уравнениям вида (1.13). С этой целью вновь примем

предположение о нормальном распределении плотности вероятности случайных величин

y (i ) :

6

1

1

(1.14)

exp( 2 ( y (i ) y 0(i ) ) 2 ), (i 1,2,..., n).

2

2

(i )

(i )

Понятно, что предполагаемые истинные значения y 0 измеряемых величин y

в

p( y ( i ) )

m

точности удовлетворяют уравнениям (1.13)

f ij j

j 1

точные значения коэффициентов

у 0(i ) , в которых «зашифрованы» и

j , ( j 1,2,..., m) . С учетом этого обстоятельства для

плотности вероятности случайной выборки y { y

выражение:

(1)

, y ( 2) ,..., y ( n ) } из (1.14) следует

p( y (1) , y ( 2) ,..., y ( n ) ) p( y (1) ) p( y ( 2) )... p( y ( n ) )

1

1 n (i ) m

exp(

( y f ij j ) 2 ), (i 1,2,..., n).

n

2

2 i 1

j 1

2

(1.15)

Теперь эту функцию будем рассматривать как функцию многих переменных

j , ( j 1,2,..., m) : p( 1 , 2 ,... m )

1

2

n

exp(

1

2 2

n

m

i 1

j 1

( y (i ) f ij j ) 2 ) . Эта

величина достигает максимума при выполнении необходимых условий экстремума

функции многих переменных, то есть при условии одновременного обращения в нуль всех

ей частных производных по k , (k 1,2,..., m) .

На этом основании приходим к следующей системе уравнений:

1 p

1

2

p k

n

m

i 1

j 1

( y (i ) f ij j ) f ik

0, (k 1,2,..., m)

(1.16)

Отсюда следует система уравнений относительно j , ( j 1,2,..., m) вида:

m

n

f

j 1

i 1

m

c

j 1

kj

j

ij

n

f ik j f ik y (i ) , (k 1,2,..., m), или

i 1

bk

n

n

i 1

i 1

где ckj c jk f ik f ij f ij f ik ,

(1.17)

n

bk f ik y (i ) , (k 1,2,..., m; j 1,2,..., m).

i 1

Напомним, что здесь f ik , (i 1,..., n; j 1,..., m) - элементы матрицы f (x ) .

Заметим, что в системе (1.13) число уравнений n не равно числу неизвестных m.

Более того, интуитивно мы ожидаем, что чем больше уравнений (а каждому соответствует

одно измерение величины y), тем точнее должна получаться оценка для коэффициентов,

но тогда неясно, какое из возможных решений этой системы принимать за «хорошую»

оценку коэффициентов. В уравнениях (1.17) эти проблемы сняты: число уравнений равно

числу неизвестных, матрица коэффициентов симметрична относительно главной

диагонали, что также является существенным достоинством.

Итак, в качестве наиболее вероятной оценки коэффициентов j по результатам

измерений, содержащих случайные погрешности, следует брать не прямое решение

системы уравнений (1.13), а решение «сконструированных» из неё уравнений (1.17).

Условие максимального правдоподобия в этом случае совпадает с условием минимума

суммы квадратов ошибок:

7

i2 y (i )

n

n

i 1

2

i 1

m

n

j f ij y (i )

j 1

(1.18)

i 1

Поэтому метод и называется методом наименьших квадратов.

Пример. Рассмотрим следующий пример [5]. Пусть по результатам пяти измерений

получена система уравнений типа (1.13) следующего вида:

4,91 1 59,0 2 339,8

2,72 2,7 47,5

1

2

0,05 1 32,4 2 262,5

2,91 27,7 152,9

1

2

4,77 1 1,4 2 27,9

где правые части – результат измерений. Чтобы получить уравнения вида (1.17) вычислим

четыре коэффициента cij. Итак,

5

c11 f i1 f i1 4,91 2,72 0,05 2,91 4,77 62,73;

2

2

2

2

2

i 1

c12 c 21

5

f i1 f i 2

4,91(59,0) 2,72(2,7) 0,05 32,4 (2,91)27,7 (4,77)1,4 382,7;

i 1

5

c 22 f i 2 f i 2 59,0 2,7 32,4 27,7 1,4 5307 ,3;

2

2

2

2

2

i 1

Найдем правые части новых уравнений:

5

b1 f i1 y (i )

i 1

4,91 339,8 2,72 47,5 0,05262,5 2,91152,9 4,77 27,9 2096 ,3;

5

b2 f i 2 y (i )

i 1

59,0 339,8 2,7 47,5 32,4262,5 27,7 152,9 1,4 27,9 32877 ,7;

В итоге имеем следующую систему уравнений относительно 1 , 2 :

62,73 1 382,7 2 2096 ,3;

382,7 1 5307 ,3 2 32877 ,7;

Решение дает следующие значения: 1 7,81 и 2 6,76 .

Посмотрим, какие значения коэффициентов были бы получены, если бы была

предпринята попытка (ошибочная!) оценить их по данным двух первых измерений. Решим

по правилу Крамера систему:

4,91 1 59,0 2 339,8

2,72 1 2,7 2 47,5

8

4,91 59,0

4,91 2,7 2,72 59,0 147 ,223;

2,72 2,7

1

2

339,8 59,0

47,5

2,7

4,91 339,8

2,72

47,5

339,8 2,7 47,5 59,0 1885,04;

4,91 47,5 2,72 339,8 691,31;

1 12,8; 2 4,69.

Это решение довольно сильно отличается от наиболее вероятной оценки.

9

Задание.

Решить следующую задачу. Пусть скалярная выходная переменная y

моделируемой системы является функцией вектора входных (контролируемых)

переменных x {x1 , x2 ,..., xk } и вектора неизвестных параметров системы { 0 ,1 ,..., m }

, то есть y f ( x , ) . В результате проведения n (n>m+1) имитационных экспериментов

измерены n значений выходной переменной y (i ) , (i 1,2,..., n) , которые соответствуют

значениям контролируемых переменных x (i ) {x1(i ) , x2(i ) ,..., xk(i ) }, (i 1,2,...n) , заданным в

соответствии с планом эксперимента. (Во всех формулах верхний индекс обозначает

номер

эксперимента,

нижний

индекс

соответствует

номеру

компоненты

соответствующего вектора). Случайные погрешности измерений подчиняются закону

нормального распределения.

Экспериментатор принял предположения, что исследуемая система описывается

линейной относительно неизвестных параметров зависимостью вида

y f ( x ) , f ( x ) { f 0 ( x ), f1 ( x ),..., f m ( x )} ,

а также о конкретном виде векторной функции f ( x ) { f 0 ( x ), f1 ( x ),..., f m ( x )} . Вид этой

функций указан далее в каждом варианте задания.

Цель работы: найти наилучшую линейную несмещенную оценку вектора

параметров { 0 ,1 ,..., m } системы по результатам косвенных измерений.

Требуется:

1) Описать метод наибольшего правдоподобия для случая многих переменных

(теоретическая часть).

2) Записать исходную систему уравнений вашей задачи.

3) Записать систему нормальных уравнений.

4) Найти наиболее вероятные оценки (наилучшую линейную несмещенную оценку)

коэффициентов { 0 ,1 ,..., m } модели и записать уравнения модели.

5) Выбрать из n исходных уравнений (m+1) разных уравнений, найти из этой

системы «случайную» оценку коэффициентов { 0 ,1 ,..., m } , сравнить,

насколько этот результат отличается от наиболее вероятной оценки.

6) Оформить отчет.

Номер задания совпадает с номером студента в списке группы.

2. Определение модели, значения контролируемых переменных и результаты

экспериментов:

2.1. x {x1 , x2 , x3}, (k 3); f {x} { f 0 ( x) 0, f1 ( x ) x1 , f 2 ( x ) x2 , f 3 ( x ) x3 }, ( m 3);

i

y (i )

x1(i )

x2(i )

x3(i )

1 775,9 9,8 117,1 10,1

2 82,6

5,5

5,4

1,1

3 375,1

0,1

64,8 15,2

4 465,1 5,8 55,4

15,2

5 245,8 9,5

2,9

30,1

6 450,2 10,1 100,2 30,1

n 6.

2.2. x {x1 , x2 }, (k 2); f {x} { f 0 ( x ) 0, f1 ( x ) x1 , f 2 ( x ) x2 , f 3 ( x ) x1 x2 }, ( m 3);

i

y (i )

x1( i )

x2( i )

1 675,9 9,8 117,1

2 92,5

5,5

5,4

3 525,1

0,1

64,8

4 305,1 5,8 55,4

5 55,8 9,5

2,9

6 747,2 10,1 100,2

n 6.

x {x1 , x2 , x3 , x4 }, (k 4);

2.3.

f {x} { f 0 ( x ) 0, f1 ( x ) x1 , f 2 ( x ) x2 , f 3 ( x ) x3 , f 4 ( x ) x4 }, ( m 4);

y (i )

31,8

i

1

x1(i )

2,5

x2( i )

3.0

x3( i )

3,5

x4( i )

4,5

2 42,9 4,1

3 0,8 17,4

4 8,5 11,2

3,2

7,0

6,8

7,1

6,1

10,1 2,0

9,1

4,1

5

6

67,5

39,4

12,1

5,0

4,2

20,1

5,1

15,4

8,1

12,3

7

26,5

8,0

12,1

5,1

7,2

n 7.

x {x1 , x2 , x3 }, (k 3);

2.4.

f {x} { f 0 ( x ) 0, f1 ( x ) x1 , f 2 ( x ) x2 , f 3 ( x ) x3 }, ( m 3);

i

1

y (i )

31,8

x1(i )

2,5

x2(i )

3.0

x3(i )

7,5

2 42,9 4,1

3 0,8 17,4

4 8,5 11,2

3,2 12,1

7,0 12,1

6,8 5,1

5 67,5

6 39,4

12,1

5,0

4,2

20,1

12,1

3,4

8,0

12,1

12,1

7

26,5

n 7.

2.5. x {x1}, (k 1); f {x} { f 0 ( x ) 1, f1 ( x ) x1 , f 2 ( x ) x12 }, ( m 2);

i

1

2

3

4

5

6

7

8

x1(i )

y (i )

200 300 400 500 600 700 800 900 n 8.

5,1 5,5 5,9 6,8 7,4 7,5 8,6 9,4

10

11

2.6. x {x1}, (k 1); f {x} { f 0 ( x ) 1, f1 ( x ) x1 , f 2 ( x ) x12 , f 3 ( x ) x13}, ( m 3);

i

1 2 3 4 5 6 7 8

x1(i ) 1 2 3 4 5 6 7 8 n 8.

y (i ) 12 13 18 19 23 26 30 34

2.7. x {x1}, (k 1); f {x} { f 0 ( x ) 1, f1 ( x ) x1 , f 2 ( x ) x12 , f 3 ( x ) x13}, ( m 3);

i

1

2

3

4

5

6

7

8

x1(i ) 17,6 40,4 67,7 90,1 113,8 140,3 165,3 190,2 n 8.

y (i )

0 1000 2000 3000 4000 5000 6000 7000

2.8. x {x1}, (k 1); f {x} { f 0 ( x ) 1, f1 ( x ) x1 , f 2 ( x ) x12 }, ( m 2);

i

1

2

3

4

5

6

7

8

79 82

85

88 90 93

97 100 n 8.

8,1 17,5 29,9 36,9 51,1 60,5 72,6 86,4

x1(i )

y (i )

2.9. x {x1}, (k 1); f {x} { f 0 ( x) 1, f1 ( x ) x1 , f 2 ( x ) x12 }, ( m 2);

i

1

2

3

4

5

6

7

x1(i )

y (i )

3

2

1

0

1

2

3

242,3 231,1 213,2 189,1 151,2 107,0 52,6

n 7.

2.10. x {x1}, (k 1); f {x} { f 0 ( x ) 0, f1 ( x ) cos( x1 ), f 2 ( x ) sin( x1 )}, ( m 2);

i

1

2

3

4

5

x1(i )

y (i )

0.4 0.2 0 0.2 0.4

3,1 16,1 6,1 9,1 8,1

n 5.

2.11. x {x1}, (k 1); f {x} { f 0 ( x) 1, f1 ( x ) x1 , f 2 ( x ) x12 }, ( m 2);

i

1

2

3

4

5

x1(i )

y (i )

65,0 75,0 85,1 94,8 104.9

20,1 17,2 41,9 94,2 126,9

n 5.

2.12. x {x1}, (k 1); f {x} { f 0 ( x) 1, f1 ( x ) x1 , f 2 ( x ) x12 }, ( m 2);

i

x1(i )

y (i )

1

2

3

4

5

6

2

0

3

4

6

9

35,1 50,2 67,8 70,3 75,9 84,1

n 6.

2.13. x {x1 , x2 }, (k 2); f {x} { f 0 ( x ) 0, f1 ( x ) x1 , f 2 ( x ) x2 , f 3 ( x ) x1 x2 }, ( m 3);

i

y (i )

x1(i )

x2(i )

1 100,9 10.3 100,1

2 300,5 5.1 50,4

3 59,1 2,1 4,8

4 148,1

2.2

10,4

5 775,8

5,5

46,9

6 1747,2

9,9

92,2

n 6.

2.14. x {x1}, (k 1); f {x} { f 0 ( x ) 0, f1 ( x ) x1 , f 2 ( x ) x12 , f 3 ( x ) x13 }, ( m 3);

i

1

2

3

4

5

6

7

x1(i ) 10,6

20,4

27,7

40,1

53,8

60,3

71,3

(i )

y

1250,1 8700,0 29000,0 64000,0 130000,0 220000,0 357500,0

n 7.

2.15. x {x1 , x2 , x3}, (k 3); f {x} { f 0 ( x) 0, f1 ( x ) x1 , f 2 ( x ) x2 , f 3 ( x ) x3 }, ( m 3);

i

y (i )

x1( i )

x2( i )

1 13,9

19,8 11,1

2 140,6 15,5 5,1

3 50,1

10,1

6,8

4

5,1 15,8 5,1

5 18,8 19,5 12,9

6 540,2 100,1 10,2

x3(i )

1,1

10,1

5,5

5,5

3,1

3,1

n 6.

2.16. x {x1 , x2 , x3 }, (k 3); f {x} { f 0 ( x ) 1, f1 ( x ) x1 , f 2 ( x ) x2 , f 3 ( x ) x3 }, ( m 3);

i

y (i )

x1( i )

x2( i )

1 50,9 19,8 11,1

2 80,6

15,5 5,1

3 10,1 10,1

6,8

4 55,1 15,8 5,1

5 42,8 19,5 12,9

6 490,2 100,1 10,2

x3( i )

1,1

10,1

5,5

5,5

3,1

3,1

n 6.

2.17. x {x1}, (k 1); f {x} { f 0 ( x ) 0, f1 ( x ) x1 , f 2 ( x ) x12 }, ( m 2);

i

1

2

3

4

5

6

7

x1(i )

y (i )

5,2 0 3,2 8,1 16,4 21,0 30,5

22,1 1,2 46,8 50,3 112,9 134,1 234,1

n 7.

12

2.18. x {x1 , x2 , x3}, (k 3); f {x} { f 0 ( x) 0, f1 ( x ) x1 , f 2 ( x ) x2 , f 3 ( x ) x3 }, ( m 3);

i

y (i )

x1(i )

x2(i )

x3(i )

1 73,9

3,2 10,1 21,1

2 24,6

1,6

5,1 10,1

3 49,1

0,8

2,8

5,5

4 2,5 1,8

5,1

5,5

5 3,8 3,2 9,9

10,1

6 214,2 6,1 12,2 33,1

n 6.

x {x1 , x2 , x3 }, (k 3);

2.19.

f {x} { f 0 ( x ) 0, f1 ( x ) x1 , f 2 ( x ) x2 , f 3 ( x ) x3 }, ( m 3);

y (i )

161,8

x1(i )

9,5

x2( i )

16.0

x3( i )

3,5

2 112,9 7,1

3 30,8 2,4

4 88,5

0,2

12,2

7,0

6,8

4,1

6,1

8,1

5

6

167,5

239,4

2,1

5,0

10,2 12,1

15,1 18,4

7

346,5

8,0

20,1 22,1

i

1

n 7.

2.20. x {x1 , x2 }, (k 2); f {x} { f 0 ( x ) 1, f1 ( x ) x1 , f 2 ( x) x2 }, ( m 2);

i

y (i )

x1( i )

1 51,8 9,5

x2( i )

16.0

2 5,9

3 65,8

4 173,5

7,1

2,4

0,2

12,2

7,0

6,8

5 247,5

6 253,4

2,1

5,0

10,2

15,1

7 339,5

8,0

20,1

n 7.

2.21. x {x1 , x2 }, (k 2); f {x} { f 0 ( x ) 0, f1 ( x ) x1 , f 2 ( x ) x2 ,}, ( m 2);

i

y (i )

x1(i )

1 180,8 9,5

x2(i )

16.0

2 136,9 7,1

3 64,8 2,4

4 50,5

0,2

12,2

7,0

6,8

5

6

10,2

15,1

16,5

129,4

2,1

5,0

n 6.

13

2.22. x {x1 , x2 }, (k 2); f {x} { f 0 ( x ) 0, f1 ( x ) x1 , f 2 ( x) x2 , f 3 ( x ) x12 }, ( m 3);

i

1

y (i )

69,5

x1(i )

5,0

x2( i )

4.0

2

3

4

60,8

63,2

79,2

4,0 6,0

3,0 8,0

2,0 10,0

5 95,4

6 135,5

1,0 12,0

1,0 14,0

n 6.

2.23. x {x1}, (k 1); f {x} { f 0 ( x ) 1, f1 ( x ) x1 , f 2 ( x ) x12 }, ( m 2);

i

1

y (i )

21,2

x1(i )

4,0

2

3

4

8,9

7,7

13,5

3,0

1,0

0,0

5 45,8

6 174,2

2,0

6,0

7 290,0

8,0

n 7.

2.24. x {x1 , x2 }, (k 2); f {x} { f 0 ( x ) 0, f1 ( x ) x1 , f 2 ( x) x2 , f 3 ( x ) x22 }, ( m 3);

y (i )

51,2

x1( i )

2,0

x2( i )

4

2 45,3

3 109,2

4 182,5

4,0

6,0

8,0

2

2

4

i

1

5 265,4 12,0

6 540,0 20,0

n 6.

6

8

2.25. x {x1}, (k 1); f {x} { f 0 ( x ) 0, f1 ( x ) x1 , f 2 ( x ) x12 , f 3 ( x ) x13 }, ( m 3);

i

1

y (i )

1,0

x1(i )

5,0

2

3

4

13,2

46,0

91,0

4,0

3,0

3,0

5 285,0

6 657,0

5,0

7,0

n 6.

14

2.26. x {x1 , x2 , x3}, (k 3); f {x} { f1 ( x ) x1 , f 2 ( x ) x2 , f 3 ( x ) x3}, ( m 3);

i

y (i )

x1(i )

x2(i )

x3( i )

1 775,9 9,8 117,1 12,3

2 82,6

5,5

5,4

2,1

n 6.

3 375,1

0,1

64,8 17,6

4 465,1 5,8 55,4

14,2

5 245,8 9,5

2,9

27,1

6 450,2 10,1 100,2 32,1

2.27. x {x1 , x2 }, (k 2); f {x} { f1 ( x ) x1 , f 2 ( x ) x2 , f 3 ( x ) x1 x2 }, ( m 3);

i

y (i )

x1(i )

x2( i )

1 675,9 9,8 127,1

2 92,5

5,5 15,4

3 525,1

0,1

59,8

4 305,1 5,8 67,4

5 55,8 9,5 12,9

6 747,2 10,1

90,2

n 6.

x {x1 , x2 , x3 , x4 }, (k 4);

2.28.

f {x} { f1 ( x ) x1 , f 2 ( x ) x2 , f 3 ( x ) x3 , f 4 ( x ) x4 }, ( m 4);

i

1

y (i )

29,8

x1( i )

2,5

x2( i )

3.0

x3(i )

3,5

x4( i )

4,5

2 48,9 4,1

3 2,8 17,4

4 13,5 11,2

3,2

7,0

6,8

7,1

6,1

10,1 2,0

9,1

4,1

5

6

75,5

49,7

12,1

5,0

4,2

20,1

5,1

15,4

8,1

12,3

7

36,5

8,0

12,1

5,1

7,2

n 7.

x {x1 , x2 , x3}, (k 3);

2.29.

f {x} { f1 ( x ) x1 , f 2 ( x ) x2 , f 3 ( x ) x3}, ( m 3);

i y (i )

1 15,8

x1( i )

2,5

x2(i )

3.0

x3(i )

7,5

2 21,9 4,1

3 1,8 17,4

4 4,5 11,2

3,2 12,1

7,0 12,1

6,8 5,1

5 35,5 12,1

6 19,4 5,0

4,2

20,1

12,1

3,4

7 15,5

12,1

12,1

8,0

n 7.

15

16

2.30. x {x1}, (k 1); f {x} { f 0 ( x ) 1, f1 ( x ) x1 , f 2 ( x ) x12 }, ( m 2);

i

1

2

3

4

5

6

7

8

x1(i ) 100 150 200 250 300 350 400 450

y (i ) 5,1 5,5 5,9 6,8 7,4 7,5 8,6 9,4

n 8.

2.31. x {x1}, (k 1); f {x} { f 0 ( x ) 1, f1 ( x ) cos( x1 ), f 2 ( x) sin( x1 )}, ( m 3);

i

1

2

3

4

5

x1(i )

y (i )

0.4 0.2 0 0.2 0.4

5,3 14,9 7,9 12,0 5,7

n 5.

17

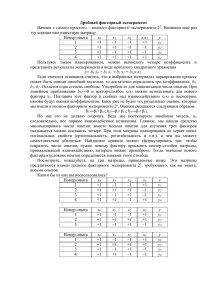

Лабораторная работа № 2 (3).

Полнофакторный эксперимент: обработка результатов и проверка адекватности.

По результатам полнофакторного эксперимента 23 (см. задания, номера

которых соответствуют номеру студента по списку группы) для функции отклика

y b0 b1 x1 b2 x2 b3 x3 b12 x1 x2 b23 x2 x3 b13 x1 x3 b123 x1 x2 x3 найти наилучшую линейную

несмещенную оценку вектора параметров b {b0 , b1 ,..., bm }. Для этого требуется:

r

1) Найти средний отклик yi

y

p 1

ip

.

r

2) Найти наиболее вероятные оценки (наилучшую линейную несмещенную оценку)

N

коэффициентов модели b j

x

i 1

ij

yi

. Показать, что эта расчетная формула коэффициентов

N

регрессии является следствием применения метода максимального правдоподобия в

случае, когда информационная матрица получается из матрицы плана полнофакторного

эксперимента, столбцы которой попарно ортогональны.

r

3)

Найти

построчные

( i ) 2

дисперсии

N

r

( y

N

ip

( y

p 1

ip

yi ) 2

r 1

и

дисперсию

yi ) 2

1

i 1 p 1

( i ) 2

N i 1

N (r 1)

4) По T-критерию Стьюдента проверить значимость коэффициентов регрессии. Для

S 2 ( y)

этого найти дисперсию коэффициентов регрессии: S 2 (b j )

, по таблицам

Nr

определить критическое значение Tкр критерия Стьюдента для степеней свободы f=N(r-1)

и уровня значимости =5%. Построить интервал длиной rb j , b j Tкр S (b j ) , где

воспроизводимости S 2 ( y )

b j Tкр S (b j ) - половина длины доверительного интервала. Если абсолютная величина

коэффициента b j b j , то коэффициент считается значащим.

5) Проверить адекватность модели на основе критерия Фишера. С этой целью

N

r

( yi yi ) 2 , где m – количество членов

вычислить дисперсию адекватности S 2 ad

N m i 1

аппроксимирующего полинома, учитывая и свободный член, а yi - значение функции

отклика, вычисленное по принятой функции регрессии. Вычислить значение критерия

S 2 ad

Фишера F 2

. Из таблиц найти критическое значение критерия Фишера Fкр для

S ( y)

степеней свободы Fад=N-m, fk=N(r-1) и заданного уровня значимости =5%. При

выполнении условия F<Fкр модель признается адекватной. 6) Вычислить коэффициент

N

( yi yi ) 2

множественной корреляции: R 1 i N1

. Если R близко к единице, то уравнение

2

( yi y )

i 1

регрессии хорошо описывает экспериментальные данные.

18

2. Таблица плана и результатов эксперимента:

3.1.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

№

точек

плана

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

58

6

8

0

14

0

2

-3

p=2

50

12

9

2

15

-2

3

-4

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

95

7

9

-1

15

-3

0

0

p=2

89

8

6

2

11

-4

3

-4

yi

3.2.

Факторы

X1X2, X2X3,

Параметры оптимизации

yi

3.3.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

№

точек

плана

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

95

18

17

-1

30

-3

4

-8

p=2

98

21

21

-2

36

-5

6

-10

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

148

-100

-116

104

-110

89

88

-100

p=2

150

-110

-104

103

-114

99

98

-90

yi

3.4.

Факторы

X1X2, X2X3,

Параметры оптимизации

yi

19

3.5.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

19

2

-2

1

1

-8

-7

1

p=2

22

3

-3

0

2

-5

-6

1

yi

3.6.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

№

точек

плана

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

42

4

-1

22

1

-3

-4

1

p=2

39

2

-3

21

-2

-4

-5

1

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

35

2

-2

15

1

9

7

-1

p=2

39

4

-3

18

0

6

5

-1

yi

3.7.

Факторы

X1X2, X2X3,

Параметры оптимизации

yi

3.8.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

2

-10

-10

2

10

12

-10

6

p=2

-1

-9

-11

0

9

14

-9

4

yi

20

3.9.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

24

8

10

10

11

4

0

8

p=2

26

10

13

15

16

7

-3

7

yi

3.10.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

№

точек

плана

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

100

76

25

34

-2

21

-43

-65

p=2

110

80

29

40

-4

26

-50

-70

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

34

-2

-18

32

-12

-2

-26

-8

p=2

38

-4

-24

40

-16

-6

-32

-10

yi

3.11.

Факторы

X1X2, X2X3,

Параметры оптимизации

yi

3.12.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

290

255

295

264

289

254

296

255

p=2

300

260

298

275

296

270

304

248

yi

21

3.13.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

120

40

18

-20

70

-4

-18

-50

p=2

134

42

20

-26

80

0

-16

-60

yi

3.14.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

№

точек

плана

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

46

-2

-4

-2

8

-4

3

10

p=2

42

-1

-2

-1

7

-2

6

8

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

40

22

18

6

20

3

6

-12

p=2

44

20

16

4

22

6

8

-10

yi

3.15.

Факторы

X1X2, X2X3,

Параметры оптимизации

yi

3.16.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

440

114

112

-50

210

-6

36

-26

p=2

400

96

106

-46

220

-4

50

-18

yi

22

3.17.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

2

-18

-16

8

2

-6

0

28

p=2

4

-20

-20

12

3

-5

-1

26

yi

3.18.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

№

точек

плана

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

80

40

-45

-66

8

-18

4

-10

p=2

90

50

-48

-65

9

-17

2

-12

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

84

-48

-30

14

-66

45

21

-15

p=2

91

-52

-34

16

-60

46

23

-12

yi

3.19.

Факторы

X1X2, X2X3,

Параметры оптимизации

yi

3.20.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

110

108

101

97

101

98

95

92

p=2

106

102

110

90

110

100

98

93

yi

23

3.21.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

-290

-450

-290

-450

-290

-450

-290

-450

p=2

-300

-440

-300

-460

-300

-440

-300

-460

yi

3.22.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

№

точек

плана

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

13

3

-1

7

7

-5

-10

-5

p=2

15

1

1

3

5

-7

-6

-3

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

30

18

16

20

22

10

8

12

p=2

32

20

18

22

24

12

10

14

yi

3.23.

Факторы

X1X2, X2X3,

Параметры оптимизации

yi

3.24.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

-2

-2

-10

-10

-14

-15

-15

-15

p=2

-1

-1

-13

-13

-12

-14

-15

-14

yi

24

3.25.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

-290

-450

-290

-450

-290

-400

-290

-450

p=2

-250

-400

-320

-360

-300

-440

-250

-400

yi

3.26.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

№

точек

плана

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

103

31

-11

70

70

-50

-90

-50

p=2

95

10

8

30

45

-67

-76

-30

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

60

35

33

39

50

21

17

23

p=2

58

41

37

48

45

29

20

29

yi

3.27.

Факторы

X1X2, X2X3,

Параметры оптимизации

yi

3.28.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

-12

-12

-20

-21

-25

-25

-25

-33

p=2

-11

-11

-23

-23

-22

-24

-27

-30

yi

25

3.29.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

-190

-350

-190

-345

-189

-330

-190

-350

p=2

-100

-240

-200

-360

-200

-344

-200

-360

yi

3.30.

№

точек

плана

Факторы

X1X2, X2X3,

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

№

точек

плана

b0,

X1,

X2,

X3,

j=0

j=1

j=2

j=3

j=4

1

2

3

4

5

6

7

8

+

+

+

+

+

+

+

+

+

+

+

+

-

+

+

+

+

-

+

+

+

+

-

+

+

+

+

Параметры оптимизации

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

53

39

35

47

47

38

30

35

p=2

15

1

44

43

45

33

35

37

X3X1,

X1X2X3,

y i/ ,

yi// ,

j=5

j=6

j=7

+

+

+

+

+

+

+

+

+

+

+

+

-

p=1

150

90

81

100

110

101

108

120

p=2

162

120

90

110

124

122

98

154

yi

3.31.

Факторы

X1X2, X2X3,

Параметры оптимизации

yi