Информационный критерий и его использование для решения

реклама

УДК 623.4.024

Н.И. Куренков, д-р техн. наук, проф.

С.Н. Ананьев, канд. техн. наук, доц.

Информационный критерий

и его использование для решения задач обработки многомерных данных

Аннотация. Предлагается подход к решению проблемы построения

информационного критерия для процедур оценки структурных отличий

многомерных данных в задачах их анализа и распознавания образов. Потребность

в использовании такого критерия, легко вычисляемого и обладающего хорошими

дискриминантными свойствами, обусловлена необходимостью выявления тонких

различий в структуре массивов многомерных данных и последующего

использования полученной информации в интересах решения задач их обработки.

Приведены явный вид информационного критерия и примеры его использования для

оценки информативности признаков, в задачах распознавания образов и

обработки изображений.

Обработка

многомерных

данных,

описывающих

исследуемые

процессы и объекты, предполагает выполнение над ними некоторого

преобразования с целью получения информации об объектах исследования.

Такая информация обычно содержится в структурных особенностях

обрабатываемых данных. В статье предлагается один из подходов к

построению

информационного

критерия,

позволяющего

получать

информацию об этих особенностях, которая необходима для решения задач

классификации и снижения размерности многомерных данных. Возможности

метода

показаны

на

решении

двух

актуальных

задач

-

оценки

информативности признаков распознавания и градации числовых массивов.

Не претендуя на полноту исследования, продемонстрируем саму идею

получения

информации

использования.

По

о

структуре

нашему

мнению

данных

и

ее

предлагаемый

практического

метод

будет

способствовать развитию информационного подхода к обработке данных.

В настоящее время имеются замечательные руководства (см. список

литературы в [1]), в которых отражен современный уровень использования

информационных мер в анализе и обработке данных. Успех этих подходов

базируется на использовании вероятностной меры, позволяющей априорную

информацию представлять в виде законов распределения соответствующих

случайных величин, формировать критерии качества обработки данных.

Однако далеко не всегда выполняются условия реализации теоретиковероятностных методов. Ограничения хорошо известны и это, прежде всего,

недостаточность объема исходных данных в анализируемых выборках,

неопределенность условий их получения, воздействие различного рода помех

и т.п. Альтернативой традиционным подходам может служить подход, в

котором задача получения информационного критерия качества решается в

экстремальной постановке. При таком подходе возможна разработка

адаптивных

алгоритмов,

обладающих

большей

устойчивостью

к

воздействию помех и не требующих для получения статистически

устойчивого результата больших объемов входных данных. Однако решение

оптимизационных задач при обработке многомерных данных, как правило,

требует больших вычислительных ресурсов. Поэтому необходим поиск

класса целевых функций, допускающего простые алгоритмы вычисления

экстремумов. К таким функциям можно отнести не только линейные и

квадратичные функции, но и позиномы. Для них разработаны эффективные

методы

решения

оптимизационных

задач,

известные

как

задачи

геометрического программирования [2]. Более того, появившиеся

в

последнее время аналитические методы их решения [3] позволяют надеяться

на успех применения позиномов в анализе данных.

Одновременно при обработке многомерных данных в подавляющем

числе случаев решается задача их агрегирования. В качестве таких агрегатов

обычно используются средние величины и, в частности, средние степенные

[4].

Среди

последних

арифметическое

и

особыми

среднее

свойствами

гармоническое.

Их

обладают

среднее

отношение

обладает

свойствами энтропии, значения которой можно интерпретировать как меру

неопределенности в выборе элементов массива. Однако здесь нас будет

интересовать другой аспект указанного отношения, а именно – отношение

как мера структурных различий значений компонент одномерного массива.

Поскольку различия лежат в основе понятия информации, то естественной

является

попытка

информационного

использования

критерия.

Для

этой

меры

формального

для

построения

изложения

сделаем

необходимые обозначения.

Пусть

X

матрица

с

положительными

элементами

X Rnm { X ( xij ) | xij 0 i 1, n; j 1, m} , имеющая n строк и m столбцов и

n

пусть p n {p ( p1 , p2 ,... pn )T | pi 1, pi 0, i 1, n} . Для каждой матрицы

i 1

X R nm можно определить функцию

H (p, X ) ln pT X X T p ln m ,

где

X T

(1)

- транспонированная матрица, элементы которой являются

обратными значениями элементов матрицы X .

При фиксированных значениях элементов матрицы X функция (1)

будет зависеть от компонент вектора p . Желая подчеркнуть этот факт, будем

для H (p, X ) использовать также обозначение H (p ) . Можно показать, что H (p )

обладает основными свойствами энтропии. Если строки матрицы

X

различны по структуре значений своих элементов, то максимальное значение

T

n

1 1 1

1

*

o

(1) достигается на векторе p , отличном от равномерного p , ,... e .

n

n n n

Компоненты вектора p* обладают интересным свойством: две максимальные

по своим значениям компоненты соответствуют двум объектам (строкам

матрицы X ), которые в наибольшей степени отличаются друг от друга

структурой значений своих элементов (наиболее деструктивны). Это

свойство вектора

p*

можно использовать при разработке алгоритмов

классификации.

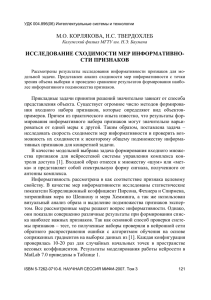

Возможность использования свойств вектора p* для решения задачи

кластеризации данных цветов ириса на три класса - virginic, versicol и setosa

[1] с покажем на примере. На рис.1 показан график значений компонент

вектора p* для всей выборки. Как видно наибольшие значения компонент

вектора p* соответствуют двум элементам: [7,2 3,6 6,1 2,5]; [4,3 3,0 1,1 0,1].

На первом шаге с использованием меры близости [1]

(x, y) ln(xT y) ln(y T x)

(3)

оказалось возможным разбить всю совокупность характеристик цветов ириса

на два кластера по степени их близости к выделенным элементам по

алгоритму, изложенному в [1]. Полученные в результате кластеры, первый цветы virginic и versicol, второй - цветы setosa. На втором шаге после

проведения

аналогичной

процедуры

для

данных

первого

кластера

наблюдались 9 ошибок, которые распределились между классами (цветами)

как 5 к 4.

Распределение р для всей выборки цветов ириса

0.5

0.45

0.4

Значкения р

0.35

0.3

0.25

0.2

0.15

0.1

0.05

0

0

50

100

150

Порядковый номер элементов ввыборки

Рис.1 График изменения компонент вектора p* для

всей выборки характеристик цветов ириса.

Общие

результаты

классификации,

представлены

в

виде

матрицы

перепутывания

45 5 0

P 4 46 0 .

0 0 50

Их можно отнести к одним из лучших результатов кластеризации цветов

ириса [10], что демонстрирует возможность использования информационных

свойств вектора p* для построения алгоритмов классификации многомерных

данных. Можно продолжить исследования в этом направлении для

различных решающих правил в процедурах классификации, однако, оставляя

в стороне детали, подчеркнем, что предложенный способ выявления

различий является основой для разработки эффективных алгоритмов

распознавания.

Вернемся к основной цели нашего исследования по формированию

информационного критерия. Рассмотрим частный случай, когда матрица

X

в (1) состоит из одного вектор-столбца x ( x1 , x2 ,...xn )T R n1 . Для этого случая

представим (1) в виде

n p n

h(x) ln xT p pT x ln i pi xi .

i1 xi i1

(4)

Легко проверить, что

1. h(x) h( x) 0 ;

n

2. h(x) 0 x e (1,1...1)T , 0;

(5)

3. h(x) h(x1 ) .

На основании этих свойств будем функцию (4) называть мерой различий

компонент вектора x или информационной мерой, поскольку, там, где есть

1

различия, там есть и информация. Далее, w R n

определим

h(x / ) min ln((p./ w)T x xT (p. w))

w

(6)

и искомый информационный критерий

I (x) h(x) h(x / ) ln pT x xT p min ln((p./ w) T x x T (p. w))) ,

w

(7)

где ( . / ) и ( . ) –поэлементные операции деления и умножения соответственно.

Область определяется условиями решаемой задачи. Приведем

примеры использования формулы (7). Начнем с простого случая. Пусть

преобразование заключается в замене исходного вектора x ( x1 , x2 ,...xn )T R n1

вектором y ( y1 , y2 ,... yn )T R n1 . Тогда область ограничений определится

соотношениями {w Rn1 | wi yi i 1, n} , а величина I (x) - равенством

I (x) ln pT x x T p ln((p./ y )T x x T (p. y )) ,

(8)

откуда следует, что максимально возможное количество информации

содержится в тождественном преобразовании и равно

I (x) ln pT x x T p ,

(9)

что и следовало ожидать.

Рассмотрим более сложные и практически важные примеры.

1. Оценка информативности признаков.

В теории распознавания образов оценку информативности признака

получают как отношение результатов распознавания объектов контрольной

выборки в полном пространстве признаков к результатам распознавания,

проводимого без учета оцениваемого признака [6]. Из этого определения

следует, что оценка информативности признака, очевидно, зависит от

решающего правила. Кроме того, эта оценка зависит от объема обучающей

выборки [5], где показано, что для получения ее достоверного значения,

объектов в каждом классе должно быть в десятки раз больше числа

исследуемых признаков.

С точки зрения содержания понятия «информативность», можно дать

следующее определение: информативный признак - это признак, имеющий

близкие значения на элементах (объектах) одного класса и существенно

различные значения на элементах разных классов.

Отсюда следует, что для эффективного решения задачи распознавания

в алгоритмах классификации необходимо перейти к использованию

признаков, обладающих отмеченным свойством. Область допустимых

значений определим следующим образом. Представим всю совокупность

элементов обучающей выборки, которую предполагаем известной, в виде

строк матрицы X R nm . Пусть k - число распознаваемых классов, ( xij ) номер класса, которому соответствует значение xij j -го признака на i -ом

элементе выборки. Тогда информативность j -го признака (столбца X j

матрицы X ) можно оценить на основе решения задачи (7) с областью

определения в виде

{w Rn1 | wu wv ( xuj ) ( xvj ) j 1, m} .

(10)

Отметим, что определяемая таким образом информативность признака I ( X j )

не зависит от единиц его измерения и учитывает только относительные

значения распределения признаков на элементах классов распознавания.

Работоспособность предлагаемого метода покажем при решении ряда

задач. Оценим информативность четырех признаков цветов ириса при

разбиении его на 3 класса (продолжение выше приведенного примера).

Область (10) будет состоять из всех векторов w , для компонент которых

выполняются соотношения: w1 wi i 1,50; w51 wi i 51,100; w100 wi i 101,150.

В таблице 1 представлены результаты оценки информативности

признаков цветов ириса, а на рисунке 1- график значений их характеристик.

Низкая информативность первых двух признаков обусловлена их небольшой

вариативностью, тогда как для последних двух, наоборот, наблюдается

высокая вариативность.

Таблица 1 - Результаты оценки информативности признаков цветов ириса

Признаки

Свойства признака

чашелистик

пестик

длина

ширина

длина

ширина

Информативность

0,0126

0,0079

0,3205

0,8158

Относительный диапазон

изменения

0,6116

0,3980

5,0146

12,1539

В последней строке таблицы представлена величина относительного

диапазона изменения признака, определяемая как сумма отношений модуля

попарных разностей средних значений признака в классе к их минимальному

среднему значению. Как видно, приведенные оценки информативности

хорошо согласуются с оценками вариативности признаков.

8

data1

data2

data3

data4

7

Значение признака

6

5

4

3

2

1

0

0

50

100

Порядковый номер выборки

Рисунок 2 - Графики изменения признаков цветов ириса

150

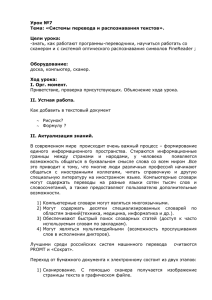

Теперь рассмотрим другой пример: оценка информативности частотных

признаков

текущих

спектров

гласных

фонем.

Эта

задача

имеет

самостоятельный интерес при распознавании голоса диктора. Пусть имеется

выборка текущих спектров мощности шести гласных фонем, представленных

каждая 30 спектрами из 128 частотных признаков в диапазоне от 0 до 5 кГц.

Всю выборку сведем в матрицу X R nm при n 180, m 128 , строки которой

соответствуют фонемам, а столбцы – частотным признакам. Требуется

оценить информативность частотных признаков указанных фонем с целью

решения

задачи

распознавания

голоса

диктора.

Поскольку

оценка

информативности частотных признаков в спектрах фонем не зависит от

порядка их следования в строках матрицы X , то для определенности спектры

фонем упорядочим в матрице в виде последовательности А, И, О, У, Э, Ы. Из

(8)

при

определим

{w | wk wi k 1,6; i 30 (k 1) 1,30 k}

информативность частотных признаков, которая представлена на рис.2

Информативность частотных признаков гласных фонем

3

Значение информативности

2.5

2

1.5

1

0.5

0

0

500

1000

1500

2000

2500

3000

3500

4000

4500

5000

Частота, Гц

Рисунок 2 - Зависимость информативности частотных признаков голоса

диктора

Как видно, признаки в диапазоне от 3,5 кГц до 5 кГц не информативны и их

можно исключить при решении задачи распознавания гласных фонем.

Для верификации диктора по голосу большое значение имеет

распределение

локальных

экстремумов

на

кривой

информативности,

поскольку они характеризуют резонансные частоты его голосового тракта,

являющиеся для каждого диктора его индивидуальными характеристиками.

Применительно к рассматриваемому примеру это частоты: 280 Гц, 560 Гц,

960 Гц, 1320 Гц, 1640 Гц, 1800 Гц, 2880 Гц. Как показывает наш опыт

исследований,

метод

выявления

резонансных

частот

по

кривой

информативности можно использовать для разработки методов верификации

дикторов в различной фоно-помеховой обстановке.

2. Оптимальная градация признаков.

Очень часто, в задачах классификации и распознавания образов

признаки, описывающие объекты наблюдения имеют разную природу,

например, количественные и качественные. Их совместное использование

при классификации данных, как правило, связано с серьезными трудностями

[5]. В связи с этим возникает задача преобразования количественных

признаков

в качественные,

или

иными

словами, задача

разбиения

количественных признаков на градации. Причем такое разбиение должно

быть оптимальным с точки зрения потребностей решаемой задачи. В

настоящей статье предлагается метод градации признаков на основе

информационного критерия (7). Эта задача сложнее, чем определение

признаков распознавания, поскольку её решение предполагает не только

определение значений критерия (7), но и определение значений порогов

градации. Оставляя в стороне детали, наметим путь решения этой задачи и

приведем примеры.

Пусть x {xi }1n R n1 - вектор-столбец вещественных положительных

чисел упорядоченных по возрастанию. Требуется разбить все n его значений

по степени близости на k групп по ns

значений в каждой ( s 1, k ,

n1 n2 ... nk n ). Обозначим ns 1 ... ns . Тогда для задачи (7) область

есть {w Rn1 | wi wn : wn

s

s 1 1

wi wns s 1, k} .

Из формулы (7) видно, что в качестве целевой функции используется

n

функция f (w)

i 1

xi n wi

, минимизация которой по области позволяет

wi i 1 xi

легко определить экстремальное w* arg min f (w) . Однако область зависит

w

от значений ns , определяемых порядковыми номерами порогов градаций

xns s 1, k . Эти пороги можно найти из условий минимизации их вкладов в

значение целевой функции f (w ) . Указанные вклады vn определяются из

следующего очевидного соотношения

n

n

1

1

1

ui ui 1 2 1 un 2 1 2un 1 vn

un un

i 1

i 1 ui

i 1

i 1 ui

n1

n1

Легко построить алгоритм определения значений

(11)

xns на основе метода

динамических сгущений и оценок вкладов (11). С использованием этого

подхода, авторами разработан эффективный метод градации значений. Его

работоспособность покажем на конкретных примерах.

1. Градация первых 100 чисел натурального ряда. В табл.2 приведены

результаты градаций этих чисел. Отметим, что при k 2 относительная

величина порога 0,21 близка к золотому сечению 0,168.

Таблица 2 - Результаты градации первых 100 чисел натурального ряда

Количество

градаций к

пороговые значения xns

ï ðåäëàãàåì û é ì åòî ä

ðàâí î ì åðí î å ðàçáèåí èå

2

21

50

3

[10; 40]

[33;66]

4

[7; 24;54]

[25;50;75]

5

[5;16;35;62]

[20; 40;60;80]

10

[3;9;17;27;38;50;62;74;87]

[10;20;30;40;50;60;70;80;90]

Как видно из табл. 2, результаты градации по информационному

критерию в сравнении с равномерным распределением смещены влево. Это

можно объяснить тем, что значение целевой функции зависит от

относительных приращений аргументов, но не от абсолютных.

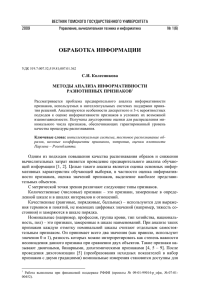

2. Градация яркостей изображений. Отмеченный в п.1 факт можно

использовать для градации изображений, когда необходимо более «часто»

градуировать те области яркостей пикселей, различия которых необходимо

подчеркнуть. Например, ярких значения пикселей, а не темных, поскольку

глаз более чувствителен к восприятию светлых участков изображений. Для

этого достаточно перейти к градуировке изображения с матрицей яркости

пикселей Y , равного Y M X , где M - матрица, все значения которой равны

максимальному значению матрицы исходного изображения

X.

Для

краткости такой метод градации назовем «обратным», в отличие от градации

исходного изображения, который мы назовем «прямым».

На рис.3 представлены результаты 4-х уровневой (2 бита) градации

яркостей пикселей изображения «Роза». В интересах сопоставления на всех

4-х изображений (включая исходное) сумма яркостей пикселей одинакова.

Как

видно,

при

равномерном,

не

оптимальном,

разбиении

наблюдаются немногочисленные артефакты, «прямой» метод показал

хорошую чувствительность к малым значениям пикселей, «обратный» выделил все яркие участки исходного изображения.

Таким образом, предлагаемый информационный критерий позволяет

получить информацию о структуре значений компонент элементов (строк,

столбцов) массива анализируемых данных, которая может быть использована

для решения различных задач их анализа – классификации, оценки

информативности признаков и их градации.

4-х уровневые градуированные изображения

равномерное разбиение

Исходное изображение

предлагаемый метод

«прямой»

«обратный»

Графики изменения критерия информативности

«прямой» метод

«обратный» метод

Рис.4 Результаты градации изображения «Роза»

Работа выполнена при поддержке РФФИ (грант № 05-08-65501 2005 г.)

Список литературы

1. Куренков Н.И. Ананьев С.Н. Энтропийный подход к решению задач

классификации

многомерных

данных.

//

Информационные

технологии. 2006. № 8. С. 50-55.

2. Самсонов В.А., Дидманидзе О.Н. Геометрическое программирование

в инженерных задачах. — М.: Колос, 1999

3. Судаков

Р.С.,

Яцко

А.И.

Элементы

прикладной

теории

геометрического программирования. — М.: Знание, 2004. — 126.

4. Айвазян С.А., Мхитарян.В.С.

Прикладная статистика и основы

эконометрики.- М.: Юнити. 1998.-1022 с.

5. Лбов Г.С. Методы обработки разнотипных экспериментальных

данных — Новосибирск: Наука, 1981. — 158 с.

6. Ту Дж., Гонсалес Р. Принципы распознавания образов.- М.: Мир,

1978.

7. Миркин Б.Г. Анализ качественных признаков. — М.: Статистика,

1976.

8. Дидэ Э. и др. Методы анализа данных / под ред Айвазяна С.А. и

Бухштабера В.М. — М.: Финансы и статистика, 1985. — 357с.

9. Сакоян С.А. Об оптимальных разбиениях на градации в задачах

классификации //Прикладная статистика — М.: Наука, 1983. —

с.179-188.

10. Rui Xu, D., Wunsch II. Survey of clustering algorithms// IEEE

Transactions on Neural Networks. -2005.-v.16, № 3.-р. 645.