УДК 519.688:004.032.26 Анализ градиента для нейронных сетей с вейвлет-разложением целевого вектора

реклама

УДК 519.688:004.032.26

Анализ градиента для нейронных сетей с вейвлет-разложением целевого вектора

Астапов К.А.

Ставропольский государственный университет, г.Ставрополь

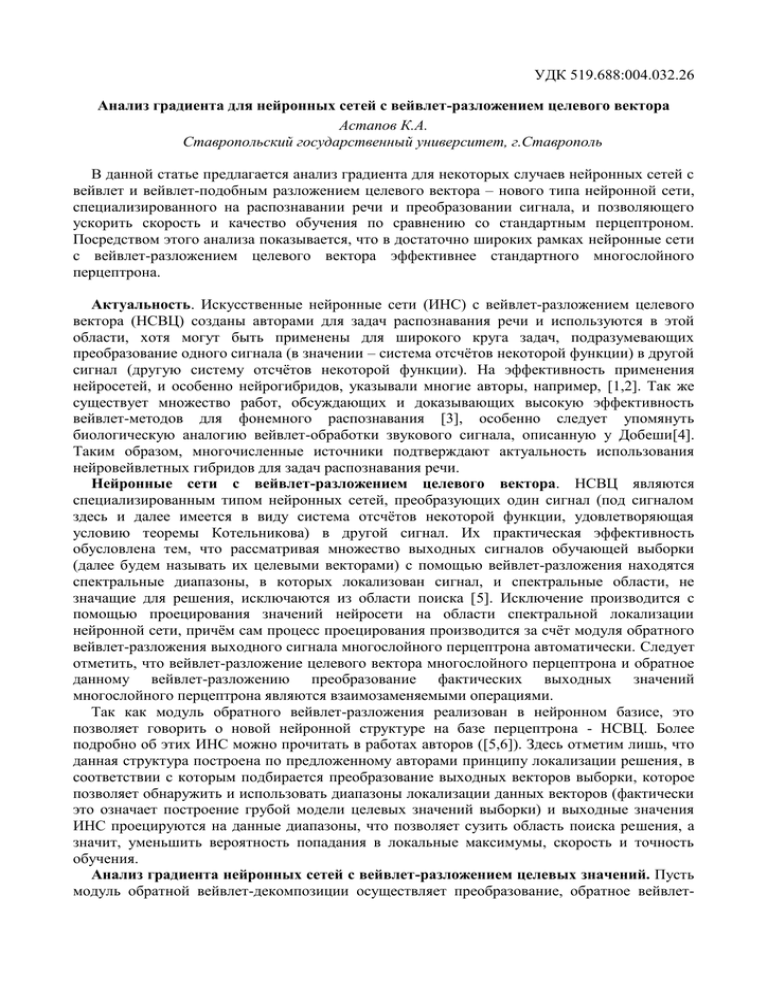

В данной статье предлагается анализ градиента для некоторых случаев нейронных сетей с

вейвлет и вейвлет-подобным разложением целевого вектора – нового типа нейронной сети,

специализированного на распознавании речи и преобразовании сигнала, и позволяющего

ускорить скорость и качество обучения по сравнению со стандартным перцептроном.

Посредством этого анализа показывается, что в достаточно широких рамках нейронные сети

с вейвлет-разложением целевого вектора эффективнее стандартного многослойного

перцептрона.

Актуальность. Искусственные нейронные сети (ИНС) с вейвлет-разложением целевого

вектора (НСВЦ) созданы авторами для задач распознавания речи и используются в этой

области, хотя могут быть применены для широкого круга задач, подразумевающих

преобразование одного сигнала (в значении – система отсчётов некоторой функции) в другой

сигнал (другую систему отсчётов некоторой функции). На эффективность применения

нейросетей, и особенно нейрогибридов, указывали многие авторы, например, [1,2]. Так же

существует множество работ, обсуждающих и доказывающих высокую эффективность

вейвлет-методов для фонемного распознавания [3], особенно следует упомянуть

биологическую аналогию вейвлет-обработки звукового сигнала, описанную у Добеши[4].

Таким образом, многочисленные источники подтверждают актуальность использования

нейровейвлетных гибридов для задач распознавания речи.

Нейронные сети с вейвлет-разложением целевого вектора. НСВЦ являются

специализированным типом нейронных сетей, преобразующих один сигнал (под сигналом

здесь и далее имеется в виду система отсчётов некоторой функции, удовлетворяющая

условию теоремы Котельникова) в другой сигнал. Их практическая эффективность

обусловлена тем, что рассматривая множество выходных сигналов обучающей выборки

(далее будем называть их целевыми векторами) с помощью вейвлет-разложения находятся

спектральные диапазоны, в которых локализован сигнал, и спектральные области, не

значащие для решения, исключаются из области поиска [5]. Исключение производится с

помощью проецирования значений нейросети на области спектральной локализации

нейронной сети, причём сам процесс проецирования производится за счёт модуля обратного

вейвлет-разложения выходного сигнала многослойного перцептрона автоматически. Следует

отметить, что вейвлет-разложение целевого вектора многослойного перцептрона и обратное

данному вейвлет-разложению преобразование фактических выходных значений

многослойного перцептрона являются взаимозаменяемыми операциями.

Так как модуль обратного вейвлет-разложения реализован в нейронном базисе, это

позволяет говорить о новой нейронной структуре на базе перцептрона - НСВЦ. Более

подробно об этих ИНС можно прочитать в работах авторов ([5,6]). Здесь отметим лишь, что

данная структура построена по предложенному авторами принципу локализации решения, в

соответствии с которым подбирается преобразование выходных векторов выборки, которое

позволяет обнаружить и использовать диапазоны локализации данных векторов (фактически

это означает построение грубой модели целевых значений выборки) и выходные значения

ИНС проецируются на данные диапазоны, что позволяет сузить область поиска решения, а

значит, уменьшить вероятность попадания в локальные максимумы, скорость и точность

обучения.

Анализ градиента нейронных сетей с вейвлет-разложением целевых значений. Пусть

модуль обратной вейвлет-декомпозиции осуществляет преобразование, обратное вейвлет-

преобразованию, заданному двумя зеркльно-квадратурными FIR фильтрами G и H,

определяемыми коффициентами hi и gi.

В этом случае вейвлет-разложение может быть реализовано последовательным

применением свёрток H ( zi )

nH

nG

l 1

l 1

hl 2k zi и G ( zi ) gl 2k zi .

xi , ~

yi , i=1,2,…,imax где вектора ~

xi , ~

yi равны

Пусть дана обучающая выборка ~

~

xi xi1 , xi 2 ,..., xin , ~

yi yi1 , yi 2 ,..., yim , и вейвлет преобразование F, преобразующее

y в набор коэффициентов F (l ) ~

вектор ~

y : F (l ) ~

y F j, l , ~

y , j=1,2,…,jmax, l=1,2,…,lmax,

i

j

i

j

i

i

где l – номер уровня вейвлет-разложения, а j – номер коэффициента на данном уровне

yi обучающей пары ~

xi , ~

yi будем называть целевым

вейвлет-разложения. Компонент ~

компонентом или целевым вектором. Тогда:

Целевые компоненты пар-примеров обучающей выборки подвергаются

вейвлет-разложению.

На каждом уровне l вейвлет разложения по всей выборке выбираются

минимальные и максимальные значения

1.

2.

Sl max F j(l ) ~

yi ,

(1)

I l min F j(l ) ~

yi .

(2)

i, j

i, j

Те же самые операции (п.1 и п.2) проводятся над контрольной выборкой.

Результатом являются контрольные минимальные и максимальные значения

3.

Ŝl и Iˆl .

Если контрольный максимум не превосходит максимум обучающей выборки

4.

более чем на заданную константу точности , Ŝl Sl , а минимум

обучающей выборки не превосходит контрольный минимум более чем ту же

, Iˆl I l , то можно говорить о корректности выбранных минимальных

и максимальных значений для данной задачи.

5.

Диапазонами частотной локализации будут области I l ; Sl для каждого

уровня l вейвлет-разложения.

Данный алгоритм дан здесь в виде инициализации ИНС, но практически возможно не

инициализировать величины Il, Sl, а корректировать их в процессе предъявления обучающих

примеров.

НСВЦ состоит из двух модулей – многослойного перцептрона (на месте которого, в

принципе, может быть любая нейронная сеть, построенная в соответствии с парадигмой

«обучение с учителем») и модуля обратной вейвлет-проекции. Значения многослойного

перцептрона принципиально ограничены (обычно в диапазонах [-1;1] и [0;1]). Процесс

проецирования выходных значений перцептрона, соответствующих l-му уровню масштаба

вейвлет-разложения на область частотной локализации будет сдвиг и масштабирование

области значений нейронной сети на область частотной локализации I l ; Sl . Обозначим

верхнее значение, принимаемое входами ИНС будет S, а нижнее I.

l

Проецирование значений перцептрона o j на диапазоны частотной локализации

решения осуществляется следующим образом:

oˆ lj olj I

SS II

l

l

I l . (3)

Рассмотрим влияние масштабирования на градиент. Введём следующие обозначения:

t

E – ошибка слоя. El - l-й компонент.

E (w) - целевая функция.

dj – желаемый выходной сигнал j-го нейрона слоя

yj – выходное значение, в общем случае y(0,1).

xi – входное значение.

wij – вес, связывающий i-й вход с j-м выходом.

uit - взвешенная сумма i-го нейрона, t-го слоя. uit

N

wkit xkt

k 0

Согласно метода распространения ошибки, имеют место следующие формулы:

E ( w)

Eit

1

2

nN

( yi d i ) 2

(4)

i 1

nt

Elt 1wilt 1 , (5)

EiN

wijt

l 1

yi d i .(6)

t dyit t

E j t xi (7)

dui

Где - скорость обучения.

dy j

E

E u j dy j E

xj

(8)

wij yi wij du j yi

du j

Пусть D(x) – функция, которая позволяет найти производную активационной функции f

по её значению

Т.е. если y j f u j

То Dy j f u j

dy j

du j

D y j (9)

такими функциями, будут, например

D( y ) y 1 y (10)

для униполярной функции и

D ( y ) 1 y 2 (11)

для биполярной функции

Рассмотрим для простоты случай биполярной функции.

E

E

xi D( y j ) (12)

wij yi

Проанализируем влияние масштабирования на компонент градиента.

Пусть выход yj во всех ситуациях не превосходит

y max sup{ y j }

1

1

k max

. Иными словами,

(13)

k max

Тогда, с учётом того, что нейронная сеть с униполярной функцией активации

выходного слоя выдаёт значения в области (0,1) мы можем промасштабировать выход,

увеличив его в k k max раз. Для этого достаточно промасштабировать соответствующий

целевой вектор. Для этого введём замену переменной

y ky

Соответственно,

d kd

Тогда, для масштабированного выхода получаем

E

k ( yi d i ) xi D(ky j ) (14)

wij

D(ky j ) 1 k 2 y 2j (15)

Используя 10 выводим

E

E D(ky j )

k

wij

wij D ( y j )

(16)

E

E ky j 1 ky j

E 1 ky j

k

k2

wij

wij y j 1 y j

wij 1 y j

E

E

Введём величину М как отношение

к

:

wij wij

E

w

.

M ij

E

wij

С помощью несложных расчётов приходим к формуле

(17)

(18)

1 k 2 y2

M ( y) k

.

1 y2

(19)

Собственно, анализ выражения 16 сводится к анализу множителя

M ( y) k

1 k 2 y j2

1 y j2

.

(20)

Этот множитель отображает участок биполярной(логистической) сигмоиды на отрезке

1

0, в полноценную сигмоиду на отрезке 0;1 . При этом

k

E

E

M yj

wij wij

Исследуем свойства множителя M.

(21)

M ( y) k

1 k 2 y j2

1 y j2

k k

3

1 k 2

1 y2

k

3

3 k k3

2y

3

M ( y) k

k

k

1 y2

1 y2

k k3

(22)

1 y2

С учётом того, что k>1, множитель k k всегда отрицательный, проверяя знаки

2

.

(23)

3

производной в окрестностях особых точек, видим, что M имеет единственный экстремум –

максимум maxM ( y ) k в точке y=0.

Таким образом мы пришли к важному выводу: в случае биполярной функции её

градиент в k раз больше при y=0, а далее монотонно убывает при y 1 и y 1 . Мы

используем эту особенность для выбора оптимального коэффициента k (см. ниже).

Для дальнейших рассуждений нам понадобиться вычислить отрезок, на котором M ( y )

больше единицы, т.е. найти то множество y, на котором градиент

E

E

.

wij wij

Исходя из монотонного убывания M(y) на отрицательной и положительной полуосях

для нахождения этого множества нам достаточно найти такие y, при которых M(y)=1.

k

M ( y) 1

y

3

1

k k 1

2

k k3

1 y2

1 y 1

2

k k3

1 k 3

1

k 2 k 1

.

(24)

Итак, мы вычислили, что M ( y) 1 при y

Обозначим

y2

.

2

2

k k 1 k k 1

что

M yeq 1 .

1

;

1

величину,

yeq такую

M ( y) 1 y yeq , yeq .

(25)

Подберём коэффициент k масштабирования таким образом, чтобы

(26)

kymax kmax yeq ,

где y max - максимальное значение y, причём y max =

1

k max

Тогда

.

При этом условии будет верно M ( y) 1 (необходимо помнить, что сигмоидальная

функция не принимает значения своего супремума и инфинума), или, что равносильно

E

E

,

wij wij

(27)

для всех значений ограниченной величины y.

Так как

y eq

kymax

1

,

k max 2 k max 1

kmax

1

,

kmax yeq k

2

kmax

kmax kmax 1

(28)

(29)

что возможно если

k

kmax 2

k max 2 k max 1

,

(30)

Итак, при коэффициенте масштабирования k

kmax 2

k max 2 k max 1

градиент целевой

функции больше на всей области значений нейронной сети, что ускоряет обучение ИНС.

Обобщим теперь изложенное в предыдущем пункте на случай вейвлет-преобразования.

Вейвлет-преобразование известно своими сжимающими свойствами, что проявляется в

том, что при вейвлет-разложении достаточно широкого класса сигналов коэффициенты

высокой детализации обычно близки к нулю. Это свойство используют для сжатия

информации с потерями, отбрасывая коэффициенты и получая приближённую модель

сигнала.

Как уже говорилось выше, мы рассматриваем узкий случай применения нейронных

сетей: когда результатом работы нейронной сети является временной сигнал, а точнее –

отсчёты некоторой временной функции.

В этом случае, если искомый сигнал (систему отсчётов функции) разложить с помощью

вейвлет-преобразования, и коэффициенты этого вейвлет-преобразования по абсолютной

величине малы, то выгоднее искать вейвлет-образ, а не сам сигнал. Причём эффективность

возрастает при уменьшении величины коэффициентов. Интуитивно очевидно, что чем

больше сигнал можно сжать при помощи выбранного вейвлет-преобразования, тем меньше

коэффициенты вейвлет-образа, и тем эффективнее использование НСВЦ. Иными словами,

степень сжимаемости сигнала можно считать мерой эффективности нейронной сети с

вейвлет-разложением сигнала.

Представим это интуитивное понимание в более формализованном виде:

Теорема об эффективности нейронных сетей с вейвлет-разложением цели.

Пусть

1) дана система из 2k отсчётов f1(t0), f2(t0), f3(t0), … , f k (t 0 ) некоторой

2

функции f(t). Причём f i (t 0 ) f (t 0 i t ) .

2) Пусть этой системе отсчётов соответствует вейвлет-образ из n

уровней разложения и 2k коэффициентов. Обозначим его коэффиценты

( j)

как d i

, j {1,2,...,n, n 1} , где d i

( j)

(t0 ) при j<n+1 – детализирующие

коэффициенты

вейвлет-образа,

а

приближённая(«огрублённая») версия сигнала fi.

3) Введём величины

( j)

k max

1

di(n 1) (t0 )

(31)

sup d i( j ) t0

i ,t 0

и

kj

k

k k

( j) 2

max

( j) 2

( j)

max

max

;

(32)

1

Тогда

если среди коэффициентов существуют такие kmax , что k max 1,

( j)

( j)

-

то

градиент построенной на данном вейвлет-разложении нейронной сети с вейвлетразложением цели больше по абсолютному значению, чем градиент соответствующей

базовой ИНС (ИНС, на основе которой построена НСВЦ).

Покажем это.

Градиент целевой функции gradE базовой нейронной сети

E

gradE

w

i, j

ij

2

(33)

Градиент целевой функции НСВЦ

E

gradE

w

i, j

ij

2

(34)

Пусть

yj k j y j .

Тогда из формул 18,20,21

E

E

,

M kj, yj

wij

wij

(35)

где

M k , y k

1 k 2 y2

1 y

2

.

(36)

При этом из соотношения 30 и утверждения 3 теоремы следует что для любых kj, yj,

удовлетворяющих условию задачи,

(37)

M k j , y j 1.

2

E

gradE M k j , y j

w

i, j

ij

2

E

2

M

k

,

y

j

j

w

i, j

ij

2

E

gradE

i , j wij

(38)

Что и требовалось доказать.

Выводы. Нами показано, что при нахождении областей частотной локализации и

проецировании значений нейронной сети на область локализации решения, в достаточно

широких рамках можно добиться увеличения градиента (по сравнению с той же ИНС без

частотной локализации и модуля обратной вейвлет-проекции), а следовательно, скорости

сходимости нейронной сети.

Литература

1. Tebelskis, J. Speech Recognition using Neural Networks: PhD thesis … Doctor of Philosophy

in Computer Science/ Joe Tebelskis; School of Computer Science, Carnegie Mellon University.–

Pittsburgh, Pennsylvania, 1995.– 179 c.

2. Handbook of neural network signal processing/ Edited by Yu Hen Hu, Jenq-Neng Hwang.–

Boca Raton; London; New York, Washington D.C.: CRC press, 2001.– 384c.

3. Ф.Г. Бойков Применение вейвлет-анализа в задачах автоматического

распознавания речи: Дис. … кандидата физико-математических наук: 05.13.18/ Фёдор

Геннадьевич Бойков.– М, 2003.– 111 с.

4. Добеши И. Десять лекций по вейвлетам.– Ижевск: НИЦ «Регулярная и хаотическая

динамика», 2001.– 464 с.

5. Астапов К.А. Применение вейвлет-преобразования для сокращения области значения

искусственных нейронных сетей на примере задачи распознавания речи// Астапов

Константин Андреевич. // Электронный научно-инновационный журнал «Инженерный

вестник Дона: электронное научное издание № ГОС. РЕГИСТРАЦИИ 0420900096, Ростовна-Дону: . – 2009. – №1. – регистрационный номер статьи

.

6. Червяков Н.И., Астапов К.А. Использование вейвлетов для улучшения параметров

нейронных сетей в задачах распознавания речи. // Червяков Николай Иванович; Астапов

Константин Андреевич. //Инфокоммуникационные технологии – N° 4. – 2008. – Самара:

Издательство ПГУТИ, 2008. – с. – с. 9-12.