Выбор набора информативных признаков для

реклама

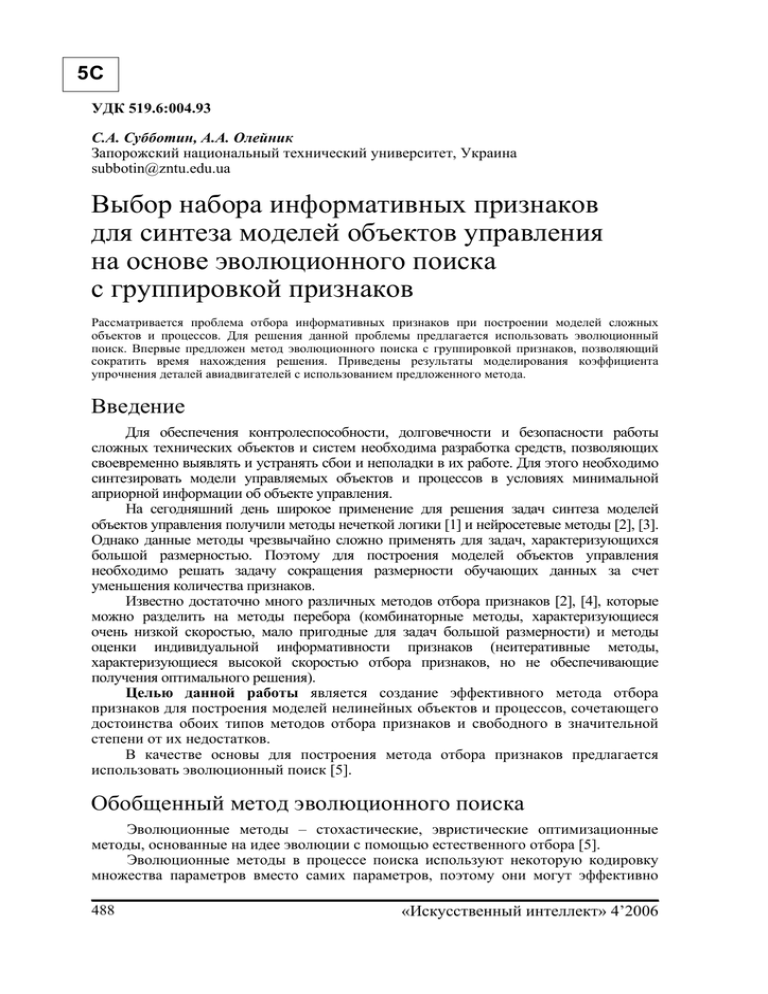

5С УДК 519.6:004.93 С.А. Субботин, А.А. Олейник Запорожский национальный технический университет, Украина subbotin@zntu.edu.ua Выбор набора информативных признаков для синтеза моделей объектов управления на основе эволюционного поиска с группировкой признаков Рассматривается проблема отбора информативных признаков при построении моделей сложных объектов и процессов. Для решения данной проблемы предлагается использовать эволюционный поиск. Впервые предложен метод эволюционного поиска с группировкой признаков, позволяющий сократить время нахождения решения. Приведены результаты моделирования коэффициента упрочнения деталей авиадвигателей с использованием предложенного метода. Введение Для обеспечения контролеспособности, долговечности и безопасности работы сложных технических объектов и систем необходима разработка средств, позволяющих своевременно выявлять и устранять сбои и неполадки в их работе. Для этого необходимо синтезировать модели управляемых объектов и процессов в условиях минимальной априорной информации об объекте управления. На сегодняшний день широкое применение для решения задач синтеза моделей объектов управления получили методы нечеткой логики [1] и нейросетевые методы [2], [3]. Однако данные методы чрезвычайно сложно применять для задач, характеризующихся большой размерностью. Поэтому для построения моделей объектов управления необходимо решать задачу сокращения размерности обучающих данных за счет уменьшения количества признаков. Известно достаточно много различных методов отбора признаков [2], [4], которые можно разделить на методы перебора (комбинаторные методы, характеризующиеся очень низкой скоростью, мало пригодные для задач большой размерности) и методы оценки индивидуальной информативности признаков (неитеративные методы, характеризующиеся высокой скоростью отбора признаков, но не обеспечивающие получения оптимального решения). Целью данной работы является создание эффективного метода отбора признаков для построения моделей нелинейных объектов и процессов, сочетающего достоинства обоих типов методов отбора признаков и свободного в значительной степени от их недостатков. В качестве основы для построения метода отбора признаков предлагается использовать эволюционный поиск [5]. Обобщенный метод эволюционного поиска Эволюционные методы – стохастические, эвристические оптимизационные методы, основанные на идее эволюции с помощью естественного отбора [5]. Эволюционные методы в процессе поиска используют некоторую кодировку множества параметров вместо самих параметров, поэтому они могут эффективно 488 «Искусственный интеллект» 4’2006 Выбор набора информативных признаков для синтеза моделей объектов… 5С применяться для решения задач дискретной оптимизации, определённых как на числовых множествах, так и на конечных множествах произвольной природы. Для работы эволюционных методов в качестве информации об оптимизируемой функции используются лишь её значения в рассматриваемых точках пространства поиска [5], [6]. Поэтому при использовании данных методов не требуется вычислений ни производных, ни каких-либо иных характеристик, а значит, такие методы применимы к широкому классу функций [7]. Обобщенный метод эволюционного поиска можно записать следующим образом [5]. Шаг 1. Запуск в начальное время t = 0. Шаг 2. Генерация начальной популяции особей P(t). Шаг 3. Вычисление функции приспособленности для всех особей в популяции F(P(t)). Шаг 4. Проверка условий окончания поиска (время, число итераций, значение функции приспособленности и т.п.). Если критерии окончания удовлетворены, перейти на шаг 12. Шаг 5. Увеличить счетчик времени (итераций): t = t + 1. Шаг 6. Выбрать часть популяции (родительские особи) для скрещивания P'. Шаг 7. Скрестить выбранные родительские особи P'(t). Шаг 8. Применить оператор мутации к особям P'(t). Шаг 9. Вычислить новую функцию приспособленности популяции F(P'(t)). Шаг 10. Выбрать выжившие особи исходя из уровня приспособленности. Шаг 11. Перейти на шаг 4. Шаг 12. Останов. Эволюционный поиск с группировкой признаков Методы эволюционного поиска являются высоко итеративными. Длительность их работы сильно зависит от начальных условий поиска. Поэтому эффективность работы традиционных методов эволюционного поиска является недостаточно высокой. Для повышения эффективности методов эволюционного поиска при решении задач отбора информативных признаков целесообразно анализировать информативность признаков на этапе инициализации параметров эволюционного метода путём применения традиционных неитеративных методов оценки индивидуальной информативности признаков [2], [4], [8]. На основании приведенных выше рассуждений предлагается реализовать метод эволюционного поиска с группировкой признаков путем модификации основных операторов эволюционного поиска. Инициализация (генерация хромосом начальной популяции) может быть выполнена следующим образом. Шаг 1. Установить: i = 0. Шаг 2. Если i > L, где L – количество хромосом начальной популяции, перейти на шаг 6. Шаг 3. Сгенерировать случайное число t ∈ [0; 1]. Шаг 4. Инициализировать i-ю хромосому по формуле: 1, t ≥ Pk , h ki = 0, t < Pk , где h ki – k-й бит i-й хромосомы; Pk – вероятность включения k-го признака в хромосому, учитывающая его информативность, а также информативность его центра группы. «Штучний інтелект» 4’2006 489 Субботин С.А., Олейник А.А. 5С Шаг 5. Установить: i = i + 1. Перейти на шаг 2. Шаг 6. Останов. Расчет вероятности Pk включения k-го признака в хромосому предлагается выполнять в такой последовательности. Шаг 1. Определить показатели индивидуальной информативности признаков Ii и тесноты связи признаков d ij , i = 1, N , где N – количество признаков. Шаг 1.1. Рассчитать I i – оценку индивидуальной информативности i-го признака, определяемую теснотой связи i-го признака с прогнозируемым параметром у. Для оценки индивидуальной информативности признаков по отношению к целевому признаку предлагается использовать один из следующих критериев [1], [8]: m – коэффициент парной корреляции: I i = ∑ (x j=1 m ∑ (x j=1 – коэффициент корреляции Фехнера: I i = – коэффициент корреляции знаков: I i = где x i = ij − x i )(y j − y) ; m ij − x i ) 2 ∑ (y j − y) 2 j=1 C i − H i 2C i = − 1; Ci + Hi m C +x i y − C +x i C +y C +x i C +y (1 − C +x i )(1 − C +y ) , 1 m 1 m x i j и y = ∑ y j – средние значения признаков x i и отклика y, m – ∑ m j=1 m j=1 количество экземпляров, Сi – количество совпадений одинаковых как позитивных, так и негативных знаков разностей (x i j − x i ) и (y j − y) для i-го признака соответственно, Нi – + количество несовпадений знаков разностей (x i j − x i ) и (y j − y) для i-го признака, Cxi y – количество совпадений положительных знаков разностей (x i j − x i ) и (y j − y) , + деленное на m – количество экземпляров в выборке, C x i , C +y – частные от деления количества положительных знаков на m для каждой переменной xi и y отдельно. Шаг 1.2. Рассчитать d ij – оценку тесноты связи i-го и j-го признаков по формулам, аналогичным приведенным выше для Ii, где вместо y используются признаки xj. Шаг 2. Выполнить группировку признаков. Шаг 2.1. Установить: q i = 0 , i = 1, N , N g = 0 , где q i – флаг обработки i-го признака ( q i = 1 , если признак обработан, и q i = 0 – в противном случае), N g – количество групп признаков. Шаг 2.2. Определить центр группы признаков: k = argmax I i . q i =0, i =1, N Установить: q k = 1 , g k = k , N g = N g + 1 , где g i – номер признака, являющегося центром группы для i-го признака. 490 «Искусственный интеллект» 4’2006 Выбор набора информативных признаков для синтеза моделей объектов… 5С Шаг 2.3. Для всех признаков i = 1, N : если d ki ≥ d гр и q i = 0 , тогда установить: g i = k и q i = 1 , где d гр – среднее значение тесноты связи признаков d ij : 1 N m ∑∑ d ij . Nm i =1 j=1 Шаг 2.4. Если имеется хотя бы один признак, для которого q i = 0 , тогда перейти на шаг 2.2. Шаг 3. Рассчитать вероятности включения i-го признака в хромосому по формуле: Pi = I i 1 − I gi + I i . В операторе отбора кроме учета ошибки, составленной с учетом отобранных признаков модели, целесообразно также учитывать информативность включенных в модель признаков. Для этого предлагается использовать одно из следующих выражений для расчета фитнесс-функции: – критерий максимума совокупности индивидуальных оценок информативности отобранных признаков – минимума ошибки модели E: d гр = ( ) N F(h k ) = ∑I h i =1 i ki ; E – критерий максимума индивидуальных оценок информативности отобранных признаков – минимума ошибки модели: max I i h ki F(h k ) = i =1, N ; E – критерий максимума совокупности индивидуальных оценок информативности отобранных признаков – минимумов количества отобранных признаков и ошибки модели: N ∑I h F(h k ) = i =1 N i ki ; ∑ h ki E i =1 – критерий минимумов количества отобранных признаков и ошибки модели: 1 ; F(h k ) = N ∑ h ki E i =1 – критерий максимума совокупности индивидуальных оценок информативности отобранных признаков – минимумов количества отобранных признаков, ошибки модели и взаимозависимости отобранных признаков: N F(h k ) = ∑I h i =1 i ki N N N ∑ h ki ∑ ∑ h ki h kj d ij E i =1 i =1 j=1 . Ошибка модели E рассчитывается по формуле: 2 1 m E = ∑ y i − y iрасч , m i =1 i где y расч – значение выходного признака, рассчитанное по модели, составленной с учетом отобранных признаков, y i – фактическое значение целевого признака, m – количество экземпляров выборки. ( «Штучний інтелект» 4’2006 ) 491 5С Субботин С.А., Олейник А.А. В операторе равномерного скрещивания случайным образом задается маска скрещивания, представляющая собой строку из нулей и единиц, длины, равной длине хромосом. Единица на конкретной позиции в маске скрещивания означает, что элемент, стоящий на том же месте у первой хромосомы-предка, необходимо поместить на это место у первой хромосомы-потомка. Нуль на этой позиции в маске скрещивания означает, что элемент, стоящий на том же месте у второй хромосомы-предка, необходимо поместить на это место у первой хромосомы-потомка. Теперь, если первую хромосому-предка считать второй, а вторую – первой, то по описанному правилу можно получить вторую хромосому-потомка. Например, если маска скрещивания (1001011), тогда (1100110) + (0110001) → (1110010). Априорная информация о значимости признаков может быть использована в операторе равномерного скрещивания следующим образом. Вначале определить пороговое значение информативности признаков. Затем создать маску скрещивания, установив «1» для тех признаков, оценки информативности которых выше порога, и «0» – для признаков, оценки информативности которых равны или ниже порога. С целью увеличения разнообразия популяции после формирования маски скрещивания можно случайным образом изменить в ней некоторые разряды. В операторе мутации априорные сведения об уровне информативности признаков можно использовать посредством усиления вероятности мутации признаков, имеющих низкие оценки индивидуальной информативности и ослабления вероятности мутации признаков с высокими оценками индивидуальной информативности. Это позволит закрепить признаки, наиболее сильно влияющие на целевой параметр модели, и сконцентрировать поиск на переборе сочетаний признаков с меньшей информативностью. Вероятность мутации предлагается рассчитывать по одной из следующих формул: – вероятностная мутация: PMi = α (1 − Pi ) , где PMi – вероятность мутации i-го бита в хромосоме, α – коэффициент степени мутации: α ∈ [0;1] ; 0, если g i = i, – радикальная мутация: PMi = α , если g i ≠ i. Эксперименты и результаты Метод эволюционного поиска с группировкой признаков был программно реализован на языке пакета MatLab. Разработанный программный модуль содержит функцию CalcError, которая рассчитывает ошибку полученной модели, данная функция является целевой, и EvolGroup, которая выполняет поиск оптимальной комбинации информативных признаков с помощью эволюционного поиска с группировкой признаков. На основании найденной комбинации информативных признаков строится нейросетевая или регрессионная модель исследуемой зависимости. На основе разработанного метода решалась задача отбора информативных признаков для построения диагностической модели коэффициента упрочнения лопаток газотурбинного авиадвигателя после алмазного выглаживания [2], [9]. В качестве факторов, наиболее полно отражающих процесс алмазного выглаживания деталей, в [9] предлагается использовать: х1 – твердость материала (HB, МПа), х2 – среднее контактное давление в зоне деформирования (qmax, МПа), х3 – полуось эллипса касания в зоне упругого контакта (а, мм), х4 – подача при выглаживании (s, мм/об), х5 – предел прочности ( σ B , МПа), х6 – предел текучести материала ( σ 0, 2 , МПа), х7 – показатель деформационного упрочнения (n), х8 – теоретический коэффициент 492 «Искусственный интеллект» 4’2006 Выбор набора информативных признаков для синтеза моделей объектов… 5С концентрации напряжений от следов обработки ( α σтехн ), х9 – параметр исходной шероховатости детали ( Ra1 , мкм), х10 – сила выглаживания (Py, Н), х11 – радиус сферы алмазного инструмента (Rсф, мм), х12 – параметр шероховатости после выглаживания детали (Ra2, мкм), х13 – теоретический коэффициент концентрации напряжений натурной детали или образца ( α σ ), х14 – диаметр образца в опасном сечении (d, мм), х15 – радиус скругления галтели или надреза (r, мм), х16 – относительный градиент первого главного напряжения ( G , мм-1). В настоящей работе для построения модели коэффициента упрочнения использовалась разработанная программа, с помощью которой перед моделированием коэффициента упрочнения проводился отбор информативных признаков. После принятия решений об информативности признаков из обучающего множества были исключены малоинформативные признаки (х1, х2, х4, х5, х7, х8, х9, х12, х13, х14, х15). Далее была получена регрессионная модель коэффициента упрочнения после алмазного выглаживания, имеющая следующий вид: β Рy ЭА = 2,125 + 0,72742 ⋅ a − 3,725 ⋅10 −4 ⋅ σ 0 , 2 + 4,2281 ⋅10 −4 ⋅ Py − 0,25551 ⋅ R сф + 0,068275 ⋅ G , где β РyЭА – оценка коэффициента упрочнения по регрессионной модели, полученной на основе сокращения набора признаков. Среднее значение относительной ошибки полученной регрессионной модели составляет 0,0564, что менее 7 %. Для получения более точных моделей целесообразно использовать искусственные нейронные сети. Моделирование коэффициента упрочнения осуществлялось на основе отобранных информативных признаков с помощью двухслойного персептрона [2], первый слой которого содержал 4 нейрона, а второй слой – 1 нейрон. Все нейроны имели сигмоидную функцию активации ψ(x) = 1/(1+e–x). Среднее значение относительной ошибки полученной модели β y составило 3,36·10–5. НС ЭА Для сравнения с предложенным методом рассмотренная задача решалась также на основе обобщенного метода эволюционного поиска. В табл. 1 приведена сравнительная характеристика некоторых параметров работы обобщенного метода эволюционного поиска и эволюционного поиска с группировкой признаков. Таблица 1 – Сравнительная характеристика обобщенного метода эволюционного поиска и эволюционного поиска с группировкой признаков № 1 2 3 4 5 6 Показатель Количество вычисленных значений фитнесс-функции Количество отобранных признаков Достигнутая ошибка регрессионной модели Достигнутая ошибка нейросетевой модели Время на работу метода, c Время на работу (эмуляцию) полученной НС модели, мс Обобщенный эволюционный поиск Эволюционный поиск с группировкой признаков 117 96 8 5 0,0601 0,0564 2,28·10–4 3,36·10–5 0,0781 0,0313 1,2 0,156 Также следует отметить, что время эмуляции нейромодели, построенной по всем признакам, составившее 7,812 мс, значительно больше времени эмуляции модели, полученной на основании предложенного метода, составившего 0,156 мс. «Штучний інтелект» 4’2006 493 5С Субботин С.А., Олейник А.А. Выводы Проведенные эксперименты позволяют заключить, что предложенный метод эволюционного поиска с учетом информативности признаков является более эффективным по сравнению с обобщенным методом эволюционного поиска. Разработанный метод обеспечивает существенное ускорение поиска за счет использования априорной информации о значимости признаков, полученной путем анализа индивидуальной информативности признаков на этапе инициализации параметров генетического метода с помощью применения традиционных неитеративных методов оценки индивидуальной информативности признаков. По результатам экспериментов можно рекомендовать предложенный метод для решения задач отбора информативных признаков в задачах технической и биомедицинской диагностики, экономико-математическом моделировании, задачах управления и поддержки принятия решений. Литература 1. Дли М.И. Нечеткая логика и искусственные нейронные сети. – М.: Физматлит. – 225 c. 2. Интеллектуальные средства диагностики и прогнозирования надежности авиадвигателей / В.И. Дубровин, С.А. Субботин, А.В. Богуслаев, В.К. Яценко. – Запорожье: ОАО «Мотор-Січ», 2003. – 279 с. 3. Генетические алгоритмы, искусственные нейронные сети и проблемы виртуальной реальности / Г.К. Вороновский, К.В. Махотило, С.Н. Петрашев, С.А. Сергеев. – Харьков: Основа, 1997. – 112 с. 4. Биргер И.А. Техническая диагностика. – М.: Машиностроение, 1978. – 240 с. 5. Холланд Х.Д. Генетические алгоритмы // В мире науки. – 1992. – № 9. – С. 32-40. 6. Gen M., Cheng R. Genetic algorithms and engineering design. – John Wiley & Sons, 1997. – 352 p. 7. Holland J.H. Adaptation in natural and artificial systems. – Michigan: The University of Michigan Press, 1975. – 97 p. 8. Лакин Г.Ф. Биометрия: Учеб. пособие для биол. спец. вузов. – М.: Высшая школа, 1990. – 352 с. 9. Богуслаев В.А., Яценко В.К., Притченко В.Ф. Технологическое обеспечение и прогнозирование несущей способности деталей ГТД. – К.: Манускрипт, 1993. – 333 с. С.О. Субботін, А.О. Олійник Вибір набору інформативних ознак для синтезу моделей об’єктів керування на основі еволюційного пошуку з групуванням ознак Розглядається проблема відбору інформативних ознак при побудові моделей складних об’єктів і процесів. Для розв’язання даної проблеми пропонується використовувати еволюційний пошук. Вперше запропонований метод еволюційного пошуку з групуванням ознак, що дозволяє скоротити час знаходження розв’язку. Наведено результати моделювання коефіцієнта зміцнення деталей авіадвигунів з використанням запропонованого методу. S.А. Subbotin, A.А. Oleynik The Informative Feature Set Selection for Object of Control Model Synthesis Based on the Evolutionary Search with a Features Grouping The problem of informative feature selection is considered at the construction of complex objects and processes models. The evolutionary search is proposed for a solution of this problem. The new method of the evolutionary search with a features grouping is offered, it allows to reduce a time of decision search. The results of airengine detail hardening coefficient modeling based on the suggested method are shown. Статья поступила в редакцию 20.03.2006. 494 «Искусственный интеллект» 4’2006