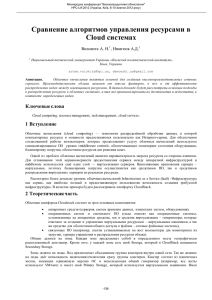

Описание кластера:

реклама

В СПбГУ создан комплекс, состоящий из центрального кластера и 5 учебных кластеров. Все кластеры соединяются оптоволоконной сетью. Связь с сетью университета осуществляется через защитный экран, установленный на отдельном сервере. Учебные кластеры расположены в зданиях факультетов физическом, прикладной математики-процессов управления, математико-мкханическом и химическом. Центральный кластер и учебный кластер установлены в Петродворцовом телекоммуникационном центре. Наличие специальной сети предусматривает объединение ресурсов. Аппаратный состав центрального кластера. Кластер состоит из 12-ти двухпроцессорных серверов Pentium III с тактовой частотой процессоров 600 МГц. Каждый сервер имеет по два жестких диска 4.7 Гб и 512 Мб оперативной памяти. Комплектация сервера: 2 CPU Intel Pentium III 600 MHz Материнская плата GA-6BXDU, chipset Intel 443BX, 2 Ultra II SCSI порта 2 DIMM PC100ECC 256 Mb 8ns SAM 2 жестких диска 4.55 Gb Fujitsu MAC3045SP Ultra-Wide SCSI Видеокарта ATI Match 3D PCI 2Mb Сетевая карта PCI 10/100Base Дисковод 3"5 1,44 Mb Максимальная производительность, достигнутая на 24-х процессорах кластера - 4 308 Mflops. Аппаратный состав учебного кластеров Рабочие станции учебный кластер несут многофункциональную нагрузку, в частности, они являются рабочими местами для обучающихся, в их комплектацию входят монитор, клавиатура и мышь. Комплектация рабочей станции: CPU Celeron 400 MHz Материнская плата GA-6VA7,chipset VIA Apollo Pro AGPset DIMM PC100ECC 64 Mb 8ns SAM 1 жесткий диск 6.5 Gb Fujitsu MPE3064AT Видеокарта S3 Trio3D/2X Сетевая карта DFE-538TX 10/100Base Дисковод 3"5 1,44 Mb Монитор HYUNDAI DeluxScan S570 Клавиатура, мышь Каждый учебно-вычислительный кластер состоит из 8 компьютеров. Максимальная производительность, достигнутая на 8 процессорах кластера - 779,54 Mflops. Сетевые компоненты комплекса. Коммуникационной средой комплекса является FastEthernet ( 100 Mb/s ). Компьютеры соединяются через коммутаторы Cisco Catalyst WS-C2924-XL-EN и 3Com SuperStack 3300. Кластеры, распределенные по территории Петродворцового учебно-научного комплекса, соединяются с вычислительным кластером через коммутатор Cisco Catalyst WS-C2924-XL-EN оптоволоконными оптическими каналfми связи, которые планируется изменить на Gigabit Ethernet. Состав дополняющих серверов комплекса В состав комплекса входят серверы, поддерживающие организационные сетевые сервисы. Это сервер связи charon.ptc.spbu.ru и файл-сервер. Комплектация сервера связи: CPU Celeron 333 MHz материнская плата SY-7IZB 2 IDE HDD 8 GB и 6GB SDRAM 64 Mb Монитор, клавиатура, мышь Сетевая карта DFE-538TX 10/100Base Сетевая карта 3C509-Combo 10Base Комплектация файл-сервера: 2 CPU Pentium II 450 MHz материнская плата GA-6BXD (chip Intel 440BX) SCSI adapter AHA-3940 UW 2 SCSI HDD 9.1 Gb 2 IDE HDD IBM DPTA-372050 20.5Gb SDRAM 256 Mb Сетевая карта PCI 10/100Base Монитор, клавиатура, мышь Программная платформа комплекса. Базовой операционной системой комплекса являются свободно распространяемые версии UNIX FreeBSD и Linux. На FreeBSD 3.3 работают компьютеры центрального кластера, учебные кластеры базируется на Linux Linux Red Hat версия 6.2, (кроме кластера физическкого факультета - Mandrake 7.0). Параллелизация поддерживается программными пакетами Mpich 1.2.1 и Pvm 3.4.3. Программы, обеспечивающие работу пользователя с комплексом - редакторы, компиляторы, графические оболочки – обеспечиваются свободно распространяемыми пакетами прикладных программ, поставляемыми вместе с системным программным обеспечением. Планируется переход всех кластеров на операционную систему на всех кластеров на Linux Red Hat версии 6.2. Масштабируемость кластера - LINPACK для матриц размера 4000x4000, 6000x6000 и матриц размера максимальной производительности Производительность, MFLOPS 5000 4500 4000 4000 3500 6000 3000 RMAX 2500 2000 1500 1000 500 0 1 4 9 16 24 4000 304 742,58 1157,39 1312,75 1201,15 6000 313,63 857,1 1381 1696,49 1450,01 RMAX 313,62 1060,88 2016,76 3220,41 4380,80 Число процессоров Производительность, MFLOP/сек Тестирование учебного кластера по тесту LINPACK Версия MPI - MPICH 1.1.2 900 800 2 CPU 700 4 CPU 600 6 CPU 8 CPU 500 400 300 200 100 0 1000 1500 2000 2500 3000 3500 4000 4500 5000 5500 6000 6500 2 CPU 119,81 162,1 180,78 206,53 4 CPU 171,98 219,71 280,25 335,05 393,8 398,49 424,08 6 CPU 210,1 273,49 389,63 406,4 435,71 503,83 548,44 570,31 587,51 592,84 8 CPU 225,09 237,83 322,17 419,92 501,53 552,65 608,3 650,59 702,91 713,89 734,6 779,54 Размер матрицы