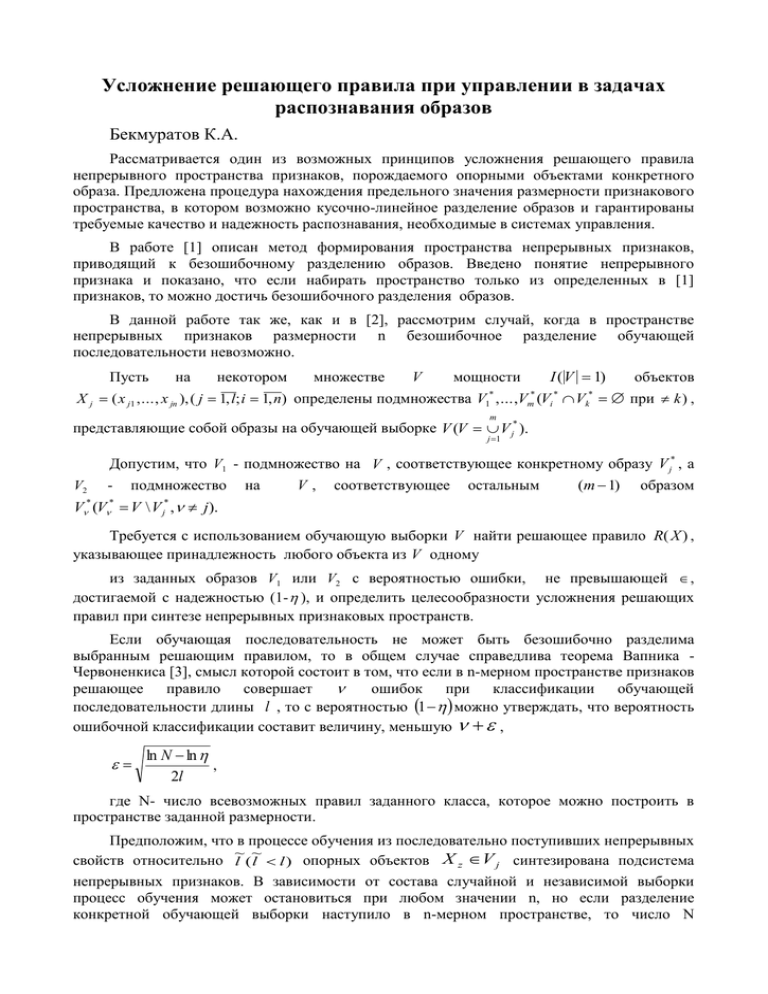

Усложнение решающего правила при управлении в задачах распознавания образов Бекмуратов К.А.

реклама

Усложнение решающего правила при управлении в задачах распознавания образов Бекмуратов К.А. Рассматривается один из возможных принципов усложнения решающего правила непрерывного пространства признаков, порождаемого опорными объектами конкретного образа. Предложена процедура нахождения предельного значения размерности признакового пространства, в котором возможно кусочно-линейное разделение образов и гарантированы требуемые качество и надежность распознавания, необходимые в системах управления. В работе [1] описан метод формирования пространства непрерывных признаков, приводящий к безошибочному разделению образов. Введено понятие непрерывного признака и показано, что если набирать пространство только из определенных в [1] признаков, то можно достичь безошибочного разделения образов. В данной работе так же, как и в [2], рассмотрим случай, когда в пространстве непрерывных признаков размерности n безошибочное разделение обучающей последовательности невозможно. объектов I ( V 1) Х j ( x j1 ,..., x jn ),( j 1, l; i 1, n) определены подмножества V1* ,...,Vm* (Vi * Vk* при k) , Пусть на некотором множестве V мощности m представляющие собой образы на обучающей выборке V (V V j* ). j 1 Допустим, что V1 - подмножество на V , соответствующее конкретному образу V j* , а V2 - подмножество на V, соответствующее остальным (m 1) образом V (V V \ V , j ). * * * j Требуется с использованием обучающую выборки V найти решающее правило R( X ) , указывающее принадлежность любого объекта из V одному из заданных образов V1 или V2 с вероятностью ошибки, не превышающей , достигаемой с надежностью (1- ), и определить целесообразности усложнения решающих правил при синтезе непрерывных признаковых пространств. Если обучающая последовательность не может быть безошибочно разделима выбранным решающим правилом, то в общем случае справедлива теорема Вапника Червоненкиса [3], смысл которой состоит в том, что если в n-мерном пространстве признаков решающее правило совершает ошибок при классификации обучающей последовательности длины l , то с вероятностью 1 можно утверждать, что вероятность ошибочной классификации составит величину, меньшую , ln N ln , 2l где N- число всевозможных правил заданного класса, которое можно построить в пространстве заданной размерности. Предположим, что в процессе обучения из последовательно поступивших непрерывных ~ ~ свойств относительно l ( l l ) опорных объектов X z V j синтезирована подсистема непрерывных признаков. В зависимости от состава случайной и независимой выборки процесс обучения может остановиться при любом значении n, но если разделение конкретной обучающей выборки наступило в n-мерном пространстве, то число N всевозможных решающих правил в классе не должно превышать числа всех подмножеств множества, состоящего из элементов, т.е. N 2 n 3 l Cmn * , где ~ m* l 2r Cmr . Логарифмируя получим n ln N ln 2 n 1 ln l ln Cm * Если учесть (1) ~ m* l mr , то (1) принимает вид ln N ln 2n 1 ln l ln C~lnm r , (2) n где ln C~ можно оценить в виде l mr ln C n ~ r lm ~ ~ (l m r ) n ln n(r ln m ln l ) ln 2 n n 2 (3) Подставляя (3) в (2), получаем ~ ln N n(ln l r ln m) ln l 1 (4) Используя теорему Вапника-Червоненкиса [3], можно вычислить предельную размерность пространства n l ln l ln 1 ~ ln l r ln m которая при заданных , ~ r , m, l , l (5) гарантирует требуемые и . Пусть вычислено максимально допустимое значение размерности пространства n в виде (5) и в этом пространстве фиксирована линейная решающая функция n R( X ) 0 i xi . (6) i 1 Далее, для того чтобы в процессе обучения синтезировать пространство, в котором линейное решающее правило (6) безошибочно разделило бы обучающую выборку V длины l , и при этом размерность пространства не превышала бы n , необходимо на признаки xi ( i 1, n ) наложить дополнительные требования. Зная предельную размерность простанства n (8), можно оценить минимально допустимую разделяющую силу каждого выбираемого признака xi в виде Fmin ( xi ) r . n Минимально допустимая разделяющая сила признака позволяет при синтезе непрерывного пространства использовать не все признаки, а выбирать только те, разделяющая сила которых удовлетворяет неравенству Fmax ( xi ) Fmin ( xi ). Допустим, что в синтезированном пространстве непрерывных признаков размерности n линейная решающая функция (9) совершает ошибки с частотой . Тогда рассмотрим соотношение ( ln N * ln ln N * * ln , ) 2l l (7) где N* - соответствует решающему правилу, работающему с частотой ошибки , N**безошибочно разделяющая обучающая последовательность длины l . С использованием этого соотношения, можно установить целесообразность усложнения решающего правила в случае, если в пространстве размерности n ещё не достигнуто безошибочное разделение обучающей выборки. Известно [3], что если вместо линейного правила используется кусочно-линейное и оно безошибочно разделяет обучающую выборку длины l, то в соответствии (7) вместо n следует выбирать величину n=nk+k , (8) где k - число линейных решающих правил, составляющих искомое кусочно - линейное правило. Используя соотношения (7) и (8), ответим на вопрос: стоит ли усложнять решение, если линейное правило в пространстве размерности n не обеспечивает безошибочного разделения обучающей выборки. Для этого нужно сделать подстановку: ~ ln N * n(ln l r ln m) ln l 1 , (9) ~ ln N * * (nk k )(ln l r ln m) ln l 1 В этом случае усложнение решающего правила, определяемое числом k, не приведёт к снижению вероятности ошибки, если будет выполнено соотношение (7) после подстановки (8). Из этого условия можно найти такое значение k, выше которого теряет всякий смысл усложнение решающего правила, действующего в пространстве непрерывных признаков размерности n: ~ n(ln l r ln m) ln l 1 ln l ( ) ln l ln 1 2 l k . ~ (n 1)(ln l r ln m) (10) Таким образом, если выбирать n и k согласно (5) и (10), то процедура позволяет, при синтезе пространства, использовать не все признаки, а выбирать только те, разделяющая ~ сила которых позволяет при заданных r , m, l , l обеспечить требуемые значения ε и η. Список литературы 1. Бекмуратов. К.А. Процедура формирования непрерывных признаковых пространств при последовательном обучении. Узб. Журнал // «Проблемы информатики и энергетики».1994.-№4.-С.17-20. 2. К.А. Бекмуратов. Пошаговая проверка целесообразности усложнения решающего правила при последовательном обучении задаче распознавания. Узб. Журнал // «Проблемы информатики и энергетики». -2000. -№1. – С. 16-19. 3. Вапник В.Н., Червоненкис А.Я. Теория распознавания образов.(Статистические проблемы обучения). – М.: Наука, 1974. –С. 415.