Лекция 7 Уравнение множественной регрессии Теорема Гаусса-Маркова

реклама

Лекция 7

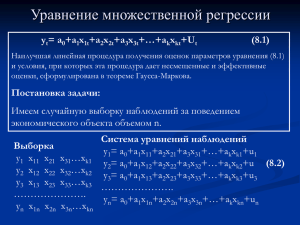

Уравнение множественной регрессии

Теорема Гаусса-Маркова

n

yt a0 a1 x1t a2 x2t ... an xnt ut ai xit ut

(7.1)

i 0

Наилучшая линейная процедура получения оценок

параметров уравнения (7.1) и условия, при которых эта

процедура дает несмещенные и эффективные оценки,

сформулирована в теореме Гаусса-Маркова

Карл Фридрих Гаусс

Время жизни

30.04.1777 - 23.02.1855

Научная сфера –

математика, физика,

астрономия

Андрей Андреевич Марков

Время жизни

14.06.1856 - 20.07.1922

Научная сфера - математика

Постановка задачи:

Имеем случайную выборку наблюдений за поведением

экономического объекта объемом n

y1

y2

...

yn

x11

x12

...

x1n

x21

x22

...

x 2n

...

...

...

...

xk 1

xk 2

...

xkn

Выборка наблюдений за переменными

модели (7.1)

Первый индекс – номер регрессора

Второй индекс – номер наблюдения

y1 a0 a1 x11 a2 x 21 ... an xk1 u1

y 2 a0 a1 x12 a2 x 22 ... an xk 2 u2

.......... .......... .......... .......... ..........

y1 a0 a1 x1n a2 x 2n ... an xkn un

(7.2)

(7.2) - Система уравнений наблюдений, связывающая

наблюдения в выборке

Сформируем вектора и матрицу коэффициентов на основе

системы (7.2)

a0

A a1

...

ak

y1

y

Y 2

...

yn

u

1

U u2

...

un

1 x11

1

X ... x...12

1

x1n

x21

x22

...

x 2n

...

...

...

...

xk 1

xk 2

...

xkn

Y – вектор выборочных значений эндогенной переменной

U – вектор выборочных значений случайного возмущения

A - вектор неизвестных параметров модели

х – вектор регрессоров

X – матрица коэффициентов при неизвестных параметрах

Y Ax U

По данным выборки найти: Ã, Cov(ÃÃ), σu, σ(ỹ(z))

Теорема (Гаусса – Маркова)

Если матрица Х неколлинеарна и вектор случайных

возмущений удовлетворяет следующим требованиям:

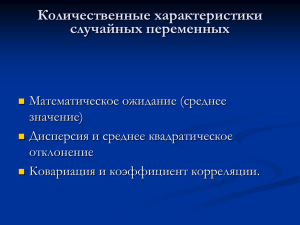

1. Mui 0

2. 2 ui u2

3. Covui ,uj 0

при i j

4. Covxi ,ui 0

Математическое ожидание всех

случайных возмущений равно нулю

Дисперсия случайных возмущений

постоянна во всех наблюдениях

(условие ГОМОСКЕДАСТИЧНОСТИ)

Случайные возмущения в разных

наблюдениях не зависимы

Случайные возмущения и регрессоры

не зависимы

Тогда наилучшей линейной процедурой оценки

параметров модели (7.1) является:

1

~

A XT X XT Y

(7.3)

которая удовлетворяет методу наименьших квадратов

~ ~

~u2 XT X

Cov( A, A )

При этом:

1

2

1

1

2

~

~

y

y

ui

i

i

nk

nk

~

Y z ~

a0 ~

a1 z1 ... ~

ak zk

2 ~

2

~

y

(

z

)

u 1 q0

1

T T

q0 z X X z

2

u

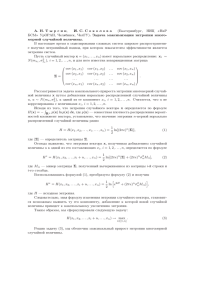

Доказательство

Воспользуемся методом наименьших квадратов

n

T

2

S ui u u min

(7.4)

i 1

где

~

u Y Y Y X~

a

(7.5)

Подставив (7.5) в (7.4) получим

T

T

S u u Y X~

a Y X~

a

T

T

T

~

~

Y

X

a

Y a X

T T

T

T

T

~

~

Y Y 2~

Y

X

a X a

a X

(7.6)

Для получения необходимого условия экстремума

дифференцируем (7.6) по вектору параметров

S

2 XT Y 2 XT X~

a0

~

a

Откуда система нормальных уравнений для определения

искомых параметров получает вид

T

T

~

X Xa X Y

Решение системы (7.7) в матричном виде есть

1

~

T

T

A X X X Y

Выражение (7.3) доказано

(7.7)

Докажем несмещенность оценок (7.3)

1

T

T

~

M a M X X X Y M XT X

M XT X

1

1

X Xa u

T

T

X Xa u

a

Несмещенность оценки (7.3) доказана

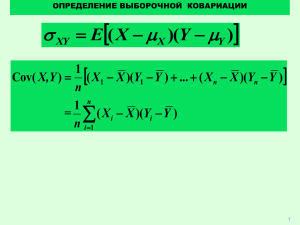

Вычислим ковариационную матрицу оценок (7.3)

T 1 T

1

1

2

T

T

T

~

~

Cov a, a Cov X X X Y, X X X Y u X X

В результате получено выражение (7.4)

Пример 1. Пусть имеем выборку из n наблюдений за

случайной величиной Y

Найти наилучшие оценки среднего значения и

дисперсии этой переменной

В терминах теоремы Гаусса –Маркова задача

формулируется так: необходимо построить модель

типа Y = a0 +u, при этом имеем:

1

1

X

...

1

y

1

y

Y 2

...

yn

X 1 1 ... 1

T

Решение

1. Вычисляем (XTX)-1

1

XT X 1 1 ... 1...1 n

1

4. Находим дисперсию

среднего

X

T

X

1

2. Вычисляем (XTY)

1

n

~a X X

y1

y

T

X Y 1 1 ... 1 2 yi

...

yn

3. Вычисляем оценку параметра а0

n

1

T

T

~

X

X Y yi

a0 X

n i1

1

2

0

2

u

T

1

n 1

2

u

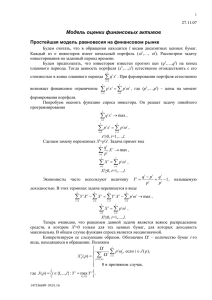

Пример 2. Уравнение парной регрессии

Построить модель типа Y=a0+a1x +u, по данным выборки наблюдений за переменными Y и x объемом n

В схеме Гаусса-Маркова имеем:

y1

1 x1

u1

y

u2

1

1

1

...

1

T

x

2

X

Y 2 A a0 U

X

x1 x2 ... xn

a1

...

... ...

...

un

1 xn

yn

1. Вычисляем матрицы (XTX) и (XTX)-1

1

1

1

1

...

1

T

X X x1 x2 ... xn ...

1

x1

x2 n

... xi

xn

x

x X X

i

2

i

T

1

xi2 xi

2

n xi xi xi xi n

1

2. Вычисляем XTY

y1

yi

1

1

...

1

y

T

2

X Y

...

xn ... xi yi

x1 x2

y

n

3. Вычисляем оценку вектора параметров а

xi2 xi yi

2

n xi xi xi xi n xi yi

2

1

x

i yi xi xi yi

~

a

0

a

2

a1 n xi xi xi n xi yi xi yi

~

a

1

Вычислим дисперсии (ковариационную матрицу)

параметров модели

2

~

~

1

1

xi xi

2

2

T

Cov A, A u X X u

n xi2 xi xi xi n

Следовательно:

xi

2 ~

2

a0 u

n xi2 xi xi

2

2

~

a1 u

2

n

n xi2 xi xi

2

~

Cov~

,

a0 a1

u

xi

n xi2 xi xi

Расчет дисперсии прогнозирования

Прогноз осуществляется в точке Z={1,z}Т

Y(z) 1 q

1

1

x

x

q Z X X Z 1 z n

z

n

x x x x

z x 1

1

x

z

nz

n x x x x

1

x x z x

x

2z x n z

x

n

n x x x

n x x x

1

z

x

Y(z) 1 n n x x

2

2

u

T

0

2

1

T

i

i

2

0

i

i

i

i

2

i

i

2

i

i

i

i

2

2

2

i

2

i

2

i

i

2

i

2

2

i

i

i

i

2

2

2

2

u

2

i

i

i

Процедура «ЛИНЕЙН» в приложении EXCEL

Алгоритм использования процедуры:

1. Подготовка таблицы исходных данных

2. Вызов процедуры «ЛИНЕЙН»

3. Ввод исходных данных в процедуру

4. Анализ результата

Рассмотрим алгоритм на примере

Выводы:

1. Теорема Гаусса-Маркова формулирует

наилучшую линейную процедуру расчета оценок

параметров линейной модели множественной регрессии

2. Линейная процедура соответствует методу

наименьших квадратов

3. Предпосылки теоремы обеспечивают получение

оценок, обладающих свойствами несмещенности и

эффективности

4. При выполнении предпосылок свойства

эффективности и несмещенности достигаются при любом

законе распределения случайного возмущения