Л е к ц и я №03.

реклама

Л е к ц и я №03. Базы данных.

Технологии добычи данных (Data Mining).

1.

2.

3.

4.

5.

Введение......................................................................................................................................................... 1

Информационные технологии анализа данных .......................................................................................... 4

Технология добычи данных .......................................................................................................................... 6

Классы систем Data Mining ........................................................................................................................... 7

Перспективы систем Data Mining ................................................................................................................ 11

СЛАЙД №2

1. Введение

«За последние годы, когда, стремясь к повышению эффективности и прибыльности бизнеса, при создании БД все стали пользоваться средствами обработки цифровой информации,

появился и побочный продукт этой активности - горы собранных данных: И вот все больше

распространяется идея о том, что эти горы полны золота».

В прошлом процесс добычи золота в горной промышленности состоял из выбора участка земли и дальнейшего ее просеивания большое количество раз. Иногда искатель находил несколько ценных самородков или мог натолкнуться на золотоносную жилу, но в большинстве случаев

он вообще ничего не находил и шел дальше к другому многообещающему месту или же вовсе

бросал добывать золото, считая это занятие напрасной тратой времени.

Data Mining для данных развилась почти таким же способом. Старые методы, применявшиеся

математиками и статистиками, отнимали много времени, чтобы в результате получить конструктивную и полезную информацию. Сегодня на рынке представлено множество инструментов, включающих различные методы, которые делают Data Mining прибыльным делом, все более доступным для большинства компаний.

Термин Data Mining получил свое название из двух понятий: поиска ценной информации в

большой базе данных (data) и добычи горной руды (mining). Оба процесса требуют или просеивания огромного количества сырого материала, или разумного исследования и поиска искомых

ценностей.

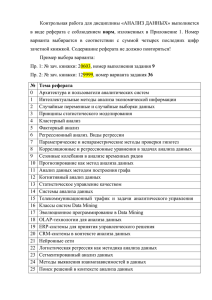

Data Mining - мультидисциплинарная область, возникшая и развивающаяся на базе таких наук

как прикладная статистика, распознавание образов, искусственный интеллект, теория баз данных и др.

СЛАЙД №3

Приведем краткое описание некоторых дисциплин, на стыке которых появилась технология Data Mining.

наблюдений либо экспериментов.

Статистика - это наука о методах сбора

данных, их обработки и анализа для выявления закономерностей, присущих

изучаемому явлению. Статистика является совокупностью методов планирования эксперимента, сбора данных, их

представления и обобщения, а также

анализа и получения выводов на основании этих данных. Статистика оперирует данными, полученными в результате

2

Понятие Машинного обучения. Единого определения машинного обучения на сегодняшний день нет. Машинное обучение можно охарактеризовать как процесс получения программой новых знаний. Митчелл в 1996 году дал такое определение: "Машинное обучение это наука, которая изучает компьютерные алгоритмы, автоматически улучшающиеся во

время работы". Одним из наиболее популярных примеров алгоритма машинного обучения

являются нейронные сети.

Понятие Искусственного интеллекта. Искусственный интеллект - научное направление,

в рамках которого ставятся и решаются задачи аппаратного или программного моделирования видов человеческой деятельности, традиционно считающихся интеллектуальными.

Термин интеллект (intelligence) происходит от латинского intellectus, что означает ум, рассудок, разум, мыслительные способности человека. Соответственно, искусственный интеллект (AI, Artificial Intelligence) толкуется как свойство автоматических систем брать на себя

отдельные функции интеллекта человека. Искусственным интеллектом называют свойство

интеллектуальных систем выполнять творческие функции, которые традиционно считаются

прерогативой человека.

СЛАЙД №4

Каждое из направлений, сформировавших Data Mining, имеет свои особенности. Проведем

сравнение с некоторыми из них.

Сравнение статистики, машинного обучения и Data Mining

Статистика

o Более, чем Data Mining, базируется на теории.

o Более сосредотачивается на проверке гипотез.

Машинное обучение

o Более эвристично.

o Концентрируется на улучшении работы агентов обучения.

Data Mining.

o Интеграция теории и эвристик.

o Сконцентрирована на едином процессе анализа данных, включает очистку данных, обучение, интеграцию и визуализацию результатов.

Data Mining – это процесс обнаружения в сырых данных ранее неизвестных, нетривиальных,

практически полезных и доступных интерпретации знаний, необходимых для принятия решений в различных сферах человеческой деятельности.

СЛАЙД №5

Суть и цель технологии Data Mining можно охарактеризовать так: это технология, которая

предназначена для поиска в больших объемах данных неочевидных, объективных и полезных

на практике закономерностей.

Неочевидных - это значит, что найденные закономерности не обнаруживаются стандартными методами обработки информации или экспертным путем.

Объективных - это значит, что обнаруженные закономерности будут полностью соответствовать действительности, в отличие от экспертного мнения, которое всегда является

субъективным.

Практически полезных - это значит, что выводы имеют конкретное значение, которому

можно найти практическое применение.

В связи с совершенствованием технологий записи и хранения данных на людей обрушились

колоссальные потоки информационной руды в самых различных областях. Деятельность любого предприятия (коммерческого, производственного, медицинского, научного и т.д.) теперь

сопровождается регистрацией и записью всех подробностей его деятельности. Что делать с

3

этой информацией? Стало ясно, что без продуктивной переработки потоки сырых данных образуют никому не нужную свалку.

Специфика современных требований к такой переработке следующие:

Данные имеют неограниченный объем

Данные являются разнородными (количественными, качественными, текстовыми)

Результаты должны быть конкретны и понятны

Инструменты для обработки сырых данных должны быть просты в использовании

Традиционная математическая статистика, долгое время претендовавшая на роль основного

инструмента анализа данных, откровенно спасовала перед лицом возникших проблем. Главная причина — концепция усреднения по выборке, приводящая к операциям над фиктивными

величинами (типа средней температуры пациентов по больнице, средней высоты дома на улице, состоящей из дворцов и лачуг и т.п.). Методы математической статистики оказались полезными главным образом для проверки заранее сформулированных гипотез (verification-driven

data mining) и для «грубого» разведочного анализа, составляющего основу оперативной

аналитической обработки данных (online analytical processing, OLAP).

СЛАЙД №6

Примеры формулировок задач при использовании методов OLAP и Data Mining

OLAP

Data Mining

Каковы средние показатели травматизма

для курящих и некурящих?

Встречаются ли точные шаблоны в описаниях людей, подверженных повышенному травматизму?

Каковы средние размеры телефонных

счетов, существующих клиентов в сравнении со счетами бывших клиентов, отказавшихся от услуг телефонной компании?

Имеются ли характерные портреты клиентов, которые, по всей вероятности, собираются отказаться от услуг телефонной

компании?

Какова средняя величина ежедневных

покупок по украденной и не украденной

кредитной карточке?

Существуют ли стереотипные схемы покупок для случаев мошенничества с кредитными карточками?

СЛАЙД №7

4

СЛАЙД №8

В основу современной технологии Data Mining (discovery-driven data mining) положена концепция шаблонов (паттернов), отражающих фрагменты многоаспектных взаимоотношений в

данных. Эти шаблоны представляют собой закономерности, свойственные подвыборкам

данных, которые могут быть компактно выражены в понятной человеку форме. Поиск шаблонов производится методами, не ограниченными рамками априорных предположений о структуре выборке и виде распределений значений анализируемых показателей.

Важное положение Data Mining — нетривиальность разыскиваемых шаблонов. Это означает, что найденные шаблоны должны отражать неочевидные, неожиданные (unexpected) регулярности в данных, составляющие, так называемые, скрытые знания (hidden knowledge). К

обществу пришло понимание, что сырые данные (raw data) содержат глубинный пласт знаний, при грамотной раскопке которого могут быть обнаружены настоящие самородки.

СЛАЙД №9

2. Информационные технологии анализа данных

Агентство Gartner Group, занимающееся анализом рынков информационных технологий, в

1980-х годах ввело термин «Business Intelligence» (BI), деловой интеллект или бизнесинтеллект. Этот термин предложен для описания различных концепций и методов, которые

улучшают бизнес решения путем использования систем поддержки принятия решений. В 1996

году агентство уточнило определение данного термина.

Business Intelligence (BI) – программные средства, функционирующие в рамках предприятия и

обеспечивающие функции доступа и анализа информации, которая находится в хранилище

данных, а также обеспечивающие принятие правильных и обоснованных управленческих решений.

BI-системы также известны под названием Систем Поддержки Принятия Решений (СППР, DSS,

Decision Support System). Эти системы превращают данные в информацию, на основе которой

можно принимать решения, т.е. поддерживающую принятие решений.

Gartner Group определяет состав рынка систем Business Intelligence как набор программных

продуктов следующих классов:

Средства построения хранилищ данных (data warehousing, ХД);

Системы оперативной аналитической обработки (OLAP);

Информационно-аналитические системы (Enterprise Information Systems, EIS);

Средства интеллектуального анализа данных (data mining);

Инструменты для выполнения запросов и построения отчетов (query and reporting tools).

Классификация Gartner базируется на методе функциональных задач, где программные продукты каждого класса выполняют определенный набор функций или операций с использованием специальных технологий.

СЛАЙД №10

Первичная обработка источников информации (для структурированных источников [по

соответствующим критериям}; для неструктурированных источников [индексирование; неисключающая рубрикация; морфологический, лексикографический, синтаксический и логикосимантический анализы; обновление в тезаурусе предметной области]):

Структурированные источники:

5

Неструктурированные источники:

СЛАЙД №11

Идентификация информационных объектов (позволяет выявить сходные информационные

объекты, полученные из различных источников {связи похожести [набор ключевых атрибутов] и

связи совпадения [обрабатываются специалистом-аналитиком]})

Извлечение знаний

Контекстный анализ (выявить ключевые объекты анализа, скрытые и косвенные связи,

выбранного объекта или группы объектов)

Ситуативный анализ (выявить в массиве фактографической информации неявные закономерности, получая, таким образом, качественно новые знания)

Поиск цепочек связей (позволяет автоматически выполнить проверку экспертных

предположений о том, что объекты имеют связь)

Нечёткий поиск (позволяет задать сразу несколько критериев по текстам, по рубрикам,

по атрибутам документов и скомбинировать их в запрос любой сложности)

6

Полнотекстовый поиск похожих документов (позволяет выполнить отбор в массиве фактографической информации фрагментов, аналогичных или похожих на описание ситуации на естественном языке)

Мониторинг фактографической информации

Автоматизированное ведение досье на объект (построение досье на некоторый информационный объект, если выявляются связи, то новые объекты добавляются автоматически)

Мониторинг ситуации в соответствии с их типологиями (используется для проверки

построенных досье на соответствие стандартным типологиям)

СЛАЙД №12

3. Технология добычи данных

Развитие методов записи и хранения данных привело к бурному росту объемов собираемой и

анализируемой информации. Объемы данных настолько внушительны, что человеку просто не

по силам проанализировать их самостоятельно, хотя необходимость проведения такого анализа вполне очевидна, ведь в этих «сырых» данных заключены знания, которые могут быть использованы при принятии решений. Для того, чтобы провести автоматический анализ данных,

используется Data Mining.

Data Mining – это процесс обнаружения в «сырых» данных ранее неизвестных нетривиальных

практически полезных и доступных интерпретации знаний, необходимых для принятия решений в различных сферах человеческой деятельности. Data Mining является одним из шагов

Knowledge Discovery in Databases.

Информация, найденная в процессе применения методов Data Mining, должна быть нетривиальной и ранее неизвестной, например, средние продажи не являются таковыми. Знания

должны описывать новые связи между свойствами, предсказывать значения одних признаков на основе других и т.д. Найденные знания должны быть применимы и на новых данных

с некоторой степенью достоверности. Полезность заключается в том, что эти знания могут

приносить определенную выгоду при их применении. Знания должны быть в понятном для

пользователя не математика виде. Например, проще всего воспринимаются человеком логические конструкции «если … то …». Более того, такие правила могут быть использованы в различных СУБД в качестве SQL-запросов. В случае, когда извлеченные знания непрозрачны для

пользователя, должны существовать методы постобработки, позволяющие привести их к интерпретируемому виду.

Алгоритмы, используемые в Data Mining, требуют большого количества вычислений. Раньше

это являлось сдерживающим фактором широкого практического применения Data Mining, однако сегодняшний рост производительности современных процессоров снял остроту этой проблемы. Теперь за приемлемое время можно провести качественный анализ сотен тысяч и

миллионов записей.

Задачи, решаемые методами Data Mining:

1. Классификация – это отнесение объектов (наблюдений, событий) к одному из заранее известных классов.

2. Регрессия, в том числе задачи прогнозирования. Установление зависимости непрерывных

выходных от входных переменных.

3. Кластеризация – это группировка объектов (наблюдений, событий) на основе данных

(свойств), описывающих сущность этих объектов. Объекты внутри кластера должны быть

"похожими" друг на друга и отличаться от объектов, вошедших в другие кластеры. Чем

7

больше похожи объекты внутри кластера и чем больше отличий между кластерами, тем

точнее кластеризация.

4. Ассоциация – выявление закономерностей между связанными событиями. Примером такой закономерности служит правило, указывающее, что из события X следует событие Y.

Такие правила называются ассоциативными. Впервые эта задача была предложена для

нахождения типичных шаблонов покупок, совершаемых в супермаркетах, поэтому иногда

ее еще называют анализом рыночной корзины (market basket analysis).

5. Последовательные шаблоны – установление закономерностей между связанными во

времени событиями, т.е. обнаружение зависимости, что если произойдет событие X, то

спустя заданное время произойдет событие Y.

6. Анализ отклонений – выявление наиболее нехарактерных шаблонов.

Проблемы бизнес анализа формулируются по-иному, но решение большинства из них сводится к той или иной задаче Data Mining или к их комбинации. Например, оценка рисков – это решение задачи регрессии или классификации, сегментация рынка – кластеризация, стимулирование спроса – ассоциативные правила. Фактически, задачи Data Mining являются элементами, из которых можно собрать решение подавляющего большинства реальных бизнес задач.

Для решения вышеописанных задач используются различные методы и алгоритмы Data Mining.

Ввиду того, что Data Mining развивалась и развивается на стыке таких дисциплин, как статистика, теория информации, машинное обучение, теория баз данных, вполне закономерно, что

большинство алгоритмов и методов Data Mining были разработаны на основе различных методов из этих дисциплин. Например, процедура кластеризации k-means была просто заимствована из статистики. Большую популярность получили следующие методы Data Mining: нейронные

сети, деревья решений, алгоритмы кластеризации, в том числе и масштабируемые, алгоритмы

обнаружения ассоциативных связей между событиями и т.д.

Data Mining является аналитической платформой, в которую включен полный набор инструментов для решения задач: линейная регрессия, нейронные сети с учителем, нейронные сети

без учителя, деревья решений, поиск ассоциативных правил и множество других. Для многих

механизмов предусмотрены специализированные визуализаторы, значительно облегчающие

использование полученной модели и интерпретацию результатов. Сильной стороной платформы является не только реализация современных алгоритмов анализа, но и обеспечение

возможности произвольным образом комбинировать различные механизмы анализа.

СЛАЙД №13

4. Классы систем Data Mining

Data Mining является мультидисциплинарной областью, возникшей и развивающейся на базе

достижений прикладной статистики, распознавания образов, методов искусственного интеллекта, теории баз данных и др. Отсюда обилие методов и алгоритмов, реализованных в различных действующих системах Data Mining. Многие из таких систем интегрируют в себе сразу

несколько подходов. Тем не менее, как правило, в каждой системе имеется какая-то ключевая

компонента, на которую делается главная ставка.

Предметно-ориентированные аналитические системы очень разнообразны. Наиболее широкий подкласс таких систем, получивший распространение в области исследования финансовых рынков, носит название "технический анализ". Он представляет собой совокупность нескольких десятков методов прогноза динамики цен и выбора оптимальной структуры инвестиционного портфеля, основанных на различных эмпирических моделях динамики рынка. Эти

методы часто используют несложный статистический аппарат, но максимально учитывают

сложившуюся своей области специфику (профессиональный язык, системы различных индексов и пр.). На рынке имеется множество программ этого класса. Как правило, они довольно

дешевы (обычно $300–1000).

8

Статистические пакеты. Последние версии почти всех известных статистических пакетов

включают наряду с традиционными статистическими методами также элементы Data Mining. Но

основное внимание в них уделяется все же классическим методикам — корреляционному, регрессионному, факторному анализу и другим. Самый свежий детальный обзор пакетов для статистического анализа приведен на страницах Центрального экономико-математического института http://is1.cemi.rssi.ru/ruswin/publication/ep97001t.htm.

Недостатком систем этого класса считают требование к специальной подготовке пользователя.

Также отмечают, что мощные современные статистические пакеты являются слишком "тяжеловесными" для массового применения в финансах и бизнесе. К тому же часто эти системы

весьма дороги — от $1000 до $15000.

Есть еще более серьезный принципиальный недостаток статистических пакетов, ограничивающий их применение в Data Mining. Большинство методов, входящих в состав пакетов опираются на статистическую парадигму, в которой главными фигурантами служат усредненные характеристики выборки. А эти характеристики, как указывалось выше, при исследовании реальных сложных жизненных феноменов часто являются фиктивными величинами. В качестве

примеров наиболее мощных и распространенных статистических пакетов можно назвать SAS

(компания SAS Institute), SPSS (SPSS), STATGRAPICS (Manugistics), STATISTICA, STADIA и

другие.

СЛАЙД №14

Нейронные сети. Это большой класс систем, архитектура которых имеет аналогию (как теперь

известно, довольно слабую) с построением нервной ткани из нейронов. В одной из наиболее

распространенных архитектур, многослойном перцептроне с обратным распространением

ошибки, имитируется работа нейронов в составе иерархической сети, где каждый нейрон более высокого уровня соединен своими входами с выходами нейронов нижележащего слоя. На

нейроны самого нижнего слоя подаются

значения входных параметров, на основе которых нужно принимать какие-то

решения, прогнозировать развитие ситуации и т. д. Эти значения рассматриваются как сигналы, передающиеся в

следующий слой, ослабляясь или усиливаясь в зависимости от числовых значений (весов), приписываемых межнейронным связям. В результате на выходе нейрона самого верхнего слоя вырабатывается некоторое значение, которое рассматривается как ответ — реакция всей сети на введенные значения

входных параметров. Для того чтобы

сеть можно было применять в дальнейшем, ее прежде надо "натренировать" на полученных

ранее данных, для которых известны и значения входных параметров, и правильные ответы на

них. Тренировка состоит в подборе весов межнейронных связей, обеспечивающих наибольшую

близость ответов сети к известным правильным ответам.

Основным недостатком нейросетевой парадигмы является необходимость иметь очень большой объем обучающей выборки. Другой существенный недостаток заключается в том, что даже натренированная нейронная сеть представляет собой черный ящик. Знания, зафиксированные как веса нескольких сотен межнейронных связей, совершенно не поддаются анализу и интерпретации человеком (известные попытки дать интерпретацию структуре настроенной

нейросети выглядят неубедительными – система “KINOsuite-PR”). Примеры нейросетевыхсистем — BrainMaker (CSS), NeuroShell (Ward Systems Group), OWL (HyperLogic).

9

Системы рассуждений на основе аналогичных случаев. Идея систем case based reasoning

— CBR — на первый взгляд крайне проста. Для того чтобы сделать прогноз на будущее или

выбрать правильное решение, эти системы находят в прошлом близкие аналоги наличной ситуации и выбирают тот же ответ, который был для них правильным. Поэтому этот метод еще

называют методом "ближайшего соседа" (nearest neighbour). В последнее время распространение получил также термин memory based reasoning, который акцентирует внимание, что решение принимается на основании всей информации, накопленной в памяти.

Системы CBR показывают неплохие результаты в самых разнообразных задачах. Главным их

минусом считают то, что они вообще не создают каких-либо моделей или правил, обобщающих

предыдущий опыт, — в выборе решения они основываются на всем массиве доступных исторических данных, поэтому невозможно сказать, на основе каких конкретно факторов CBR системы строят свои ответы.

Другой минус заключается в произволе, который допускают системы CBR при выборе меры

"близости". От этой меры самым решительным образом зависит объем множества прецедентов, которые нужно хранить в памяти для достижения удовлетворительной классификации или

прогноза [7]. Примеры систем, использующих CBR, — KATE tools (Acknosoft, Франция), Pattern

Recognition Workbench (Unica, США).

СЛАЙД №15

Деревья решений (decision trees). Деревья решения являются одним из наиболее популярных подходов к решению задач Data Mining. Они создают иерархическую структуру классифицирующих правил типа «ЕСЛИ... ТО...» (if-then), имеющую вид дерева. Для принятия решения,

к какому классу отнести некоторый объект или ситуацию, требуется ответить на

вопросы, стоящие в узлах этого дерева,

начиная с его корня. Вопросы имеют вид

"значение параметра A больше x?". Если ответ положительный, осуществляется переход к правому узлу следующего

уровня, если отрицательный — то к левому узлу; затем снова следует вопрос,

связанный с соответствующим узлом.

Популярность подхода связана как бы с

наглядностью и понятностью. Но деревья решений принципиально не способны находить “лучшие” (наиболее полные

и точные) правила в данных. Они реализуют наивный принцип последовательного просмотра признаков и “цепляют” фактически

осколки настоящих закономерностей, создавая лишь иллюзию логического вывода.

Вместе с тем, большинство систем используют именно этот метод. Самыми известными являются See5/С5.0 (RuleQuest, Австралия), Clementine (Integral Solutions, Великобритания), SIPINA

(University of Lyon, Франция), IDIS (Information Discovery, США), KnowledgeSeeker (ANGOSS, Канада). Стоимость этих систем варьируется от 1 до 10 тыс. долл.

Эволюционное программирование. Проиллюстрируем современное состояние данного подхода на примере системы PolyAnalyst — отечественной разработке, получившей сегодня общее признание на рынке Data Mining. В данной системе гипотезы о виде зависимости целевой

переменной от других переменных формулируются в виде программ на некотором внутреннем

языке программирования. Процесс построения программ строится как эволюция в мире программ (этим подход немного похож на генетические алгоритмы). Когда система находит программу, более или менее удовлетворительно выражающую искомую зависимость, она начина-

10

ет вноситьв нее небольшие модификации и отбирает среди построенных дочерних программ

те, которые повышают точность. Таким образом система "выращивает" несколько генетических

линий программ, которые конкурируют между собой в точности выражения искомой зависимости. Специальный модуль системы PolyAnalyst переводит найденные зависимости с внутреннего языка системы на понятный пользователю язык (математические формулы, таблицы и пр.).

Другое направление эволюционного программирования связано с поиском зависимости целевых переменных от остальных в форме функций какого-то определенного вида. Например, в

одном из наиболее удачных алгоритмов этого типа — методе группового учета аргументов

(МГУА) зависимость ищут в форме полиномов. В настоящее время из продающихся в России

систем МГУА реализован в системе NeuroShell компании Ward Systems Group. Стоимость систем до $ 5000.

Генетические алгоритмы. Data Mining не основная область применения генетических алгоритмов. Их нужно рассматривать скорее как мощное средство решения разнообразных комбинаторных задач и задач оптимизации. Тем не менее генетические алгоритмы вошли сейчас в

стандартный инструментарий методов Data Mining, поэтому они и включены в данный обзор.

Первый шаг при построении генетических алгоритмов — это кодировка исходных логических

закономерностей в базе данных, которые именуют хромосомами, а весь набор таких закономерностей называют популяцией хромосом. Далее для реализации концепции отбора вводится

способ сопоставления различных хромосом. Популяция обрабатываетсяс помощью процедур

репродукции, изменчивости (мутаций), генетической композиции. Эти процедуры имитируют

биологические процессы. Наиболее важные среди них: случайные мутации данных в индивидуальных хромосомах, переходы (кроссинговер) и рекомбинация генетического материала, содержащегося в индивидуальных родительских хромосомах (аналогично гетеросексуальной репродукции), и миграции генов. В ходе работы процедур на каждой стадии эволюции получаются популяции со все более совершенными индивидуумами.

Генетические алгоритмы удобны тем, что их легко распараллеливать. Например, можно разбить поколение на несколько групп и работать с каждой из них независимо, обмениваясь время

от времени несколькими хромосомами. Существуют также и другие методы распараллеливания генетических алгоритмов.

Генетические алгоритмы имеют ряд недостатков. Критерий отбора хромосом и используемые

процедуры являются эвристическими и далеко не гарантируют нахождения “лучшего” решения.

Как и в реальной жизни, эволюцию может “заклинить” на какой-либо непродуктивной ветви. И,

наоборот, можно привести примеры, как два неперспективных родителя, которые будут исключены из эволюции генетическим алгоритмом, оказываются способными произвести высокоэффективного потомка. Это особенно становится заметно при решении высокоразмерных задач

со сложными внутренними связями. Примером может служить система GeneHunter фирмы

Ward Systems Group. Его стоимость — около $1000.

Алгоритмы ограниченного перебора. Алгоритмы ограниченного перебора были предложены

в середине 60-х годов М.М. Бонгардом для поиска логических закономерностей в данных. С тех

пор они продемонстрировали свою эффективность при решении множества задач из самых

различных областей.

Эти алгоритмы вычисляют частоты комбинаций простых логических событий в подгруппах данных. Примеры простых логических событий: X = a; X < a; X > a; a < X < b и др., где X — какой

либо параметр, “a” и “b” — константы. Ограничением служит длина комбинации простых логических событий (у М. Бонгарда она была равна 3). На основании анализа вычисленных частот

делается заключение о полезности той или иной комбинации для установления ассоциации в

данных, для классификации, прогнозирования и пр.

11

Наиболее ярким современным представителем этого подхода является система WizWhy предприятия WizSoft. Хотя автор системы Абрахам Мейдан не раскрывает специфику алгоритма,

положенного в основу работы WizWhy, по результатам тщательного тестирования системы

были сделаны выводы о наличии здесь ограниченного перебора (изучались результаты, зависимости времени их получения от числа анализируемых параметров и др.).

Автор WizWhy утверждает, что его система обнаруживает ВСЕ логические if-then правила в

данных. На самом деле это, конечно, не так. Во-первых, максимальная длина комбинации в ifthen правиле в системе WizWhy равна 6, и, во-вторых, с самого начала работы алгоритма производится эвристический поиск простых логических событий, на которых потом строится весь

дальнейший анализ. Поняв эти особенности WizWhy, нетрудно было предложить простейшую

тестовую задачу, которую система не смогла вообще решить. Другой момент — система выдает решение за приемлемое время только для сравнительно небольшой размерности данных.

Тем не менее, система WizWhy является на сегодняшний день одним из лидеров на рынке

продуктов Data Mining. Это не лишено оснований. Система постоянно демонстрирует более

высокие показатели при решении практических задач, чем все остальные алгоритмы. Стоимость системы около $ 4000, количество продаж — 30000.

СЛАЙД №16

Системы для визуализации многомерных данных. В той или иной мере средства для графического отображения данных поддерживаются всеми системами Data Mining. Вместе с тем,

весьма внушительную долю рынка занимают системы, специализирующиеся исключительно на

этой функции. Примером здесь может служить программа DataMiner 3D словацкой фирмы

Dimension5 (5-е измерение).

В подобных системах основное внимание

сконцентрировано на дружелюбности

пользовательского интерфейса, позволяющего ассоциировать с анализируемыми показателями различные параметры диаграммы рассеивания объектов

(записей) базы данных. К таким параметрам относятся цвет, форма, ориентация

относительно собственной оси, размеры

и другие свойства графических элементов изображения. Кроме того, системы

визуализации данных снабжены удобными средствами для масштабирования и

вращения изображений. Стоимость систем визуализации может достигать нескольких сотен долларов.

СЛАЙД №17

5. Перспективы систем Data Mining

Потенциал Data Mining дает «зеленый свет» для расширения границ применения технологии.

Относительно перспектив Data Mining возможны следующие направления развития:

Выделение типов предметных областей с соответствующими им эвристиками, формализация которых облегчит решение соответствующих задач Data Mining, относящихся к этим

областям;

Создание формальных языков и логических средств, с помощью которых будет формализованы рассуждения и автоматизация которых станет инструментом решения задач

Data Mining в конкретных предметных областях;

12

Создание методов Data Mining, способных не только извлекать из данных закономерности,

но и формировать некие теории, опирающиеся на эмпирические данные;

Преодоление существенного отставания возможностей инструментальных средств Data

Mining от теоретических достижений в этой области.

Если рассматривать будущее Data Mining в краткосрочной перспективе, то очевидно, что развитие этой технологии наиболее направлено к областям, связанным с бизнесом.

В краткосрочной перспективе продукты Data Mining могут стать такими же обычными и необходимыми, как электронная почта, и, например, использоваться пользователями для поиска самых низких цен на определенный товар или наиболее дешевых билетов.

В долгосрочной перспективе будущее Data Mining является действительно захватывающим это может быть поиск интеллектуальными агентами как новых видов лечения различных заболеваний, так и нового понимания природы вселенной.

Однако Data Mining таит в себе и потенциальную опасность - ведь все большее количество

информации становится доступным через всемирную сеть, в том числе и сведения частного

характера, и все больше знаний возможно добыть из нее:

Не так давно крупнейший онлайновый магазин «Amazon» оказался в центре скандала по поводу полученного им патента «Методы и системы помощи пользователям при покупке товаров»,

который представляет собой не что иное как очередной продукт Data Mining, предназначенный

для сбора персональных данных о посетителях магазина. Новая методика позволяет прогнозировать будущие запросы на основании фактов покупок, а также делать выводы об их назначении. Цель данной методики - получение как можно большего количества информации о клиентах, в том числе и частного характера (пол, возраст, предпочтения и т.д.). Таким образом, собираются данные о частной жизни покупателей магазина, а также членах их семей, включая

детей. Последнее запрещено законодательством многих стран – сбор информации о несовершеннолетних возможен там только с разрешения родителей.

Исследования отмечают, что существуют как успешные решения, использующие Data Mining,

так и неудачный опыт применения этой технологии. Области, где применения технологии Data

Mining, скорее всего, будут успешными, имеют такие особенности:

Требуют решений, основанных на знаниях;

Имеют изменяющуюся окружающую среду;

Имеют доступные, достаточные и значимые данные;

Обеспечивают высокие дивиденды от правильных решений.