Научные основы информатики

реклама

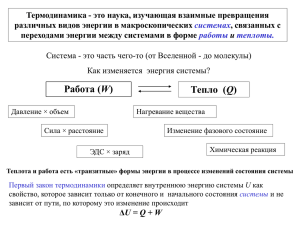

Научные основы информатики Материя Материя - это то, что составляет мир. Материя бывает двух видов (во всяком случае пока науке известно только два вида материи): вещество и поле. Вещество - это все то, что состоит из элементарных частиц (протонов, электронов и прочих), а значит, всё состоящее из атомов и молекул: звезды, планеты, воздух, человек, камень… Поле - это то, что не состоит из молекул и элементарных частиц. Пока известны такие поля: электромагнитное (свет, радиоволны…), гравитационное (обеспечивающее притяжение между телами), слабое поле и сильное (ядерное) поле. Материя Вещество Поле Энергия Понятие «энергия» характеризует движение и изменение материи. Говорить об энергии можно лишь в тех случаях, когда с материей что-нибудь происходит или может произойти (в последнем случае говорят о потенциальной энергии). Энергией обладают летящая пуля и нагретая вода, свет и электрический ток, вода, собранная в водохранилище гидроэлектростанции, и мускулы человека. С любой материей связана некоторая энергия. Не бывает материи, которая бы не обладала энергией. Приведем пример. При нагревании воды не происходит изменения молекул воды. Вода, как вещество, не изменяется. Но увеличивается скорость движения молекул. Поэтому увеличивается внутренняя энергия воды. Важным свойством энергии является то, что она не исчезает и не появляется «ниоткуда». Она только переходит от одного тела к другому. Этот факт носит название закона сохранения энергии. Информация В обычной речи мы используем понятие «информация» для обозначения некоторого сообщения, новости, рассказа. Однако с научной точки зрения информация - нечто совсем иное. Информация - это то, что определяет строение, внутреннее устройство, структуру тел, объектов, явлений, событий, процессов... Например, графит, алмаз и сажа с точки зрения вещества совершенно одинаковы: все они состоят из атомов углерода. Однако их свойства совершенно разные и определяются их строением : • графит - это кристаллическое вещество, мягкое настолько, что его используют, как смазку; • алмаз - это кристаллическое вещество, самое твердое из природных; • сажа - аморфный порощок. Три кита Материя, энергия и информация - три «кита», три ипостаси, лежащие в основе нашего мира. Действительно, какой бы объект Вселенной мы ни взяли, он состоит из какого-либо вида материи. Любой объект Вселенной находится в непрерывном движении и изменении, что характеризуется энергией. И, наконец, любой объект имеет некоторое строение, внутреннюю структуру, то есть несет в себе информацию. Информация и энтропия Информация (как и материя и энергия) это первичное, неопределяемое понятие. Дать его строгое определение невозможно. Тем не менее, его можно объяснить, проиллюстрировать примерами, рассказать о его свойствах. Выяснилось, что понятие информации тесно связано с понятием энтропии, которое физики широко используют в молекулярной физике и термодинамике. А для понимания энтропии надо знать понятие вероятности события. Выпадения орла и решки при бросании монеты равновероятны. Говорят, что вероятность орла 50% или 1/2. Это означает, что из двух бросаний вероятнее всего, что орел выпадет 1 раз. При бросании кубика, на гранях которого написаны числа от 1 до 6 вероятность выпадения 1 равна 1/6, то есть из 6-ти бросаний наиболее вероятно, что только в одном выпадет 1. Ясно, что вероятность выпадения орла (1/2) больше вероятности выпадения единицы при бросании кубика (1/6). Энтропия - что это? Понятие энтропии рассмотрим на примере газов. Всем известна “аксиома": газ занимает весь предоставленный ему объем. А почему? Как это объясняет молекулярно-кинетическая теория? Рассмотрим сосуд, состоящий из двух равных объемов, содержащий две молекулы газа. Молекулы движутся хаотично, поэтому в некоторый момент времени может реализоваться одна из четырех возможностей: 1 1 2 2 1 1 2 2 Последние два случая физически неразличимы, так как молекулы неразличимо одинаковы. Вероятность того, что в некоторый момент времени обе молекулы окажутся в левой части сосуда составляет 1 из 4, т.е. 1/4=0,25. А вероятность того, что в каждой части будет по молекуле - 2 из 4, т.е. 2/4=0,5 - в два раза больше, чем в предыдущем случае. Таким образом, равномерное распределение двух молекул по сосуде в два раза более вероятно, чем неравномерное. Распределение трех молекул Но может быть это только для двух молекул? Рассмотрим сосуд с тремя молекулами. Вероятность того, что молекулы случайно соберутся в левой части сосуда равна 1/8=0,125 (меньше, чем в случае с двумя молекулами), а вероятность более или менее равномерного распределения равна 6/8=0,75 (больше, чем в случае двух молекул). Эта тенденция, очевидно, сохраниться и для большего числа молекул. Вывод: чем больше молекул газа, тем больше вероятность того, что они равномерно распределяться по всему объему сосуда. Второй закон термодинамики Для реального сосуда с газом с огромным количеством молекул почти невероятно (хотя теоретически и возможно), чтобы все молекулы сами собой, вследствие хаотичности своего движения собрались в одной половине сосуда. Второй закон термодинамики гласит: система стремится перейти в наиболее вероятное состояние, то есть такое, где частицы расположены равномерно, хаотично, беспорядочно. Энтропия - мера беспорядка! Мерой «беспорядка» является энтропия. Она обозначается буквой S. S=k*ln(W) , где k=1,38*10-23 Дж/К постоянная Больцмана, W - вероятность данного положения частиц, а ln(W) логарифм вероятности. Используя понятие энтропии, второй закон термодинамики можно сформулировать так: в замкнутой системе энтропия возрастает (так как система переходит в состояние с большей вероятностью W). Уменьшение энтропии Энтропию можно уменьшить (увеличить упорядоченность системы) только затратив энергию, взятую извне системы. Например, чтобы расположить все молекулы в левой половине сосуда, надо взять перегородку и передвинуть ее. Проделав это, мы одновременно получим информацию о расположении молекул: до того мы могли лишь с той или иной степенью вероятности предполагать, где находятся молекулы, сейчас же мы точно знаем, что все молекулы - в левой половине сосуда. Негэнтропийный принцип Таким образом, уменьшение энтропии означает увеличение информации о системе. Энтропия и информация взаимодополняющие, дуальные величины. Бриллюэн сформулировал негэнтропийный принцип: обозначим количество информации через I, тогда I*S=const или I const S Если энтропия S - мера беспорядка в системе, то информация I - мера упорядоченности. Второй закон термодинамики Наибольшей энтропии (беспорядку) соответствует минимальная информация и наоборот, нулевой энтропии (полной упорядоченности) соответствует полная информация о системе. Количество информации возрастает по мере упорядочивания системы, но для этого надо затратить энергию. И наоборот, по мере увеличения беспорядка, хаоса мы теряем информацию о расположении частиц, о связях между ними. Негэнтропийный принцип позволяет сформулировать второе начало термодинамики в терминах информации так: в замкнутой системе информация теряется (уменьшается, рассеивается), для увеличения (получения) информации надо затратить энергию (провести новые измерения). Информация теряется В замкнутой системе информация теряется (уменьшается, рассеивается), для увеличения (получения) информации надо затратить энергию (провести новые измерения). Такая формулировка второго закона термодинамики подтверждается даже простой бытовой жизнью: если не прикладывать никаких усилий, то дома наступает беспорядок, вещи теряются, поскольку теряется информация об их положении. Для увеличения информации надо затратить энергию - прибраться. Это упорядочит систему. Другой пример потери информации: пусть информация - это текст на листе бумаги. С течением времени происходит диффузия молекул краски и молекул бумаги - их перемешивание. Через некоторое время (конечно, очень большое) краска равномерно распределится по всей бумаге. Конец