Выше, больше, чаще (сравнение выборок)

реклама

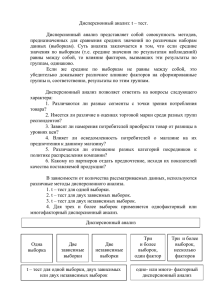

Биостатистика 4. Сравнение выборок Рубанович А.В. Институт общей генетики им. Н.И. Вавилова РАН Сравнение средних Самая первая и основная задача - сравнение средних для двух выборок. Например, рост в выборках «М» и «Ж»: Кроме таблицы надо посмотреть все иллюстрации различий: Plot of Means and Conf. Intervals (95,00%) Рост 180 Categ. Box & Whisker Plot: 175 Рост 200 170 180 Values 165 Histogram: Рост Пол: M Рост = 34*10*normal(x; 167,6657; 19,3972) Пол: Ж Рост = 66*10*normal(x; 148,7613; 16,5892) 160 160 22 20 Рост 155 150 18 140 16 14 145 120 No of obs 12 140 Ж M Пол 100 Рост 10 8 6 80 Ж M Пол Median 25%-75% Min-Max 4 2 0 90 110 100 130 120 150 140 170 160 190 180 210 200 90 110 100 Пол: M 130 120 150 140 170 160 190 180 210 200 Пол: Ж Рост Нулевая гипотеза состоит в предположении, что обе выборки изъяты из одной генеральной совокупности (т.е. различий нет): Н0: x1 x 2 Н1: x1 x 2 (двусторонний тест) Дальше надо предложить способ оценить вероятность ошибки I рода Сравнение средних На прошлом занятии мы рассмотрели достаточно универсальный способ построения статистических критериев: Z – статистика, т.е. Z / Z x1 x 2 x x 1 , т.е. разность средних, деленная на стандартное отклонение этой разности. 2 Есть надежда, что эта величина имеет нормальное распределение со средним 0 и дисперсией 1. Так оно и есть, но только при больших объемах выборок! x x 2 Для не очень больших выборок распределение величины t 1 x1 x 2 следует распределению Стьюдента. Это распределение случайной величины, равной t 0 1 2 (1 22 ... k2 ) k , где все i - нормальны k – число степеней свободы Вильям Стьюдент (Госсет) (1876-1936) Работал на пивоваренном заводе Гиннесса Опубликовал «распределение Стьюдента» в 1908 г. Сравнение средних Распределение Стьюдента очень похоже на нормальное, но имеет большую дисперсию: D(t) = k/(k-2) > 1 При k∞ становится нормальным 2 означает, что тест двусторонний Excel умеет вычислять «хвосты» распределения Стьюдента: 0.048 = СТЬЮДРАСП(2; 100; 2) Сравнение средних 3 варианта использования теста Стьюдента: Сравнение выборочного среднего с известным числом Сравнение двух зависимых выборок Для каждой особи проводят 2 однотипных замера: - до и после приема лекарства, - в этом году и в прошлом году и т.д. Сравнение двух выборочных средних для независимых выборок Упражняемся … 15 октября 2011 г. президент Д. Медведев сообщил, что средняя продолжительность жизни в РФ составляет 69 лет Эта запись означает, что наша величина имеет Стьюдентаи сполучена другая В этом месяце в районном моргераспределение побывало 100 клиентов, n-1оценка степенями свободы оценка: 623 года. Отличается ли эта от средней по стране? 2 означает, что тест x x x Вычисляем величину двусторонний ~ t (n 1) x SE / n Р = 0.022 = СТЬЮДРАСП((69-62)/3; 100-1; 2) Вывод: нулевая гипотеза отвергается. Вероятность того, что при этом отвергли правильную нулевую гипотезу равна 0.022 (ошибка I рода). Выборка по данным районного морга не соответствует среднему по стране. Различия статистически значимы. Никогда не пишите, что различия достоверны! Достоверно это то, что происходит с вероятностью 1 В данном примере среднее для одной выборки сравнивалось с заранее известной величиной. Это так называемый одновыборочный тест (мы это уже делали: помните 470 из 1000?) Сравнение средних в случае зависимых выборок Это простой случай. Вычисляется t-статистика t x1 x 2 x x 1 2 x1 x 2 SE12 SE22 и вес хвостов распределения Стьюдента с n1+n2-2 степенями свободы. Можно ни о чем этом не думать и использовать =ТТЕСТ(массив1; массив2; 2; 1) 2 означает, что тест 1 означает, что двусторонний выборки зависимы Для независимых выборок все несколько сложнее… Сравнение средних в случае независимых выборок При сравнении средних двух независимых выборок возможны 2 ситуации: 1 = 2 , т.е. изменчивость данных в обеих выборках одинакова Тогда все просто: вычисляется статистика t x1 x 2 SE SE 2 1 2 2 ~ t (n1 n2 2) 1 ≠ 2 , т.е. изменчивость данных в выборках неодинакова, и эти различия статистически значимы. Тогда вычисляется объединенная дисперсия для двух выборок. Число степеней свободы тоже модифицируется. В Excel это делается так: =ТТЕСТ(массив1; массив2; 2; 2) 2 означает, что тест двусторонний 2 - 1 = 2 3 - 1 ≠ 2 Excel при этом не проверяет статистическую значимость 1 ≠ 2 . Более адекватно в STATISTICA: Сравнение средних c помощью программы STATISTICA Случай равных дисперсий Дисперсии выборок значимо не различаются Сравнение средних c помощью программы STATISTICA Случай неравных дисперсий Дисперсии выборок значимо различаются Сравнение дисперсий Р. Фишер построил критерий (односторонний) для сравнения дисперсий (F-тест) и вычислил функцию распределения соответствующей статистики. 22 F 2 1 (большая на меньшую), F- распределение имеет 2 параметра: df1 = n1-1, df2 = n2-1 В Excel имеется функция, вычисляющая это распределение Можно также сравнить дисперсии двух выборок Н0: 1 = 2 против Н1: 1 < 2 =FРАСП(1,5;100;100) = 0.022 =ФТЕСТ(массив1; массив2) Не путайте статистику (критерий) Фишера с точным тестом Фишера! Сравнение нескольких выборок Дисперсионный анализ (ANOVA) – сравнение нескольких выборок: средняя дисперсия vs дисперсии средних Среднее Дисперсия Рассмотрим набор k выборок: (при k = 2 все сведется к критерию Стьюдента) Выборка 1 Выборка 2 ………. Р. Фишер показал, что Выборка k 2 W2 B2 Все выборки x1 x2 … xk x 12 22 … k2 2 т.е. дисперсию объединенной выборки можно разложить на сумму средней дисперсии внутри выборок ( W2 ) и межвыборочную дисперсию ( B2): k 2 Средняя дисперсия Внутривыборочная изменчивость Остаточная изменчивость i 1 k k 2 k (x i x) 2 i 1 k 2 Статистика F 2B W Ничего, кроме школьной алгебры! Дисперсия средних Межвыборочная изменчивость Факториальная изменчивость Сравнение нескольких выборок Дисперсионный анализ (ANOVA) – сравнение нескольких выборок: средняя дисперсия vs дисперсии средних Даты Выборка 2 x1 j x2 j x1 x2 12 22 ………. … … … Выборка 1 Объемы выборок равны n Среднее Дисперсия k xk xij 2 Все выборки x 2 ( xij x i )( x i x) xij x i x xij x i x x i Выборка k i, j i, j i - номер выборки, 2 i = 1, … , k 2 xkj i, j i, j i, j Номер даты в i-ой выборке, j = 1, 2 2, ... , n n xi n x xi n xi n x xi i i i i Могучий прием: xij x ( xij x i ) ( x i x) x x ( x x x ( x 2 ij ij x i ) 2 ( x i x) 2 2( xij x i )( x i x) ij x i ) 2 ( x i x) 2 2 ( xij x i )( x i x) 2 i, j ij i, j i, j i, j Сравнение нескольких выборок Дисперсионный анализ (ANOVA) – сравнение нескольких выборок: средняя дисперсия vs дисперсии средних Даты Выборка 2 x1 j x2 j x1 x2 12 22 ………. … … … Выборка k xkj Все выборки xij xk x k2 2 Выборка 1 Объемы выборок равны n Номер даты в i-ой выборке, j = 1, 2, ... , n i - номер выборки, i = 1, … , k x ij Среднее Дисперсия xij x ( xij x i ) ( x i x) x ( x x ) ( x x) 2( x x )( x x) x x ( x x ) ( x x ) 2 2 ij 2 i i ij 2 i, j ij 2 i, j ij i i i 2 i, j i SST SSW SS B Total Within Between - обозначения Фишера Сравнение нескольких выборок Дисперсионный анализ (ANOVA) – сравнение нескольких выборок: средняя дисперсия vs дисперсии средних SST SSW SSB или, как часто пишут: SS SS Err SS Factor Табличка Фишера: Source of Variation Degrees of Freedom Sum of Squares Mean Square F Between Groups k-1 SSB MSB = SSB./(k-1) MSB / MSW Within Groups n-k SSW MSW = SSW./(n-k) Total n-1 SSТ Статистика F MS B (число степеней свободы k-1, n-k) MSW Н0: x1 x 2 ... x k vs Н1: хотя бы одно среднее отличается F-статистика не дает указаний на то, в какой выборке среднее больше! Это одновременное сравнение совокупности выборок. «Разборки» со средними называются Post Hoc Tests Сравнение нескольких выборок (SPSS) Сравнение нескольких выборок (STATISTICA) Plot of Means and Conf. Intervals (95,00%) АберХр 0,9 Для нашей учебной базы данных сравним частоты аберраций хромосом для носителей различных генотипов по0,8локусу GSTP1 0,7 0,6 Values 0,5 0,4 0,3 0,2 0,1 0,0 -0,1 A/A A/G GSTP1_A313G Межгрупповая дисперсия в 12 раз выше, чем внутригрупповая G/G АберХр Сравнение нескольких выборок (STATISTICA) Для нашей учебной базы данных сравним частоты аберраций хромосом для носителей различных генотипов по локусу GSTP1 Важное предупреждение t-тест (Стьюдента) F-тест (Фишера) Дисперсионный анализ только для нормально распределенных данных! (особенно при небольших выборках) В противном случае можно получить совершенно абсурдный результат: Средние Фирма 1 Фирма 2 100 120 100 120 100 120 100 120 110 120 110 500 103.3 183.3 В какой фирме зарплата выше? =ТТЕСТ(массив1; массив2; 2; 3) Р = 0.235 Эти средние значимо не различаются по тесту Стьюдента! Вспомните «мажорирующие выборки»: 6!6! p2 0.0022 12! На этом примере видно, что в ряде случаев надо сравнивать не сами данные, а их порядковые ранги (номера в последовательности) Ранговые статистики Данные Средние Ранги Фирма 1 Фирма 2 Фирма 1 Фирма 2 100 120 1 7 100 120 2 8 100 120 3 9 100 120 4 10 110 120 5 11 110 500 6 12 103.3 183.3 3.5 9.5 0.0002 =ТТЕСТ(массив1; массив2; 2; 2) Другое дело! Хотя и это некорректно… Ранговые критерии Ранговые критерии являются непараметрическими, т.е. такими, которые не зависят от характера распределения данных. В частности они нечувствительны к выбросам отдельных точек Самый простой тест – критерий знаков для пары зависимых выборок Плацебо Лекарство Разность 105 120 + 110 115 + 120 110 - 103 125 + 115 120 + 121 134 + 107 110 + 114 117 + 1 минус из 8 Приводит ли лекарство к увеличению систолического давления? 0.035 =БИНОМРАСП(1;8;0,5;1) Различия значимы по одностороннему тесту (но не по двустороннему!) Ранговые критерии Для сравнения 2 независимых выборок используется тест Манна – Уитни, который основан на вычислении суммы рангов для каждой из выборок Как всегда Н0: выборки взяты из одной генеральной совокупности. Но что там с нормальностью? Упражняемся … Box & Whisker Plot: АберХр В нашем файле смотрим сопряженность заболевания с частотой аберраций Видим различия средних: 0,50 0,45 0,40 АберХр 0,35 0,30 0,25 0,20 0,15 0,10 0 1 Болезнь Mean ±SE ±1,96*SE Различия значимы по Стьюденту Проверяем значимость различий по Стьюденту: (независимо от условия равенства дисперсий ) Проверяем нормальность … Строим гистограммы распределений аберраций для больных и здоровых: Categ. Histogram: АберХр Болезнь: 0 АберХр = 52*0,1*normal(x; 0,1953; 0,2906) Болезнь: 1 АберХр = 47*0,1*normal(x; 0,3334; 0,3756) 30 28 Какая уж тут нормальностью! 26 24 22 20 No of obs 18 16 14 12 10 8 6 4 2 0 -0,1 0,1 0,0 0,3 0,2 0,5 0,4 0,7 0,6 0,9 0,8 1,1 -0,1 1,0 Болезнь: 0 0,1 0,0 0,3 0,2 0,5 0,4 0,7 0,6 0,9 0,8 1,1 1,0 Болезнь: 1 АберХр Необходимо использовать непараметрический тест Манна-Уитни! Различия значимы по Стьюденту (независимо от условия равенства дисперсий ) Непараметрический тест Манна – Уитни Незначимо по Манну-Уитни! «Ненормальность» распределений не замедлила сказаться! Различия значимы по Стьюденту (независимо от условия равенства дисперсий ) Тест Крускала - Уоллиса 1 выборка n выборок Параметрически Непараметрически Тест Стьюдента Тест Манна-Уитни Дисперсионный анализ (ANOVA) Тест Крускала-Уоллиса Для непараметрических тестов характерна пониженная мощность, но они безопаснее в смысле ошибки I рода Что значит «незначимо»? Допустим мы не обнаружили статистическую значимость различий, о чем с грустью сообщаем в публикации. Достаточно ли этого? НЕТ! Мы должны продемонстрировать, что объемы наших выборок достаточны, чтобы обнаружить эффект, если он существует. Мощность (чувствительность) используемых тестов должна быть не ниже 80% (тогда упускаем не более 20% открытий) Только в этом случае незначимые различия можно рассматривать как отрицательный результат Что значит «незначимо»? Допустим, что для 2 выборок имеем: n x SE SD Выборка 1 100 10 1 10 Выборка 1 100 12 1 10 Тогда по тесту Стьюдента различия незначимы и Р = 0.159 Compare2/ Numerical observations/ Normal distributin/mean value Проверим мощность данного теста Compare2/ Power/ Comparison of means Size A - 100 Size B – 100 DETECT a difference 2 Мощность всего 29% т.е. доля упущенных открытий более 70% ! О чем мы обязаны сообщить в публикации (правда биологи этого почти никогда не делают) Чтобы выйти на мощность 80% объемы выборок должны быть 400 и 400 Compare2/ Sample size/ Means ! Поговорим о нормальном распределении Вы его много раз видели: 1 e 2 ( x x)2 0,4 x 0, 1 2 2 0,3 f (x ) f ( x) Площадь равна вероятности 1Площадь < x < 2 двух красных треугольников равна 0.05 0,2 0,1 0 -4 -3 -1.96 -2 -1 0 1 2 3 4 1.96 x Это плотность распределения (кривая, огибающая гистограмму). Площадь под кривой равна вероятности попадания x в соответствующий интервал. Площадь хвостов: Р (-1.96 < x < 1.96) = 0.95 Отсюда 95%-ый доверительный интервал: x 1.96SE; x 1.96SE Почему нормальное распределение встречается на каждом шагу? Нормальное распределение имеет любая величина, которая определяется суммой большого числа случайных слагаемых (ЦПТ). Чем больше слагаемых – тем «нормальней»! Например, биномиальный закон – это вероятность суммарного числа независимых событий в N испытаниях. Поэтому, если N велико, биномиальное распределение становится нормальным. Проверяем ... К 20 годам 80% молодых людей курит. Какова вероятность, что среди 100 окажется 15 некурящих? С помощью биномиального распределения: = ЧИСЛКОМБ(100;15)*0,2^15*0,8^85 или Р(15) = 0.048 = БИНОМРАСП(15; 100; 0,2; 0) = НОРМРАСПР(15;20;4;0) С помощью нормального распределения: Среднее число некурящих Np =1000.2=20, дисперсия равна Np(1-p) = 1000.2(1-0.2) = 16, = 4. Р(15) = 0.046 Пока мы говорили о сравнениях количественных признаков При этом: Мы припомнили, что такое тест Стьюдента и каких случаях его можно использовать Познакомились с дисперсионным анализом – методом одновременного сравнения нескольких выборок Узнали, как обрабатывать данные, распределение которых существенно «ненормально» Поговорили о том, как следует осмысливать и преподносить незначимые результаты Качественные признаки Будет правильно, если вы скажите – мы этим уже занимались! Сравнение частот, таблицы 2х2, точный тест Фишера и все такое. Но то было сравнение 2 частот. А как сравнивать несколько пар частот? Например, распределения генотипов при различных вариантах скрещиваний – наблюдаемые и ожидаемые исходя из законов Менделя? Или как сравнить в целом видовой состав в двух регионах? Или частоты встречаемости блондинов, брюнетов, шатенов и т.д. для 2 этносов Во всех этих случаях речь идет либо о сравнении двух выборочных дискретных распределений, либо о сравнении наблюдаемого распределения с теоретически ожидаемым Для решении этих задач разработаны тесты, называемые критериями согласия Критерий 2 Соответствие наблюдаемых численностей ожидаемым частотам Класс Наблюдаемая численность Ожидаемая численность 1 n1 p1 N 2 n2 p2 N … … … k nk pk N Всего N N Вычисляется сумма 2 ( Н О ) 2 О 2 ( n p N ) 2 i i pi N i 1 k т.е. В 1900 г. Карл (Charles) Пирсон вычислил распределение этой величины: Оказалось, что 2 распределен как сумма 2 2 2 2 квадратов независимых случайных величин: 1 2 ... k 1 ~ где все i - нормальны k -1– число степеней свободы Если величина 2 достаточно велика, то гипотеза о совпадении наблюдаемых и ожидаемых численностях отвергается. Насколько велика скажет Excel: 0.05 =ХИ2РАСП(3.84;1) Критерий 2 Распределение 2 при различных k Площадь = 0.05 3.84 0.05 =ХИ2РАСП(3.84;1) Упражняемся … В выборке 100 человек имеем 44 мужчины и 56 женщин. Есть ли значимое отклонение от 1:1 ? 2 2 ( 44 50 ) ( 56 50 ) Вычисляем величину 2 1.44 50 50 0.23 =ХИ2РАСП(1.44;1) Вывод: нулевая гипотеза не отвергается. Мужчины и женщины представлены в этой выборке в соотношении 1:1. Вероятность наблюдать такие и еще более сильные отклонения равна 0.23 Подобное мы уже считали : 0.135 =БИНОМРАСП(44;100;0,5;1) Соответствие распределению Харди–Вайнберга – не обходится без 2 Соответствие распределению Харди - Вайнберга Как правило для популяционных частот генотипов АА, аА, аа соблюдается соотношение Харди–Вайнберга (а2также и 2многих других). pq Кастла 2 p 2q Закон настолько прост, что его открывали для себя многие, но стеснялись публиковать. Я запишу это соотношение в виде: PaA 2 Paa PAA и то же самое для численностей: naA 2 naa n AA Т.е. не бывает: [100, 100, 100] , а лишь, например, [50, 100, 50] Класс АА аА аа Всего Наблюдаемая численность nАА nаА nаа N Ожидаемая частота р2 2pq q2 1 где p 1 1 naa naA n Aa 2 2 q , N N p q 1 n AA Упражняемся … Для учебного файла определим частоты генотипов по локусу GSTP1 Упражняемся …Важное условие применимости 2 : Для учебного файла определим частоты генотипов локусу GSTP1 всепоожидаемые >5 Класс АА аА аа Всего Наблюдаемая численность 47 42 11 100 1 p 47 42 / 100 0.68 2 1 q 11 42 / 100 0.32 2 Ожидаемая численность 0.682 100 = 46.24 20.680.32 = 43.52 0.322 100 = 10.24 100 (Н-О)2/О 0.0125 0.0531 0.0564 0. 1220 0.727 =ХИ2РАСП(0,122; 1) Число степеней свободы 1, а не 2. Это потому, что мы вычисляли ожидаемые через Вывод: нулевая гипотеза не отвергается. Частоты генотипов соответствует наблюдаемые распределению Харди-Вайнберга. Вероятность наблюдать такие и еще более сильные отклонения равна 0.73 (при условии равновесия Х-В) Что означают серьезные отклонения от Харди – Вайнберга? Основная причина выполнения закона Харди-Вайнберга – панмиксия (случайность скрещиваний). Например, существенные отклонения от ХВ возможны в популяциях растений с частичным самоопылением В принципе причинами отклонений от ХВ могут быть - близкородственные скрещивания - подразделенность популяции - генетический дрейф - отбор Но самая реальная причина – ошибки генотипирования Проверяйте ХВ, чтобы убедиться в том, что ваши праймеры работают правильно Критерий 2 и таблицы сопряженности Тест 2 можно использовать для проверки независимости качественных признаков. Например бинарных (да - нет) Вероятности независимых событий перемножаются. Поэтому, если признак А не сопряжен (не связан) с признаком В, то таблица сопряженности этих признаков принимает вид: Признак А есть Признака А нет B _ B A _ A p A pB p_A pB p A p_B p_A p_B Это и есть ожидаемые частоты при условии, что признаки А и В никак не связаны Теперь их можно сравнить с реально наблюдаемым распределением, используя 2 Критерий 2 и таблицы сопряженности Как это делается практически? B _ B A _ A 50 30 20 100 Наблюдаемые Вычисляем: B _ B A _ A 5600 10400 8400 15600 Делим на 200 (сумма по 4 клеткам) _ A A Ожидаемые B 28 52 _ B 42 78 В 2общем случае: 2 (50 28) (30 52) (20 42 ) (100 78)строк-1) 2 (число столбцов-1)(число 44.3 2 28 2 52 А что скажет по этому поводу точный тест Фишера? 42 78 2,810-11 =ХИ2РАСП(44,3; 1) 2,510-9 Критерий 2 и таблицы сопряженности Все это можно делать, используя STATISTICA Критерий 2 и таблицы сопряженности Это все были таблицы Напомню:2х2. во всех численности Для признаков с более, чем 2 клетках значениями, все тоже самое должны быть > 5 Наблюдаемые: n23 n*3 Ожидаемые: n2* n*3 n2* N 2 ( Н О ) 2 О Число степеней свободы = (число столбцов-1)(число строк-1) =ХИ2РАСП(2; Число ст. свободы) Кстати точный тест Фишера считается только для 2х2, и поэтому только и остается, что использовать 2 Критерий 2 и таблицы сопряженности Таблица сопряженности 2х3: ассоциация заболевания с полиморфизмом гена GSTP1 GSTP1 A313G 90 A/A Relative frequency (%) 80 A/G 70 G/G 60 50 40 30 20 10 0 0 1 Болезнь Критерий 2: проверка однородности данных В практике экспериментатора постоянно возникает вопрос о возможности объедания выборок Данные мониторинга популяций, полученные в различные годы Данные по частотам генов в нескольких выборках в пределах одно локальности Сравнение частот аберраций для экспонированных и контрольных популяций: можно ли объединять данные для различных особей Объединие выборок возможно лишь при условии однородности данных. В случае таблиц сопряженности на однородность указывает низкий 2 (соответствующее р > 0.1) При работе с неоднородными данными возникают невероятные ситуации! На сегодня это все Напоследок хочу посоветовать: Проверяйте характер распределения сравниваемых величин. Или хотя бы стройте гистограммы распределений – для себя. При сравнении средних всегда пробуйте все тесты – параметрические и непараметрические. Оценивайте мощность теста в случае получения незначимых результатов Прикиньте с помощью 2 – соотношение мальчиков и девочек в вашей группе отличается значимо от 1:1 ?