Практическое задание №2 Вариант 1

реклама

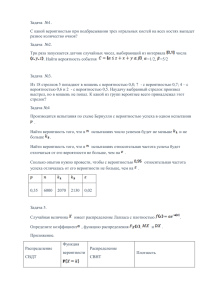

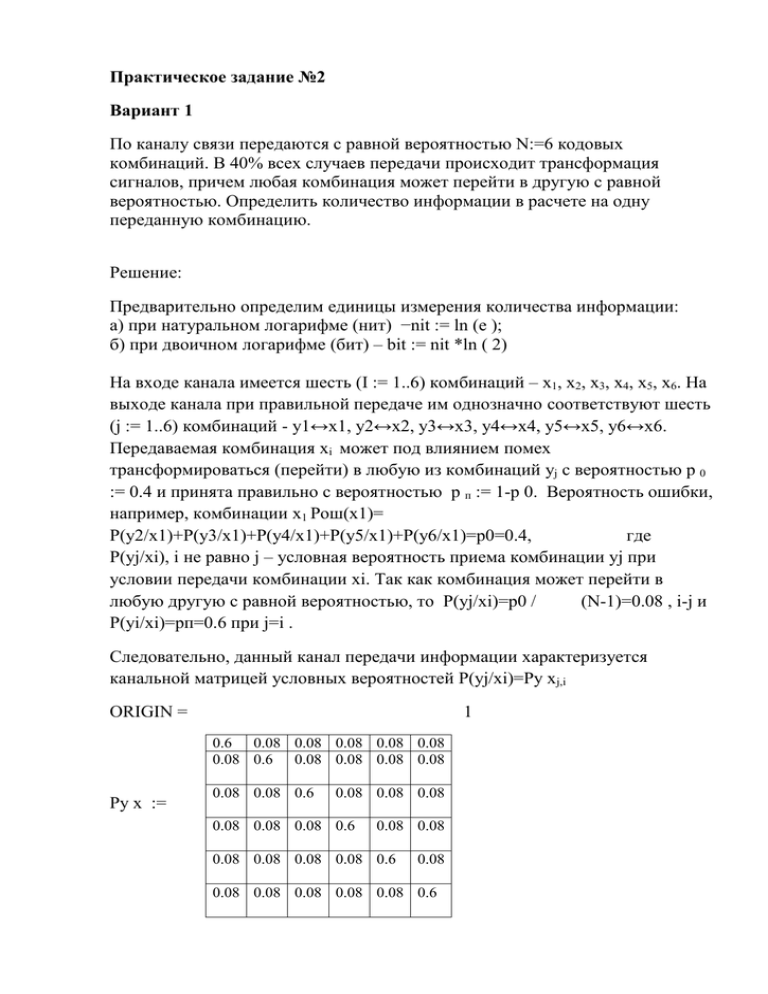

Практическое задание №2 Вариант 1 По каналу связи передаются с равной вероятностью N:=6 кодовых комбинаций. В 40% всех случаев передачи происходит трансформация сигналов, причем любая комбинация может перейти в другую с равной вероятностью. Определить количество информации в расчете на одну переданную комбинацию. Решение: Предварительно определим единицы измерения количества информации: а) при натуральном логарифме (нит) −nit := ln (е ); б) при двоичном логарифме (бит) – bit := nit *ln ( 2) На входе канала имеется шесть (I := 1..6) комбинаций – х1, х2, х3, х4, х5, х6. На выходе канала при правильной передаче им однозначно соответствуют шесть (j := 1..6) комбинаций - y1↔x1, y2↔x2, y3↔x3, y4↔x4, y5↔x5, y6↔x6. Передаваемая комбинация хi может под влиянием помех трансформироваться (перейти) в любую из комбинаций уj с вероятностью р 0 := 0.4 и принята правильно с вероятностью р п := 1-p 0. Вероятность ошибки, например, комбинации х1 Pош(x1)= P(y2/x1)+P(y3/x1)+P(y4/x1)+P(y5/x1)+P(y6/x1)=p0=0.4, где P(yj/xi), i не равно j – условная вероятность приема комбинации yj при условии передачи комбинации xi. Так как комбинация может перейти в любую другую с равной вероятностью, то P(yj/xi)=p0 / (N-1)=0.08 , i-j и P(yi/xi)=pп=0.6 при j=i . Следовательно, данный канал передачи информации характеризуется канальной матрицей условных вероятностей P(yj/xi)=Py хj,i ORIGIN = 1 0.6 0.08 0.08 0.08 0.08 0.08 0.08 0.6 0.08 0.08 0.08 0.08 Py x := 0.08 0.08 0.6 0.08 0.08 0.08 0.08 0.08 0.08 0.6 0.08 0.08 0.08 0.08 0.08 0.08 0.6 0.08 0.08 0.08 0.08 0.08 0.08 0.6 Количество информации в среднем на одну переданную комбинацию I(X,Y)=H(Y)-H(Y/X), гдеH(Y) –энтропия принимаемой комбинации; H(Y/X) –условная энтропия, т.е. энтропия принимаемой комбинации при условии, что известна передаваемая комбинация. Так как комбинации передаются и принимаются с равной вероятностью, то вероятность передачи i-й и приема j-й комбинации 1 1 Pxi := ; Px1 = 0.167; Pyj := ; Py1 = 0.167 𝑁 𝑁 Согласно (1.1), энтропия принимаемой комбинации 𝐻𝑌 ∶= − ∑𝑗=1 6 𝑃𝑌 𝑗 ∗ ln(𝑃𝑌𝑗) ; 𝐻𝑦 = 2.585 ∗ 𝑏𝑖𝑡 Согласно (1.7) с учетом P(xi,yj)=P(xi)P(yj/xi) условная энтропия принимаемой комбинации при известной передаваемой. Таким образом, количество информации на одну переданную комбинацию IXY := HY-HYх; Iху = 0.685* bit.