Идентификация бинарных образов векторной нейронной сетью

реклама

ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3

В.М. КРЫЖАНОВСКИЙ

Научно-исследовательский институт системных исследований РАН,

Москва

Vladimir.Krizhanovsky@gmail.com

ИДЕНТИФИКАЦИЯ БИНАРНЫХ ОБРАЗОВ ВЕКТОРНОЙ

НЕЙРОННОЙ СЕТЬЮ С МЕРОЙ БЛИЗОСТИ

МЕЖДУ СОСТОЯНИЯМИ НЕЙРОНОВ

В настоящей работе описывается новая модель векторной нейронной

сети, в которую легко и естественно вводится априорная информация о

распределении шума. Учет характера шума позволяет существенно повысить помехоустойчивость системы. Впервые введена мера близости между состояниями нейрона, позволяющая учитывать априорную информацию. Введение меры близости на порядок повышает емкость памяти двухэтапной системы идентификации бинарных образов.

Ключевые слова: векторные нейронные сети, распознавание бинарных

образов

Введение

Построение эффективных систем ассоциативной памяти требует знания условий, в которых будет она работать. Очень важно встроить в систему априорные знания:

о запоминаемых данных – сколько классов, к какому классу и подклассу относится каждый эталон, каково перекрытие эталонов и т.п.;

о том, как происходит искажение входных векторов во входном канале – автокорреляционная функция шума и его распределение.

Часто ассоциативная память разрабатывается на базе готовой нейросетевой модели, разработанной для других условий применения. Например,

распределение шума отличается от распределения, предполагаемого при

построении используемой модели. Модификация готовой модели затруднена и зачастую не возможна. Поэтому актуально создание моделей

нейронных сетей, легко адаптируемых для различных условий задач.

Посвящается памяти академика Андрея Леоновича Микаэляна. Работа поддержана грантом РФФИ #09-07-00159-а и проектом ОНИТ РАН 1.7.

УДК 004.032.26(06) Нейронные сети

161

ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3

В настоящей работе описывается модель векторной нейронной сети

(ВНС), в которую легко и естественно вводится априорная информация о

распределении шума, налагаемого на компоненты распознаваемого образа

во входном канале. (Здесь и далее полагается, что шум является белым,

т.е. компоненты входного вектора искажаются независимо). Векторные

нейронные сети предназначены для распознавания параметрических векторов, каждая компонента которых принимает одно из нескольких дискретных значений. Например, в качестве эталонных векторов могут выступать изображения с 256 градациями серого (Q = 256). В этом случае

количество нейронов в ВНС будет равно количеству пикселов, а количество состояний нейрона будет определяться цветностью Q. Значение компоненты входного вектора (цвет пикселя) определяет состояние векторного нейрона, приписанного к этой компоненте в начальный момент времени. В процессе распознавания нейроны под действием друг друга переключаются из состояния в состояние, пиксель за пикселем восстанавливая

входной вектор.

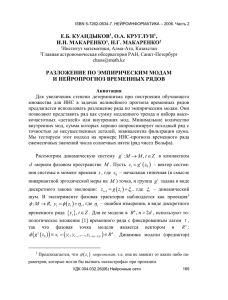

Классические ВНС (например, модель Поттса) эффективно борются с

белым шумом [1], имеющим «равномерное» распределение (рис. 1,б) – с

вероятностью 1–b цвет пикселя не искажается, а с вероятностью b искажается на любой другой. Из рис. 1,б видим, что 98 % искажение таким

шумом приводит к тому, что человек не способен распознать образы правильно. В то же время ВНС на это способна, т.к. она настроена на этот тип

искажений.

УДК 004.032.26(06) Нейронные сети

162

ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3

(а)

(б)

(в)

Рис. 1. Воздействие шума на входной вектор: а) эталон; б) белый шум

с «равномерным» распределением (с вероятностью b = 0,98 цвет пикселя

меняется на любой другой); в) белый шум с «нормальным» распределением с нулевым средним и среднеквадратическим отклонением σ = 85 (рис.

1,б)

На практике шум редко имеет равномерное распределение, чаще его

распределение близко к нормальному: с вероятностью 1–b цвет пикселя

не искажается, а с вероятностью b∙f(Δ) яркость пикселя увеличивается на

Δ, где f(Δ) – плотность нормального распределения с нулевым средним и

среднеквадратическим отклонением σ. На рис. 1в представлены эталонные образы, искаженные белым шумом с нормальным распределением.

Здесь также 98 % пикселей искажены, однако информации сохранилось

существенно больше. Видим, что человеческий глаз в этом случае распознает искаженные образы корректно. По-видимому, природа настроила

нашу зрительную систему на этот тип искажений как на наиболее распространенный, иначе рис.1в выглядел бы для нас так же неинформативно,

как рис. 1,б. Следует отметить, что распознавание таких векторов

(рис. 1,в) классической ВНС будет основываться только на информации,

где лишь 2 % неискаженных пикселов. Знание распределения шума позволяет извлекать дополнительную информацию с 98 % искаженных пикселов (по чуть-чуть с каждого), что приводит к существенному повышению надежности распознавания.

Для того, чтобы ввести в ВНС информацию о характере шума, предлагается вводить меру близости между состояниями нейрона. Это достигается за счет модификации весов классической ВНС – умножения матриц,

описывающих синаптические связи, на матрицу мер близостей. Меру близости между двумя состояниями предлагается задавать пропорционально

вероятности переключения из одного состояния в другое под воздействием искажений. Другими словами, если пиксель в результате искажений с

вероятностью 30 % меняет свой цвет с цвета k на цвет r, то мера близости

между состояниями k и r задается равной 0,3.

Апробация предложенного метода проведена на задаче распознавания

бинарных векторов. Важность этой задачи обусловлена тем, что известные скалярные модели нейросетей, работающих с бинарными образами,

имеют очень малую емкость памяти (причем емкость памяти жестко связана с размерностью образов) [2]. Данное обстоятельство не позволяет

использовать скалярные модели для разработки практических приложений. В работе [3, 4] было показано, как адаптировать ВНС для распознаУДК 004.032.26(06) Нейронные сети

163

ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3

вания бинарных образов. Адаптация заключается в отображении бинарных образов (черно-белых изображений большой размерности) в

Q-нарные образы (цветные изображения меньшей размерности). Было

показано, что этот подход позволяет добиться экспоненциальной по свободному параметру емкости памяти, на несколько порядков превосходящей емкость памяти модели Хопфилда. Однако наличие искажений в исходном бинарном векторе приводит к сильному усилению искажений в

Q-нарном векторе, что негативно сказывается на емкости памяти. В

настоящей работе показано, что введение меры близости (т.е. учет распределения шума, возникающего при отображении) повышает емкость

памяти (до 30 раз).

Работа имеет следующую структуру. Во втором разделе представлено

описание векторного перцептрона (ВП) с мерой близости между состояниями нейронов. В третьем разделе описывается алгоритм отображения

бинарных векторов в Q-нарные. Обсуждается его положительные и отрицательные стороны. Показывается, что отображение усиливает искажения. Четвертый раздел содержит оценки распознающих характеристик ВП

(емкость памяти, вероятность ошибочной идентификации). Показывается,

что введение меры близости повышает емкость памяти до 30 раз.

Описание модели

Рассмотрим векторный перцептрон (ВП), состоящий из двух слоев

векторных нейронов; каждый нейрон входного слоя (N нейронов) связан

со всеми нейронами выходного слоя (n нейронов). Нейроны входного и

выходного слоев имеют Q и q дискретных состояний соответственно (в

общем случае Q q ). Состояния нейронов входного слоя описываются

орт-векторами ek

Q

Q-мерного пространства RQ , а выходного слоя –

орт-векторами v r q-мерного пространства R q .

Пусть каждому эталонному вектору X (x1 , x 2 ,..., xN ) поставлен в

q

однозначное соответствие

вектор-отклик

Y (y1, y 2 ,..., y n ),

где

Q

q

x j ek , y i v k и 1, M . Тогда синаптическая связь между

i-м и j-м нейронами задается q Q -матрицей по обобщенному правилу

Хебба:

УДК 004.032.26(06) Нейронные сети

164

ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3

M

Wij y i (x j e0 )T J,

(1)

1

1 Q

(2)

ek , i 1, n и j 1, N ,

Q k 1

а J – симметричная Q Q -матрица мер близостей между состояниями

нейронов входного слоя, элементы Jkl = Jlk которой – это мера близости

между состояниями k и l, k , l 1, Q . Между состояниями нейронов выходного слоя мера близости не вводится. Если в качестве матрицы J выбрать

единичную матрицу E (т.е. J=E), то выражение (1) будет описывать веса

классического перцептрона Поттса [1, 5–8]. Таким образом, чтобы ввести

меру близости в уже обученный перцептрон Поттса, достаточно модифицировать межнейронные связи, умножив их справа на матрицу J.

Матрица мер близости J может задаваться либо условиями задачи, либо из анализа данных и характера шума. Для того чтобы ввести в ВНС

информацию о распределении шума, предлагается задавать меру близости

между состояниями нейрона равной вероятности переключения из одного

состояния в другое под действием искажений:

(3)

J kl Pkl , k , l 1, Q ,

где Pkl – вероятность переключения из состояния k в состояние l под действием искажений.

Отклик Y векторного перцептрона при предъявлении неизвестного

где

e0

входного вектора X x1 , x2 ,..., x N , где x j εk Q , рассчитывается следующим образом. Вычисляется локальное поле на i-м выходном нейроне:

N

H i Wij x j .

(4)

j i

Далее i-й нейрон, подобно спину, находящемуся в магнитном поле,

под воздействием локального поля Hi принимает положение, наиболее

близкое к направлению этого поля (состояние нейрона дискретно, поэтому он не может ориентироваться строго вдоль вектора Hi). Иными словами, нейрон ориентируется вдоль того орт-вектора vr, проекция локального

поля Hi на который максимальна. Пусть, например, это будет проекция на

орт v3. Тогда, i-й выходной нейрон переключится в состояние № 3, описываемое орт-вектором v3:

(5)

y i v3 .

УДК 004.032.26(06) Нейронные сети

165

ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3

Эта процедура выполняется параллельно для всех выходных нейронов

( i 1, n ).

Предобработка бинарного вектора

Идентификация образов проводится в два этапа. На первом этапе производится предварительная обработка входного бинарного сигнала: бинарный L-мерный вектор Z отображается в Q-нарный N-мерный вектор X.

На втором этапе Q-нарный образ X идентифицируется (распознается) векторным перцептроном, т.е. формируется вектор-отклик Y, несущий всю

необходимую информацию о входном бинарном векторе Z.

Предобработка – это отображение бинарного вектора в Q-нарный вектор, процедура предобработки состоит в следующем. Пусть у нас имеется

L-мерный бинарный вектор Z ( z1 , z 2 ,..., z L ) , zi {0,1} . Мысленно разделим его на N фрагментов, содержащих по r элементов каждый (N = L/r).

i-й фрагмент бинарного вектора можно рассматривать как некое записанное в двоичном коде целое число ki, 0 ≤ ki ≤ Q – 1, Q = 2r, i = 1,…, N. Поставим в соответствие i-му бинарному фрагменту орт-вектор, описывающий ki-ое состояние нейрона, т.е. xi eki , где eki (0,...,0,1,0,...,0) – это

орт-вектор Q-мерного пространства, ki-я компонента которого равна 1.

Тем самым, всему бинарному вектору Z ставится в однозначное соответствие набор Q-мерных векторов, т.е. образ X (x1 , x2 ,..., x N ), xi {e k }Q .

Подчеркнем, что X не является вектором, но в дальнейшем будем относиться к нему как к вектору, помня о том, что его компоненты – это

Q-мерные орт-векторы.

Представленное отображение имеет как положительные, так и отрицательные свойства. С одной стороны, процедура отображения подавляет

имеющиеся корреляции эталонных бинарных образов. Например, рассмотрим два бинарных вектора Z1 (10000001 ) и Z 2 (10011001 ) , у которых совпадают 75 % компонент. Если к ним применить процедуру

отображения с параметром r = 2 (N = 4, Q = 4), т.е. разбить каждый вектор

на четыре фрагмента по два элемента, то получим два Q-нарных образа

X1 (e2 , e0 , e0 , e1 ) и X2 (e2 , e1 , e2 , e1 ) , которые перекрываются только

на 50% (совпадают только две компоненты из четырех – первая и последняя). Применив ту же процедуру с параметром отображения r = 4 (N = 2,

Q = 16), получим два совершенно не перекрывающихся отображения

X1 (e8 , e1 ) и X2 (e9 , e9 ). С другой стороны, наличие искажений в

УДК 004.032.26(06) Нейронные сети

166

ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3

исходном бинарном векторе приводит к сильному усилению искажений в

Q-нарном векторе. В среднем перекрытие эталонного образа Z и его ис~

каженного варианта Z после отображения описывается выражением:

L

r

Ox 1 ,

(6)

r

где α – вероятность того, что под действием шума компонента бинарного

вектора Z будет инвертирована. Видим, что с ростом r и α перекрытие

быстро стремится к нулю. В представленном выше примере вектор Z2

можно рассматривать как искаженный на 25 % вектор Z1. Соответственно,

отображение с параметром r = 2 приводит к 50 % искажениям, а с r = 4 –

к 100 % искажениям. В работе рассматривается, как можно избежать этого негативного эффекта, направлена настоящая работа. Основная идея

заключается в том, чтобы на втором этапе использовать ВП с мерой близости, настроенный на данный тип искажений. Вероятность того, что k-е

состояние под действием искажений перейдет в l-е определяется выражением:

(7)

Pkl (1 )r kl kl ,

где kl – это Хеммингово расстояние между бинарным представлением

чисел k и l. Тогда задав Jkl=Pkl, мы существенно повысим помехоустойчивость системы.

Эффективность идентификации

Получение оценок эффективности ВНС с мерой близости идентично

подходу, опубликованному в работах [3,4]. Приведем лишь конечные выражения для вероятности правильной идентификации, емкости памяти,

вычислительной сложности и объема оперативной памяти, необходимого

для хранения синаптических коэффициентов.

Вычислительная сложность процесса идентификации (4)-(5) с введением меры близости не изменилась:

(8)

OP nNq [операций] .

Также не изменились требования к объему оперативной памяти, необходимого для хранения синаптических коэффициентов (1):

(9)

RAM 4nNqQ [байт].

Предполагается, что под хранение одного элемента матрицы Wij выделяется 4 байта.

УДК 004.032.26(06) Нейронные сети

167

ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3

Вероятность того, что ВП идентифицирует входной образ X неправильно, т.е. восстановит вектор-отклик Y с ошибками, оценивается выражением вида:

n(q 1)

2

Pr1

exp ,

(10)

2

2

где – отношение «сигнал/шум», которое в общем случае имеет вид:

NQq Q 2 1

(11)

Pkl .

2M k

Q

Для рассматриваемой задачи идентификации бинарных образов отношение «сигнал/шум» (11) с учетом (7) примет вид:

L2r 1 q

1

r

(12)

2

(1 )2 2 r .

rM

2

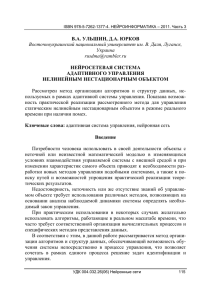

Полученная оценка вероятности ошибки достаточно хорошо согласуется с экспериментом (рис. 2). Это позволяет на ее основе оценить емкость памяти.

2

Рис. 2. Зависимость вероятности ошибки Pr от числа записанных в сеть

эталонов M для фиксированного параметра отображения r и уровня искажений α. Тонкие линии – теория, маркеры – эксперимент. Параметры: L =

1000; r = 6, 7, 8; α = 20 %

Максимальное число эталонов M, которое можно надежно идентифицировать с ошибкой меньшей, чем заданное значение Pmax,, получим, решив трансцендентное уравнение Pr( M ) Pmax . Емкость памяти двухэтапной схемы идентификации, на втором этапе которой используется векторный перцептрона с мерой близости, имеет вид:

УДК 004.032.26(06) Нейронные сети

168

ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3

L 2r 2 q

(1 ) 2 2 r 1 .

(13)

r ln(nq / Pmax )

2r

Для сравнения приведем емкость памяти двухэтапной схемы идентификации, на втором этапе которой используется векторный перцептрон

без меры близости [3, 4]:

L 2r 2 q

(1 ) 2 r 1 .

(14)

M0

r ln(nq / Pmax )

2r

M

Рис. 3. Зависимость емкости памяти от параметра отображения r: тонкие

кривые 1 и 1’ – стандартное отображение, жирные кривые 2 и 2’ – ВНС с

мерой близости; пунктирные кривые 3 и 3’ – оценка (13). Кривые 1, 2 и 3

построены для α = 0,2 и L = 1000, а кривые 1’, 2’ и 3’ построены для α =

0,3 и L = 1000

На рис. 3 приведены зависимости емкости памяти двухэтапной системы без меры близости (тонкие кривые) и с мерой близости (жирные кривые) от величины параметра отображения r, полученные в эксперименте

по идентификации бинарных векторов размерности L = 1000. Емкость

памяти M определялась из условия Pr M M 1 , т.е. как максимальное

число образов, распознаваемое без ошибки. Верхние кривые 1’, 2’ и 3’

соответствуют уровню искажений α = 0,2, а нижние кривые 1, 2 и 3 –

α = 0,3. Как видим, с ростом уровня искажений α емкость памяти обеих

моделей падает. Однако, система с мерой близости более устойчива к искажениям (жирные кривые 2 и 2’ лежат выше тонких кривых 1 и 1’). Введение меры близости повышает емкость памяти в 2 раза при α = 0,2 и в 7

раз при α = 0,3. С ростом параметра отображения r после определенного

критического значения емкость памяти M начинает падать. Это связано с

тем, что при отображении происходит сильное усиление искажений, приУДК 004.032.26(06) Нейронные сети

169

ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3

водящее к тому, что в определенный момент уже все бинарные фрагменты содержат хотя бы один искаженный бит, что приводит к срыву распознавания системы без меры близости (кривая 1’ в области r = 8 – 9). Система с мерой близости также подвержена этому эффекту, но в существенно меньшей степени: например, при r = 9 и α = 0,3 отношение

M/M0 = 30. Теперь сравним теоретическую оценку емкости памяти (13) с

результатами эксперимента (жирные кривые 2 и 2’, и пунктирные кривые

3 и 3’ соответственно). Видим, что теория хорошо согласуется с экспериментом за исключением точки r = 9, в которой не происходит падения

емкости памяти в связи с эффектом описанным выше. Скалярная модель

Хопфилда при шумах α = 0,2 и α = 0,3 способна хранить лишь 26 и 12 бинарных образов соответственно, что на два порядка меньше емкости памяти двухэтапной системы с мерой близости, способной хранить и

надежно восстанавливать 6226 и 1680 эталонных векторов соответственно.

Заключение

Разработана модель нейронной сети, которая позволяет легко и естественно вводить априорную информацию о распределении шума. Получены оценки распознающих характеристик этой модели. На примере

идентификации бинарных образов показано согласие полученных оценок

с вычислительным экспериментом. Учет характера шума позволяет существенно повысить емкость памяти и помехоустойчивость системы. Продемонстрировано, что емкость ассоциативной памяти, построенной на

базе векторной нейронной сети с мерой близости, на несколько порядков

превышает емкость памяти модели Хопфилда.

Высокие параметры надежности представленного алгоритма позволяют использовать его как алгоритм быстрого поиска, работающий при

наличии искажений входных данных.

Список литературы

1. Kryzhanovsky Boris, Kryzhanovskiy Vladimir, Litinskii Leonid. Machine Learning in Vector Models of Neural Networks. // Advances in Machine

Learning II. Dedicated to the memory of Professor Ryszard S. Michalski. Koronacki, J., Ras, Z.W., Wierzchon, S.T. (et al.) (Eds.), Series “Studies in Computational Intelligence”. Springer. ISSN: 1860-949X. SCI 263. 2010. P. 427–

443.

УДК 004.032.26(06) Нейронные сети

170

ISBN 978-5-7262-1377-4. НЕЙРОИНФОРМАТИКА – 2011. Часть 3

2. Hopfield J.J. // Proc. Nat. Acad. Sci. USA. 1982. V.79. P. 2554–2558.

3. Крыжановский Б.В., Крыжановский В.М. Идентификатор бинарных образов на основе модели Поттса // Вестник информационных компьютерных технологий. №8. 2009. С. 24–30.

4. Kryzhanovsky V.M., Kryzhanovsky B.V., Fonarev A.B. Application

of Potts-model perceptron for binary patterns identification // ICANN, Lecture

Notes in Computer Science 5163. Part I. 2008. P. 553–561.

5. Kanter I. Potts-glass models of neural networks. Physical Review A.

V. 37(7). 1988. P. 2739–2742.

6. Cook J. The mean-field theory of a Q-state neural network model.

Journal of Physics A. Vol. 22. 1989. P. 2000–2012.

7. Nadal J., Rau A. Storage capacity of a Potts-perceptron // J. Phys. I:

France 1. 1991. P. 1109–1121.

8. Bolle D., Dupont P. & Huyghebaert J. Thermodynamics properties of

the q-state Potts-glass neural network // Phys. Rew. A. Vol. 45. 1992. P. 4194–

4197.

УДК 004.032.26(06) Нейронные сети

171