Глава 12. Математическая статистика

реклама

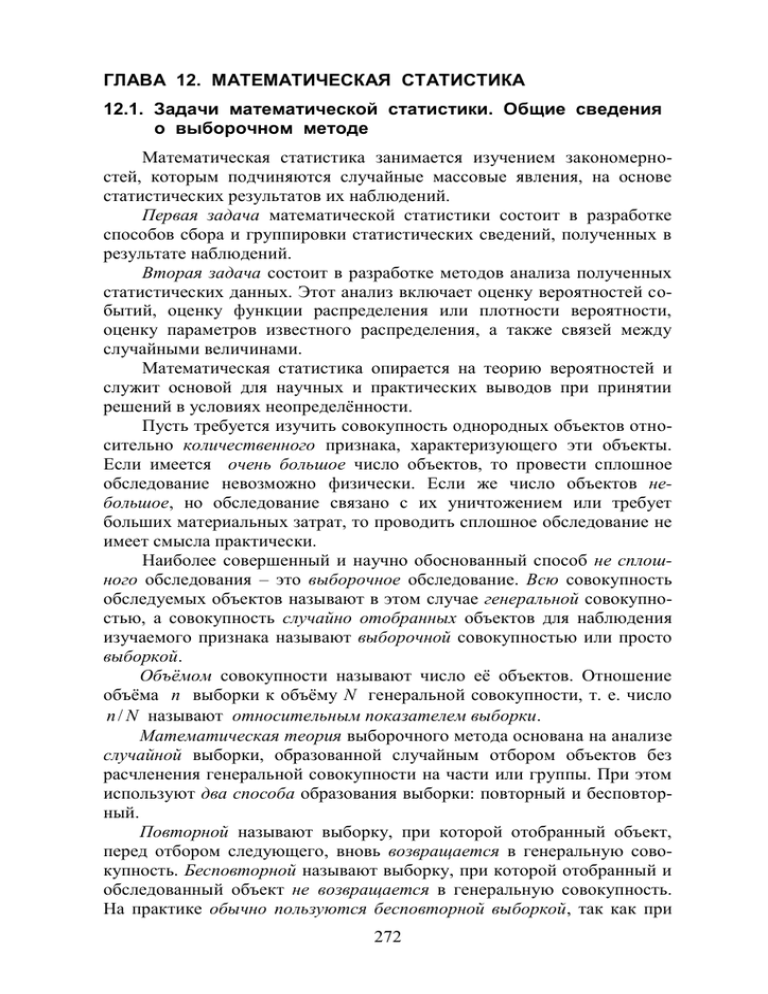

ГЛАВА 12. МАТЕМАТИЧЕСКАЯ СТАТИСТИКА 12.1. Задачи математической статистики. Общие сведения о выборочном методе Математическая статистика занимается изучением закономерностей, которым подчиняются случайные массовые явления, на основе статистических результатов их наблюдений. Первая задача математической статистики состоит в разработке способов сбора и группировки статистических сведений, полученных в результате наблюдений. Вторая задача состоит в разработке методов анализа полученных статистических данных. Этот анализ включает оценку вероятностей событий, оценку функции распределения или плотности вероятности, оценку параметров известного распределения, а также связей между случайными величинами. Математическая статистика опирается на теорию вероятностей и служит основой для научных и практических выводов при принятии решений в условиях неопределённости. Пусть требуется изучить совокупность однородных объектов относительно количественного признака, характеризующего эти объекты. Если имеется очень большое число объектов, то провести сплошное обследование невозможно физически. Если же число объектов небольшое, но обследование связано с их уничтожением или требует больших материальных затрат, то проводить сплошное обследование не имеет смысла практически. Наиболее совершенный и научно обоснованный способ не сплошного обследования – это выборочное обследование. Всю совокупность обследуемых объектов называют в этом случае генеральной совокупностью, а совокупность случайно отобранных объектов для наблюдения изучаемого признака называют выборочной совокупностью или просто выборкой. Объёмом совокупности называют число её объектов. Отношение объёма n выборки к объёму N генеральной совокупности, т. е. число n / N называют относительным показателем выборки. Математическая теория выборочного метода основана на анализе случайной выборки, образованной случайным отбором объектов без расчленения генеральной совокупности на части или группы. При этом используют два способа образования выборки: повторный и бесповторный. Повторной называют выборку, при которой отобранный объект, перед отбором следующего, вновь возвращается в генеральную совокупность. Бесповторной называют выборку, при которой отобранный и обследованный объект не возвращается в генеральную совокупность. На практике обычно пользуются бесповторной выборкой, так как при 272 большом объёме N генеральной совокупности и небольшом объёме n выборки различие между повторной и бесповторной выборками незначительное, а при бесконечно большой генеральной совокупности это различие исчезает вовсе. Выборка, правильно представляющая пропорции генеральной совокупности об интересующем нас признаке, называется репрезентативной или представительной. Это условие достигается соблюдением принципа равной возможности или равной вероятности каждому объекту генеральной совокупности попасть в выборку. С этой целью извлечение объектов в выборку должно проводиться путём жеребьёвки (лотереи) или с помощью таблицы случайных чисел, вырабатываемых датчиком случайных чисел. 12.2. Статистическое распределение выборки Пусть из генеральной совокупности извлечена выборка объёма n, при этом значение x1 количественного признака X наблюдалось n1 раз, значение x2 наблюдалось n2 раз и т. д., значение xk наблюдалось nk раз и k ni n . i 1 Наблюдаемые значения xi признака X называются его вариантами, а их последовательность, записанная в возрастающем порядке x1 , x2 , x3 , , xi , , xk , (12.1) называется вариационным рядом. Число наблюдений ni значений xi называется частотой, а отношение частоты к объёму выборки n pi* i (12.2) n / называется относительной частотой или частостью . Частоты и частости вариантов xi называются их весами. Вариационный ряд (12.1) называется прерывным (или дискретным), если любые его варианты отличаются на конечную постоянную величину, и называется непрерывным (или интервальным), если его варианты могут отличаться друг от друга на сколь угодно малую величину. В последнем случае, производя группировку значений xi , непрерывный вариационный ряд разбивают на последовательность интервалов ( x0 , x1 ) , ( x1 , x2 ) , , ( xi1 , xi ) , , ( xk 1 , xk ) . (12.3) В таком интервальном ряде частота ni интервала ( xi 1 , xi ) показывает число членов выборки, у которых изучаемый признак X принимает значения в границах указанного интервала. При этом точные конкретные значения признака X остаются неизвестными. Каждому интервалу принадлежит лишь один из его концов (либо во всех случаях левый, ли273 бо во всех случаях правый). Если частоты ni интервального вариационного ряда (12.3) поставить в соответствие серединам интервалов, т. е. значениям ( xi1 xi ) / 2 , (i 1, 2 , , k ) , то получим прерывный (дискретный) вариационный ряд, соответствующий данному интервальному ряду (12.3). О п р е д е л е н и е. Статистическим распределением выборки называют перечень вариантов или интервалов и соответствующих им частот или относительных частот (частостей). Статистические распределения выборок имеют вид таблиц 5 и 6. Таблица 5 … Значения xi x1 x2 x3 xk … Частоты ni n1 n2 n3 nk Относительные частоты pi* p1* p 2* … p3* p k* Значение варианта xi с наибольшей частотой ni называется модой вариационного ряда. Таблица 6 Значение признака X … ( x0 , x1 ) ( x1 , x2 ) ( xk 1 , xk ) … Частоты ni n1 n2 nk Относительные частоты p i* p1* p 2* … p k* З а м е ч а н и е. В теории вероятностей под распределением случайной дискретной величины X понимают соответствие между возможными значениями xi величины X и их вероятностями pi . В математической статистике под распределением количественного признака X понимают соответствие между наблюдаемыми вариантами xi (табл. 5) или интервалами ( xi1 , xi ) (табл. 6) и их частотами ni , или относительными частотами pi* ni / n . 12.3. Графическое изображение статистического распределения. Эмпирическая функция распределения Применяются несколько способов графического изображения статистических распределений в зависимости от их вида и поставленной задачи. Пусть прерывный вариационный ряд заni дан таблицей 1 п.12.2. В прямоугольной n2 системе координат построим точки с коорn4 n1 динатами ( xi , ni ) , (i 1, 2 , , k ) , и соедиn3 x3 x4 x i ним их последовательно отрезками пря0 x1 x2 мых. Получится ломаная линия, называеРис. 90 мая полигоном частот (рис. 90). 274 Полигоном относительных частот называют ломанную линию, отрезки которой соединяют точки ( xi , pi* ) , i 1, 2 , , k . Для графического изображения интервальных вариационных рядов применяют гистограммы. Гистограммой частот называют ступенчатую фигуру, состоящую из прямоугольников, основаниями которых служат частичные интервалы ( xi1 , xi ) постоянной длины h xi xi1 , а высоты равны отношениям ni / h . Величина отношения ni / h называется плотностью частоты ni (рис. 91). Площадь i-го часni / h тичного прямоугольника равна сумме nk 1 / h частот h ni / h ni вариантов, попавших в i-й интервал. Следовательно, плоnk / h n2 / h щадь гистограммы частот равна сумме n1 / h . . . n – объёму выборки. всех частот 0 h x xi Гистограммой относительных x0 h x1 h x2 k Рис. 91 частот называют аналогичную ступенчатую фигуру, состоящую из прямоугольников с основаниями, равными постоянной длине интервалов h , и высотами, равными отношениям pi* / h . Величина отношения pi* / h называется плотностью относительной частоты pi* . Следовательно, площадь гистограммы относительных частот равна сумме k pi* 1 . i 1 Полигон и гистограмма относительных частот статистического распределения выборки аналогичны кривой распределения непрерывной случайной величины X в теории вероятностей, заданной плотностью вероятности f ( x) F ( x) . Рассмотрим теперь статистический аналог интегральной функции распределения F ( x) P( X x) случайной величины X , называемый в статистике эмпирической функцией распределения. Обозначим через nx число наблюдений, при которых наблюдалось значение признака X x . Число nx называется накопленной частотой, а отношение nx / n называется накопленной частостью. Накопленную частость nx / n можно получить последовательным суммированием частостей pi* всех вариантов xi или интервалов ( xi1 , xi ) , удовлетворяющих условию X x . О п р е д е л е н и е. Эмпирической функцией распределения (функцией распределения выборки) называется функция F * ( x) , определяющая для каждого значения x накопленную частость события X x : 275 nx , n где nx число вариантов, меньших x ; n объём выборки. F * ( x) (12.4) Эмпирическая функция распределения выборки F * ( x) служит для оценки теоретической функции распределения генеральной совокупности F ( x) P( X x) и обладает всеми свойствами интегральной функции теории вероятностей: 1) 0 F * ( x) 1 ; 2) F * ( x1 ) F * ( x2 ) при x1 x2 ; 3) если x1 наименьший вариант, то F * ( x) 0 при x x1 ; если xk наибольший вариант, то F * ( x) 1 при x xk . График функции F * ( x) имеет ступенчатый вид. П р и м е р. Построить эмпирическую функцию распределения * F ( x) по данной выборке. 2 6 8 10 xi 6 ni 16 18 20 Р е ш е н и е. Найдём объём выборки n 6 16 18 20 60 и составим распределение частостей p i* . 2 6 8 10 xi p i* 6 / 60 16 / 60 18 / 60 20 / 60 Запишем эмпирическую функцию распределения F * ( x) и построим её график. 0 , если x 2 , 6 / 60 0,1 , если 2 x 6 , F * ( x) 22 / 60 0,4 , если 6 x 8 , 40 / 60 0,7 , если 8 x 10 , 1 , если x 10 . F * ( x) 1 0,7 0,4 0,1 0 1 2 3 x 4 5 6 7 8 9 10 Рис. 92 276 12.4. Числовые характеристики генеральной и выборочной совокупностей Пусть изучается прерывная (дискретная) генеральная совокупность относительно количественного признака X. Генеральной средней x г , т. е. средним значением признака X в пределах всей данной генеральной совокупности объёма N, называют среднее арифметическое значений признака: x x xN 1 N (12.5) xг 1 2 xi . N N i1 Если же значения признака x1 , x2 , , xk имеют соответственно частоты N1 , N 2 , , N k , причём N1 N 2 N k N , то x1N1 x2 N 2 xk N k 1 k (12.6) xi Ni , N N i1 т. е. генеральная средняя в этом случае есть средняя взвешенная значений признака с весами, равными соответствующим частотам. В обоих случаях формул (12.5) и (12.6) генеральная средняя равна математическому ожиданию признака X: (12.7) xг M ( X ) . Генеральной дисперсией Dг называют среднее арифметическое квадратов отклонений значений признака X генеральной совокупности от их среднего значения x г : 1 N (12.8) Dг D ( X ) ( xi x г ) 2 . N i1 Если же значения признака x1 , x2 , , xk имеют соответственно частоты N1 , N 2 , , N k , причём N1 N 2 N k N , то xг 1 k (12.9) ( xi x г ) 2 Ni . N i 1 Генеральным средним квадратическим отклонением (или стандартом) г , т. е. средней величиной разброса значений признака X вокруг Dг D ( X ) его среднего значения M ( X ) x г , называют квадратный корень из генеральной дисперсии: г ( X ) Dг . (12.10) Пусть теперь для изучения генеральной совокупности объёма N относительно количественного признака X извлечена выборка объёма n N , и пусть значения признака x1 , x2 , , xk имеют соответственно частоты n1 , n2 , , nk , причём n1 n2 nk n . 277 Выборочной средней x в , т. е. средним значением признака X в пределах выборки объёма n , называется величина k 1 k x в xi ni xi pi* . (12.11) n i1 i 1 Выборочной дисперсией Dв называется среднее арифметическое квадратов отклонений наблюдаемых значений xi от их среднего значения x в : k 1 k (12.12) ( xi x в ) 2 ni ( xi x в ) 2 pi* . n i1 i 1 Выборочным средним квадратическим отклонением (стандартом) называется арифметический квадратный корень из выборочной дисперсии: Dв в Dв . (12.13) Процентное отношение среднего квадратического отклонения в к выборочной средней x в , т. е. (12.14) V в 100 % , xв называется коэффициентом вариации выборки. Для малых выборок объёма n 30 вместо выборочных дисперсии Dв и среднего квадратического отклонения в используют на практике «исправленную» выборочную дисперсию n 1 k s2 D (12.15) ( x x в ) 2 ni n 1 в n 1 i1 i и «исправленное» выборочное квадратическое отклонение s s2 . (12.16) Соответственно коэффициент вариации V для малой выборки объёма n 30 вычисляется по формуле s (12.17) V 100 % . xв Приведём также формулу для среднего квадратического отклонения выборочной средней x в от генеральной средней x г : в в случаебольших выборокпри n 30; 2 n (12.18) ( x в ) M ( x в x г ) s в случаемалых выборокпри n 30. n Формулы (12.18) используются для вычисления так называемой предельной ошибки выборки. 278 12.5. Точечные оценки параметров распределения Одной из центральных задач математической статистики является задача оценки теоретического распределения случайной величины X на основе выборочных данных. При этом предполагается, что закон распределения генеральной совокупности известен, но неизвестны его параметры или числовые характеристики, например, математическое ожидание и дисперсия. Допустим, что закон распределения случайной величины X содержит теоретический параметр θ , численное значение которого не указано. В связи с этим возникает следующая задача: исходя из набора значений (12.19) x1 , x2 , , xn , полученных в результате n наблюдений или в результате выборки объёма n, требуется оценить значение параметра θ . О п р е д е л е н и е. Точечной оценкой θ* параметра θ называется функция результатов наблюдений или вариантов выборки: θ* θ* ( x1 , x2 , , xn ) , (12.20) которая в этом случае называется статистикой. Если для оценки параметра θ взять k различных выборок объёма n, то в общем случае получим столько же различных между собой случайных оценок θ1* , θ*2 , , θ*k . Математическое ожидание M (θ* ) случайной величины θ* может как совпасть, так и не совпасть с оцениваемым параметром θ . О п р е д е л е н и е. Точечная статистическая оценка θ* называется несмещённой, если M (θ* ) θ . (12.21) M (θ* ) θ В противном случае, при , она называется смещённой. Для случайной величины X генеральной совокупности математическим ожиданием M (X ) является x г , а дисперсией D (X ) является Dг . Несмещённой оценкой генеральной средней x г служит выборочk ная средняя x в xi pi* , где pi* частости, так как доказано, что i 1 M ( xв ) xг M ( X ) . (12.22) Смещённой оценкой генеральной дисперсии Dг для малой выборки объёма n 30 служит выборочная дисперсия Dв , так как n 1 M ( Dв ) D D( X ) , (12.23) n г 279 а несмещённой оценкой генеральной дисперсии Dг малой выборки объёма n 30 служит «исправленная» выборочная дисперсия s 2 , так как M ( s 2 ) Dг D( X ) . (12.24) Для больших выборок объёма n 30 различие в формулах (12.23) и (12.24) несущественное, так как lim (n 1) / n 1 . Для малых выборок n требование несмещённости очень важно. Как и для любой случайной величины X, оценка θ* может иметь большой или небольшой разброс (т. е. дисперсию) относительно математического ожидания. О п р е д е л е н и е. Эффективной называется статистическая оценка θ* , которая при одних и тех же объёмах выборки n имеет наименьшую дисперсию. Состоятельной называется статистическая оценка θ* , которая при n ∞ стремится по вероятности к оцениваемому параметру θ , т. е. lim P (θ* θ) 1 . (12.25) n Если оценка θ* параметра θ является несмещённой, а её дисперсия D (θ* ) 0 при n ∞, то оценка θ* является эффективной и состоятельной, так как в этом случае θ* θ при достаточно большом значении n . Рассмотренные выше несмещённые точечные статистические оценки x в выборочная средняя и s 2 «исправленная» выборочная дисперсия являются эффективными и состоятельными оценками математического ожидания M (X ) и дисперсии D (X ) случайной величины X генеральной совокупности. З а м е ч а н и е. На практике иногда целесообразно использовать другие незначительно смещённые оценки или оценки, обладающие большей дисперсией по сравнению с эффективными оценками, так как для простоты расчётов всегда желательно, чтобы выражение для статистики θ* θ* ( x1 , x2 , , xn ) было не слишком сложным. 12.6. Интервальные оценки параметров распределения При выборке малого объёма точечная оценка может существенно отличаться от оцениваемого параметра. В этом случае целесообразно использовать интервальные оценки. Интервальной называют оценку, которая определяется двумя числами – концами интервала, покрывающего оцениваемый параметр θ . Интервальная оценка позволяет установить надёжность и точность точечной оценки θ* . 280 Пусть найденная по данным выборки величина θ* служит оценкой неизвестного параметра θ . Оценка θ* определяет параметр θ тем точнее, чем меньше разность | θ θ * | , т. е. чем меньше величина в неравенстве | θ θ* | , (12.26) где число 0 называется предельной ошибкой выборки. Так как θ* случайная величина, полученная по данным значениям выборки, то и разность | θ θ* | случайная величина. Поэтому неравенство (12.26) при заданной предельной ошибке выборки может выполняться только с некоторой вероятностью. Надёжностью или доверительной вероятностью оценки θ* неизвестного параметра θ называется вероятность , с которой осуществляется неравенство (12.26). Обычно задаётся надёжность и по ней вычисляется предельная ошибка выборки , определяющая точность оценки. Чаще всего вероятность задаётся значениями 0.95 , или 0.99 , или 0.999 . Неравенство (12.26) можно записать в форме θ θ* θ* θ θ* . (12.27) ) , который покрывает неизвестный параметр Интервал θ с заданной надёжностью , называется доверительным интервалом. Предельная ошибка выборки в случае малых выборок объёма n 30 находится по формуле t s , (12.28) n где s «исправленное» выборочное квадратическое отклонение (θ* ; θ* k s ( xi x в ) 2 ni i 1 , (12.29) n 1 а коэффициент t t ( , n) называется коэффициентом доверия для заданной надёжности и заданного объёма выборки n . Значения коэффициента t приведены, например, в таблице Приложения 3, стр. 392, известного задачника В.Е. Гмурмана «Руководство к решению задач по теории вероятностей и математической статистике». В случае больших выборок объёма n 30 предельная ошибка выборки , определяющая точность оценки параметра, находится по иной формуле, а именно: 281 t в , n где в выборочное среднее квадратическое отклонение в 1 k ( xi x в ) 2 ni n i 1 (12.30) k ( xi x в ) 2 pi* , (12.31) i 1 а параметр t t () находится из уравнения 1 (t ) , 2 (12.32) t 2 1 e z / 2 dz функция Лапласа, значения которой приведе2 0 ны в таблице Приложения 2, стр. 390-391, задачника, указанного выше. Для интервальной оценки с надёжностью математического где (t ) ожидания M ( X ) a нормально распределённого количественного признака X по выборочной средней x в при неизвестном среднем квадратическом отклонении (X ) генеральной совокупности используют формулы: t s t s для малых выборок P x в a xв n n при n 30 , (12.33) t t P x в в a x в в 2 (t ) для больших выборок n n при n 30 . (12.34) Для интервальной оценки с надёжностью среднего квадратического отклонения (X ) нормально распределённого количественного признака X по «исправленному» выборочному квадратическому отклонению s используют формулу: P (s (1 q) (1 q) s) , где таблица значений параметра q q ( , n) приведена в Приложении 4, стр. 392, задачника, указанного выше. 12.7. Принцип практической невозможности маловероятных событий В основе применения любых выводов и рекомендаций с помощью теории вероятностей и математической статистики лежит принцип практической невозможности маловероятных событий: 282 если вероятность случайного события A в данном испытании очень мала, то при однократном испытании практически можно считать, что это событие не произойдёт. Этот принцип не может быть доказан математически. Но он подтверждается всем практическим опытом человеческой деятельности. Достаточно малую вероятность, при которой событие A можно считать практически невозможным, называют уровнем значимости события A и обозначают (12.35) P (A) , где 1 . На практике обычно принимают 0,01 0,05 . Уровень значимости 0,01 называют однопроцентным, 0,05 пятипроцентным, и т. д. Если же производится много испытаний, то вероятность того, что событие A произойдёт хотя бы один раз в n независимых испытаниA A A , равна значению ях, т. е. вероятность события B n слагаемых (12.36) P ( B) 1 Pn ( A) 1 (1 )n 1 (1 n ) n , следовательно, вероятность P (B) увеличивается по сравнению с P(A) в n раз. Таким образом, при многократном повторении испытаний нельзя считать маловероятное событие A практически невозможным. 12.8. Статистическая гипотеза и общая схема её проверки С теорией статистического оценивания параметров распределения тесно связана проверка статистических гипотез. О п р е д е л е н и е. Статистической гипотезой называется любое предположение о виде неизвестного закона распределения или о величине параметров известных распределений. Например, статистическими являются следующие гипотезы: 1) генеральная совокупность распределена по закону Пуассона; 2) дисперсии двух генеральных совокупностей, распределённых по нормальному закону, равны между собой. Проверяемую гипотезу обычно называют нулевой или основной и обозначают H 0 . Наряду с нулевой гипотезой H 0 рассматривают конкурирующую или альтернативную гипотезу H1 , являющуюся логическим отрицанием H 0 . Например, если нулевая гипотеза H 0 : M ( X ) 10 , тогда альтернативная гипотеза H1 : M ( X ) 10 , или H1 : M ( X ) 10 , или H1 : M ( X ) 10 . Нулевая и конкурирующая гипотезы представляют собой две возможности выбора, осуществляемого в задачах проверки статистических гипотез. 283 Проверку правильности или неправильности выдвинутой гипотезы проводят статистическими методами. В результате такой проверки может быть принято правильное или неправильное решение. При этом различают ошибки неправильного решения двух родов. Ошибка первого рода состоит в том, что будет отвергнута правильная гипотеза. Ошибка второго рода состоит в том, что будет принята неправильная гипотеза. Последствия этих ошибок весьма различны. О п р е д е л е н и е. Вероятность допустить ошибку 1-го рода, т. е. отвергнуть правильную гипотезу H 0 , называется уровнем значимости или «альфа – риском». Вероятность допустить ошибку 2-го рода, т. е. принять гипотезу H 0 , когда она неверна, обычно обозначают и называют «бета – риском». Пользуясь терминологией статистического контроля качества продукции, можно сказать, что «альфа – риск» есть «риск потребителя», равный вероятности признания негодной по результатам выборочного контроля партии годной продукции, а «бета – риск» есть «риск потребителя», равный вероятности принять негодную продукцию, не удовлетворяющую стандарту. По юридической терминологии вероятность есть вероятность вынесения обвинительного приговора невиновному, а вероятность есть вероятность вынесения оправдательного приговора виновному. Возможностью двойной ошибки 1-го и 2-го рода проверка гипотез отличается от рассмотренного ранее интервального оценивания параметров, в котором имелась лишь одна возможность ошибки получить доверительный интервал, который на самом деле не содержит оцениваемый параметр. Для проверки нулевой гипотезы H 0 в рассмотрение вводят специально подобранную случайную величину, закон распределения которой известен. Эту случайную величину K , которая служит для проверки нулевой гипотезы H 0 , называют статистическим критерием, или просто критерием. Сначала по выборочным характеристикам вычисляются значения величин, входящих в критерий K , а затем вычисляется и сам критерий. Вычисленное по выборкам значение критерия называют наблюдаемым значением K набл . Область возможных значений критерия K разбивают на две области: в одной находятся те значения критерия, при которых гипотеза H 0 принимается, в другой – те, при которых она отвергается. Критической областью называется область значений критерия K , при которых нулевая гипотеза H 0 отвергается. Областью принятия гипотезы H 0 называют совокупность значений критерия, при которых гипотезу H 0 принимают. 284 Поскольку критерий K есть одномерная случайная величина, то все её возможные значения принадлежат некоторому интервалу. Критическими точками (границами интервалов) Kкр называются точки числовой оси, отделяющие критическую область от области принятия гипотезы H 0 . Различают одностороннюю (правостороннюю или левостороннюю) и двустороннюю критические области (рис. 93): K K кр а) 0 K кр K кр 0 K – правосторонняя критическая область; K – левосторонняя критическая область; K – двусторонняя критическая область. K K кр б) в) K K1 кр K1 кр 0 K K 2кр K 2 кр Рис. 93 Для отыскания, например, правосторонней критической области необходимо найти критическую точку Kкр исходя из условия P ( K K кр ) , (12.37) где вероятность, называемая уровнем значимости или «альфа – риском». Для каждого критерия имеются соответствующие таблицы, по которым и находят критическую точку Kкр , удовлетворяющую условию (12.37). Затем сравнивают два значения K набл и Kкр . Если K набл K кр , то нулевую гипотезу H 0 отвергают как практически невозможную. Если же K набл K кр , то нулевую гипотезу H 0 принимают (точнее, не отвергают). 12.9. Проверка гипотезы о законе распределения по критерию Пирсона Одной из важнейших задач математической статистики является установление теоретического закона распределения случайной величины, характеризующей изучаемый признак, по опытному (эмпирическому) распределению, представляющему вариационный ряд. Если на основании теоретических предпосылок или опыта аналогичных исследований, или на основании графического изображения статистического распределения можно предположить, что теоретический закон распределения имеет определённый вид, например A, то проверяют нулевую гипотезу H 0 : генеральная совокупность распределена по закону A. При этом неизвестные параметры распределения A заменяют наилучшими оценками по выборке, как это указано в п.12.5 и в п.12.6. 285 Как бы хорошо ни был подобран теоретический закон распределения, между эмпирическим и теоретическим распределениями неизбежны расхождения. Естественно возникает вопрос: объясняются ли эти расхождения только случайными обстоятельствами, связанными с ограниченным числом наблюдений, или они являются существенными и связаны с тем, что теоретический закон распределения подобран неудачно. Для ответа на этот вопрос выбирают статистический критерий – критерий согласия. Критерием согласия называют статистический критерий проверки гипотезы о предполагаемом законе неизвестного распределения. Имеется несколько критериев согласия. На практике наиболее часто используют критерий 2 (хи-квадрат) Пирсона, который применим к любым распределениям, в чём и состоит его достоинство. В качестве критерия проверки нулевой гипотезы H 0 принимается случайная величина: (ni ni ) 2 , ni i 1 m 2 (12.38) где ni частоты дискретного или интервального вариационного ряда m ni n . Числа выборочной совокупности объёма i 1 ni n pi называются теоретическими частотами предполагаемого закона распределения случайной величины X . Если случайная величина X дискретная, то вероятности pi находят по соответствующим законам её распределения: биномиальному, Пуассона, гипергеометрическому и т. п. Если случайная величина X непрерывная, то вероятности pi вычисляются через значения функции распределения F (x) или плотности вероятности f (x) по формуле pi P (i X i ) . (12.39) Например, при нормальном распределении случайной величины X вероятность pi находится по известной формуле xв pi P ( i X i ) i в xв i , в (12.40) где (x) функция Лапласа, x в выборочная средняя, в выборочное среднее квадратическое отклонение. Величина 2 в формуле (12.38) случайная, так как в различных опытах она принимает различные, заранее не известные, значения. Ясно, что чем меньше различаются эмпирические ni и теоретические ni 286 частоты, тем меньше величина критерия 2 . Следовательно, он в известной мере характеризует близость эмпирического и теоретического распределений. Доказано, что при n ∞ закон распределения случайной величины 2 известен и практически не зависит от закона распределения случайной величины X генеральной совокупности. Закон распределения величины 2 называется 2 - распределением с k m r 1 степенями свободы, где m число интервалов, на которые разбивают данный дискретный или непрерывный вариационный ряд; r число параметров теоретического распределения, вычисленных по выборочным данным. В частности, если предполагаемое распределение – нормальное, то оценивают по выборке два параметра M ( X ) a и (X ) , поэтому r 2 и число степеней свободы k m 2 1 m 3 . Для распределения Пуассона оценивается один параметр , поэтому r 1 и число степеней свободы k m 1 1 m 2 . Схема применения критерия 2 для проверки гипотезы H 0 сводится к следующему. 1. Сначала вычисляются вероятности pi по формуле (12.39), а для нормального распределения по формуле (12.40), затем теоретические частоты ni n pi , а затем наблюдаемое значение критерия: (ni ni ) 2 . ni i 1 m 2 набл (12.41) 2. Для выбранного уровня значимости по таблице 2 распре2 ( , k ) деления находят критическую точку кр при числе степеней 2 ( , k )) . свободы k m r 1 , при которых P ( 2 кр 2 2 ( , k ) кр 3. Если набл , то гипотеза H 0 отвергается как практи- чески невозможная. 2 2 ( , k ) кр Если набл , то нет оснований отвергать нулевую гипотезу H 0 , так как она не противоречит опытным данным. З а м е ч а н и е. Объём выборки должен быть достаточно велик, во всяком случае n 50 . В каждом частичном интервале (i , i ) должно быть не менее 5-8 вариант xi . Если в каком-нибудь интервале число наблюдений ni 5 , имеет смысл объединить соседние интервалы в один, суммируя частоты. После этого при вычислении числа степеней свободы k m r 1 в качестве величины m берётся соответственно уменьшенное число интервалов. 287 12.10. Условные распределения и регрессии В естественных науках функциональная зависимость между двумя переменными величинами характеризуется тем, что каждому значению одной из них соответствует вполне определённое значение другой. Однако между двумя переменными величинами часто существуют зависимости, когда каждому значению одной переменной соответствует не какое-то определённое, а множество значений другой переменной, причём число значений не является постоянным, а сами значения не отражают определённой закономерности. Иначе говоря, каждому значению одной переменной соответствует определённое (условное) распределение другой переменной. Такая зависимость (связь) получила название статистической. При этом на практике чаще всего ограничиваются изучением изменения среднего значения одной величины при изменении другой; в этом случае статистическую зависимость между двумя переменными величинами называют корреляционной (согласованной). Вероятностный подход к решению подобных задач исходит из предположения, что система двух случайных величин X и Y образует двумерную случайную величину ( X ,Y ) с определённым совместным распределением вероятностей. Её законом распределения является перечень пар чисел ( xi , y j ), где xi и y j (i 1, 2, , n ; j 1, 2, , m) возможные значения величин X и Y , и вероятностей их совместного появления p ( xi , y j ) . Эти значения можно внести в таблицу, которая носит название таблицы распределения двумерной случайной величины (табл. 7), в каждой клетке (i, j ) которой располагаются вероятности произведения событий p ( xi , y j ) P [( X xi )(Y y j )] . Таблица 7 xi yj x1 y1 p ( x1, y1 ) y2 … p ( x1 , y2 ) yj p ( x1 , y j ) … … ym n … x2 … p ( x2 , y1 ) … p ( x2 , y 2 ) … … … p ( x2 , y j ) … xi … m xn p ( xi , y1 ) … p ( xn , y1 ) p ( xi , y2 ) … p ( xn , y2 ) … … … p ( xi , y j ) … p ( xn , y j ) … … … … p ( x1 , ym ) p ( x2 , ym ) … p ( xi , ym ) … p ( xn , ym ) P ( x1 ) … P ( x2 ) … P ( xi ) i 1 288 … P ( xn ) j 1 P ( y1 ) P ( y2 ) … P(y j ) … P ( ym ) 1 Так как события [(X xi )(Y y j )] (i 1, 2, , n; j 1, 2, , m) , состоящие в том, что случайная величина X примет значение xi , а случайная величина Y значение y j , несовместимы и единственно возможны, т. е. образуют полную группу, то сумма вероятностей, помещённых во всех клетках таблицы 7, равна единице. Зная закон распределения двумерной дискретной случайной величины ( X , Y ) , можно найти законы распределения каждой из составляющих. Действительно, например, события [( X x1 )(Y y1 )] , [( X x1 )(Y y2 )] , , [( X x1 )(Y ym )] несовместимы, поэтому вероят- ность P ( x1 ) того, что X примет значение x1 , по принципу сложения вероятностей такова: m P( x1 ) p ( x1 , y1 ) p ( x1 , y 2 ) p ( x1 , y m ) p ( x1 , y j ) . j 1 Таким образом, вероятность того, что X примет значение xi , равна сумме вероятностей «столбца xi ». Аналогично сложив вероятности «строки y j », получим вероятность P( y j ) P (Y y j ) . Допустим, что в результате испытания величина X приняла значение X xi ; при этом Y примет одно из своих возможных значений: y1 , или y2 , , или ym . Обозначим условную вероятность того, что Y примет, например, значение y j при условии, что X xi , через p( y j | xi ) . Условным распределением составляющей Y при X xi называют совокупность условных вероятностей p( y1 | xi ) , p( y2 | xi ) , , p( ym | xi ) , вычисленных в предположении, что событие X xi (i имеет одно и тоже значение при всех значениях Y ) уже наступило. Аналогично определяется условное распределение составляющей X . Согласно определению условной вероятности случайного события (п. 11.2), условный закон распределения составляющей Y определяется соотношением P[( X xi )(Y y j )] p( xi , y j ) . (12.42) p( y j | xi ) P ( X xi ) P( xi ) Аналогично находят условный закон распределения составляющей X : P [( X xi )(Y y j )] p( xi , y j ) . (12.43) p( xi | y j ) P (Y y j ) P( y j ) Из числовых характеристик условного распределения вероятностей величины Y при условии X x практически важным является понятие условного математического ожидания. 289 О п р е д е л е н и е. Условным математическим ожиданием дискретной случайной величины Y при условии X x называют сумму произведений возможных значений Y на их условные вероятности: m M (Y | X x) M (Y | x) y j p ( y j | x) . j 1 (12.44) Условное математическое ожидание M (Y | x) есть функция от x , которая называется регрессией («откликом») величины Y на величину X (или функцией регрессии); обозначим её через (12.45) M (Y | X x) M (Y | x) f ( x) . Аналогично определяется функция регрессии величины X на величину Y : (12.46) M ( X | Y y) M ( X | y ) ( y ) . Функциональная зависимость между значениями одной из переменных и условным математическим ожиданием другой называется корреляционной зависимостью. При этом предполагается, что f ( x) const и ( y) const, т. е. если при изменении x и y условные математические ожидания M (Y | x) и M ( X | y) не изменяются, то говорят, что корреляционная зависимость между переменными величинами X и Y отсутствует. Уравнение y f (x) называется уравнением регрессии Y на X , а график функции регрессии – линией регрессии. Линия регрессии Y на X показывает, как в среднем изменяется величина Y при изменении величины X . Аналогичные понятия используются для функции регрессии X на Y . 12.11. Ковариация и коэффициент корреляции Пусть имеется двумерная случайная величина ( X , Y ) распределение которой известно, т. е. известна таблица 7. Тогда можно найти (см. п. 11.11 и п. 11.12) математические ожидания M ( X ) mx и M (Y ) my и дисперсии D ( X ) 2x и D (Y ) 2y одномерных составляющих X и Y . Однако математические ожидания и дисперсии случайных величин X и Y недостаточно полно характеризуют двумерную случайную величину ( X , Y ) , так как не выражают степени зависимости её составляющих X и Y . Эту роль выполняют ковариация и коэффициент корреляции. О п р е д е л е н и е 1. Ковариацией (или корреляционным моментом) xy случайных величин X и Y называется математическое ожидание произведения отклонений этих величин от своих математических ожиданий, т. е. xy M [(X mx )(Y my )] . (12.47) 290 Из определения следует, что xy yx . Кроме того, xx M [(X mx )2 ] D( X ) , yy M [(Y m y ) 2 ] D(Y ) , т. е. ковариация случайной величины с самой собой есть её дисперсия. Ковариация двух случайных величин характеризует как степень зависимости случайных величин, так и их рассеяние вокруг точки (mx , my ) . Это вытекает из следующих свойств ковариации случайных величин. 1. Ковариация двух независимых случайных величин равна нулю, так как это следует из свойств математического ожидания (см. п. 11.11): xy M [(X mx )(Y my )] M ( X mx ) M (Y my ) 0 0 0 . 2. Ковариация двух случайных величин равна математическому ожиданию их произведения минус произведение математических ожиданий, т. е. xy M ( XY) mx my . (12.48) Действительно, используя свойства математического ожидания из п. 11.11, получим: xy M [( X mx )(Y my )] M ( XY mxY my X mx my ) M ( XY) mx M (Y ) my M ( X ) mx my M ( XY) 2mx my mx my . Отсюда следует равенство (12.48). Из определения ковариации следует, что она имеет размерность, равную произведению размерностей величин X и Y , т. е. зависит от единиц измерения случайных величин. Этого недостатка лишён коэффициент корреляции. О п р е д е л е н и е 2. Коэффициентом корреляции rxy случайных величин X и Y называется отношение ковариации к произведению средних квадратических отклонений этих величин xy M [( X mx )(Y m y )] rxy (12.49) x y M [( X m ) 2 ] M [(Y m ) 2 ] x y M ( XY ) m x m y M ( X 2 ) m x2 M (Y 2 ) m 2y . Очевидно, коэффициент корреляции не зависит от выбора единиц измерения для величин X и Y , т. е. есть величина безразмерная. Он не зависит также и от выбора начал отсчёта при измерении X и Y . Это даёт возможность сравнивать между собой коэффициенты корреляции различных систем случайных величин. Из определения следует, что rxy ryx r . 291 Т е о р е м а. Коэффициент корреляции принимает значения на отрезке [1; 1] , т. е. (12.50) 1 r 1 . В случае r 1 величины X и Y связаны линейной зависимостью: Y aX b (12.51) (a , b const) , причём a 0 ; при r 1 между величинами X и Y имеет место линейная зависимость с коэффициентом a 0 . Д о к а з а т е л ь с т в о. Рассмотрим математическое ожидание o o o o случайной величины (Y t X ) 2 , где Y Y m y , X X mx есть отклонения случайных величин от их математических ожиданий, а t любое действительное число. Имеем: o o o o o o o o o M [(Y t X ) 2 ] M (Y 2 2t Y X t 2 X 2 ) M (Y 2 ) 2t M (Y X ) o t 2 M ( X 2 ) D (Y ) 2t xy t 2 D ( X ) t 22x 2t xy 2y . Мы получили равенство вида o o M [(Y t X ) 2 ] t 2 2 t ; 2x , xy , 2y . (12.52) Квадратный трёхчлен, стоящий в правой части этого равенства, при любом значении t неотрицателен, так как он равен математическому ожиданию случайной величины, принимающей только неотрицательные значения. Отсюда вытекает, что его дискриминант, т. е. выражение 2 , есть число неположительное. Итак: 2 2xy 2x 2y 0 2xy 2x 2y r2 1 . (12.53) Мы пришли к неравенству r 2 1 , означающему, что величина r заключена на отрезке [1; 1] , т. е. 1 r 1 . Предположим теперь, что r 2 1 , т. е. r 1 или r 1 . В этом случае дискриминант квадратного трёхчлена в правой части равенства (12.52) равен нулю. Отсюда вытекает, что трёхчлен имеет действительный корень, т. е. при некотором действительном значении t a выполняется равенство a 2 2 a 0 . Но тогда в силу формулы (12.52) мы должны иметь: o o M [(Y a X ) 2 ] 0 , а это в свою очередь означает: o (12.54) o Ya X 0 Y a X b . (12.55) 292 Нетрудно теперь убедиться, что квадратное уравнение a 2 2 a 0 (12.56) при дискриминанте 0 имеет единственный корень 2 a y xy , 2 r x x r 1 . (12.57) В этом случае a 0 , когда r 1 ; если r 1 , то a 0 при x 0 . Теорема доказана полностью. С л е д с т в и е. Линейная зависимость (12.51), как следует из доказательства теоремы, в более симметричной записи принимает вид: y (12.58) Y my r ( X mx ) , r 1 . x Установленные свойства коэффициента корреляции r дают основание для некоторого качественного заключения, а именно: близость r 2 к единице есть признак того, что зависимость Y f (X ) между X и Y близка к линейной. Если при этом r 0 , то с возрастанием X возрастает в среднем и Y , тогда говорят о положительной корреляции между величинами X и Y ; если же r 0 , то при возрастании X величина Y в среднем убывает (отрицательная корреляция). Иллюстрацией служит рис. 94, называемый полем корреляции. Y Y 0 X Сильная положительная корреляция Y X 0 Слабая положительная корреляция X 0 Отрицательная корреляция Рис. 94 Точки на этом рисунке изображают результаты наблюдений над системой ( X , Y ) ; каждое наблюдение даёт пару значений ( xi , yi ) , т. е. точку на плоскости. Для качественной оценки тесноты линейной корреляционной связи между случайными величинами можно пользоваться таблицей 8 (Чеддока): Таблица 8 Диапазон из0,1 – 0,3 0,3 – 0,5 0,5 – 0,7 0,7 – 0,9 0,9 – 0,99 1,0 менения | r | Теснота УмеренВесьма ЛинейСлабая Заметная Сильная связей ная сильная ная 293 12.12. Уравнения прямых регрессии и статистические оценки их параметров Наиболее простым случаем корреляционной зависимости является тот, при котором обе функции регрессии (см. п. 12.10) f ( x) M (Y | x) и ( y) M ( X | y) линейны, так что обе линии регрессии будут прямыми линиями; они называются прямыми регрессии. В этом случае говорят о линейной корреляции между случайными величинами X и Y . Выведем уравнения прямых регрессии. Будем искать параметры A и B линейной регрессии Y на X в виде (12.59) f ( x) A( x mx ) B . Используем основное свойство регрессии: если f (x) есть функция регрессии величины Y на величину X , то математическое ожидание квадрата отклонения величины Y от функции f (X ) меньше, чем от любой другой функции h (X ) : M [(Y f ( X )) 2 ] M [(Y h ( X )) 2 ] . (12.60) Непосредственным следствием этого свойства является то, что математическое ожидание величины Y совпадает с математическим ожиданием функции f (X ) : (12.61) M (Y ) M [ f ( X )] . Подставляя сюда линейную функцию f ( X ) A ( X mx ) B и учитывая, что M ( X mx ) 0 , найдём последовательно my M (Y ) M [ f ( X )] A M ( X mx ) M ( B) B , xy M [(X mx )(Y my )] M [(X mx )( f ( X ) my )] A M [( X mx ) 2 ] A2x , откуда получаем xy y . A 2 r x x Таким образом, в случае линейной корреляции функция регрессии Y на X имеет вид y f ( x) r ( x mx ) m y . (12.62) x Аналогично функция регрессии X на Y примет вид ( y ) r x ( y m y ) mx . (12.63) y После этого уравнения обеих прямых регрессии запишутся в форме: 294 y ( x mx ) прямая регрессии Y на X , x x mx r x ( y m y ) прямая регрессии X на Y . y y my r (12.64) (12.65) Из уравнений прямых регрессии видно, что обе эти прямые проходят через точку (mx , my ) центр совместного распределения X и Y . Угловые коэффициенты прямых регрессии и тангенс угла между прямыми равны соответственно значениям (рис. 95): y 1 r 2 x y 1 y 2 , tg , tg . (12.66) tg r r x r x x 2y y my Регрессия X на Y Регрессия Y на X 0 mx x Рис. 95 Если 0 | r | 1 , то | r | 1/ | r | , поэтому прямая регрессии Y на X имеет меньший угол наклона к оси Ox, чем прямая регрессии X на Y . Чем ближе | r | к 1, тем меньше угол между этими прямыми; при | r | 1 прямые регрессии сливаются, а их уравнения (12.64) и (12.65) совпадают. При r 0 прямые регрессии имеют уравнения y my и x mx , так как обе они параллельны соответствующим осям координат. В этом случае величины X и Y называются некоррелированными, для них (12.67) M (Y | X x) M (Y ) my , M ( X | Y y) M ( X ) mx , т. е. условные математические ожидания совпадают с безусловными. Для оценки коэффициента корреляции r между двумя случайными величинами X и Y и параметров m x , m y , x , y прямых регрессии производят ряд независимых испытаний (экспериментов, наблюдений), исходом каждого из которых является пара величин ( xi , yi ) (i 1, 2, , n) ; двумерные величины ( x1 , y1 ) , ( x2 , y2 ) , , ( xn , yn ) независимы и следуют тому же распределению, что и двумерная величина ( X , Y ) . Как мы уже знаем из п. 12.5, несмещёнными и состоятельными оценками центров распределений m x , m y и дисперсий 2x , 2y служат 295 выборочные средние и «исправленные» выборочные дисперсии (п. 12.5): 1 n 1 n (12.68) x в xi , y в yi , n i1 n i 1 1 n 1 n (12.69) s x2 ( x x в ) 2 , s 2y n 1 ( yi y в ) 2 . n 1 i1 i i 1 В качестве несмещённой и состоятельной оценки корреляционного момента xy (ковариации) может служить выборочный корреляционный момент xy : 1 n (12.70) ( x x в )( yi y в ) , n 1 i1 i так как проверка несмещённости этой оценки приводит к равенству 1 n (12.71) M ( xi x в )( yi y в ) xy , n 1 i 1 что и означает несмещённость оценки (12.70). С помощью полученных оценок s x , s y , xy параметров x , y , xy xy рассчитывают выборочный коэффициент корреляции n xy rв sx s y ( xi x в )( yi y в ) i 1 n ( xi x в ) i 1 , 2 n ( yi y в ) (12.72) 2 i 1 который и применяют в качестве точечной оценки коэффициента корреляции r . Выборочный коэффициент корреляции rв даёт смещённую оценку теоретического коэффициента корреляции r ; смещение оценки убывает с увеличением числа n и стремится к нулю при n ∞. Заменяя теперь в уравнениях (12.64), (12.65) прямых регрессии все теоретические параметры на значения соответствующих выборочных оценок, мы получаем уравнения выборочных прямых регрессии: sy y y в rв ( x x в ) выборочная прямая регрессии Y на X , (12.73) sx sx x x в rв ( y y в ) выборочная прямая регрессии X на Y . (12.74) sy Выборочный коэффициент корреляции по абсолютной величине не превосходит 1, т. е. | rв | 1 , причём он достигает крайних значений 1 только в том случае, когда все точки ( xi , yi ) лежат на одной прямой. Равенство rв 0 говорит лишь об отсутствии линейной корреляционной зависимости, но не вообще об отсутствии корреляционной, а тем более статистической, зависимости. 296