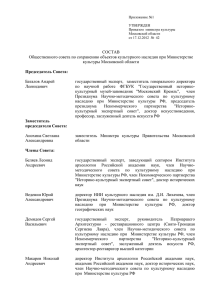

К вопросу о навигации по массивам данных

реклама

Д.В. Хворостин Челябинский государственный университет (Миасс) E-mail: konf-csu@narod.ru К вопросу о навигации по массивам данных на основе глубинного анализа электронных документов 0. Введение. Виртуальная реальность, отличная от реальности действительной, породила специфический тип текста – гипертекст, не имеющий начала и конца, элементы которого зачастую связаны между собой причудливыми переходами. В чистом виде таким гипертекстом в современном мире является интернет, потенциально способный облегчить доступ к культурному и научному наследию любого народа или народности. Приметой времени стало создание многочисленных электронных библиотек (массивов данных), в которых аккумулируются тексты, иллюстрации, аудиои видеозаписи. Оцифровываются шедевры культуры, создаются их электронные репродукции. Процесс оцифровки культурного наследия закономерно (поскольку цель в данном случае – обеспечить доступ к информации) должен вылиться в объединение электронных библиотек в рамках единой сети. Такой сетью, доступной в любой точке планеты, является интернет. Но процесс интеграции электронных библиотек в интернет-пространство порождает целый ряд проблем, связанных со спецификой гипертекста и современной информационной среды в целом. Прежде всего, мы имеем в виду разработку и создание средств для удобной навигации по электронным базам данных. Рост общего числа электронных документов создаёт значительный информационный шум; найти нужную информацию в нём зачастую не представляется возможным. Кроме того, учёные и искусствоведы уже озабочены вопросом, увеличил ли свободный доступ к шедеврам мировой культуры интерес общества к ним? Отметим заранее, что речь ниже пойдёт об анализе текстовой информации. 1. Общие требования к электронным документам. К электронным текстам изначально целесообразно предъявлять ряд требований. Во-первых, они должны максимально соответствовать бумажному оригиналу, независимо от настроек компьютера. Во-вторых, по возможности занимать минимум дискового пространства. В-третьих, обладать возможностью быть проиндексированными (по этим документам можно организовать контекстный поиск). Первое требование обусловлено тем, что тексты цитируются (точность отсылок к оригиналу в научном сообществе трудно переоценить). Во многих интернетбиблиотеках (например, в Библиотеке М. Мошкова, http://www.lib.ru) представленные в формате TXT тексты не имеют разбивки на страницы, графические элементы (выделение значимых элементов текста полужирным шрифтом, крусивом) не используются, что создаёт определённые сложности при использовании электронного документа. Тексты же, в которых изначально большую роль играет пространственное расположение текста, перестают оказывать на читателя эстетическое воздействие. Преимущество же формата TXT заключается в том, что файлы занимают мало места (так, все четыре тома «Толкового словаря живого великорусского языка» В.И. Даля занимают 17,5 Мб дискового пространства). Использовать графические элементы при сохранении размера файла позволяет формат HTML. Сложность при его использовании возникает из-за существования в интернет различных кодировок (windows-1251, utf-8, koi8-r, koi8-u и проч.). Несмотря на то, что многие программы для работы с интернет (броузеры) способны автоматически определять кодировку и приводить текст к “читабельному” виду, иногда алгоритмы перекодировки дают сбой. Из-за этого некоторые текста имеют вид беспорядочного набора символов, что вряд ли приемлемо. В настоящее время создать максимально точную копию бумажного текста позволяют два формата: PDF и DJVU. Наибольшее распространение в интернет получил первый из них. Причём если при оцифровке текст распознаётся, то это существенно сокращает объём файла и позволяет этот файл проиндексировать (т.е. организовать по нему контекстный поиск), что очень важно. Проиллюстрируем это простым примером. Поиск информации в электронных базах данных (частным случаем является поиск информации в интернет) идёт по ключевым словам. Результаты поиска выдаются “по релевантности”, т.е. с учётом соотношения повторяемости этих слов к общему объёму текста. Иными словами, если в аннотации к тексту, действительно важном для учёного, ключевое слово встречается лишь однажды, а на странице интернет-магазина оно употребляется несколько раз, то ссылка на необходимый текст затеряется в многочисленной рекламе и обзорах книжных новинок. С учётом того, что совокупное число страниц в интернет приближается к 10 млрд., проблема информационного шума стоит довольно остро. Кроме того, формат PDF позволяет сохранять авторские права и, что также важно, вид текста в PDF-файлах не зависит от настроек компьютера. 2. Создание единой базы данных. Наиболее простым решением проблемы доступа к культурному и научному наследию может показаться создание единой базы данных, своего рода электронной Александрийской библиотеки. Здесь мы сталкиваемся с целым рядом трудностей. Прежде всего, возможен крах системы (например, в случае атаки комьютерных вирусов, которая может привести к потере всех электронных документов или значительной их части). Но если эту проблему ещё можно решить (создавая копии, дублируя хранилище на разных серверах), то проблему кодировок и совместимости различных языков решить гораздо труднее. Проблема, которая наиболее остро стоит перед разработчиками программного обеспечения – это размещение на одной платформе документов на различных языках и создание поисковой системы, которая адекватно работает со всеми языками. Первую проблему решает в той или иной мере использование формата PDF. Решение второй (мультиязычный поиск, мультиязычная поддержка) пока не найдено. Технологически уже сегодня мы можем получить доступ к интернетпространству Таиланда, Китая или Японии, но способны ли мы найти там необходимую нам информацию? Мы составляем представление культуре и науке этих стран по английским версиям интернет-страниц, но где гарантия, что действительно важная информация представлена не только на китайском или японском языках, но и на английском? Вынужден констатировать, что в силу технологических причин (пользователь компьютера ограничен при доступе к интернет двумя языками – теми, что есть на клавиатуре: родным и английским), англо-американская культура и наука оказались в привилегированном положении. Признаком хорошего тона являются в научных работах ссылки на зарубежные источники, что подразумевает включённость учёного в мировое научное сообщество. Но на какие работы при этом ссылаются авторы? Часто – на работы на английском языке, реже – на французском, немецком, испанском. Как много ссылок в отечественных исследованиях на японских или китайских учёных? Я попросил бы уважаемых коллег со всей серьёзностью отнестись к этой проблеме, поскольку развитие интернет не изменило картины и говорить о едином информационном поле пока преждевременно. В какой-то мере такой “Александрийской библиотекой” являются индексы крупнейших поисковых систем (например, Google, http://www.google.com, роботами которого проиндексирована треть информации, размещённой в интернет). Исходя из этого, я особое внимание уделил бы совершенствованию механизмов поиска информации в уже созданных базах данных (в индексе того же Google). Создание же отдельных библиотек должно пониматься лишь как способ пополнения этих баз данных информацией, имеющей культурную и научную ценность. В связи с этим встаёт проблема “продвижения” библиотек в интернет-пространстве, иначе они затеряются среди миллионов других порталов, сайтов и “домашних страниц”. Переформулировав многочисленные высказывания по этому поводу, отмечу, что важно не только обеспечить свободный доступ к шедеврам мировой культуры, но и “спровоцировать” интерес общества к ним. Анализ результатов поисковых запросов позволяет утверждать, что в развитии любой базы данных рано или поздно наступает момент, когда поиск нужного документа будет чрезвычайно затруднён. Во-первых, процесс оцифровки культурного наследия автоматизируется; во-вторых, имеет создаются копии не только бумажных, но и электронных текстов, т.к. некоторые из новейших достижений культуры существуют только в электронной версии (например, flash-анимация). В любом случае, при автоматизации отбора материала возникает риск “замусорить” базу данных ненужной информацией. Отметим, что этой проблемой уже озаботились разработчики широкоизвестных поисковых систем (таких как Яndex, http://www.yandex.ru), работающие над созданием алгоритмов для автоматического выявления ангажированных и рекламных текстов. Проблема информационной насыщенности имеет ещё один аспект. Дело в том, носителем информации становится сама информация. Для большой части англоязычного интернета характерно наличие ссылок на электронный магазин “Amazon.com”, причём часто границы между собственно текстом и рекламой размыты. Поиск необходимой информации становится всё более и более затруднительным: с одной стороны, можно отметить рост объёма доступной информации, с другой — низкое качество значительной её части. Неспособность определить, какая информация действительно важна, а какая нет, приводит к тому, что по поводу даже самых насущных жизненных вопросов становится всё труднее выработать самостоятельное суждение: “Ежедневно поступающая масса сведений, фактов, оценок, рекомендаций, которые нередко противоречат друг другу и которые человеческое сознание не успевает как следует переварить, порождает “интеллектуальную диспепсию”, сбивает человека с толку и не даёт возможности самоопределиться — ни в интеллектуальном, познавательном, ни в нравственном отношении” [1: 189]. Решение проблемы доступа к электронному культурному и научному наследию видится нам в разработке интеллектуальных поисково-аналитических программ. 3. Глубинный анализ электронных документов. Интеллектуальные поисковоаналитические программы, о которых было сказано выше, должны не просто находить все документы, удовлетворяющие условиям запроса, а обрабатывать массив данных, выстраивая связи между документами и определяя важность того или иного документа. В итоге, использование таких анализаторов должно помочь свести к минимуму информационный шум в результатах поиска. Сегодня можно прогнозировать рост информационного мусора в интернет – документов, содержащих ключевые слова, фрагменты текстов и т.д. Такой информационный мусор принято называть термином “дорвей” (doorway). Цель – завести как можно больше пользователей сети интернет на свои страницы. Приём прост: владелец сайта обращается к одному из сайтов-советчиков, которые не только подскажут сколько раз в минувшем месяце запрашивалась отдельная ключевая фраза, но и предоставят список альтернативных терминов (пример такого сайта: http://inventory.overture.com/d/searchinventory/suggestion/), а потом размещает популярную информацию на своём сайте. Это необычайно затрудняет поиск действительно нужной информации [7, 8]. Одним из путей решения этой проблемы является лингвостатистический подход. Прежде всего, вычленяется дублирующаяся информация и при чрезмерной густоте ключевых слов поисковый робот может отказать в индексировании страницы. Более того, предполагается, что для текстов разных жанров характерна различная частота употребления тех или иных слов и выражений. На основе предварительно отобранных администратором образцов текстов, программа способна автоматически категоризировать сообщения и применять к ним соответствующие действия: включать их в индекс или игнорировать. Второй путь – “овеществление” подтекста. Программы-анализаторы, как нам представляется, должны сопоставлять эксплицитную и имплицитную информацию, и на результате этого сопоставления включать или не включать документ в результаты поиска. Исследования в области неассетривных (неявных) компонентов смысла, позволили нам выделить ряд “маркеров”, сигнализирующих о наличии в тексте определённой (не выраженной явно) информации. Регулярность и устойчивость связи между этими “маркерами” и имплицитной информацией позволяют предположить, что эксплицирование в большинстве случаев возможно по некоему, заранее заданному алгоритму. В результате взаимосвязанности объектов и явлений действительности, в значении слова возникает некая периферия семантических признаков, окружающих содержательное ядро лексического значения. Сопоставление этой “перефирии” для разных фрагментов текста позволит определить важность текста для пользователя. Интересный механизм – механизм ассоциаций – предложен разработчиками поисковой системы Rambler (http://www.rambler.ru). Набрав в поисковой строке нужное слово, вы нажимаете на кнопку “найти”. Открывается ответная страница, на которой найденные документы расположены в порядке убывания релевантности (соответствия запросу). На этой же странице в самом низу – строка “У нас также ищут”. В ней приведено несколько слов и словосочетаний, тематически (ассоциативно) связанных с исходным запросом. Например, на слово “Джоконда” в строке “У нас также ищут” выдаются результаты: Джаконда, картина Джоконда, Мона Лиза... Если нажать на кнопку “Еще”, возникает целый блок ассоциаций, более развернутый (см. рисунок). Можно, нажав на любое слово из списка, продолжить поиск [9]. С помощью механизма ассоциаций пользователь может быстро уточнить или расширить свой запрос. Дальнейшее развитие механизма ассоциаций возможно в следующем направлении: чем больше фраз, соответствующих некоему тематическому запросу, находится на сайте, тем большую ценность он представляет для пользователя (естественно, если речь не идёт о чрезмерной густоте ключевых слов). Слабое место алгоритма в том, что он выдаёт ассоциации только на те запросы, которые делаются достаточно часто. При узкоспециализированных запросах (например, при поиске научных статей) ассоциаций может не быть. Решение нам видится в интегрирования в поисковую систему различных словарей и энциклопедий. Элементы мирового контента и интернет-пространства (как составной его части) обладают интертекстуальными свойствами: для понимания текста необходимо обращение к другим, вспомогательным текстам. Такими вспомогательными текстами является справочная литература. Очевидна необходимость интегрирования в поисковые системы словаря синонимов (так на запрос “лингвистика” кроме соответствующих ссылок поисковая программа может выдать ссылки и на слово “языкознание”) и иностранных словарей (“linguistics”), ассоциативных словарей. Необходимо составление баз данных гипонимов и гиперонимов. Так, слово “чёрный” влечёт за собой понятие “цвет” и, напротив, слово “цвет” влечёт за собой ряд гипонимов: “красный”, “оранжевый”, “жёлтый” и т.д. В свете вышесказанного ясно, что необходим переход к глубинному анализу текстов, к анализу смысла, а не его материального выражения. Оговоримся, однако, что речь идёт не о понимании текста, а об особой его обработке: модификацию текстов путём замены одних элементов текста на другие. Литература: 1. Гайденко, П.П. Информация и знание // Философия науки / РАН. Ин-т. философии. – М., 1997. – Вып. 3: Проблемы анализа знания. – С. 185-192. 2. Вимер, Б. Пресуппозиции и импликатуры в толкованиях предельных событий и соотносимых с ними процессов // Научно-техническая информация. Сер. 2. Информационные процессы и системы, 2000, № 1. С. 31-43. 3. Долинин, К.А. Имплицитное содержание высказывания // Вопр. языкознания, 1983, № 6. С. 37-47. 4. Ермаков, А.Е. Эксплицирование элементов смысла текста средствами синтаксического анализа-синтеза // http://www.dialog-21.ru/Archive/2003/Ermakov.htm. 5. Никитин, М.В. Основы лингвистической теории значения. М., 1988. 6. Падучева, Е.В. Семантические исследования (Семантика времени и вида в русском языке; Семантика нарратива). М., 1996. 7. Рой, С. Технология клоакинга // http://promo.by/searchengines/cloaking.html 8. Салливан, Д. Конец спора о клоакинге // http://www.ibusiness.ru/project/inter/24492/. 9. Поиск Rambler: новый механизм ассоциаций // http://www.rambler.ru/doc/about.shtml#search.