Свойства апостериорного распределения модели

реклама

c 2013 г.

А.А. Зайцев

(Datadvance, Институт проблем передачи информации имени А.А.

Харкевича),

Е.В. Бурнаев, канд. физ.-мат. наук

(Datadvance, Институт проблем передачи информации имени А.А.

Харкевича, Premolab, Московский физико-технический институт),

В.Г. Спокойный, д.ф.-м.н.

(Weierstrass Institute (WIAS) Berlin, Germany, Premolab, Московский

физико-технический институт)

Свойства апостериорного распределения модели зависимости

на основе гауссовских случайных полей1

Рассматривается задача построения регрессии на основе гауссовских процессов. Предполагается, что априорное распределение вектора параметров соответствующей модели ковариационной функции является неинформативным. При таком предположении доказана теорема Бернштейнафон Мизеса о близости апостериорного распределения вектора параметров к соответствующему нормальному распределению. Также приведены

результаты вычислительных экспериментов, подтверждающие применимость полученных результатов для практически важных случаев.

1. Введение

Гауссовские процессы широко применяются для решения задачи восстановления

регрессии [14, 2, 7]. Предполагается, что наблюдаемая выборка значений функции

в фиксированных точках пространства дизайна является реализацией гауссовского

процесса, распределение которого полностью определяется априорно задаваемыми

функцией математического ожидания и функцией ковариации. Считается, что ковариационная функция между значениями реализации зависит только от точек, в

которых сделаны наблюдения. В таком случае прогноз значения функции в новой

точке обычно делается с помощью апостериорного (относительно известной выборки

значений функции) математического ожидания процесса, которое равно взвешенной

сумме известных значений функции, причем веса в сумме определяются взаимными

ковариациями значений функции в новой точке и точках выборки [14].

Обычно предполагают, что ковариационная функция гауссовского процесса принадлежит некоторому параметрическому семейству [14], параметры которого характеризуются априорным распределением [1, 9, 13]. Соответственно, апостериорное распределение параметров (относительно известной выборки значений процесса) будет

пропорционально произведению правдоподобия данных, также зависящего от параметров ковариационной функции, и заданного априорного распределения параметров.

1

Работа выполнена при поддержке лаборатории структурных методов анализа данных в предсказательном моделировании, МФТИ, грант правительства РФ дог. 11.G34.31.0073; РФФИ, грант

13-01-00521.

1

Согласно широко известной теореме Бернштейна-фон Мизисе (БфМ) апостериорное распределение является асимптотически нормальным со средним, близким к

Оценке Максимума Правдоподобия (ОМП), и матрицей ковариаций, близкой к матрице ковариаций ОМП. Именно по этой причине данная теорема часто рассматривается в качестве байесовского дополнения к теореме Фишера об асимптотической

нормальности ОМП. Теорема БфМ обеспечивает теоретическое основание для различных байесовских процедур, например, использования байесовского вывода для

оценки ОМП и ее матрицы ковариаций, построения эллиптических доверительных

множеств на основе первых двух моментов апостериорного распределения, и т.д.

Классическая версия теоремы БфМ формулируется для случая, когда параметрическое предположение о модели данных верно, а размер выборки — стремится к

бесконечности. Именно в такой постановке до сих пор изучаются свойства апостериорного распределения вектора параметров ковариационной функции, см., например, [8, 6, 16]. Однако, для практически важных случаев необходимо рассматривать

ситуации, в которых размер выборки ограничен, а исходное параметрическое предположение о ковариационной функции гауссовского процесса может не выполняться

(на практике невозможно установить истинную природу функции, модель которой

мы строим).

В [17, 18] разработаны методы, позволяющие доказать теорему БфМ при достаточно общих предположениях в случае ограниченной выборки и возможной ошибочности исходного параметрического предположения о модели. В данной работе эти методы адаптированы для рассматриваемой модели гауссовского процесса и применены

для исследования свойств апостериорного распределения вектора параметров ковариационной функции. А именно, доказана теорема БфМ о близости апостериорного

распределения вектора параметров ковариационной функции к соответствующему

нормальному распределению в случае неинформативного априорного распределения

вектора параметров. В том числе показано, что среднее значение апостериорного распределения вектора параметров близко к оценке максимума правдоподобия (ОМП),

а матрица ковариаций — близка к матрице ковариаций ОМП.

Работа устроена следующим образом. В следующем разделе описана процедура

восстановления регрессии на основе гауссовских процессов. В третьем разделе приведены полученные теоретические результаты. В четвертом разделе описаны проведенные вычислительные эксперименты. В приложении представлен план доказательства

полученных теоретических результатов.

2. Регрессия на основе гауссовских процессов

Решается следующая задача. Предполагается, что задана выборка значений неизвестной функции D = (X, y) = {xi , y(xi ) = yi }ni=1 , x ∈ X ⊆ Rd . Необходимо построить

по выборке D размера n аппроксимацию yb(x) функции y(x).

Будем считать, что функция y(x) является реализацией гауссовского процесса.

Без ограничения общности положим среднее значение этого гауссовского процесса

равным нулю. В таком случае совместное распределение вектора значений y имеет

вид y ∝ N (0, K), где K — некоторая положительно определенная ковариационная

матрица, вообще говоря, зависящая от выборки D.

Предположим, что ковариация между произвольными значениями гауссовского

2

процесса задается некоторой ковариационной функцией cov(y(x), y(x0 )) = k(x, x0 ).

Тогда ковариационная матрица значений выборки D имеет вид K = {k(xi , xj )}ni,j=1 .

Для гауссовского случайного процесса апостериорное распределение значения реализации y(x) в новой точке x ∈ Rd будет нормальным при фиксированной ковариационной функции

p(y(x)|D) = N (µ(x), σ 2 (x)).

Выражения для математического ожидания µ(x) и дисперсии σ 2 (x) апостериорного

распределения p(y(x)|D) выписываются в явном виде:

µ(x) = kT (x)K −1 y,

σ 2 (x) = k(x, x) − kT (x)K −1 k(x).

Здесь k(x) = (k(x, x1 ), . . . , k(x, xn ))T — вектор-столбец из ковариаций между значением y(x) случайного процесса в точке x и значениями y(x1 ), . . . , y(xn ) случайного

процесса в точках выборки x1 , . . . , xn . Апостериорное математическое ожидание µ(x)

используется в качестве прогноза yb(x) значения процессе y(x), а апостериорная дисперсия σ 2 (x) служит оценкой неопределенности прогноза.

На практике для моделирования ковариационной функции обычно используют

некоторое параметрическое семейство ковариационных функций kθ (x, x0 ), θ ∈ Θ ⊆

Rp , где Θ — некоторое компактное множество. В таком случае для построения регрессии на основе гауссовских процессов необходимо оценить вектор параметров θ

ковариационной функции kθ (x, x0 ). Естественно, нет никаких оснований полагать,

что параметрическое предположение о ковариационной функции гауссовского процесса выполняется, то есть, вообще говоря, k(x, x0 ) 6∈ {kθ (x, x0 ), θ ∈ Θ ⊆ Rp }.

Совместное распределение вектора известных значений y будет нормальным. Тогда логарифм (квази-) правдоподобия данных имеет вид

(1)

L(θ) = −

1

n log 2π + ln |Kθ | + yT Kθ−1 y ,

2

где Kθ = {kθ (xi , xj )}ni,j=1 .

В качестве оценки вектора параметров θ часто используют оценку максимального

(квази-) правдоподобия

e = argmax L(θ).

θ

θ∈Θ

Пусть так же задано некоторое априорное распределение Π(dθ) для вектора

параметров θ . Тогда апостериорное распределение при заданной выборке D будет

описывать условное распределение случайного вектора ϑ . Обычно, это соотношение

записывают в виде

(2)

ϑ D ∝ exp L(θ) Π(dθ).

Цель данной работы состоит в том, чтобы изучить свойства апостериорного распределения ϑ D. Отметим, что максимум апостериорного распределения может использоваться в качестве характерного значения (оценки) вектора параметров θ .

3

3. Cвойства апостериорного распределения вектора параметров

ковариационной функции

В дальнейшем мы будем изучать вероятностные свойства апостериорного распределения вектора параметров θ для случая неинформативного априорного распределение Π(dθ) .

3.1. Предположения о ковариационной функции

Введем обозначение для центральной точки θ ∗

def

θ ∗ = argmax IEL(θ).

θ∈Θ

Для того, чтобы описать свойства полученного апостериорного распределения,

необходимо наложить ряд ограничений на множество X ∈ X , ковариационную функцию kθ (x, x0 ) и соответствующие ковариационные матрицы Kθ и K.

Положим

D02 = −∇2 IEL(θ ∗ ), V02 = Var {∇L(θ ∗ )} .

Здесь D02 играет роль матрицы информации Фишера. Перечислим используемые в

работе предположения:

— Ковариационная функция kθ (x, x0 ) трижды непрерывно дифференцируема по

θ ∈ Θ для x, x0 ∈ X.

— Минимальные собственные числа матриц K и Kθ больше некоторого λ0 > 0, а

их максимальные

собственные числа не превосходят некоторое λ0 < ∞.

∂Kθ — ∂θi < λ1 < ∞ для всех θ ∈ Θ, i = 1, p.

2 2

∂ Kθ — ∂θ

< λ2 < ∞ для всех θ ∈ Θ, i, j = 1, p.

j 2

i ∂θ

2

θ

— ∂θ∂i ∂θKj ∂θ

< λ3 < ∞ для всех θ ∈ Θ, i, j, k = 1, p.

k

2

— Минимальное собственное число матрицы n1 D02 больше, чем некоторое d0 > 0.

— Вектор θ ∗ = argmaxθ∈Θ IEL(θ) существует.

— Найдется r > 0, такое, что для θ ∈

/ Θ0 (r) = {θ : kV0 (θ − θ ∗ )k 6 r} выполнено

|Kθ∗ |

∗

−1

IEL(θ) − IEL(θ ) = log

+ tr (Kθ−1

6= 0.

∗ − Kθ )K

|Kθ |

Отметим, что в данной работе не предполагается выполнимость параметрического

предположения, то есть, может оказаться, что k(x, x0 ) 6∈ {kθ (x, x0 ), θ ∈ Θ ⊆ Rp }.

3.2. Квадратичная экспоненциальная ковариационная функция

Рассмотрим пример параметрического класса ковариационных функций, а именно, квадратичную экспоненциальную ковариационную функцию [14]

!

n

X

1

θi (xi − x0i )2 + σ 2 δ(x − x0 ),

(3)

kθ (x, x0 ) = exp −

2 i=1

4

где δ(·) обозначает функцию Кронекера. Первое слагаемое в (3) задает ковариацию

между значениями реализации гауссовского процесса в точках пространства, второе слагаемое — определяет уровень дисперсии нормально распределенного шума в

данных.

Для квадратичной экспоненциальной ковариационной функции выполнение условий, перечисленных в разделе 3.1, обеспечивается выбором достаточно хорошего дизайна X и величины уровня шума σ 2 > σ02 > 0, играющего роль параметра регуляризации в соответствующей ковариационной матрице Kθ .

В случае использования этого класса ковариационных

функций необходимо оцеQ

нить вектор параметров θ = {θ1 , . . . , θp } ∈ Θ = pi=1 (θmin,i , θmax,i ) (при этом d = p).

Отметим, что часто используются различные параметризации вектора параметров

θ [10, 12], позволяющие улучшить аппроксимацию апостериорного распределения

соответствующим нормальным распределением.

3.3. Свойства апостериорного распределения вектора параметров θ

Обозначим через C — универсальную абсолютную константу, которая в разных

формулах может принимать разные значения. Также пусть зафиксирована достаточно большая константа x = xn , растущая при увеличении n.

Обозначим через Ωn случайное событие с доминирующей вероятностью, такое,

что

IP Ωn > 1 − Ce−xn .

Определим величины

def

ϑ = IE ϑ D ,

2 def

def

S = Cov(ϑ) = IE

n

> o

ϑ − ϑ ϑ − ϑ D ,

играющие роль апостериорного среднего значения и апостериорной ковариационной

матрицы случайного вектора ϑ.

Верно следующее обобщение теоремы БфМ.

Т е о р е м а 1. Пусть выполнены условия из раздела 3.1. Тогда найдутся величина

τ и случайное событие Ωn с доминирующей вероятностью, такие, что на Ωn

выполнены неравенства

2

e (4)

D0 ϑ − θ

6 Cτ (p + x) ,

Ip − D0 S2 D0 6 Cτ (p + x) ,

(5)

∞

при этом величина τ (p + x) мала и уменьшается при увеличении n.

Кроме того, для произвольного λ ∈ Rp с kλk2 6 (p + x) выполнено неравенство

> −1

2

(6)

ϑ−ϑ

D − kλk /2 6 Cτ (p + x).

log IE exp λ S

Выражения (4) и (5) показывают, что среднее значение ϑ и матрица ковариаций

e и матрице D−2 соответственно,

S апостериорного распределения близки к ОМП θ

0

а уравнение (6) описывает близость апостериорного распределения к соответствующему нормальному распределению.

2

5

4. Вычислительный эксперимент

4.1. Генерация данных

Для простоты будем считать, что истинная ковариационная функция k(x, x0 )

принадлежит семейству квадратичных экспоненциальных ковариационных функций

kθ (x, x0 ) (3). Дисперсию шума будем считать известной и равной σ 2 = 0.01, а априорноеQраспределение вектора параметров — равномерным на заданном гиперкубе

Θ = pi=1 (θmin,i , θmax,i ) . Такое неинформативное априорное распределение не искажает форму исходного правдоподобия в окрестности точки θ ∗ ∈ Θ .

Пусть выбраны истинное значение вектора параметров θ ∗ , точки из набора X

принадлежат гиперкубу X = [0, 1]d . Тогда совместное распределение вектора значений y будет многомерным нормальным с нулевым математическим ожиданием и

ковариационной матрицей Kθ∗ = {kθ∗ (xi , xj )}ni,j=1 .

Генерация отдельной выборки для произвольного θ ∈ Θ проводится следующим

образом:

— Пусть зафиксирована ковариационная функция kθ (x, x0 ) и ее параметры θ,

— Сгенерируем набор точек X = {xi }ni=1 фиксированного размера n, например,

используя равномерное распределение на гиперкубе X = [0, 1]d ,

— Сгенерируем распределенный нормально вектор y с нулевым математическим

ожиданием и ковариационной матрицей Kθ = {kθ (xi , xj )}ni,j=1 в точках X,

— Вектор y будет реализацией гауссовского процесса с фиксированной ковариационной функцией kθ (x, x0 ).

4.2. Вид апостериорного распределения данных

В работе [10] показано, что существуют такие ковариационные функции и расположение точек пространства дизайна, что зачастую апостериорное распределение

выборки, порождаемой соответствующим гауссовским процессом, имеет максимум в

нуле или в бесконечности. Так же в работе [10] приведены аналитические примеры,

в которых у функции правдоподобия данных есть локальный максимум, который не

является глобальным.

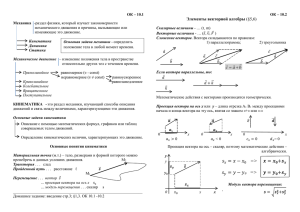

Зависимость плотности апостериорного распределения от значения параметра θ

приведена на рисунке 1. Показаны два случая:

— у апостериорной плотности один максимум, который находится не в нуле (стандартный случай),

— апостериорная плотность имеет локальный максимум, который находится в

нуле или бесконечности. Отметим, что в этом случае нарушается условие невырожденности соответствующей ковариационной матрицы.

Видно, что в первом случае апостериорная плотность достаточно близка к нормальной.

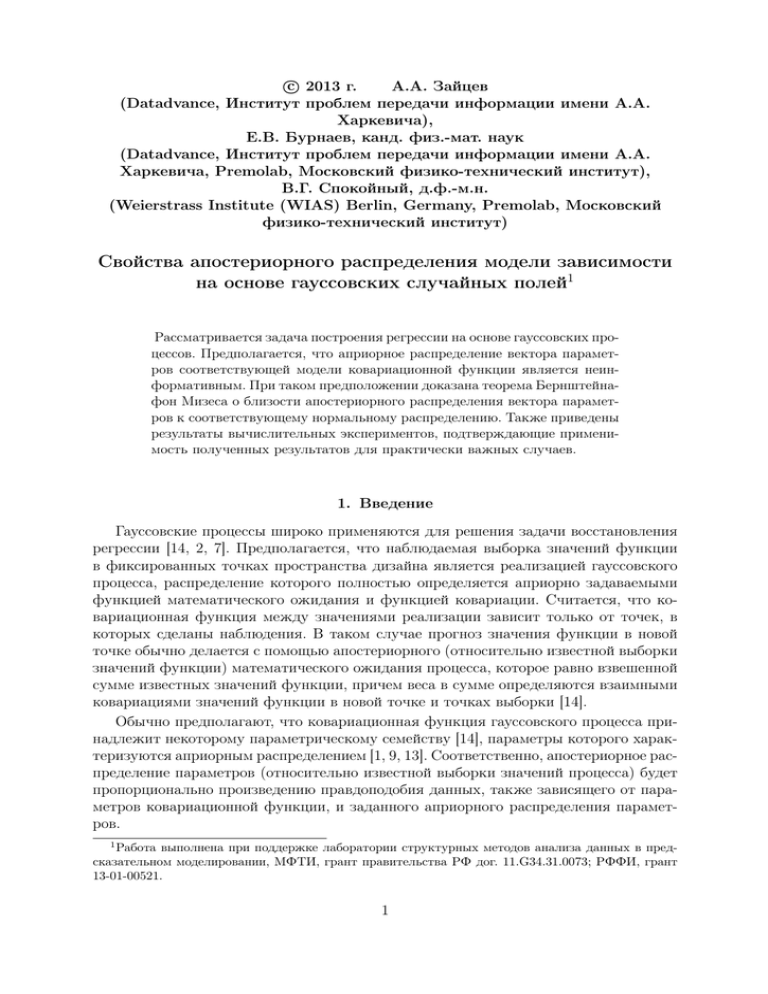

Так же на рисунке 2 в двумерном случае приведен пример апостериорного распределения вектора параметров θ, полученный аналогичным образом.

4.3. Проверка утверждений теоремы

Проведем исследование того, насколько значительны хвосты полученного апостериорного распределения. Для простоты рассмотрим случай d = 1. Будем оценивать

6

Posterior density

θ∗ value

0.35

Posterior density

θ ∗ value

4.5

4

0.3

3.5

Posterior density

Posterior density

0.25

0.2

0.15

0.1

3

2.5

2

1.5

1

0.05

0.5

0

0

2

3

4

5

6

7

8

9

10

11

12

0

13

0.5

1

1.5

2

2.5

3

3.5

4

4.5

5

Parameter θ value

Parameter θ value

(a) Обычная форма апостериорной плотности. Раз- (b) Глобальный максимум апостериорной плотномер обучающей выборки равен n = 500.

сти находится в нуле. Размер обучающей выборки

равен n = 50.

Рис. 1. Возможные виды апостериорной плотности распределения вектора параметров θ в одномерном случае

10

Posterior density

θ ∗ parameters

9

Parameter θ2 value

8

7

6

5

4

3

2

1

0

0

1

2

3

4

5

6

7

8

9

10

Parameter θ1 value

Рис. 2. Апостериорная плотность распределения вектора параметров θ в двумерном

случае. Размер обучающей выборки равен n = 300.

7

вероятность для ϑ не попасть в область

Θϑ,2S = {θ : |θ − ϑ| 6 2S},

где ϑ — математическое ожидание, а S — стандартное отклонение апостериорного

распределения (оценка этих параметров проводится численно).

Зависимость вероятности хвостов апостериорного распределения от размера выборки приведена на рисунке 3. Видно, что с ростом размера выборки вероятность

сходится к достаточно малой величине. Доверительные интервалы оценены с помощью бутстрепа по 200 случайно сгенерированным выборкам.

Определим для двух распределений P и Q с плотностями p(θ) и q(θ) соответственно, такими что, их математические ожидания µ и дисперсии σ 2 совпадают,

ограниченное расстояние Хеллингера согласно формуле

Z

2

p

p

1

2

p(θ) − q(θ) dθ.

H (P, Q) =

2 Θµ,2σ

Проверим близость апостериорного распределения параметров θ к соответствуюe апостериорного

щему нормальному распределению в окрестности точки максимума θ

распределения. Для этого подсчитаем между этими распределениями ограниченное

расстояние Хеллингера.

На рисунке 4 видно, что с ростом размера выборки n ограниченное расстояние Хеллингера между апостериорным распределением и соответствующим ему нормальным распределением уменьшается. Доверительные интервалы были оценены с

помощью бутстрепа по 200 случайно сгенерированным выборкам.

Таким образом, действительно с увеличением размера выборки n выполняется и

сходимость вероятности попадания в хвосты апостериорного распределения, и сходимость апостериорного распределения к соответствующему нормальному распределению.

5. Выводы

В работе получено описание вероятностных свойств апостериорного распределения вектора параметров модели ковариационной функции в задаче построения

регрессии на основе гауссовских процессов. Доказана теорема Бернштейна-фон Мизеса, а именно, показано, что апостериорное распределение вектора параметров в

случае неинформативного априорного распределения близко к соответствующему

нормальному распределению. Проведенные вычислительные эксперименты показывают применимость полученных результатов в практически важных случаях.

ПРИЛОЖЕНИЕ 1

Изложим план доказательства теоремы 1. Напомним, что ζ(θ) = L(θ) − IEL(θ) ,

и L(θ, θ ∗ ) = L(θ) − L(θ ∗ ) . Приведем выражения для нескольких необходимых в

дальнейшем величин:

• Правдоподобие как функция вектора параметров θ

1

L(θ) = − N log 2π + ln |Kθ | + yT Kθ−1 y .

2

8

0.05

2σ tails probability for posterior distribution

95% confidence interval

Tails probability

0.045

0.04

0.035

0.03

0.025

0.02

0

20

40

60

80

100

120

140

160

180

Sample size

Рис. 3. Зависимость вероятности попадания в хвосты постериорного распределения

от размера выборки

0.28

Hellinger distance for 2σ interval

95% confidence interval

0.26

0.24

Distance

0.22

0.2

0.18

0.16

0.14

0.12

0.1

0.08

0

20

40

60

80

100

120

140

160

180

Sample size

Рис. 4. Зависимость ограниченного расстояния Хеллингера от размера выборки

• Математическое ожидание правдоподобия

EL(θ) = −

1

N log 2π + ln |Kθ | + tr Kθ−1 K .

2

9

• Производная правдоподобия

1

−1 ∂Kθ

−1 T ∂Kθ

−1

T

− y (Kθ )

K y .

Oi L(θ) = − tr Kθ

2

∂θi

∂θi θ

• Производная математического ожидания правдоподобия

1

−1 ∂Kθ

−1 T ∂Kθ

−1

Oi EL(θ) = − tr Kθ

− tr (Kθ )

K K

.

2

∂θi

∂θi θ

• Положим Ui = Ui (θ ∗ ) =

имеет вид

Kθ−1

V02

T

=

∂Kθ

Kθ−1 ∂θi

θ=θ ∗

1

tr(Ui KUj K)

2

. Матрица V02 = Var {∇L(θ ∗ )}

p

.

i,j=1

• Элементы матрицы D02 = −∇2 IEL(θ ∗ ) = {di,j }pi,j=1 имеют вид

di,j

i

2

1 h

−1 T ∂ Kθ

−1

= tr Ui Kθ Uj K + Uj Kθ Ui K − Ui Kθ Uj Kθ + Kθ

K (Kθ − K) .

2

∂θi ∂θj θ

θ=θ ∗

Покажем, что для введенных в разделе 3.1 предположений выполнены следующие

утверждения.

(ED0 ) Существуют константы g > 0 , ν0 > 1 , такие, что для всех |λ| 6 g

выполнено неравенство

>

γ ∇ζ(θ ∗ )

6 ν02 λ2 /2.

(П.1)

sup log IE exp λ

kV0 γk

γ∈Rp

Обозначим

p

1 X

γi Ui .

Z=

kV0 γk i=1

Тогда математическое ожидание в левой части неравенства (П.1) существует, если матрица K −1 − λZ (или, что тоже самое, матрица I − λKZ ) положительно

определена. В силу сделанных предположений норма kKZk ограничена для произвольных X и θ ∗ , следовательно, существует такое g , что для любого |λ| 6 g матрица

I − λKZ > 0 .

Итак, при |λ| 6 g неравенство (П.1) можно переписать в виде

λ

1

ν 2 λ2

sup − tr(ZK) − log |I − λZK| 6 0 .

2

2

2

γ∈Rp

Так как матрица I − λZK положительно определена, то выражение под знаком

sup в левой части неравенства можно разложить по Тейлору. В итоге получаем,

что для доказательства неравенства (П.1) достаточно доказать существование ν02 и

достаточно малого g , таких, что при любом |λ| 6 g выполнено неравенство

!

∞

1

X

1

i (П.2)

(λZK) 6 ν02 λ2 2.

tr

2

i

i=2

10

Так как в силу сделанных предположений величину tr [(ZK)p ] можно ограничить

сверху некоторой константой c, то неравенство (П.2) выполнено для некоторых g и

ν02 .

Таким образом, возможно выбрать параметр g так, чтобы для любого |λ| 6 g

были выполнены следующие условия:

a) матрица I − λZK положительно определена;

b) степенной

ряд (П.2), коэффициенты которого зависят от θ ∗ , ограничен вели

чиной ν02 λ2 2 .

Для так выбранного g утверждение (ED0 ) выполнено.

Пусть r20 > C(p + x).

(ED1 ) Для каждого r 6 r0 существует константа ω(r) 6 1/2 , такая, что для

всех θ ∈ Θ0 (r) выполнено

>

γ {∇ζ(θ) − ∇ζ(θ ∗ )}

(П.3)

sup log IE exp λ

6 ν02 λ2 /2,

|λ| 6 g.

ω(r)kV0 γk

γ∈Rp

Здесь константа g такая же, как и в (ED0 ) .

Определим Z(θ) как

p

X

1

Z(θ) =

γi (Ui (θ ∗ ) − Ui (θ)),

ω(r)kV0 γk i=1

T

θ

Kθ−1 . Доказательство будем проводить аналогично доказагде Ui (θ) = Kθ−1 ∂K

∂θi

тельству утверждения (ED0 ) , но теперь нужно будет дополнительно искать такое

g , что для любого |λ| 6 g выполнены условия

a) матрица I − λZ(θ)K положительно определена для всех θ ∈ Θ0 (r) ;

b) степенной ряд вида

(П.2), коэффициенты которого зависят от θ ∈ Θ0 (r) , ограничен величиной ν02 λ2 2 для всех θ ∈ Θ0 (r) .

Такое g существует в силу введенных предположений о ковариационной функции.

(L0 ) Для каждого r 6 r0 найдется такая константа δ(r) 6 1/2 , что на множестве Θ0 (r) выполнено неравенство

−2IEL(θ, θ ∗ )

(П.4)

kD0 (θ − θ ∗ )k2 − 1 6 δ(r).

Доказательство этого утверждения использует тот факт, что функция IEL(θ, θ ∗ )

дважды непрерывно дифференцируема в окрестности θ ∗ и ее градиент ∇IEL(θ ∗ )

равен 0 . Тогда разложение до второго порядка IEL(θ, θ ∗ ) содержит только квадратичный член, и, значит, радиус окрестности может быть подобран таким образом,

чтобы было выполнено неравенство (П.4).

(I) Существует константа a > 0 , такая, что

(П.5)

a2 D02 > V02 .

11

В силу свойств матриц D02 и V02 и сделанных предположений о ковариационной

функции неравенство (П.5) будет выполнено.

(Er)

Для произвольного r существует такая величина g(r) > 0 , что для всех

λ 6 g(r) выполнено

>

γ ∇ζ(θ)

(П.6)

sup sup log IE exp λ

6 ν02 λ2 /2.

kV0 γk

θ∈Θ0 (r) γ∈Rp

Используя ограниченность ковариационных матриц и их производных по θ, аналогично доказательству неравенства (ED0 ) можно показать, что (П.6) выполнено.

(L r) Найдется такое b , что для каждого r > r0

IEL(θ, θ ∗ ) > br2 .

(П.7)

inf ∗

θ: kV0 (θ−θ )k=r

∗

)|

c

Функция f (θ) = kV|IEL(θ,θ

∗ 2 непрерывная и f (θ) 6= 0 при θ ∈ Θ0 (r0 ) = Θ \ Θ0 (r0 )

0 (θ−θ )k

в силу введенных в разделе 3.1 предположений. Так как Θ0c (r0 ) — компактное множество, то найдется такое b > 0, что f (θ) > b при θ ∈ Θ0c (r0 ), откуда получаем

(П.7).

Таким образом, при выполнении условий из раздела 3.1 будут выполнены утверждения (ED0 ) , (ED1 ) , (L0 ) , (I) , (Er) и (L r) . Далее, теорема 1 доказывается

следуя рассуждениям, приведенным в работе [18].

СПИСОК ЛИТЕРАТУРЫ

1. М.Е. Панов, Е.В. Бурнаев, и А.А. Зайцев. О способах введения регуляризации в

регрессии на основе гауссовских процессов. In ММРО-15, 2011.

2. А.Я. Червоненкис, С.С. Чернова, и Т.В. Зыкова. Применение ядерной гребневой

оценки к задаче расчета аэродинамических характеристик пассажирского самолета (сравнение с результатами, полученными с использованием искусственных

нейронных сетей). Автоматика и телемеханика, 5(5):175–182, 2011.

3. Y. Andrianakis and P.G. Challenor. Parameter estimation and prediction using

gaussian processes. Technical report, MUCM Technical report 09/05, University of

Southampton, 2009.

4. C.M. Bishop et al. Pattern recognition and machine learning, volume 4. Springer

New York, 2006.

5. Tingjin Chu, Jun Zhu, and Haonan Wang. Penalized maximum likelihood estimation

and variable selection in geostatistics. The Annals of Statistics, 39(5):2607–2625,

2011.

12

6. Jo Eidsvik, Andrew O Finley, Sudipto Banerjee, and Havard Rue. Approximate

bayesian inference for large spatial datasets using predictive process models.

Computational Statistics & Data Analysis, 56(6):1362–1380, 2011.

7. A. Forrester, A. Sobester, and A. Keane. Engineering design via surrogate modelling:

a practical guide. Wiley, 2008.

8. Cari G Kaufman, Mark J Schervish, and Douglas W Nychka. Covariance tapering

for likelihood-based estimation in large spatial data sets. Journal of the American

Statistical Association, 103(484):1545–1555, 2008.

9. M.C. Kennedy and A. O’Hagan. Bayesian calibration of computer models. Journal of

the Royal Statistical Society: Series B (Statistical Methodology), 63(3):425–464, 2001.

10. S. Kok.

The asymptotic behaviour of the maximum likelihood function of

kriging approximations using the gaussian correlation function. In EngOpt 2012 International Conference on Engineering Optimization, Rio de Janeiro, Brazil, 1-5

July 2012., 2012.

11. K.V. Mardia and R.J. Marshall. Maximum likelihood estimation of models for residual

covariance in spatial regression. Biometrika, 71(1):135–146, 1984.

12. B. Nagy, J.L. Loeppky, and W.J. Welch. Correlation parameterization in random

function models to improve normal approximation of the likelihood or posterior.

Technical report, Department of Statistics, The University of British Columbia, 2007.

13. P.Z.G. Qian and C.F.J. Wu. Bayesian hierarchical modeling for integrating lowaccuracy and high-accuracy experiments. Technometrics, 50(2):192–204, 2008.

14. C.E. Rasmussen and C.K.I. Williams. Gaussian processes for machine learning,

volume 1. MIT press Cambridge, MA, 2006.

15. M.W. Seeger, S.M. Kakade, and D.P. Foster.

Information consistency of

nonparametric gaussian process methods. Information Theory, IEEE Transactions

on, 54(5):2376–2382, 2008.

16. Benjamin Shaby and David Ruppert. Tapered covariance: Bayesian estimation and

asymptotics. Journal of Computational and Graphical Statistics, 21(2):433–452, 2012.

17. V. Spokoiny. Parametric estimation. finite sample theory. Annals of statistics, 6:2877–

2909, 2012.

18. V. Spokoiny. Bernstein-von mises theorem for growing parameter dimension.

arxive.org, 1:1, 2013.

19. A.W. Van der Vaart and J.H. Van Zanten. Rates of contraction of posterior

distributions based on gaussian process priors. The Annals of Statistics, 36(3):1435–

1463, 2008.

20. A.W. Van der Vaart and J.H. Van Zanten. Information rates of nonparametric

gaussian process methods. The Journal of Machine Learning Research, 12:2095–2119,

2011.

13

21. R. Zimmermann. Asymptotic behavior of the likelihood function of covariance

matrices of spatial gaussian processes. Journal of Applied Mathematics, 2010:1, 2011.

14