М.В. БУРАКОВ ГЕНЕТИЧЕСКОЕ КОНСТРУИРОВАНИЕ НЕЙРОНЕЧЕТКИХ СИСТЕМ

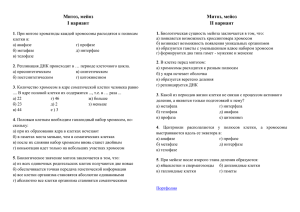

реклама

ISBN 5-7262-0634-7. НЕЙРОИНФОРМАТИКА – 2006. Часть 3

М.В. БУРАКОВ

Санкт-Петербургский государственный

университет аэрокосмического приборостроения

bmv@aanet.ru

ГЕНЕТИЧЕСКОЕ КОНСТРУИРОВАНИЕ

НЕЙРОНЕЧЕТКИХ СИСТЕМ

Аннотация

В докладе рассматриваются особенности использования генетического

алгоритма при настройке нейронечетких регуляторов для управления динамическими объектами.

Генетический алгоритм (ГА) является предметно независимым инструментом глобальной оптимизации, эффективность которого хорошо

известна и для решения задач параметрической настройки нейронных

сетей (НС) ([1 – 4] и др.).

Использование ГА предполагает, что параметры НС (обычно это веса

межнейронных связей) кодируются цепочкой битов – хромосомой.

Совокупность хромосом образует популяцию. Первоначальная генерация популяции осуществляется случайным образом в исследуемой области решений. После этого начинается циклическая работа ГА. На первом

шаге происходит тестирование всех по очереди хромосом популяции, после чего каждая хромосома получает фиксированный на данном шаге

признак – относительную пригодность (ОП) (англ. fitness function). В соответствии с выбранной стратегией хромосомы копируются в будущую

популяцию на основании своих значений ОП.

Операция отбора (копирования) является первой генетической операцией. Затем используются генетические операторы скрещивания и мутации. Как известно, операция скрещивания позволяет выйти на субоптимальное решение в рамках некоторой достаточно ограниченной области

поиска, в то время как операция мутации позволяет выполнять пробные

шаги в разных точках всего пространства поиска.

Существует достаточно большое количество исследований, посвященных вариантам выполнения операций отбора, скрещивания и мутации.

Однако очевидно, что эффективная работа ГА невозможна без правильного расчета ОП хромосом. Во многих практических задачах такая проблема

не возникает, но в задаче генетического обучения нейронного регулятора

(НР) она может иметь критическое значение [5].

УДК 004.032.26(06) Нейронные сети

43

ISBN 5-7262-0634-7. НЕЙРОИНФОРМАТИКА – 2006. Часть 3

Использование ГА при синтезе НР предполагает, что каждому варианту параметров НР соответствует своя хромосома. Для оценки ОП i-й хромосомы необходимо знать, какой переходный процесс Xi(t) ей соответствует. При обычном размере популяции в сотни и тысячи хромосом требуется очень большое количество экспериментов, что делает необходимым использование имитационной модели (ИМ) объекта. При этом возникает две фундаментальные проблемы:

ИМ должна быть достаточно быстрой, иначе нехватка вычислительных ресурсов дискредитирует использование ГА;

при расчете ОП хромосом нужно учитывать неизбежное неполное

несоответствие ИМ и объекта.

Эти проблемы взаимосвязаны, потому что чем точнее описание объекта, тем меньше быстродействие модели и наоборот. Проблема неполного

соответствия объекта и модели будет возникать, естественно, и при

управлении в реальном времени.

Основоположник теории нечетких множеств Л. Заде подчеркивал, что

требования к точности описания объекта управления могут быть снижены

за счет повышения интеллектуальности системы управления [6]. Нечеткие

регуляторы являются примером подобного подхода. Однако генетическое

обучение классических нечетких регуляторов сопряжено с некоторыми

проблемами, которых нет при обучении НР (см. [5]).

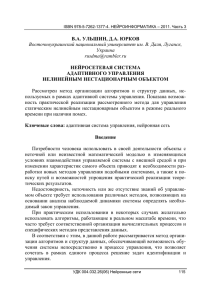

Учитывая сделанные замечания, совершенно естественным представляется переход от НР к нейронечеткому регулятору (ННР). В ННР один

нейрон используется для представления одного нечеткого правила. Пусть

нечеткое правило имеет вид:

Если (x1=w1*)и(x2=w2*)и…(xn=wn*), то u=v1*,

где w1*, w2* ,…wn* – термы лингвистических переменных (ЛП), описывающих посылки правила, v* – терм ЛП заключения.

Если использовать для представления термов гауссову функцию (ГФ),

то правило можно представить как нейрон с n входами (рис. 1).

Входные сигналы xi преобразуются в нечеткую форму, образуя центры

ГФ, описывающих функции принадлежности μi(x):

1

2

xi x ,

2

i ( x) exp

(1)

где параметр β отвечает за ширину «окна» ГФ.

УДК 004.032.26(06) Нейронные сети

44

ISBN 5-7262-0634-7. НЕЙРОИНФОРМАТИКА – 2006. Часть 3

x1

w1*

x1*

α1

w1

x2

w2*

x2*

w2

xn

xn*

u*

αmin

α2

αmin,

u*

v

wn* αn

wn

Рис. 1. Нейронное представление нечеткого правила

Аналогично преобразуются в нечеткую форму веса wi и v.

Степень соответствия посылки и заключения описывается формулой:

i sup xi* wi* .

(2)

x

НС для реализации ННР должна быть двухслойной, задача второго

слоя заключается в выполнении функции дефаззификации – вычисления

совместного действия всех правил [7].

Если считать, что ширина ГФ β не меняется в процессе обучения, то

НС на рис. 1 описывается таким же набором параметров, что и обычная

НС прямого распространения: wi соответствуют весу входа, а v – параметр

активационной функции. Второй слой в процессе обучения не участвует,

поэтому можно сказать, что хромосома имеет одинаковый вид при генетическом обучении как НР, так и ННР.

Основное преимущество использования ННР по отношению к НР заключается в том, что ННР сохраняет такие полезные свойства нечеткого

регулятора как естественную адаптивность и слабую чувствительность к

помехам. Степень запуска правила αmin зависит от сходства ситуации поУДК 004.032.26(06) Нейронные сети

45

ISBN 5-7262-0634-7. НЕЙРОИНФОРМАТИКА – 2006. Часть 3

ступившей от объекта – {x1, x2, …xn} и эталонной ситуации {w1, w2, … wn}.

Изменяя β, можно обобщать или, наоборот, конкретизировать условия

срабатывания правил.

При генетическом обучении ННР возникает сходная задача оценки

сходства эталонной и реальной траекторий с целью определения ОП хромосомы. Нечеткое описание и здесь может быть использовано для построения простого и эффективного алгоритма оценки ОП.

Рассмотрим задачу обучения НР (или ННР) подробнее. В простейшем

случае, когда объект управления одномерный, имеется эталонный переходный процесс Z(t), описывающий реакцию на типовое входное воздействие, и заданный совокупностью точек, соответствующих n моментам

времени: z1, z2, … zn.

НР включается в цепь обратной связи по ошибке управления. Если параметры НР выбраны правильно, то реальный переходный процесс X(t),

заданный точками x1, x2, … xn , будет с достаточной степенью точности

соответствовать Z(t):

n

z

i 1

i

xi ,

где ε – малая величина.

Однако при генетическом обучении НР количественные оценки, основанные только на использовании функций расстояния, малоэффективны.

Известно, что задача вычисления сходства кривых на плоскости требует

анализа их качественного соответствия [9]. На начальной стадии обучения

все хромосомы могут быть одинаково далеки от оптимума.

Рассмотрим, как могут быть построены нечеткие оценки ОП хромосом. Основная идея предлагаемого подхода заключается в переходе из

пространства состояний объекта в нечеткое фазовое пространство.

Преобразуем каждое значение xj в нечеткое число. Для этого можно,

следуя рис. 1, рассматривать xj как центр ГФ, определяющей функцию

принадлежности (рис. 2, где Ti(x) – функция принадлежности).

Совокупность xi* может рассматриваться в качестве термов лингвистической переменной (ЛП) Li с названием, соответствующим координате x:

Tz(Li)={ zi*, zi*,… zi*}

Ti(x

)

1

УДК 004.032.26(06)

xn-1* x3* Нейронные

x1* xn*сети

x2*

46

ISBN 5-7262-0634-7. НЕЙРОИНФОРМАТИКА – 2006. Часть 3

Рис. 2. Фаззификация выхода модели

Таким же образом можно построить ЛП, описывающую эталонный

процесс:

Tx(Li)={ xi*, xi*,… xi*}

Степень сходства этих двух ЛП можно оценить формулой, аналогичной формуле расчета уровня активации нечеткого правила (2):

1 min sup xi* zi* .

i

x

(3)

Если объект имеет k выходных координат, то формула (3) обобщается:

min j ,

j

j 1, k .

(4)

И тогда эта величина может быть использована в качестве значения

ОП хромосомы.

Таким образом, ОП хромосомы изменяется в пределах от 0 до 1. Значение 0 означает полное несоответствие, а значение 1 – полное соответствие реальной и желаемой траектории.

В соответствии с (1), изменяя β можно менять чувствительность ОП –

чем больше значение этого параметра, тем больше хромосом могут иметь

высокие оценки ОП. В начале процесса обучения можно устанавливать

большое значение β, позволяя многим хромосомам участвовать в отборе.

По мере развития популяции можно постепенно уменьшать β. Можно

УДК 004.032.26(06) Нейронные сети

47

ISBN 5-7262-0634-7. НЕЙРОИНФОРМАТИКА – 2006. Часть 3

также рассматривать нечеткое сходство для приращений Δx1, Δx2,… Δxn и

Δz1, Δz2,… Δzn.

Нечеткие оценки ОП призваны направлять генетический поиск в перспективные области пространства параметров. Если все хромосомы имеют в соответствии с (4) нулевое значение ОП, то использовать количественные оценки и генетические операции бессмысленно – лучше выполнить новую инициализацию популяции.

Симбиоз НС и нечетких правил обычно обосновывается тем, что поведение НС получает в этом случае семантическое описание, а нечеткая система становится способной к обучению. Однако, еще одно, возможно –

более важное, достоинство ННР заключается в возможности учитывать

неопределенность, возникающую при сравнении эталонных ситуаций и

реального поведения объекта управления. Такая же неопределенность

должна быть учтена и при генетическом обучении ННР.

Описанные подходы к организации генетического обучения НР и ННР

были апробированы при исследовании процессов управления реальными

сложными объектами [9 – 11].

Список литературы

1. Holland J. Adaptation in Natural and Artificial Systems: An Introductory Analysis with

application to Biology, Control and Artificial Intelligence. - University of Michigan Press, 1975.

2. Goldberg D.E. Genetic Algorithms in Search, Optimization and Machine Learning. Addison-Wesley, Reading, MA. 1989.

3. Скурихин А.Н. Генетические алгоритмы // Новости искусственного интеллекта, №4,

1995. С. 6-46.

4. Бураков М.В. Синтез нейронного регулятора // Изв. Академии наук. Теория и системы управления, 1999, №3. С. 140-145.

5. Бураков М.В., Коновалов А.С. Проектирование нейронных и нечетких регуляторов с

помощью генетического алгоритма //В кн. Управление в условиях неопределенности. Под

ред. Городецкого А.Е. / С.–Петербург, издательство СПбГТУ, 2002, 399 с.

6. Zadeh L.A. The Concept of a Linguistic Variable and Its Application to Approximate Reasoning, Information Sciences, Part 1, 8 (1975), 199-249; Part 2, 8 (1975), 301-357; Part 3 8 (1975),

43-80.

7. Gupta M.M., Rao D.H. On the principles of fuzzy neural networks // Fuzzy Sets and Systems, vol. 61, 1984, p. 1-18.

8. R.O. Duda, P.E. Hart. Pattern classification and scene analysis. New York, 1973.

9. Бураков М.В., Коновалов А.С. Нейронечеткие системы управления // Информационно-управляющие системы, №1, 2002г., с. 2-7.

10. Бураков М.В. Структура нейронечеткого регулятора // Изв. Академии наук. Теория и

системы управления, 2001, №6. с. 160-165.

11. Бураков М.В., Коновалов А.С., Шумилов П.Е. Интеллектуальные системы авиационной антиюзовой автоматики. СПб: Изд-во политехнического университета, 2005. 242 с.

УДК 004.032.26(06) Нейронные сети

48