Основы теории вероятностей и математической ... результатов измерений. Основные понятия

реклама

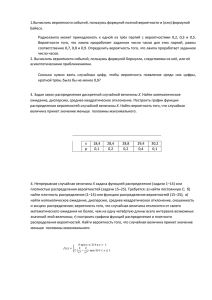

Основы теории вероятностей и математической статистики в обработке результатов измерений. Основные понятия Теория вероятностей — математическая наука, изучающая закономерности массовых случайных явлений (событий). Случайным событием (или просто событием) называется всякое явление, которое может произойти или не произойти при осуществлении определенной совокупности условий. Теория вероятностей имеет дело с такими событиями, которые имеют массовый характер. Это значит, что данная совокупность условий может быть воспроизведена неограниченное число раз. Каждое такое осуществление данной совокупности условий называют испытанием (или опытом). При этом тот или иной результат опыта может быть получен с различной степенью возможности. Т.е. в некоторых случаях можно сказать, что одно событие произойдет практически наверняка, a другое практически никогда. В отношении друг друга события также имеют особенности, т.е. в одном случае событие А может произойти совместно с событием В, в другом – нет. Полной группой событий называется совокупность всех возможных результатов опыта. Достоверным событием называется событие, которое наверняка произойдет в результате опыта. Событие называется невозможным, если оно никогда не произойдет в результате опыта. Например, если из коробки, содержащей только красные и зеленые шары, наугад вынимают один шар, то появление среди вынутых шаров белого – невозможное событие. Появление красного и появление зеленого шаров образуют полную группу событий. Классическое определение вероятности Вероятностью события А называется математическая оценка возможности появления этого события в результате опыта. Вероятность события А равна отношению числа, благоприятствующих событию А исходов опыта к общему числу попарно несовместных исходов опыта, образующих полную группу событий. 1 P(A) = m/n , где m – число элементарных исходов, благоприятствующих А; n – число всех возможных элементарных исходов испытания Здесь предполагается, что элементарные исходы несовместимы, равновозможны и образуют полную группу. Очевидно, что вероятность достоверного события равна единице, а вероятность невозможного – равна нулю. Таким образом, значение вероятности любого события – есть положительное число, заключенное между нулем и единицей. С в о й с т в о 1. Вероятность достоверного события равна единице. Действительно, если событие достоверно, то каждый элементарный исход испытания благоприятствует событию. В этом случае m = n, следовательно, Р (A) = m / n = n / n = 1. С в о й с т в о 2. Вероятность невозможного события равна нулю. Действительно, если событие невозможно, то ни один из элементарных исходов испытания не благоприятствует событию. В этом случае m = 0, следовательно, Р (А) = m / n = 0 / n = 0. С в о й с т в о 3. Вероятность случайного события есть положительное число, заключенное между нулем и единицей. Действительно, случайному событию благоприятствует лишь часть из общего числа элементарных исходов испытания. В этом случае 0 < m < n, значит, 0 < m / n < 1, следовательно, 0 < Р (А) < 1 . Итак, вероятность любого события удовлетворяет двойному неравенству 0 ≤ Р (A) ≤ 1. 2 Построение логически полноценной теории вероятностей основано на аксиоматическом определении случайного события и его вероятности. В системе аксиом, предложенной А. Н. Колмогоровым, неопределяемыми понятиями являются элементарное событие и вероятность. Приведем аксиомы, определяющие вероятность: 1. Каждому событию А поставлено в соответствие неотрицательное действительное число Р (А). Это число называется вероятностью события А. 2. Вероятность достоверного события равна единице: P() = l. 3. Вероятность наступления хотя бы одного из попарно несовместных событий равна сумме вероятностей этих событий. Исходя из этих аксиом, свойства вероятностей и зависимости между ними выводят в качестве теорем. Относительная частота. Устойчивость относительной частоты Относительная частота наряду с вероятностью принадлежит к основным понятиям теории вероятностей. Относительной частотой события называют отношение числа испытаний, в которых событие появилось, к общему числу фактически произведенных испытаний. Таким образом, относительная частота события А определяется формулой W (А) = m / n, где m - число появлений события, n - общее число испытаний. Сопоставляя определения вероятности и относительной частоты, заключаем: определение вероятности не требует, чтобы испытания производились в действительности; определение же относительной частоты предполагает, что испытания были произведены фактически. Другими словами, вероятность вычисляют до опыта, а относительную частоту - после опыта. Классическое определение вероятности предполагает, что число элементарных исходов испытания конечно. На практике же весьма часто встречаются испытания, число возможных исходов которых бесконечно. В таких случаях классическое определение неприменимо. Уже это обстоятельство указывает на ограниченность 3 классического определения. Отмеченный недостаток может быть преодолен, в частности, введением геометрических вероятностей и, конечно, использованием аксиоматической вероятности. Наиболее слабая сторона классического определения состоит в том, что очень часто невозможно представить результат испытания в виде совокупности элементарных событий. Еще труднее указать основания, позволяющие считать элементарные события равновозможными. Обычно о равновозможности элементарных исходов испытания говорят из соображений симметрии. Так, например, предполагают, что игральная кость имеет форму правильного многогранника (куба) и изготовлена из однородного материала. Однако задачи, в которых можно исходить из соображений симметрии, на практике встречаются весьма редко. По этой причине наряду с классическим определением вероятности используют и другие определения, в частности статистическое определение: в качестве статистической вероятности события принимают относительную частоту или число, близкое к ней. Например, если в результате достаточно большого числа испытаний оказалось, что относительная частота весьма близка к числу 0,4, то это число можно принять за статистическую вероятность события. Легко проверить, что свойства вероятности, вытекающие из классического определения, сохраняются и при статистическом определении вероятности. Действительно, если событие достоверно, то m = n и относительная частота m / n = n / n = 1, т. е. статистическая вероятность достоверного события (так же как и в случае классического определения) равна единице. Если событие невозможно, то m = 0 и, следовательно, относительная частота 0 / n = 0, т. е. статистическая вероятность невозможного события равна нулю. Для любого события 0 ≤ m ≤ n и, следовательно, относительная частота 0 ≤ m / n ≤ 1, т. е. статистическая вероятность любого события заключена между нулем и единицей. Для существования статистической вероятности события А требуется: 4 а) возможность, хотя бы принципиально, производить неограниченное число испытаний, в каждом из которых событие А наступает или не наступает; б) устойчивость относительных частот появления А в различных сериях достаточно большого числа испытаний. Недостатком статистического определения является неоднозначность статистической вероятности; так, в приведенном примере в качестве вероятности события можно принять не только 0,4, но и 0,39; 0,41 и т. д. Геометрические вероятности Чтобы преодолеть недостаток классического определения вероятности, состоящий в том, что оно неприменимо к испытаниям с бесконечным числом исходов, вводят геометрические вероятности — вероятности попадания точки в область (отрезок, часть плоскости и т. д.). Пусть отрезок l составляет часть отрезка L. На отрезок L наудачу поставлена точка. Это означает выполнение следующих предположений: 1. поставленная точка может оказаться в любой точке отрезка L, 2. вероятность попадания точки на отрезок l пропорциональна длине этого отрезка l и не зависит от его расположения относительно отрезка L. В этих предположениях вероятность попадания точки на отрезок l определяется равенством Р = Длина l / Длина L. СЛУЧАЙНАЯ ВЕЛИЧИНА Случайной величиной называется величина, которая в результате опыта может принимать одно и только одно возможное значение, наперед не известное и зависящее от случайных причин, которые заранее не могут быть учтены. R • Случайная величина это функция, областью определения которой является пространство элементарных событий G, областью значений – область реальных чисел R, GR 5 Случайные величины можно разделить на две категории: I.Дискретной случайной величиной называется такая величина, которая в результате опыта может принимать определенные значения с определенной вероятностью. Число возможных значений дискретной случайной величины может быть бесконечным и конечным, образовывать счетное множество (множество, элементы которого могут быть занумерованы). Это множество может быть как конечным, так и бесконечным. Например, количество выстрелов до первого попадания в цель является дискретной случайной величиной, т.к. эта величина может принимать и бесконечное, хотя и счетное количество значений. Или число точек на грани игрального кубика, выпадающее при его подбрасывании. II. Непрерывной случайной величиной называется такая величина, которая может принимать любые значения из некоторого конечного или бесконечного промежутка. Очевидно, что число возможных значений непрерывной случайной величины бесконечно. Для задания случайной величины недостаточно просто указать ее значение, необходимо также указать вероятность этого значения. Потому что случайные величины могут иметь одинаковые перечни возможных значений, а вероятности их – различные. I. Законом распределения дискретной случайной величины ДСВ называется соотношение между ее возможными значениями и их вероятностями (т. е. вероятностями, с которыми случайная величина принимает эти возможные значения). Закон распределения может быть задан формулой (формулы Бернулли, Пуассона и др.), таблицей или графиком, а также функцией распределения. Функцией распределения вероятностей случайной величины X называется функция F x P, X x определяющая вероятность того, что случайная величина X примет значение, меньшее x . Свойства функции распределения: а) функция распределения принимает значения только из отрезка [0,1]: 0 ≤ F(x) ≤ 1; б) F(x) – неубывающая функция, т.е. если x2 > x1, то F(x2) > F(x1) ; в) F(- ∞ ) = 0; F(+ ∞) = 1; 6 г) вероятность того, что случайная величина примет значение из интервала a ,b (причем a b ), равна: Pa X b F b F a ; д) F(x) непрерывна слева, т. е. F(x) = F(x – 0) Закон распределения дискретной случайной величины может быть представлен в виде многоугольника распределения – фигуры, состоящей из точек , xi , pi соединенных отрезками (рис. 1.3). Рис. 1.3. Многоугольники унимодального (а), полимодального (б) и антимодального (в) распределений Мода Mo X распределения – это значение СВ, имеющее наиболее вероятное значение. Если мода единственна, то распределение называется унимодальным (рис. 1.3, а), в противном случае – полимодальным (рис. 1.3, б) Если в середине диапазона изменения аргумента наблюдается минимум на графике многоугольника вероятностей, тогда распределение называется антимодальным (рис. 1.3, в). Математическим ожиданием M X ДСВ данной случайной величины X называется среднее значение n M X xi pi i 1 , т. е. математическое ожидание – это сумма произведений значений случайной p величины xi на соответствующие вероятности i . Свойства математического ожидания. а) M C C , где C const ; б) M CX C M X ; 7 в) M X Y M X M Y ; г) если случайные величины X и Y независимы, то M XY M X M Y . Медиана Me X – это значение случайной величины, которое делит таблицу распределения на две части таким образом, что вероятность попадания в одну из них равна 0,5 P X x P X x 0,5 . Медиана обычно не определяется для дискретной случайной величины. F x p x p Величина p , определяемая равенством , называется квантилью p порядка . Соответственно квантиль порядка 0,5 является медианой. Дисперсией D X ДСВ X называется математическое ожидание квадрата отклонения СВ от ее математического ожидания D( X ) M [( X M ( Х )) 2 ] M ( X 2 ) [ M ( X )] 2 , n n D X xi M X pi xi2 pi M X 2 i 1 i 1 2 . Дисперсия служит для характеристики рассеяния СВ относительно ее математического ожидания Свойства дисперсии: а) DC 0 , где C const ; б) DCX C D X ; 2 в) D X Y D X DY 2 cov X ,Y , где cov X ,Y M X M X Y M Y – ковариация двух случайных величин X иY; cov X ,Y 0 , тогда г) если X и Y некоррелированы, то D X Y D X DY . Средним квадратическим отклонением x называется величина, которая имеет ту же размерность, что и СВ X : . x D X 8 Основные законы распределения дискретных случайных величин ДСВ X , распределенная по закону pи Бернулли, принимает значения: 1 – «успех» или 0 – «неудача» с вероятностями q 1 p соответственно 1. Закон распределения Бернулли. Случайная величина xi pi 0 q 1 p M X 0 q 1 p p . Математическое ожидание: СВ X: D X 0 2 q 12 Дисперсия: p p 2 p1 p . 2. Биномиальный закон распределения. Случайная величина X , распределенная по биномиальному закону, принимает значения: 0, 1, 2, …, n с вероятностями, определяемыми по формулам Бернулли: p0qn 1 2 C n1 p 1q n1 C n2 p 2 q n2 Математическое ожидание: Дисперсия: ,,, k C nk p k q nk ,,, n C nn p n q 0 M X np . D X npq . На рисунке приведены многоугольники (полигоны) распределения случайной величины X, имеющей биномиальный закон распределения с параметрами n=5 и p (для p=0,2; 0,3; 0,5; 0,7; 0,8). 9 3. Закон распределения Пуассона. Случайная величина X , распределенная по закону Пуассона, принимает бесконечное счетное число значений: 0, 1, 2, …, k, …, с соответствующими вероятностями, определяемыми по формуле Пуассона k P X k e k! , где 0 – параметр распределения Пуассона. На рисунке приведены многоугольники (полигоны) распределения случайной величины X, имею ей закон распределения Пуассона с параметром (для =0,5; 1; 2; 3,5; 5). Геометрическое распределение. Дискретная случайная величина X имеет геометрическое распределение, если она принимает значения 1, 2, ..., m, ... (бесконечное, но счётное множество значений) с вероятностями 4) P( X m) pq m1 где 0 < p < 1, q=1 - p, m =1, 2, ... Пример геометрического распределения представлен на рисунке Геометрическое распределение 0,9 0,8 0,7 0,6 p=0,2 0,5 P p=0,5 0,4 p=0,8 0,3 0,2 0,1 0 0 2 4 6 8 10 12 m 10 Ряд геометрического распределения имеет вид: xi 1 2 3 ... m ... pi p pq pq2 ... pqm-1 ... Очевидно, что вероятности pi образуют геометрическую прогрессию с первым членом p и знаменателем q (отсюда и название "геометрическое распределение"). Определение геометрического распределения корректно, так как сумма ряда (так как есть сумма геометрического ряда при ). Случайная величина X=m, имеющая геометрическое распределение, представляет собой число m испытаний, проведённых по схеме Бернулли, с вероятностью p наступления события в каждом испытании до первого положительного исхода. Математическое ожидание СВ X, имеющей геометрическое распределение с параметром p, Дисперсия , где q= 1-p. Определение плотности распределения случайной величины F x P X x Функция распределения полностью характеризует случайную величину, однако, имеет один недостаток. По функции распределения трудно судить о характере распределения случайной величины в небольшой окрестности той или иной точки числовой оси. Плотностью распределения вероятностей непрерывной случайной величины Х называется функция f(x) – первая производная от функции распределения F(x). f(x) = F(x) Плотность распределения также называют дифференциальной функцией. Для описания неприемлема. дискретной случайной величины плотность распределения 11 Смысл плотности распределения состоит в том, что она показывает как часто появляется случайная величина Х в некоторой окрестности точки х при повторении опытов. После введения функций распределения и плотности распределения можно дать следующее определение непрерывной случайной величины. Определение. Случайная величина Х называется непрерывной, если ее функция распределения F(x) непрерывна на всей оси ОХ, а плотность распределения f(x) существует везде, за исключением, может быть, конечного числа точек. Зная плотность распределения, можно вычислить вероятность того, что некоторая случайная величина Х примет значение, принадлежащее заданному интервалу. b P(a< X < b) = ∫ f(x)dx a Например, задана плотность вероятности случайной величины Х: Найти вероятность того, что в результате испытания Х примет значение, принадлежащее интервалу (0,5; 1) Решение. Искомая вероятность Вероятностный смысл плотности рапределения Пусть F(x) – функция распределения непрерывной случайной величины Х. По определению плотности распределения f(x) = F(x) или иной форме 12 Разность значение , принадлежащее интервалу определяет вероятность того, что Х примет Таким образом, предел отношения вероятности того, что непрерывная случайная величина примет значение, принадлежащее интервалу , к длине этого интервала (при ) равен значению плотности распределения в точке х. Из дифференциального исчисления известно, приближенно равно дифференциалу функции, т.е. что приращение функции Вероятностный смысл этого равенства таков: вероятность того, что случайная величина примет значение, принадлежащее интервалу , приближенно равна произведению плотности вероятности в точке х на длину интервала Δх, т.е. f(x)Δx. Геометрически это будет выглядеть следующим образом: площадь заштрихованного прямоугольника, равная произведению f(x)Δx, лишь приближенно равна площади криволинейной трапеции (истинной вероятности, определямой определенным интегралом . Допущенная при этом погрешность равна площади криволинейноготреугольника АВС. 13 Плотности распределений непрерывных случайных величин называют также законами распределений. Закон равномерного рапределения вероятностей. Распределение вероятностей называют равномерным, если на интервале (а, b), которому принадлежат все возможные значения случайной величины, плотность распределения сохранаяет постоянное значение. Пример. Шкала измерительного прибора проградуирована в некоторых единицах. Ошибку при округлении отсчета до ближайшего целого деления можно рассматривать как случайную величину Х, которая может принимать с постоянной плотностью вероятности любое значение между двумя соседними целыми делениями. Таким образом, Х имеет равномерное распеределение. 14 Нормальным называют распределение вероятностей непрерывной случайной величины, которое описывается плотностью: (6.1) Замечание. Таким образом, нормальное распределение определяется двумя параметрами: а и σ. График плотности нормального распределения называют нормальной кривой (кривой Гаусса). Выясним, какой вид имеет эта кривая, для чего исследуем функцию (6.1). F(x) х 0 1) Область определения этой функции: (-∞, +∞). 2) f(x) > 0 при любом х (следовательно, весь график расположен выше оси 0х). 3) то есть ось 0х служит горизонтальной асимптотой графика при при х=а; 4) при x < a. Следовательно, 5) при x > a, - точка максимума. F(x – a) = f(a – x), то есть график симметричен относительно прямой х = а. 15 при 6) точки , то есть являются точками перегиба. Найдем вид функции распределения для нормального закона: (6.2) Перед нами так называемый «неберущийся» интеграл, который невозможно выразить через элементарные функции. Поэтому для вычисления значений F(x) приходится пользоваться таблицами. Они составлены для случая, когда а = 0, а σ = 1. Коэффициенты Стьюдента http://learning.itsoft.ru:8000/coding/first/lab00/koef.htm Определение 6.2. Нормальное распределение с параметрами а = 0, σ = 1 называется нормированным, а его функция распределения - (6.3) функцией Лапласа. Замечание. Функцию распределения для произвольных параметров можно выразить тогда через функцию Лапласа, если сделать замену: , . Найдем вероятность попадания нормально распределенной случайной величины на заданный интервал: 16 (6.4) Пример. Случайная величина Х имеет нормальное распределение с параметрами а = 3, σ = 2. Найти вероятность того, что она примет значение из интервала (4, 8). Решение. Правило «трех сигм». Найдем вероятность того, что нормально распределенная случайная величина примет значение из интервала (а - 3σ, а + 3σ): Следовательно, вероятность того, что значение случайной величины окажется вне этого интервала, равна 0,0027, то есть составляет 0,27% и может считаться пренебрежимо малой. Таким образом, на практике можно считать, что все возможные значения нормально распределенной случайной величины лежат в интервале (а - 3σ, а + 3σ). Полученный результат позволяет сформулировать правило «трех сигм»: если случайная величина распределена нормально, то модуль ее отклонения от х = а не превосходит 3σ. Показательное распределение. Определение 6.3. Показательным распределение вероятностей непрерывной описывается плотностью (экспоненциальным) называют случайной величины Х, которое (6.5) 17 В отличие от нормального распределения, показательный закон определяется только одним параметром λ. В этом его преимущество, так как обычно параметры распределения заранее не известны и их приходится оценивать приближенно. Понятно, что оценить один параметр проще, чем несколько. Найдем функцию распределения показательного закона: Следовательно, (6.6) Теперь можно найти вероятность попадания показательно распределенной случайной величины в интервал (а, b): . (6.7) Значения функции е-х можно найти из таблиц. Функция надежности. Пусть элемент (то есть некоторое устройство) начинает работать в момент времени t0 = 0 и должен проработать в течение периода времени t. Обозначим за Т непрерывную случайную величину – время безотказной работы элемента, тогда функция F(t) = p(T > t) определяет вероятность отказа за время t. Следовательно, вероятность безотказной работы за это же время равна R(t) = p(T > t) = 1 – F(t). (6.8) Эта функция называется функцией надежности. Показательный закон надежности. Часто длительность распределение, то есть безотказной работы элемента имеет показательное F(t) = 1 – e-λt . 18 Следовательно, функция надежности в этом случае имеет вид: R(t) = 1 – F(t) = 1 – (1 – e-λt) = e-λt . Определение 6.4. Показательным законом надежности называют функцию надежности, определяемую равенством R(t) = e-λt , (6.9) где λ – интенсивность отказов. Пример. Пусть время безотказной работы элемента распределено по показательному закону с плотностью распределения f(t) = 0,1 e-0,1t при t ≥ 0. Найти вероятность того, что элемент проработает безотказно в течение 10 часов. Решение. Так как λ = 0,1, R(10) = e-0,1·10 = e-1 = 0,368. 19