МОДЕЛЬ НЕЙРОНА С ВХОДНОЙ СИГМОИДАЛЬНОЙ

реклама

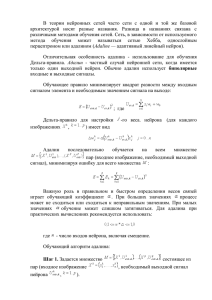

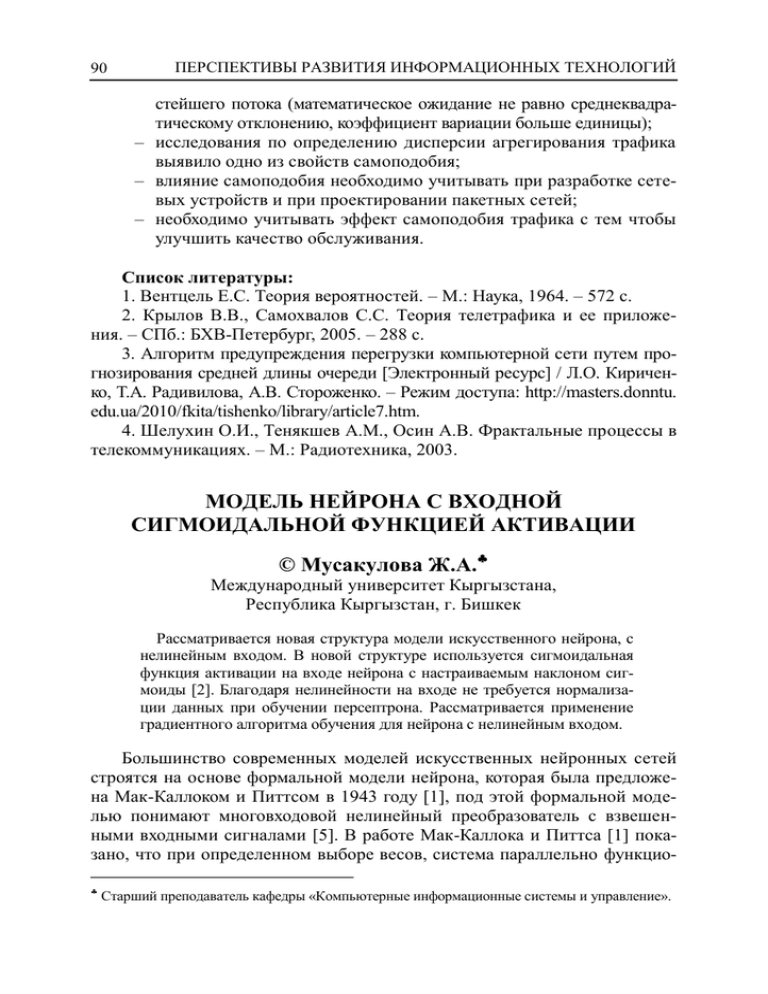

90 ПЕРСПЕКТИВЫ РАЗВИТИЯ ИНФОРМАЦИОННЫХ ТЕХНОЛОГИЙ стейшего потока (математическое ожидание не равно среднеквадратическому отклонению, коэффициент вариации больше единицы); – исследования по определению дисперсии агрегирования трафика выявило одно из свойств самоподобия; – влияние самоподобия необходимо учитывать при разработке сетевых устройств и при проектировании пакетных сетей; – необходимо учитывать эффект самоподобия трафика с тем чтобы улучшить качество обслуживания. Список литературы: 1. Вентцель Е.С. Теория вероятностей. – М.: Наука, 1964. – 572 с. 2. Крылов В.В., Самохвалов С.С. Теория телетрафика и ее приложения. – СПб.: БХВ-Петербург, 2005. – 288 с. 3. Алгоритм предупреждения перегрузки компьютерной сети путем прогнозирования средней длины очереди [Электронный ресурс] / Л.О. Кириченко, Т.А. Радивилова, А.В. Стороженко. – Режим доступа: http://masters.donntu. edu.ua/2010/fkita/tishenko/library/article7.htm. 4. Шелухин О.И., Тенякшев А.М., Осин А.В. Фрактальные процессы в телекоммуникациях. – М.: Радиотехника, 2003. МОДЕЛЬ НЕЙРОНА С ВХОДНОЙ СИГМОИДАЛЬНОЙ ФУНКЦИЕЙ АКТИВАЦИИ © Мусакулова Ж.А. Международный университет Кыргызстана, Республика Кыргызстан, г. Бишкек Рассматривается новая структура модели искусственного нейрона, с нелинейным входом. В новой структуре используется сигмоидальная функция активации на входе нейрона с настраиваемым наклоном сигмоиды [2]. Благодаря нелинейности на входе не требуется нормализации данных при обучении персептрона. Рассматривается применение градиентного алгоритма обучения для нейрона с нелинейным входом. Большинство современных моделей искусственных нейронных сетей строятся на основе формальной модели нейрона, которая была предложена Мак-Каллоком и Питтсом в 1943 году [1], под этой формальной моделью понимают многовходовой нелинейный преобразователь с взвешенными входными сигналами [5]. В работе Мак-Каллока и Питтса [1] показано, что при определенном выборе весов, система параллельно функцио Старший преподаватель кафедры «Компьютерные информационные системы и управление». Системный анализ, управление и обработка информации 91 нирующих нейронов способна производить достаточно универсальные вычисления. В математическом представлении функционирование нейрона можно описать следующими зависимостями: n v wi xi b (1) y f (v) (2) i 1 где xi – входные сигналы нейрона; wi – синаптические веса нейрона; b – порог, обеспечивающий эффект аффинного преобразования; v – индуцированное локальное поле нейрона; f(v) – функция активации; y – выходной сигнал нейрона; n-количество входных сигналов. Чаще всего в нейронных сетях преимущественно применяют нелинейную передаточную функцию, поскольку линейные функции ограничены и их выход пропорционален входу. В большинстве современных моделях искусственных нейронных сетей в качестве функции активации f() применяют S-подобную кривую, которая приближает минимальное и максимальное значения в асимптотах и называется сигмоидой. Сигмоидальная функция активации [2], является монотонно возрастающей всюду дифференцируемой нелинейной функцией с насыщением: f (v ) 1 1 e v (3) где – параметр наклона сигмоидальной функции активации; v – индуцированное локальное поле нейрона. При этом, настраивая параметр сигмоидальной функции активации нейрона в процессе обучения, можно обеспечить лучшую сходимость функции ошибки обучения нейронной сети [2], так в зависимости от разных значений , меняется вид сигмоидальной функции, она становиться боле крутой или пологой, соответственно изменяя знак коэффициента, меняется направление s-образной функции. Модель нейрона с выходной сигмоидальной функцией активации. В работе предлагается новая структура нейрона (рис. 1), позволяющая при обучении персептрона настраивать в два раза больше параметров, тем самым обеспечивая быстрый поиск глобального минимума функции ошибки обучения нейронной сети. Кроме того новая структура нейрона позволяет избавиться от проблемы нормирования входных данных, обеспечивая не- 92 ПЕРСПЕКТИВЫ РАЗВИТИЯ ИНФОРМАЦИОННЫХ ТЕХНОЛОГИЙ линейный сигнал на входе нейрона. Так как сигналы, подающиеся на вход нейрона, поступают с внешнего мира, предлагается на входе нейрона использовать нелинейную функцию активации, тем самым, если делать аналогию с биологической моделью нейрона, на вход нейрона будут подаваться «аксонные дендриты». В предлагаемой модели нейрона входные сигналы подаются через нелинейный элемент – функцию активации, в данной модели предлагается использование сигмоидальной функции активации, с настраиваемым параметром наклона сигмоиды [2]. Выходной сигнал нейрона y описывается выражением (2), а выражение (3) с учетом настраиваемого коэффициента ̂ примет следующий вид: f (v ) 1 1 e ̂v (4) где ̂ – настраиваемый коэффициент сигмоидальной функции активации на выходе нейрона; v – индуцированное локальное поле нейрона, которое описывается следующим выражением: n v f ( xi bi ) bˆ (5) i 1 где xi – входные сигналы нейрона; bi – сигнал смещения для входных сигналов; b̂ – смещение сигнала для выходной функции активации; f() – нелинейная функция активации; n – количество выходных сигналов нейрона. Соответственно, учитывая, что входные сигналы подаются через нелинейный элемент, в частности через сигмоидальную логистическую функцию выражение (5) примет следующий вид: n 1 bˆ ai ( xi bi ) 1 e i 1 v (6) где ai – настраиваемый коэффициент сигмоидальной функции активации на входе нейрона (параметр наклона сигмоиды); xi – входные сигналы нейрона; bi – сигнал смещения для входных сигналов; b̂ – смещение сигнала для выходной функции активации; n – количество выходных сигналов нейрона. Системный анализ, управление и обработка информации 93 Рис. 1. Модель нейрона с нелинейным входом Градиентный алгоритм обучения нейронной сети. Под обучением сети понимается процесс последовательной настройки весовых коэффициентов нейронной сети. На начальном этапе случайным образом подаются весовые коэффициенты, далее рассчитывается выходной сигнал персептрона, который сравнивается с учителем, то есть с эталонным сигналом и вычисляется ошибка. После нахождения значения ошибки, в зависимости от используемого алгоритма обучения сети, происходит настройка парметров нейронной сети и снова осуществляется передача сигнала в прямом направлении. В классическом случае [3, 4, 5] свободными параметрами нейронной сети, являются весовые коэффициенты синаптической связи, то есть при обучении сети происходит настройка весов синаптической связи. После каждого этапа настройки вычисляется сигнал ошибки e: e=d–y (7) где d – желаемый выход сети (учитель); y – выходной сигнал нейрона (2). Изменения коэффициентов нацелены на пошаговое приближение выходного сигнала y к желаемому d. Эта цель достигается за счет минимизации функции стоимости E: E где e – сигнал ошибки. 1 2 e 2 (8) 94 ПЕРСПЕКТИВЫ РАЗВИТИЯ ИНФОРМАЦИОННЫХ ТЕХНОЛОГИЙ Согласно градиентному методу обучения нейронной сети, синаптический вес на каждом шаге обучения изменяется по следующему правилу: w(t + 1) = w(t) – g(t) (9) где – положительная константа, называемая параметром скорости обучения; w(t) – предыдущее значение массива весов; w(t + 1) – последующее значение массива весов; g(t) – вектор градиента, вычисленный в точке w(t): g = E(w) (10) Для минимизации функции стоимости E, необходимо двигаться в сторону обратную градиенту. Градиент, представляет собой направление, в котором достигается наибольший прирост значений [3]: E E E E ( w1 , w2 ,..., wn ) , ,..., wm w1 w2 T (11) где m – общее число весовых коэффициентов. Таким образом, в данном методе [3] корректировка весов синаптической связи выполняется в направлении противоположном вектору градиента (9). Рассмотрим применение градиентного метода для минимизации функции стоимости E (8) для нейрона с нелинейным синапсом. Сигнал ошибки выхода нейрона определяется выражением (7). Для нейрона с входной сигмоидальной функцией активации предлагается настраивать параметр наклона сигмоидальных функций на входе, смещение на входе b, смешение на выходе b̂ и параметр наклона ̂ сигмоидальной функции на выходе нейрона. Введем настраиваемый массив параметров B: b Bj ̂ ˆ b (12) где = [1 … n]T, b = [b1 … bn]T. Соответственно настраиваемый массив параметров B на каждом шаге обучения будет изменяться по следующему правилу: Системный анализ, управление и обработка информации B(t + 1) = B(t) – g(t) 95 (13) где – положительная константа, называемая параметром скорости обучения; B(t) – предыдущее значение массива настраиваемых коэффициентов; B(t + 1) – последующее значение массива настраиваемых коэффициентов; g(t) – вектор градиента, вычисленный в точке B(t): g = E(B) E E E E ( B) , ,..., Bm B1 B2 (14) T (15) где m – общее число настраиваемых коэффициентов нейрона; E(B) – градиент. Обучение персептрона осуществляется путем последовательного предъявления векторов обучающего множества, с одновременной подстройкой настраиваемых коэфициентов B, в соответствии с градиентным алгоритмом обучения, пока ошибка настройки по всему множеству не достигнет приемлемого низкого уровня. При достижении требуемой ошибки обучения, нейронная сеть считается обученной. *** Предлагаемая модель нейрона с входной сигмоидальной функцией активации является более эффективной, по сравнению со стандартной моделью нейрона. Благодаря нелинейному сигналу, поступающему на адаптивный сумматор, не требуется нормирование входного сигнала, подаваемого в нейронную сеть. При использовании модели нейрона с нелинейным входом количество настраиваемых коэффициентов для одного нейрона в два раза больше чем для стандартного нейрона, что позволяет улучшить скорость и процесс обучения нейронной сети. Список литературы: 1. McCalloch W.S., Pitts W. A logical calculus of the ideas immanent in nervous activity // Bull. Math. Biophys. – 1943. – V. 5. – Р. 115-133. 2. Савченко Е.Ю., Мусакулова Ж.А. Настройка сигмоидальной логистической функции активации в алгоритме обратного распространения. // Материалы Международной конференции «Проблемы управления и информационных технологий». Проблемы автоматики и управления. № 1. – Бишкек, 2010. – С. 241. 96 ПЕРСПЕКТИВЫ РАЗВИТИЯ ИНФОРМАЦИОННЫХ ТЕХНОЛОГИЙ 3. Рутковская Д., Пилиньский М., Рутковский Л. Нейронные сети, генетические алгоритмы и нечеткие системы. – М.: Горячая линия – Телеком, 2007. – 452 с. 4. Барский А.Б. Нейронные сети: распознавание, управление. Принятие решений. – М.: Финансы и статистика, 2007. – 176 с. 5. Бодянский Е.В. Искусственные нейронные сети: архитектура, обучение, применение / Е.В. Бодянский, О.Г. Руденко. – Харьков, 2004. – 372 с. ЭФФЕКТИВНОСТЬ АВТОМАТИЧЕСКОЙ ИНТЕРВАЛЬНОЙ ОЦЕНКИ КРИВИЗНЫ ФУНКЦИИ ПРИ ПОИСКЕ ЭКСТРЕМУМА © Панов Н.В. Конструкторско-технологический институт вычислительной техники Сибирского отделения Российской академии наук, г. Новосибирск Работа посвящена изучению влияния учёта выпуклости или вогнутости функции на определённых подобластях области поиска глобального экстремума этой функции на вычислительную эффективность интервальных методов глобальной оптимизации. Многие задачи, возникающие в различных сферах человеческой деятельности, могут быть сведены к задаче поиска глобального оптимума. Оптимизация является неотъемлемой частью важнейших этапов моделирования технических, социальных, экономических и т.д. систем. В ряде случаев именно сложность возникающей оптимизационной задачи становится тем ограничением, которое не позволяет решить обратную задачу или исследовать общую постановку проблемы. В настоящее время глобальная оптимизация – широко востребованное и интенсивно развивающееся направление вычислительной математики. Трудности численного решения оптимизационных задач во многом связаны с видом оптимизируемой целевой функции и количеством её аргументов. Подходы глобальной оптимизации существенно отличаются от техники стандартных методов поиска локальных оптимумов функции (часто неспособных найти глобальный оптимум рассматриваемых многоэкстремальных задач) и характеризуются высокой вычислительной трудоемкостью. Кроме того, во многих задачах, возникающих в практике оптимизации, требуется не просто приближённое численное решение, но ещё и гарантия его близости к идеальному математическому оптимуму, а также часто га Научный сотрудник.