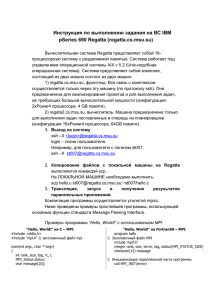

Краткая инструкция участника летней суперкомпьютерной

реклама

Краткая инструкция участника летней суперкомпьютерной академии Сайт академии МГУ: http://academy.hpc-russia.ru Суперкомпьютер Regatta Общие сведения: • Учетная запись имеет вид edu-acad13-XXX, где XXX персональный трехзначный номер участника. • Доступ осуществляется по логину/паролю • Адрес вычислительной системы для ssh доступа: regatta.cs.msu.su Доступ к вычислительной системе: Windows: • Используйте программу putty для доступа к терминалу вычислительной системе. • Используйте программу winscp для передачи файлов на суперкомпьютер или с него. Linux: • Используйте команду ssh <ваш_логин>@regatta.cs.msu.su например ssh edu-acad13-000@regatta.cs.msu.su • Используйте команду scp для передачи данных на суперкомпьютер или с него. например scp aaa.txt edu-acad13-000@regatta.cs.msu.su:./ Компиляция: • Компиляция производится на интерфейсной машине. • Компиляторы для программ MPI — mpicc, mpicxx, xlc, xlcxx... • Пример MPI программы компиляции: mpicc hello.c -o hello • Пример компиляции программы с OpenMP: xlc_r -qsmp=omp hello.c -o hello Запуск • Запуск производится через систему очередей (задача ставится в очередь и ожидает требуемых ресурсов) c помощью команды mpisubmit для программ MPI mpisubmit -n <кол-во процессоров> -w 15:00 <ваша программа> <параметры> команда ompsubmit для программ OpenMP ompsubmit -n <кол-во процессоров> -w 15:00 <ваша программа> <параметры> • Простейший вариант запуска: mpisubmit -n1 -w 15:00 <ваша программа> <параметры> стандартный вывод будет направлен в файл <ваша программа>.<номер задачи>.out, ошибки в .err Дополнительная информация: http://wiki.cs.msu.ru/Main/RegattaInstructions Техническая поддержка: сайт http://support.cs.msu.su Краткая инструкция участника летней суперкомпьютерной академии Сайт академии МГУ: http://academy.hpc-russia.ru Суперкомпьютер BlueGene /P Общие сведения: • Учетная запись имеет вид edu-acad13-XXX, где XXX персональный трехзначный номер участника. • Доступ осуществляется по логину/паролю • Адрес вычислительной системы для ssh доступа: 10.6.7.50 • Для доступа необходимо использовать VPN Доступ к вычислительной системе: Windows: • Используйте программу putty для доступа к терминалу вычислительной системе. • Используйте программу winscp для передачи файлов на суперкомпьютер или с него. Linux: • Используйте команду ssh <ваш_логин>@10.6.7.50 например ssh edu-acad13-000@10.6.7.50 • Используйте команду scp для передачи данных на суперкомпьютер или с него. например scp aaa.txt edu-acad13-000@10.6.7.50:./ Компиляция: • Компиляция производится на интерфейсной машине. • Компиляторы для программ MPI — mpicc, mpicxx, mpixlc, mpixlcxx • Пример MPI программы компиляции: mpicc hello.c -o hello • Пример компиляции программы с OpenMP: mpicc -qsmp=omp hello.c -o hello Запуск • Запуск производится через систему очередей (задача ставится в очередь и ожидает требуемых ресурсов) c помощью команды mpisubmit.bg mpisubmit.bg -n <кол-во процессоров> -w 15:00 <ваша программа> <параметры> • Простейший вариант запуска: mpisubmit.bg -n1 -w 15:00 <ваша программа> <параметры> стандартный вывод будет направлен в файл <ваша программа>.<номер задачи>.out, ошибки в .err Дополнительная информация: http://hpc.cs.msu.su Техническая поддержка: сайт http://support.cs.msu.su Краткая инструкция участника летней суперкомпьютерной академии Сайт академии МГУ: http://academy.hpc-russia.ru Суперкомпьютер Ломоносов Общие сведения: • Учетная запись имеет вид edu-acad13-*, где * персональный логин участника. • Доступ осуществляется по вашему ключу, открытую часть которого вы добавили в интерфейс http://users.parallel.ru. Если при создании ключа вы указали passphrase (пароль), то он потребуется в момент подключения. Данный пароль нельзя восстановить, в случае утери придется создать новый ключ. • Адрес вычислительной системы для ssh доступа: lomonosov.parallel.ru Доступ к вычислительной системе: Windows: • Используйте программу putty для доступа к терминалу вычислительной системе. • Используйте программу winscp для передачи файлов на суперкомпьютер или с него. Linux: • Используйте команду ssh -i <путь/к/ключу> <ваш_логин>@lomonosov.parallel.ru например ssh -i .ssh/id_rsa edu-acad13-000@lomonosov.parallel.ru • Используйте команду scp для передачи данных на суперкомпьютер или с него. например scp -i .ssh/id_rsa /etc/passwd edu-acad13-000@lomonosov.parallel.ru:./_scratch/ Компиляция: • Компиляция производится на специальном вычислительном узле. Для доступа к нему выполните команду: ssh compiler • После захода на узел выполните команду: module load intel/13.1.0 impi/4.1.0 cuda (это настроит переменные окружения на использование icc, Intel MPI) • Вычислительные узлы видят только директорию ~/_scratch, храните все ваши исполняемые файлы там (иерархическая система хранения http://parallel.ru/node/7756) • Компиляторы для программ MPI — mpicc, mpicxx, mpif90 • Компилятор CUDA программ — nvcc • Пример MPI программы компиляции: mpicc testmpi.c -o hello • Пример компиляции программы с OpenMP: mpicc -openmp testopenmp.c -o hello Запуск • Запуск производится через систему очередей (задача ставится в очередь и ожидает требуемых ресурсов) c помощью команды sbatch. sbatch -p <имя очереди> -n<кол-во процессоров> <тип mpi> <ваша программа> <параметры> • Запускаются только исполняемые файлы, находящиеся в директории ~/_scratch/ ... • Простейший вариант запуска: sbatch -p test -n1 impi <ваша программа> <параметры> impi — указание Intel MPI, если выбрали openmpi, то нужно указывать ompi стандартный вывод будет направлен в файл slurm-<номер задачи>.out, ошибки в .err • Интерактивный запуск: srun -p test -n1 <ваша программа> <параметры> блокирует терминал на время выполнения, стандартный вывод идёт в терминал. Дополнительная информация: http://parallel.ru/cluster Техническая поддержка: lomonosov-support@parallel.ru Краткая инструкция компиляции и запуска: Regatta: • MPI • mpicc testmpi.c -o testmpi mpisubmit -n 1 -w 15:00 testmpi • OpenMP • xlc -qsmp=omp testopenmp.c -o testomp ompsubmit -n1 -w 15:00 testomp BlueGene /P • MPI • mpixlc testmpit -o testmpi mpisubmit.bg -n 1 -w 15:00 testmpit • MPI+OpenMP • mpixlc_r -qsmp=omp testopenmp -o testomp mpisubmit.bg -n 1 -m smp -w 15:00 testomp Lomonosov • MPI • ssh compiler module load intel/13.1.0 impi/4.1.0 mpicc testmpi.c -o testmpi sbatch -p test -n 1 impi testmpi • MPI+OpenMP • ssh compiler module load intel/13.1.0 impi/4.1.0 mpicc -openmp testopenmp.c -o testomp sbatch -p test -N 1 --ntasks-per-node=1 impi testmpi • CUDA • module load intel/13.1.0 impi/4.1.0 cuda nvcc testcuda.c -o testcuda sbatch -p gputest -n 1 testcuda