Информетрия и закономерности строения документальных

реклама

Информетрия и закономерности строения

документальных информационных потоков

Памяти В. И. Горьковой

35 лет назад был создан Институт повышения квалифи%

кации информационных работников (ИПКИР). Инициато%

ром его создания и первым директором была доктор техни%

ческих наук, профессор Валентина Ивановна Горькова.

Основное научное направление, которое развивала

В. И. Горькова — информетрия. Этому направлению сейчас

в научной литературе и учебных планах подготовки специа%

листов по прикладной информатике уделяется недо%

статочно внимания. Поэтому редакция обратилась с прось%

бой к доктору экономических наук, профессору В. Н. Волко%

вой, работавшей в ИПКИРе в период его становления, крат%

ко охарактеризовать информетрию.

Г

орькова Валентина Ивановна (22 мая

1920 — 6 апреля 1997) — доктор тех

нических наук, профессор. Окончила

Московский энергетический институт. В 1970

году защитила докторскую диссертацию на

тему «Системноструктурный анализ доку

ментальных информационных потоков». В

1972 году стала инициатором создания и

директором первого в стране учебного за

ведения по подготовке информационных ра

ботников для отделов научнотехнической

информации — Института повышения ква

лификации информационных работников

при Государственном комитете Совета Ми

нистров СССР по науке и технике.

В ИПКИР была организована подготовка

специалистов по шести специальностям.

· Организация, экономика и планирова

ние научноинформационной деятельности.

· Аналитикосинтетическая обработка

источников информации и подготовка ин

формационных изданий.

· Справочноинформационное обеспе

чение.

Вопросы теории R Памятные даты

· Репрография, микрофильмирование

и технические средства обеспечения ин

формационных процессов.

· Механизация и автоматизация инфор

мационных процессов.

· Научнотехническая пропаганда.

По замыслу В. И. Горьковой специально

сти были взаимосвязаны. Это обеспечива

лось тем, что на каждой специальности чи

тались краткие курсы по всем другим спе

циальностям.

Валентина Ивановна проявляла интерес

ко всему новому. Она приглашала для чте

ния лекций необщепризнанных новаторов.

В ИПКИРе читали лекции Юрий Иванович

Шемакин (развивающий теорию тезаурусов

и информационносемантических систем

[13, 14]), Юлий Анатольевич Шрейдер (его

первое пособие по семиотике было подго

товлено на основе лекций «Семиотические

основы информатики», читавшихся в ИПКИРе,

и в последующем издано в издательстве

«Знание» [15]). Геннадий Григорьевич Во

робьев (предложивший новый информаци

109

Информетрия и закономерности строения документальных информационных потоков

онный подход к анализу документов научно

технической информации [1] и занимавший

ся развитием тестов MMPI), и даже такая

одиозная в то время личность, как Юрий

Алексеевич Гастев — сын репрессирован

ного в 30е годы директора Центрального ин

ститута труда (ЦИТ), прославившийся вскоре

тем, что включил в изданную книгу несущест

вующий литературный источник (что само

по себе было тогда наказуемо), да еще и на

именование источника «Chain & Stocks. The

Deathbreathing. M.: 1953» напоминало читате

лям о предсмертном дыхании Чейна и Сток

са, которое было у умирающего И.В. Сталина

(таким образом Гастев пытался оригиналь

но напомнить читателям о судьбе своего от

ца). Разумеется, это было обнаружено, и

Гастева уволили с основного места работы,

требовали лишить степени кандидата наук.

Но в ИПКИРе благодаря смелости Валенти

ны Ивановны он продолжал читать лекции!

В числе рекомендуемых учебных пособий

в ИПКИРе важное место занимала одна из

первых монографий по системному анали

зу целей М.М. Лопухина [10].

Валентина Ивановна мягко и женствен

но, но вместе с тем твердо и настойчиво от

стаивала свои позиции и убеждения перед

руководством Государственного комитета

Совета Министров СССР по науке и технике

и в общении с коллегами и подчиненными.

Она никогда не заканчивала разговор со

своими подчиненными традиционным «У Вас

все?». А говорила «Я Вас целую…». Это

означало, что пора уходить.

Несмотря на загруженность организаци

онной работой, В. И. Горькова продолжала

активно развивать методы анализа инфор

мационных потоков и запросов потребите

лей информации в системах научнотехни

ческой информации.

Для того чтобы охарактеризовать ее

вклад в исследование указанных вопросов,

кратко рассмотрим суть проблемы.

Информетрия и ее задачи

Общеизвестно, что из года в год растет

объем создаваемой обществом научной, тех

110

нической, производственной, социальной

и иных видов информации. Увеличивается

число монографий, учебников, патентов,

научнотехнических отчетов, проектов, де

ловых и нормативноправовых документов,

периодических и продолжающихся изда

ний, обзорных, реферативных, экспресс

информаций и других первичных и вторич

ных информационных источников, растет

число и объемы автоматизированных баз

данных и баз знаний. Одновременно услож

няется структура информационных потреб

ностей, комплектование справочноинфор

мационных фондов библиотек и отделов

научнотехнической информации, органи

зация поиска информации, необходимой

для принятия решений.

Разумеется, созданы и создаются все

более совершенные и разнообразные по

функциям автоматизированные информа

ционные системы, в том числе информаци

оннопоисковые системы Internet. Однако

актуальной остается проблема отбора и ор

ганизации оперативного поиска информа

ции, названной Г. Р. Громовым [8] «активны

ми информационными ресурсами». Значи

тельную долю информационных ресурсов

составляют текстовые документы. Актив

ные информационные ресурсы как сово

купности текстовых документов принято

называть документальными информацион

ными потоками (ДИП). Они являются важ

ным объектом исследований в приклад

ной информатике. Знание характеристик,

свойств, закономерностей документальных

информационных потоков позволяет при

нимать важные решения по управлению ин

формационными ресурсами с целью интен

сификации и рационализации их использо

вания.

Национальные информационные ресур

сы по науке и технике в нашей стране со

средоточены в библиотеках, всероссийских

и отраслевых системах научнотехнической

информации, общегосударственных цент

рах — во Всероссийском институте науч

ной и технической информации (ВИНИТИ),

фонды которого содержат отечественные и

Вопросы теории R Памятные даты

зарубежные периодические издания, сбор

ники трудов, реферативные журналы; во

Всероссийском научнотехническом инфор

мационном центре (ВНТИЦентре), регист

рирующем, формирующем и сохраняющем

фонды документов госрегистрации НИОКР,

отчеты по НИР и ОКР, диссертации, фонды

алгоритмов и программ; в НПО «Роспатент»,

накапливающем фонды отечественной и за

рубежной патентной литературы, товарные

знаки; в НТЦ «Информрегистр» Комитета

при Президенте РФ по политике информа

тизации, занимающемся регистрацией и

предоставлением сведений об имеющихся

в стране информационных ресурсах, в том

числе библиографических и справочных

баз данных и других информационных хра

нилищах.

Рациональное распределение состав

ляющих ДИП подразумевает организацию

комплектования и хранения информации по

тематике, типам первоисточников факто

графической информации, информацион

ных документов и иным видам информаци

онных продуктов и должно обеспечивать

минимальные затраты средств и времени

потребителей на поиск необходимой ин

формации, минимальные материальные

и интеллектуальные затраты на подготовку

тематических подборок, обзоров и других

видов обслуживания пользователей в ре

жимах избирательного распределения ин

формации и дифференцированного обслу

живания руководителей.

Для краткой характеристики количествен

ных методов исследования научнотехниче

ской информации, изучения закономерно

стей организации документальных информа

ционных потоков в начале 80х годов XX века

было введено понятие «информетрия» [17].

Данный термин возник по аналогии с тер

минами «наукометрия» и «библиометрия»

для названия научного направления, зани

мающегося применением математических

и статистических методов и моделей для ко

личественного анализа структуры и свойств

научной информации и закономерностей

процессов научной коммуникации.

Вопросы теории R Памятные даты

В более широком смысле «информет

рия — вся совокупность методов измере

ний, с помощью которых можно получить

количественные данные о системе научной

коммуникации. Она служит основой для соз

дания теории научной коммуникации и для

оптимизации научноинформационной дея

тельности» [17].

Наиболее полно это понятие было рас

крыто В. И. Горьковой [7]: «Объектом ин

форметрии являются научная информа

ция и научные коммуникации. Предметом —

их объективные количественные законо

мерности, используемые для совершен

ствования информационной деятельно

сти».

При этом под научной информацией

и научными коммуникациям (согласно [7])

понимается не только научнотехническая

литература, патенты, научные отчеты и дру

гие источники первичной и вторичной ин

формации, которые являются входным до

кументальным информационным потоком,

но и результаты информационной деятель

ности: информационные массивы, естест

венные и формализованные языки как

средство индексирования и поиска, клас

сификации, информационные запросы по

требителей информации и другие предме

ты информационной деятельности.

В информетрии исследуются количест

венные и качественные параметры орга

низации частотных словарей, использо

вания слов в текстах документов и распре

деления информации в документальных

информационных потоках. Основные на

правления информетрии — исследование

количественных параметров и закономер

ностей:

· документальных информационных по

токов, включая первичные источники ин

формации и информационные продукты;

· лингвистических средств информаци

онной деятельности;

· средств общественной коммуникации;

· тематических связей между состав

ляющими ДИП.

111

Первые результаты исследований линг

вистических закономерностей естественного

языка были получены Дж. Эсту (J. B. Estoup)

в 1916 году, А. Лоткой (A. J. Lotka) в 1926 году

и Дж. Ципфом (G.K. Zipf) в 1932 году, а первые

исследования структуры ДИП — распреде

ление статей по журналам — принадлежат

С. Брэдфорду (S. C. Bradford) — 1934 год.

Впервые характеристику качественных

свойств частотных словарей определил в

1916 году Дж. Эсту, который обнаружил, что

частота использования слов в тексте обрат

но пропорциональна его номеру в частот

ном словаре.

Наиболее исследованы следующие за

кономерности.

Информетрия и закономерности строения документальных информационных потоков

Закон Ципфа

Джордж Ципф, или в некоторых совре

менных переводах в Internet Г. Зипф, в нача

ле 30х годов XX века на основе статистиче

ских исследований получил следующую за

кономерность [26, 27].

Пусть есть текст длиной N слов и сло

варь объемом m слов с указанием частоты

появления слова в тексте. Слова в словаре

расположены в порядке их убывания по

частоте и проранжированы от 1 до m. Ранг

равный 1 присваивается слову, частота по

явления которого наибольшая, ранг равный

m — наименее употребимому слову.

Тогда pri = f ri N, где ri — ранг слова,

1 £ i £ m, pri — относительная частота по

явления слова в тексте; f ri — абсолютная

частота появления слова с рангом ri в тек

сте определенной длины; N — число слов

в тексте.

Если умножить вероятность или относи

тельную частоту обнаружения слова в тек

сте pri на ранг слова ri , то получим:

pri ri = fri

ri

= k,

N

где k — константа; 1 £ ri £ m.

Если преобразовать формулу, то получим

pri = k ri , т.е. функцию типа y = k x, график

которой — равносторонняя гипербола.

112

Таким образом, на основе анализа полу

ченных зависимостей Ципф предложил эм

пирическую формулу, устанавливающую

связь между частотой появления слов в тек

сте и его рангом в словаре:

pri = kri-1,

где k — эмпирически определяемая кон

станта, изменяющаяся для разных тек

стов.

При этом 1 £ ri £ m; p1 — частота наибо

лее употребимого слова; pm — частота наи

менее употребимого слова; pri = j( ri ) —

«гиперболическая лестница», поскольку

ранговое распределение имеет ступенча

тый характер (ряд слов появляется с одина

ковой частотой), но при аппроксимации

можно считать распределение Ципфа ги

перболой (рис. 1).

Рис. 1. Распределение Ципфа

Значение константы в разных языках раз

лично, но внутри одной языковой группы ос

тается неизменно, какой бы текст мы ни взя

ли. Так, имеются исследования, показываю

щие, что, например, для английских текстов

константа Ципфа равна приблизительно 0,1;

а для русского языка — примерно 0,06–0,07.

Поэтому Ципф приводил также запись

этой закономерности в следующей форме:

pri = 01

, ri -1, 1 < ri < m.

Вопросы теории R Памятные даты

Опираясь на экспериментальные дан

ные, собранные в результате статистиче

ского исследования многих текстов на раз

личных языках, Ципф обнаружил также, что

распределение слов естественного языка

подчиняется единому простому закону, ко

торый он назвал «принципом наименьшего

усилия»: выражая мысли с помощью языка,

мы подвергаемся действию двух противопо

ложных сил — унификации и диверсифика

ции, проявляющихся, с одной стороны, в не

обходимости быть понятыми, а с другой —

желанием выразить мысль покороче.

Ципф установил также, что частота и ко

личество слов, входящих в текст с этой час

тотой, связаны между собой. Если постро

ить график зависимости количества слов от

частоты их появления, то получившаяся

кривая будет также гиперболой и будет со

хранять свои параметры для всех без ис

ключения созданных человеком текстов.

Эту закономерность считают вторым зако

ном Ципфа.

Исследования показывают, что наибо

лее значимые слова лежат в средней части

гиперболы. Слова, которые попадаются

слишком часто, в основном оказываются

предлогами, местоимениями, в англий

ском — артиклями и т. п. Редко встречаю

щиеся слова тоже в большинстве случа

ев не имеют решающего смыслового зна

чения.

От того, как будет выставлен диапазон

значимых слов, зависят свойства информа

ционнопоисковой системы.

Если сделать слишком широкий диапа

зон — нужные термины потонут в море

вспомогательных слов; если установить уз

кий — можно потерять смысловые терми

ны. В каждой поисковой системе эта про

блема решается посвоему, с учетом обще

го объема текста, специальных словарей

и т . п.

Таким образом, закономерности Ципфа

отражают некоторое общее свойство, при

сущее разным языкам. Оно заключается

в том, что в каждом тексте на любом естест

венном языке имеется некоторое количест

Вопросы теории R Памятные даты

во наиболее употребимых слов. Причем

число этих слов значительно меньше обще

го числа слов, используемых в тексте.

Законы Ципфа универсальны. В принци

пе, они применимы не только к текстам.

В аналогичную форму выливается, на

пример, зависимость количества городов

от числа проживающих в них жителей. Ха

рактеристики популярности узлов в сети

Internet — тоже отвечают законам Ципфа.

Закономерность Ципфа проявляется и

при исследовании документальных инфор

мационных потоков. В этом случае закон

Ципфа представляют через абсолютную

частоту появления слов:

fi = Cri -1,

где fi — абсолютная частота появления сло

ва в текстах документального потока;

ri — ранг слова в ранговом распределе

нии;

C — частота появления слова iго ранга,

которую для данного ДИП можно считать

эмпирической константой.

Закон Мандельброта

Б. Мандельброт (Benoit Mandlebrot) в

1954 году [11] предложил теоретическое

обоснование эмпирически открытого зако

на Ципфа.

Представляя слова в виде последователь

ности букв, разделенных пустыми промежут

ками и присваивая знакам определенную

«стоимость» (затраты усилий, времени),

Мандельброт показывает, что словам можно

приписать априорные вероятности, так что

бы их общая «стоимость» в среднем была

минимальной и при этом количество инфор

мации оставалось инвариантным. На основе

этих представлений математическим путем

Мандельброт показал, что результирующее

соотношение между частотой слова и его

рангом соответствует эмпирическому зако

ну Ципфа с небольшой поправкой:

pri = kri - g ,

где pri — относительная частота появления

слова в тексте;

113

ri — ранг слова;

k — эмпирическая постоянная;

g — величина, близкая к единице, но из

меняющаяся в зависимости от свойств

текста.

Коэффициент g характеризует опреде

ленные свойства языка — степень его фор

мализованности. При этом с уменьшением g

степень формализованности языка умень

шается.

Информетрия и закономерности строения документальных информационных потоков

Закон Брэдфорда

Открыт английским химиком и библио

графом С. Брэдфордом в 1948 году [18–22]

на основе обнаружения общих принципов

распределения публикаций по изданиям

в разных областях (на примере изданий по

геофизике и химии).

Основной смысл закономерности состо

ит в следующем: если научные журналы

расположить в порядке убывания числа ста

тей по конкретной проблематике, то журна

лы можно разбить на три зоны таким обра

зом, чтобы количество статей в каждой зо

не по заданной теме было одинаковым.

При этом в первую зону, названной

Брэдфордом зоной ядра, входят профиль

ные журналы, непосредственно посвящен

ные рассматриваемой тематике. Количест

во журналов в зоне ядра невелико.

Вторую зону образуют журналы, частич

но посвященные заданной области, причем

их число существенно возрастает по срав

нению с числом журналов в ядре.

Третья зона — самая большая по количе

ству изданий — объединяет журналы, тема

тика которых весьма далека от рассматри

ваемой предметной области.

При равном числе публикаций в каждой

зоне число источников (в данном приме

ре — наименований журналов) резко воз

растает при переходе от одной зоны к дру

гой. Брэдфорд установил, что число наиме

нований журналов в третьей зоне примерно

во столько раз больше, чем во второй зоне,

во сколько раз число наименований журна

лов во второй зоне больше, чем в ядре:

P3 P2

P

»

» a и 3 » a2 , т. е. P3 : P2 : P1 » 1: a2 : a3 ,

P2 P1

P4

где P1, P2 , P3 — число наименований журна

лов в 1й, 2й и 3й зонах соответственно;

a = const.

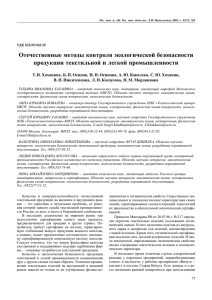

Закон Викери

Б. Викери (B. C. Vickery) [25] уточнил мо

дель С. Брэдфорда. Он выяснил, что журна

лы, проранжированные в порядке уменьше

ния числа статей в них по конкретному во

просу, можно разбить не на три зоны, а на

любое число зон (рис. 2).

Рис. 2. Закономерность Викери

114

Вопросы теории R Памятные даты

Основной смысл закономерности Вике

ри: если периодические издания располо

жить в порядке уменьшения в них количест

ва статей по конкретному запросу, то в по

лученном списке можно выделить ряд зон,

каждая из которых содержит одинаковое

количество статей. При этом число журна

лов в первой зоне и нарастающее их число

в последующих зонах соотносятся следую

щим образом:

Tx : T2 x : T3 x : T4 x : ... » 1: a2 : a3 : a4 : ..,

где x — количество статей в каждой зоне;

Tx — количество журналов, содержащих

x статей;

T2 x , T3 x , T4 x, ... — количество журналов,

содержащих 2x, 3x, 4x и т. д. статей соот

ветственно.

Часто этот закон называют законом

Брэдфорда в толковании Викери.

Закономерность

концентрации–рассеяния

В. И. Горьковой

В работах [9, 16, 19, 20] было показано,

что закономерности строения ДИП могут

быть выражены как посредством количест

венных параметров ранговых распределе

ний (закономерность Ципфа), так и посред

ством параметров упорядоченных потоков

элементов ДИП (закономерность Брэдфор

да–Викери), т. е. что эти закономерности

отображают одно феноменологическое яв

ление.

Смысловой анализ эмпирических данных

строения подсистем ДИП, проведенный в

работах В. И. Горьковой и ее учеников [2–7],

позволил зафиксировать наличие специ

фических функциональных свойств различ

ных частотных зон ранговых распределе

ний и упорядоченных потоков. Научные жур

налы, наиболее продуктивные по числу на

учных статей для соответствующего тема

тического раздела, сосредоточены в зоне

рангового распределения, где частоты по

явления наименований элементов наиболь

шие, т. е. в ядре рангового распределения.

Вопросы теории R Памятные даты

Структурное подмножество ядра ранго

вого распределения состоит из профиль

ных научных журналов, которые составля

ют приблизительно 10% всех наименований

журналов, содержащих публикации по дан

ному тематическому разделу. При этом в на

учных журналах, входящих в ядро рангового

распределения, содержится 50–60% всех

публикаций по данной тематике [3, 9, 12,

19, 20].

Тематическое содержание профильных

журналов ядра рангового распределения

определяет тематические признаки данно

го упорядоченного потока.

Для ядерного подмножества терминов

рангового распределения характерно вхо

ждение в него заглавных понятий, темати

ческое содержание которых определяет

классификатор данного тематического раз

дела. В зону ядра рангового распределения

авторов публикаций входят имена исследо

вателей, которым принадлежат основопо

лагающие положения тематического разде

ла [7].

На основе исследования этих специ

фических особенностей ядра В. И. Горь

ковой был сделан вывод о том, что явление

образования ядра рангового распреде

ления системы ДИП можно трактовать как

свойство системы ДИП концентрировать

в ядре рангового распределения логиче

скую информацию, определяющую основ

ные понятия предметной области, объектов

и методов исследования соответствующей

отрасли науки (техники), научной дисцип

лины.

Явление образования ядра Горькова

рассматривает как организацию высокого

уровня, когда между элементами подмноже

ства ядра существуют взаимосвязи, играю

щие более важную роль, чем связи между

элементами других подмножеств. Элемен

ты ядра выступают в роли «организаторов»

подсистемы ДИП в конкретной отрасли нау

ки или научной дисциплине, т. е. выполняют

функции организующих отношений систе

мы ДИП. Наименования элементов зоны яд

ра ДИП определяют условия включения

115

Информетрия и закономерности строения документальных информационных потоков

элементов всех других частотных зон ран

говых распределений в данную упорядо

ченную совокупность.

Одновременно с явлением образования

ядра рангового распределения элементов

ДИП по тематическому разделу наблюдает

ся рассеяние элементов.

Так, если ядро содержит около 10% всех

наименований элементов ДИП, что состав

ляет 50–60% упорядоченного потока под

систем ДИП, то в зоне рассеяния, содержа

щей 90% наименований элементов, сосре

доточено всего 40–50% упорядоченного по

тока документов.

Зона рассеяния рангового распределе

ния определяет структуру связи подсистем

ДИП различных отраслей науки (техники)

или научных дисциплин, взаимно обогаща

ющих друг друга семантической информа

цией.

Следует отметить, что рассмотренные

функциональные свойства двух зон ранго

вого распределения и упорядоченного по

тока огрубленно трактуют функциональные

свойства рангового распределения. В зоне

рассеяния можно выделить третье струк

турное подмножество элементов с малой

частотой появления, обладающее специ

фическими свойствами. В дальнейшем, ви

димо, возможна и более детальная структу

ризации зоны рассеяния.

Рассмотренное феноменологическое яв

ление концентрации и рассеяния элемен

тов ДИП было названо закономерностью

концентрации–рассеяния.

Действие закономерности концентра

ции–рассеяния основано на том, что упоря

доченное множество элементов ДИП име

ет два структурнофункциональных свой

ства.

Вопервых, концентрировать подмноже

ства ядерных элементов, функция которых

состоит в том, чтобы:

· сосредотачивать логическую инфор

мацию, определяющую основные предме

ты, объекты и методы исследований в от

расли науки;

116

· выполнять роль организующих отно

шений.

Вовторых, рассеивать подмножество

элементов, функция которых состоит в том,

чтобы:

· определять структурные связи под

систем ДИП различных отраслей науки

и научных дисциплин, обогащающих друг

друга семантической информацией;

· обеспечивать определенную целост

ность всей подсистемы ДИП.

Закономерность концентрации–рассея

ния позволяет использовать параметры ап

проксимирующих функций, описывающих

ранговые распределения и упорядоченные

потоки в качестве параметров, определяю

щих функциональные свойства упорядо

ченных совокупностей элементов ДИП.

По мнению В. И. Горьковой, одним из

важных параметров взаимосвязанности

для формирования ядра является мера «со

встречаемости» понятий [3, 7]. С исследо

ваниями статистических оценок парамет

ров закономерностей ДИП можно познако

миться в [7].

Следует еще раз обратить внимание на

тот факт, что численные меры упорядочен

ности строения ДИП, определяемые стати

стическими методами, только тогда могут

использоваться в практике научноинфор

мационной деятельности, когда они сочета

ются с методами исследования функцио

нальных свойств упорядоченных совокуп

ностей ДИП.

Перспективы развития информетрии

На основе идей законов Ципфа–Ман

дельброта и Брэдфорда–Викери, законо

мерности концентрации–рассеяния, сфор

мулированной В. И. Горьковой, развивают

ся методики автоматизации индексирова

ния и анализа текстов, введения весовых

коэффициентов терминов [28].

Вводятся меры веса ключевых слов. Так,

в работах Спарка Джонса эксперименталь

Вопросы теории R Памятные даты

но показано, что если N — общее число до

кументов и n — число документов, в кото

рых встречается данный индексный термин

(ключевое слово), то вычисление его веса

по формуле W = log( N n) + 1 приводит к бо

лее эффективным результатам поиска, чем

без использования оценки значимости ин

дексного термина, т. е. определенное зна

чение имеет не только частота применения

слова в конкретном документе, но и число

документов, в которых это слово встреча

ется.

Для проведения оценки вводятся лога

рифмические меры. Например, чтобы изба

виться от лишних слов и в тоже время под

нять рейтинг значимых слов, вводят инверс

ную частоту термина:

i x = log( N ni ),

где N — количество документов в базе дан

ных;

ni — количество документов с терми

ном i.

А затем каждому термину присваивают

весовой коэффициент, отражающий его

значимость:

j = jx i x ,

где j — вес термина i в документе;

jх — частота термина i в документе;

ix — инверсная частота термина.

Также в новом смысле используется

термин «ядро». В 1995 году на симпозиу

ме в Дублине предложена интересная и по

лезная для совершенствования информа

ционного поиска идея «Дублинского ядра»

(Dublin Core), основанная на формирова

нии метаданных, зафиксированных в спе

цификации определенного стандарта, и

представлении kго документа множеством

пар:

Dk = {Nik , Vik},

где Nik — имя iго элемента метаданных

«Дублинского ядра» в описании содер

жания kго документа;

Вопросы теории R Памятные даты

Vik — значение этого элемента метадан

ных.

Аналогично описывается поисковый об

раз запроса.

Перспективным представляется исполь

зование для формирования «Дублинского

ядра» закономерности концентрации–рас

сеяния.

В настоящее время возрастает интерес

и к способам оценки текстов [28]. Напри

мер, к работам Г. Луна [16], в которых пред

ложения текста оцениваются в соответст

вии с параметром:

Vпp =

2

Nзс

,

Nc

где Vпр — значимость предложения;

Nзс — число значимых слов в предложе

нии;

Nc — полное число слов в предложении.

Используя этот критерий, из любого до

кумента можно отобрать некоторое число

предложений. Понятно, что они не будут со

ставлять связного текста. Нужно учитывать

также, что значимые слова должны браться

из тематического тезауруса или отбираться

экспертом. По этой причине методика мо

жет лишь помочь человеку, а не заменить

его (во всяком случае, на современном эта

пе развития вычислительной техники).

Закономерности организации ДИП, вве

дения количественных мер терминов, пред

ложений и других компонентов текста по

лезно использовать на всех этапах созда

ния информационнопоисковых систем: при

комплектовании информационных фондов,

создании информационнопоисковых язы

ков и логикосемантического аппарата ин

формационнопоисковой системы, при ор

ганизации справочноинформационного об

служивания в библиотеках и отделах научно

технической информации, при создании и

совершенствовании классификационных

систем, выявлении тенденций роста и ста

рения ДИП, при аналитикосинтетической

обработке текстовой информации.

117

В настоящее время на основе предло

женной В. И. Горьковой концепции законо

мерности концентрации–рассеяния разра

батываются методы выявления информаци

онного ядра предметной области при по

строении информационной системы для

реорганизации бизнеспроцессов, при соз

дании виртуальных предприятий.

Информетрия и закономерности строения документальных информационных потоков

Список литературы

1. Воробьев Г. Г. Документ: Информацион

ный анализ. М.: Наука, 1973.

2. Горькова В. И. Статистические оценки

статистических совокупностей документальных

информационных потоков // НТИ. Сер. 2. 1971.

№ 12.

3. Горькова В. И., Меллион С. П. Математиче

ский метод оценки структуры классификации

систем информационных потоков // НТИ. Сер. 2.

1970. № 2.

4. Горькова В. И., Нумычева К. И. Частотное

распределение множества ключевых слов //

НТИ. Сер. 2. 1970. № 6.

5. Горькова В. И., Петренко Б. В. Совершен

ствование системы информационного обеспе

чения на основе статистического анализа ин

формационных потребностей специалистов.

Минск: БелНИИНТИ, 1973.

6. Горькова В. И., Гусева Т. И. Анализ доку

ментальных информационных потоков и изуче

ние запросов потребителей информации: лек

ции. М.: ИПКИР, 1974.

7. Горькова В. И. Информетрия: количест

венные методы в научнотехнической информа

ции // Итоги науки и техники. Сер. Информатика.

Т. 10. М.: ВИНИТИ, 1988.

8. Громов Г. Р. Национальные информацион

ные ресурсы: проблемы промышленной экс

плуатации. М.: Наука, 1984.

9. Козачков Л. С. Система потоков научной

информации. Киев: Наукова думка, 1973.

10. Лопухин М. М. ПАТТЕРН — метод плани

рования и прогнозирования научных работ. М.:

Советское радио, 1971.

11. Мандельброт Б. Теория информации и

психологическая теория частот слов. В Матема

тические методы в социальных науках. М.: Про

гресс, 1973.

118

12. Мицевич А. Т., Соловьев Н. К. Анализ не

которых закономерностей в потоках научно

технической информации по машиностроению //

НТИ. Сер. 2. 1970. № 6.

13. Шемакин Ю. И. Тезаурус в автоматизиро

ванных системах управления и обработки ин

формации. М.: Воениздат, 1974.

14. Шемакин Ю. И., Романов А. А. Компьютер

ная семантика. М.: Научнообразовательный

центр «Школа Китайгородской», 1996.

15. Шрейдер Ю. А. Логика знаковых систем.

М.: Знание, 1974.

16. Шрейдер Ю. А. О возможности теоретиче

ского вывода статистических закономерностей

текста: к обоснованию закона Ципфа // Пробле

мы передачи информации, 1967. Т. 3. Вып. 1.

17. Bonitz M. Scientometrie, Bibliometrie, Infor

metrie // Zentralblatt fur Bibliothekswessen. 1982.

V. 96. № 1.

18. Bradford S. C. Documentation. London: Cros

by Lockwood, 1948.

19. Brookes B. C. Bradford’s law and the biblio

graphy of science // Nature. 1969. V. 224. № 5223.

20. Brookes B. C. The derivation and application

of the Bradford — Zipf distribution // Journal of Do

cumentation. 1968. V. 24. № 4.

21. Brookes B. C. The complete Bradford — Zipf

«Bibliography» // Journal of Documentation. 1969.

V. 25. № 1.

22. Brookes B.C. Theory of Bradford law // Jour

nal of Documentation. 1977. V. 33. № 3.

23. Luhn H. P. Automatic creation of literature

abstracts // IBM Journal of Research and Develop

ment. 1958. V. 2. № 2.

24. Salton G. Automatic Text Analysis Science,

1970.

25. Vickery B. C. Bradford’s law of scattering //

Journal of Documentation. 1948. V. 4.

26. Zipf G. K. Human behavior and principle of

least effort. Cambridge (Mass.): Addison — Wesley,

1949. V. XI.

27. Zipf G. K. Selected studies of the principle of

relative frequency in language. Cambridge (Mass.):

Harvard University Press, 1932.

28. http://www.medialingvo.ru

Материал подготовила

Виолетта Волкова

Вопросы теории R Памятные даты