3G_L8-17

реклама

43

ЛЕКЦИЯ 8 (19.03.04)

ГЛАВА 3 УПРАВЛЕНИЕ ЗАДАЧАМИ И ПАМЯТЬЮ

Одной

из

важнейших

функций

ОС

является

организация

рационального использования ресурсов компьютера (процессоры,

память, внешние устройства, данные и программы). Одна и та же

вычислительная система может работать по-разному под управлением

разных ОС. Главные сложности при управлении ресурсами возникают

в мультипрограммных системах. Способы распределения времени

центрального процессора сильно влияют как на скорость выполнения

отдельных вычислений, так и на эффективность вычислительной

системы в целом.

При

рассмотрении

вопросов

данной

главы

не

будем

разграничивать понятия "процесс" и "поток", используя обобщающий

термин "задача".

Операционная система выполняет следующие основные функции,

связанные с управлением задачами:

создание и удаление задач;

планирование процессов и диспетчеризация задач;

синхронизация задач, обеспечение их средствами коммуникации.

§1 Подсистема управления процессами и потоками

Система управления задачами обеспечивает их прохождение через

компьютер. В зависимости от состояния процесса ему необходимо

выделить тот или иной ресурс. Например, новый процесс нужно

разместить в памяти, выделив ему адресное пространство; включить

в список задач, конкурирующих за процессорное время.

Одной

из

основных

подсистем

мультипрограммной

ОС,

непосредственно влияющей на функционирование вычислительной

машины, является подсистема управления процессами и потоками.

Она занимается их созданием и уничтожением, а также распределяет

процессорное время между одновременно существующими в системе

процессами и потоками.

Хотя потоки возникают и выполняются асинхронно, но при

одновременном выполнении в системе нескольких задач у них может

возникнуть необходимость во взаимодействии, например, при обмене

данными. Поэтому синхронизация потоков является одной из важных

функций подсистемы управления процессами и потоками.

Взаимодействие между процессами осуществляется с помощью

общих переменных и специальных базовых операций, называемых

примитивами.

Подсистема управления процессами и потоками имеет возможность

выполнять над процессами следующие операции:

создание (порождение)/уничтожение процесса;

приостановка/возобновление процесса;

блокирование/пробуждение процесса;

запуск процесса;

изменение приоритета процесса;

44

Подсистема управления процессами и потоками ответственна за

обеспечение процессов необходимыми ресурсами. ОС поддерживает в

памяти

специальные

информационные

структуры,

в

которые

записывает, какие ресурсы выделены каждому процессу. Ресурс

может назначаться процессу в единоличное пользование или в

совместное пользование с другими процессами. Некоторые из

ресурсов выделяются процессу при его создании, а некоторые –

динамически по запросам во время выполнения. Ресурсы могут быть

приписаны процессу на все время его жизни или только на

определенный период. При выполнении этих функций подсистема

управления процессами взаимодействует с другими подсистемами ОС,

ответственными за управление ресурсами, такими, как подсистема

управления памятью, подсистема ввода-вывода, файловая система.

1.1 Создание и удаление процессов и потоков

Создать процесс – это прежде всего означает создать описатель

процесса, в качестве которого выступает одна или несколько

информационных структур, содержащих все сведения о процессе,

необходимые операционной системе для управления им. Подробно

этот вопрос рассматривался ранее, сейчас только напомним, что в

число таких сведений могут входить, например, идентификатор

процесса, данные о расположении в памяти исполняемого модуля,

степень привилегированности процесса (приоритет и права доступа)

и т.п.

Создание

процесса

включает

загрузку

кодов

и

данных

исполняемой программы данного процесса с диска в оперативную

память.

При

этом

подсистема

управления

процессами

взаимодействует с подсистемой управления памятью и файловой

системой. В многопоточной системе при создании процесса ОС

создает для каждого процесса как минимум один поток выполнения.

При создании потока так же, как при создании процесса, ОС

генерирует специальную информационную структуру – описатель

потока, который содержит идентификатор потока, данные о правах

доступа и приоритете, о состоянии потока и т.п. После создания

поток

(или

процесс)

находится

в

состоянии

готовности

к

выполнению (или в состоянии бездействия, если речь идет об ОС

специального назначения).

Создание и удаление задач осуществляется по соответствующим

запросам от пользователей или от других задач. Задача может

породить новую задачу – во многих системах поток может

обратиться к ОС с запросом на создание т.н. потоков-потомков.

Порождающая

задача

называется

"предком",

"родителем",

а

порожденная – "потомком" или "дочерней задачей". "Предок" может

приостановить или удалить свою дочернюю задачу, в то время как

"потомок" не может управлять "предком".

В разных ОС по-разному строятся отношения между потокамипотомками

и

их

родителями.

В

одних

ОС

их

выполнение

синхронизируется

(после

завершения

родительского

потока

с

выполнения снимаются все его потомки), в других потомки

выполняются асинхронно по отношению к родительскому потоку.

После завершения процесса ОС "зачищает следы" его пребывания

в системе – закрывает все файлы, с которыми работал процесс,

45

освобождает области оперативной памяти, отведенные под коды,

данные

и

системные

информационные

структуры

процесса.

Выполняется коррекция очередей ОС и списков ресурсов, в которых

имелись ссылки на завершаемый процесс.

1.2 Планирование и диспетчеризация процессов и потоков

Стратегия планирования определяет, какие процессы выбираются

на выполнение для достижения поставленной цели. Стратегии могут

быть различными, например:

по возможности заканчивать вычисления в том же самом порядке,

в каком они были начаты;

отдавать предпочтение более коротким процессам;

предоставлять всем пользователям (задачам пользователей)

одинаковые услуги, в том числе и одинаковое время ожидания.

На протяжении существования процесса выполнение его потоков

может быть многократно прервано и продолжено.

Переход от выполнения одного потока к другому осуществляется

в результате планирования и диспетчеризации.

Планирование потоков осуществляется на основе информации,

хранящейся в описателях процессов и потоков. При планировании

могут приниматься во внимание приоритет потоков, время их

ожидания в очереди, накопленное время выполнения, интенсивность

обращения к вводу-выводу и др. факторы. ОС планирует выполнение

потоков независимо от того, принадлежат ли они одному или разным

процессам. Под планированием понимают задачу подбора такого

множества процессов, чтобы они как можно меньше конфликтовали

при

выполнении

и

как

можно

эффективнее

использовали

вычислительную систему.

В различных информационных источниках существуют различные

трактовки понятий "планирование" и "диспетчеризация". Так,

некоторые авторы планирование подразделяют на долгосрочное

(глобальное)

и

краткосрочное

(динамическое,

т.е.

текущее

наиболее

эффективное

распределение),

и

последнее

называют

диспетчеризацией.

Согласно

другим

источникам,

под

диспетчеризацией

понимают

реализацию

принятого

на

этапе

планирования решения. Мы будем придерживаться этого варианта.

Планирование включает в себя решение двух задач:

определение момента времени для смены активного потока;

выбор для выполнения потока из очереди готовых потоков.

Существует множество алгоритмов планирования, по-разному

решающих эти задачи. Именно особенности планирования определяют

специфику операционной системы. Рассмотрим их чуть позже.

В большинстве ОС планирование осуществляется динамически,

т.е. решения принимаются во время работы на основании анализа

текущей ситуации. Потоки и процессы появляются в случайные

моменты времени и непредсказуемо завершаются.

Статический тип планирования может быть использован в

специализированных системах, в которых весь набор одновременно

выполняемых

заданий

определен

заранее

(системы

реального

46

времени). Планировщик составляет расписание на основании знаний

о

характеристиках

набора

задач.

Затем

это

расписание

используется операционной системой для диспетчеризации.

Диспетчеризация

заключается

в

реализации

найденного

в

результате планирования решения, т.е. в переключении одного

процесса на другой. Диспетчеризация сводится к следующему:

сохранение контекста текущего потока, который требуется

сменить;

загрузка контекста нового потока, выбранного в результате

планирования;

запуск нового потока на выполнение.

В контексте потока отражены, во-первых, состояние аппаратуры

компьютера в момент прерывания (значение счетчика команд,

содержимое регистров общего назначения, режим работы процессора,

флаги, маски прерываний и др. параметры), во-вторых, параметры

операционной

среды

(ссылки

на

открытые

файлы,

данные

о

незавершенных операциях ввода-вывода, коды ошибок выполняемых

данным потоком системных вызовов и т.п.).

В контексте потока можно выделить часть, общую для всех

потоков данного процесса (ссылки на открытые файлы), и часть,

относящуюся только к данному потоку (содержимое регистров,

счетчик команд, режим процессора). Например, в среде NetWare

различаются три вида контекстов – глобальный контекст (контекст

процесса), контекст группы потоков и контекст отдельного потока.

Соотношение между данными этих контекстов аналогично соотношению

глобальных и локальных переменных в программе. Иерархическая

организация

контекстов

ускоряет

переключение

потоков:

при

переключении с потока одной группы на поток другой группы в

пределах одного процесса глобальный контекст не изменяется, а

меняется

лишь

контекст

группы.

Переключение

глобальных

контекстов происходит только при переходе с потока одного

процесса на поток другого процесса.

1.3 Алгоритмы планирования

С точки зрения решения первой задачи планирования (выбор

момента

времени

для

смены

активного

потока)

алгоритмы

планирования делятся на два больших класса – вытесняющие и

невытесняющие алгоритмы:

невытесняющие – активный поток может выполняться до тех пор,

пока он сам не передаст управление системе, чтобы та выбрала из

очереди другой готовый поток;

вытесняющие – операционная система принимает решение о смене

выполняемого задания и переключает процессор на другой поток.

Основным различием между названными алгоритмами планирования

является степень централизации механизма планирования потоков.

Рассмотрим основные характеристики, достоинства и недостатки

каждого класса алгоритмов.

Невытесняющие

алгоритмы.

Прикладная

программа,

получив

управление от ОС, сама определяет момент завершения очередного

цикла своего выполнения и только затем передает управление ОС с

47

помощью

какого-либо

системного

вызова.

Следовательно,

управление приложением со стороны пользователя теряется на

произвольный период времени. Разработчикам необходимо учитывать

это и создавать приложения так, чтобы они работали как бы

"частями",

периодически

прерываясь

и

передавая

управление

системе,

т.е.

при

разработке

выполняются

еще

и

функции

планировщика.

Достоинства данного подхода:

исключено прерывание потока в неудобный для него момент;

решается проблема одновременного использования данных, т.к.

во

время

каждого

цикла

выполнения

задача

использует

их

монопольно и уверена, что никто другой не сможет их изменить;

более высокая скорость переключения с потока на поток.

Недостатками являются затрудненная разработка программ и

повышенные требования к квалификации программиста, а также

возможность захвата процессора одним потоком при его случайном

или преднамеренном зацикливании.

Примеры:

1. В

операционной системе Windows 3.x разработанные в ней

приложения действовали именно таким образом, и программисты

должны были сами обеспечивать "дружественное" отношение своих

программ

к

другим

задачам

(крайним

проявлением

"недружественности" является зависание приложения, которое

приводит к краху системы).

2. Файл-серверы

NetWare 3.x, 4.x – высокая скорость выполнения

файловых операций. Поток, чтобы не занимать процессор слишком

долго, сам отдает управление с помощью системных вызовов.

Простой

алгоритм

планирования

и

иерархии

контекстов

обуславливает небольшие накладные расходы на диспетчеризацию

потоков, вследствие чего невытесняющий механизм организации

многопоточной работы в этой ОС очень производителен.

Вытесняющие алгоритмы – циклический, или круговой тип

планирования, при котором операционная система сама решает

вопрос о прерывании активного приложения и переключает процессор

с одной задачи на другую в соответствии с тем или иным

критерием. В системе с такими алгоритмами программисту не надо

заботиться

о

том,

что

его

приложение

будет

выполняться

одновременно с другими задачами. В качестве примеров можно

назвать операционные системы UNIX, Windows NT/2000, OS/2.

Алгоритмы этого класса ориентированы на высокопроизводительное

выполнение приложений.

Вытесняющие алгоритмы могут быть основаны на концепции

квантования или на механизме приоритетов.

Алгоритмы,

основанные

на

квантовании.

Каждому

потоку

предоставляется ограниченный непрерывный квант процессорного

времени (его величина не должна быть меньше 1 мс – как правило,

несколько

десятков

мс).

Поток

переводится

из

состояния

выполнения в состояние готовности в случае, если квант исчерпан.

Кванты могут быть одинаковыми для всех потоков или различными.

48

При выделении квантов потоку могут использоваться разные

принципы: эти кванты могут быть фиксированной величины или

изменяться в разные периоды жизни потока. Например, для

некоторого конкретного потока первый квант может быть довольно

большим, а каждый следующий выделяемый ему квант может иметь

меньшую длительность (уменьшение до заданных пределов). Таким

образом формируется преимущество для более коротких потоков, а

длительные задачи переходят в фоновый режим. Другой принцип

основан на том факте, что процессы, часто выполняющие операции

ввода-вывода, не полностью реализуют выделяемые им кванты

времени.

Для

компенсации

этой

несправедливости

из

таких

процессов может быть сформирована отдельная очередь, которая

имеет привилегии по отношению к остальным потокам. При выборе

очередного потока на выполнение сначала просматривается эта

очередь, и, только если она пуста, выбирается поток из общей

очереди готовых к выполнению.

Замечание

Эти

алгоритмы

не

используют

никакой

предварительной

информации о задачах. Дифференциация обслуживания в данном

случае базируется на "истории существования" потока в системе.

С точки зрения второй задачи планирования (принцип выбора на

выполнение очередного потока) алгоритмы также могут быть условно

разбиты на классы: бесприоритетные и приоритетные алгоритмы. При

бесприоритетном обслуживании выбор очередной задачи производится

в некотором заранее заданном порядке без учета их относительной

важности и времени обслуживания. При реализации приоритетных

дисциплин некоторым задачам предоставляется преимущественное

право попасть в состояние исполнения.

Теперь

рассмотрим

дисциплины планирования.

некоторые

наиболее

распространенные

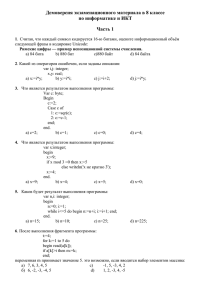

1) Обслуживание в порядке поступления. Выделение процессора

производится по принципу FIFO (First In First Out), т.е. в

порядке

поступления

заявок

на

обслуживание.

Этот

подход

Выполненные задачи

Процессор

Очередь задач, снова готовых к выполнению

Очередь новых задач

Блокирование

Дисциплина

планирования FIFO

позволяет реализовать стратегию "по возможности заканчивать

вычисления в порядке их появления". Те задачи, которые были

заблокированы в процессе выполнения, после перехода в состояние

49

готовности ставятся в очередь перед теми задачами, которые еще

не выполнялись. Таким образом, создается две очереди: одна из

еще не выполнявшихся задач, а другая – из задач, перешедших из

состояния ожидания.

Эта дисциплина реализуется как невытесняющая, когда задачи

освобождают процессор добровольно.

Достоинством

данного

алгоритма

является

его

простота

реализации. Недостатком – при большой загрузке короткие задания

вынуждены ожидать в системе долгое время. Следующий подход

устраняет этот недостаток.

ЛЕКЦИЯ 9 (26.03.04)

2) Кратчайший процесс обслуживается первым. Согласно этому

алгоритму,

следующим

для

выполнения

назначается

поток

с

минимальным оценочным временем, требуемым для окончания его

работы. Здесь оказывается предпочтение потокам, которым осталось

немного времени до их завершения. Благодаря этому уменьшается

количество ожидающих задач в системе. Недостатком является

необходимость заранее знать оценочные времена, что не всегда

возможно. В качестве грубого приближения в некоторых случаях

можно использовать время, затраченное потоком при последнем

получении управления.

Алгоритм относится к разряду невытесняющих бесприоритетных.

Названные алгоритмы могут использоваться для пакетных режимов

работы, когда пользователь не ожидает реакции системы. Для

интерактивных же вычислений нужно прежде всего обеспечить

приемлемое время реакции и равенство в обслуживании для

мультитерминальных

систем.

Для

однопользовательских

систем

желательно, чтобы те программы, с которыми непосредственно

работают, имели лучшее время реакции, чем фоновые задания. Кроме

того, некоторые приложения, выполняясь без непосредственного

участия пользователя, должны тем не менее гарантированно

получать свою долю процессорного времени (например, программа

получения электронной почты). Для решения подобных проблем

используются

приоритетные

методы

обслуживания

и

концепция

квантования.

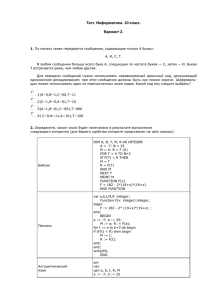

3)

Карусельная

дисциплина,

Процессор

или

круговая

–

RR

(Round

Выполненные задачи

Очередь задач, готовых к выполнению

Дисциплина планирования RR

Новые задачи

Robin).

50

Данная дисциплина относится к вытесняющим алгоритмам и основана

на квантовании. Каждая задача получает процессорное время

порциями – квантами. После окончания кванта времени задача

снимается с процессора и ставится в конец очереди процессов,

готовых к выполнению, а на обслуживание процессором принимается

очередная задача. Для оптимальной работы системы необходимо

правильно выбрать закон, по которому кванты времени выделяются

задачам.

Величина кванта выбирается как компромисс между приемлемым

временем реакции системы на запросы пользователей (с тем, чтобы

их простейшие запросы не вызывали длительного ожидания) и

накладными расходами на частую смену задач. При прерываниях ОС

должна сохранить достаточно большой объем информации о текущем

процессе,

поставить

дескриптор

снятой

задачи

в

очередь,

загрузить контекст новой задачи. При малой величине кванта

времени

и

частых

переключениях

относительная

доля

таких

накладных

расходов

станет

большой,

и

это

ухудшит

производительность системы в целом. При большой величина кванта

времени и увеличении очереди готовых задач реакция системы

станет плохой.

В некоторых ОС есть возможность указывать в явном виде

величину кванта времени или допустимый диапазон его значений.

Например, в OS/2 в файле CONFIG.SYS с помощью оператора

TIMESLICE указывается минимальное и максимальное значения для

кванта времени: TIMESLICE=32,256 указывает, что квант возможно

изменять в пределах от 32 до 256 миллисекунд.

Данная дисциплина обслуживания является одной из самых

распространенных. В некоторых случаях, когда ОС не поддерживает

в явном виде дисциплину карусельного планирования, такое

обслуживание

можно

организовать

искусственно.

Например,

в

некоторых

ОСРВ

используется

планирование

с

абсолютными

приоритетами, а при равенстве приоритетов действует принцип

очередности. Т.е., снять задачу с выполнения может только задача

с более высоким приоритетом. При необходимости организовать

обслуживание равномерно и равноправно, т.е. чтобы все задания

получали одинаковые кванты времени, системный оператор может сам

реализовать такое обслуживание. Для этого достаточно всем

пользовательским задачам присвоить одинаковые приоритеты и

создать одну высокоприоритетную задачу, которая не должна ничего

делать, кроме как планироваться на выполнение по таймеру через

указанные интервалы времени. Эта задача будет только снимать с

выполнения текущее приложение, оно переместится в конец очереди,

а сама задача тут же покинет процессор и уступит его следующему

в очереди процессу.

В простейшей реализации карусельная дисциплина обслуживания

предполагает, что все задания имеют одинаковый приоритет. Если

же необходимо ввести механизм приоритетного обслуживания, обычно

организуют несколько очередей, в зависимости от приоритетов, и к

обслуживанию менее приоритетной очереди переходят только в том

случае, когда более приоритетная очередь пуста. По такому

алгоритму выполняется планирование в системах OS/2 и Windows NT.

4)

Планирование согласно приоритетам.

51

Важная концепция, лежащая в основе многих вытесняющих

алгоритмов – это приоритетное обслуживание. Такие алгоритмы

используют информацию, находящуюся в описателе потока – его

приоритет. В разных системах приоритет определяется по-разному.

В одних системах наивысшим значением приоритета может считаться

его численно наибольшее значение, в других – наоборот, наивысшим

приоритетом считается нулевой.

Как правило, приоритет потока непосредственно связан с

приоритетом процесса, в рамках которого выполняется данный

поток. Приоритет процесса назначается операционной системой при

его создании, при этом учитывается, является ли процесс

системным

или

прикладным,

каков

статус

пользователя,

запустившего процесс, было ли явное указание пользователя на

присвоение

процессу

определенного

приоритета.

Значение

приоритета включается в описатель процесса и используется при

назначении приоритета его потокам. Если поток инициирован не по

команде пользователя, а в результате выполнения системного

вызова другим потоком, тогда для назначения ему приоритета ОС

должна учитывать параметры системного вызова.

При планировании обслуживания программ согласно описанным

ранее алгоритмам может возникнуть ситуация, когда некоторые

задачи контроля или управления не смогут быть реализованы в

течение

длительного

промежутка

времени

из-за

возрастания

нагрузки в системе (особенно в ОСРВ). При этом последствия из-за

несвоевременного выполнения таких задач могут быть серьезнее,

чем из-за невыполнения каких-то программ с более высоким

приоритетом. В таком случае было бы целесообразно временно

изменить приоритет "аварийных" задач (у которых истекает

отпущенное для них время обработки), а после выполнения

восстановить прежнее значение. Введение механизмов динамического

изменения

приоритетов

позволяет

реализовать

более

быструю

реакцию системы на короткие запросы пользователей (что важно при

интерактивной работе), но при этом гарантировать выполнение

любых запросов.

Таким

образом,

приоритет

может

быть

статическим

(фиксированным)

или

динамическим

(изменяющимся

системой

в

зависимости от ситуации в ней). Так называемый базовый приоритет

потока непосредственно зависит от базового приоритета процесса,

его породившего. В некоторых случаях система может повышать

приоритет потока (причем в различной степени), например, если

квант отведенного ему процессорного времени не был использован

полностью, или понижать приоритет в противном случае. Например,

ОС повышает приоритет в большей степени потокам, ожидающим ввода

с клавиатуры, и в меньшей степени – потокам, выполняющим

операции с диском. В некоторых системах, использующих механизм

динамических приоритетов, для изменения приоритета используются

достаточно сложные формулы, в которых участвуют значения базовых

приоритетов, степень загрузки вычислительной системы, начальное

значение приоритета, заданное пользователем, и т.п.

Пример

Рассмотрим схему назначения потоков, принятую в Windows NT. В

системе определено 32 уровня приоритетов и два класса потоков –

52

потоки реального времени и потоки с переменными приоритетами.

Диапазон от 1 до 15 включительно отведен для потоков с

переменными приоритетами, а от 16 до 31 – для более критичных

ко

времени

потоков

реального

времени

(приоритет

0

зарезервирован для системных целей). При создании процесса он в

зависимости от класса получает базовый приоритет в верхней или

нижней части диапазона. Этот базовый приоритет процесса может

быть в дальнейшем повышен или понижен операционной системой.

Поток первоначально получает значение базового приоритета из

диапазона базового приоритета процесса, в котором он был

создан. Пусть, например, значение базового приоритета процесса

равно k. Тогда все потоки данного процесса получат базовые

приоритеты из диапазона [k-2,k+2].

Существуют две разновидности приоритетного планирования:

обслуживание с относительными приоритетами и обслуживание с

абсолютными приоритетами. В обоих случаях выбор потока на

выполнение осуществляется одинаково – выбирается поток, имеющий

наивысший

приоритет,

а

момент

смены

активного

потока

определяется по-разному. В системе с относительными приоритетами

активный поток выполняется до тех пор, пока он сам не покинет

процессор (перейдет в состояние ожидания, или произойдет ошибка,

или поток завершится). В системе с абсолютными приоритетами

прерывание активного потока, кроме указанных причин, происходит

еще и в случае, если в очереди готовых потоков появляется поток

с более высоким приоритетом, чем активный. Тогда выполняемый

поток прерывается и переводится в состояние готовности.

В системе с планированием на основе относительных приоритетов

минимизируются затраты на переключение, но одна задача может

занимать процессор долгое время. Для систем разделения времени и

реального времени такой режим обслуживания не подходит, а вот в

системах пакетной обработки (например, OS/360) он используется

широко. Планирование с абсолютными приоритетами подходит для

систем управления объектами, в которых важна быстрая реакция на

события.

Смешанный тип планирования используется во многих ОС:

алгоритмы планирования на основе приоритетов сочетаются с

концепцией квантования.

Примеры

Рассмотрим примеры операционных систем, в которых квантование

сочетается с динамическими абсолютными приоритетами.

1. Именно так организовано планирование в системе Windows NT. На

выполнение выбирается поток с наивысшим приоритетом, ему

выделяется квант времени. Если во время его выполнения в

очереди готовых появляется поток с более высоким приоритетом,

то

он

вытесняет

выполняемый

поток.

Вытесненный

поток

возвращается в очередь готовых, причем ставится впереди всех

остальных потоков, имеющих такой же приоритет.

2. В системе OS/2 планирование основано на тех же принципах. При

этом на множестве потоков определены приоритетные классы –

критический, серверный, стандартный и остаточный, в каждом из

которых имеется 32 приоритетных уровня. Потоки критического

53

класса относятся к задачам реального времени и имеют наивысший

приоритет (системные потоки, управляющие сетью), следующий по

приоритетности класс предназначен для потоков, обслуживающих

серверные приложения. Потоки обычных приложений относятся к

стандартному классу (еще его называют регулярным), самый низкий

приоритет у потоков остаточного класса (например, программа

проверки электронной почты или поток вывода на экран заставки).

Поток из менее приоритетного класса не может быть выбран на

выполнение, пока очередь более приоритетного класса не пуста.

Внутри класса потоки также выбираются по приоритетам, а потоки

с одинаковым приоритетом обслуживаются в циклическом порядке.

Переход от одного потока к другому происходит либо по окончании

отведенного

ему

кванта

процессорного

времени,

либо

по

системному прерыванию, передающему управление задаче с более

высоким приоритетом (обеспечивает более быструю реакцию на

события).

Операционная система сама изменяет приоритет выполняющихся

задач. Например, она повышает приоритет "забытых" задач

следующим образом. Если задача не получает управление в течение

достаточно

долгого

промежутка

времени

(который

задается

специальным оператором MAXWAIT в файле CONFIG.SYS), ей временно

присваивается наивысший уровень приоритета (?своего класса?)

(правда, не превышающий критический). После выполнения этого

приложения в течение одного кванта времени ему возвращается

прежнее значение приоритета. Этот механизм позволяет задачам с

остаточным приоритетом даже в сильно загруженных системах

поступать на выполнение хотя бы в краткие интервалы времени. В

противном случае они могли бы вообще никогда не получить

управления.

3. В ОС UNIX System V Release 4 (SVR4) понятие "поток"

отсутствует, и планирование осуществляется на уровне процессов

в

соответствии

с

алгоритмом

вытесняющей

многозадачности,

основанной на использовании приоритетов и квантовании.

Каждый процесс относится к одному из трех приоритетных

классов: реального времени, разделения времени или системных

процессов. Назначение и обработка приоритетов выполняются для

разных

классов

по-разному.

Процессы

системного

класса,

зарезервированные для ядра, имеют фиксированные приоритеты,

назначаемые ядром и никогда не изменяющиеся. Процессы реального

времени также используют стратегию фиксированных приоритетов,

но

пользователь

может

их

изменять.

Для

каждого

уровня

приоритета

по

умолчанию

имеется

своя

величина

кванта

процессорного времени. Процессы разделения времени используют

стратегию

динамических

приоритетов.

Величина

приоритета

вычисляется пропорционально значениям двух составляющих –

пользовательской части и системной части. Пользовательская

часть может быть изменена администратором или владельцем

процесса, причем последним – только в сторону его снижения.

Системная

составляющая

позволяет

планировщику

управлять

процессами в зависимости от того, как долго они занимают

процессор, не уходя в состояние ожидания. У тех процессов,

которые потребляют большие интервалы процессорного времени, не

уходя в состояние ожидания, приоритет снижается, но выделяется

54

больший квант времени. Процессам, часто уходящим в состояние

ожидания после короткого периода использования процессорного

времени, приоритет повышается.

Планирование в системах реального времени. Планирование здесь

имеет особое значение. Поскольку выполнение процессов привязано

к внешним условиям, система должна реагировать на сигналы

управляемого объекта в пределах заданных временных ограничений.

Системы реального времени подразделяются на жесткие (hard) и

мягкие (soft) в зависимости от степени критичности условий

работы.

Система

называется

жесткой,

если

последствия

несоблюдения временных ограничений катастрофичны – например,

система управления полетами или атомной электростанцией. Если же

последствия нарушения временных ограничений не столь серьезны,

то система называется мягкой, например, система резервирования

билетов.

В

жестких

системах

время

выполнения

процессов

четко

ограничено директивными сроками. Директивные сроки – это два

числа Tb и Tf. Первое обозначает время, раньше которого процесс

не может начать работу, а второе – время, к которому он должен

ее завершить. В таких системах время завершения выполнения

каждой из критических задач должно быть гарантировано для всех

возможных сценариев работы системы. Такие гарантии могут быть

даны

либо

в

результате

исчерпывающего

тестирования

всех

возможных сценариев поведения управляемого объекта и управляющих

программ, либо в результате построения статического расписания,

либо

в

результате

выбора

математически

обоснованного

динамического

алгоритма

планирования.

Точные

критерии

возможности существования расписания являются очень сложными в

вычислительном отношении. В мягких системах применяются менее

затратные способы планирования.

В рассмотренных выше системах UNIX System V Release 4, OS/2 и

Windows NT имеется приоритетный класс реального времени. Для

потоков этого класса обеспечено только предпочтение в скорости

обслуживания, но не гарантировано выполнение заданных временных

ограничений. Поэтому эти ОС могут быть основой для построения

лишь мягких систем реального времени, но непригодны для жестких

систем.

За последние годы появился ряд интересных подходов к

планированию,

основанных

на

дополнительной

информации

о

заданиях, например:

–

Время готовности – время, когда задание становится доступным

для выполнения. В повторяющемся или периодическом задании время

готовности

представляет

собой

последовательность

заранее

известных времен.

–

Предельное время начала выполнения – время, когда должно

начаться выполнение задания.

–

Предельное время завершения выполнения – время, когда задание

должно

быть

полностью

завершено.

Обычно

задания

имеют

ограничение по предельному времени начала либо завершения

выполнения, но не оба одновременно.

55

–

Время выполнения – время, требующееся заданию для его

полного выполнения. Иногда это время известно, иногда система

сама оценивает среднее значение.

–

Требования к ресурсам – множество ресурсов, требующихся

заданию для его выполнения.

–

Приоритет – мера относительной важности задания. Жесткие

задания реального времени имеют абсолютный приоритет и приводят

к сбою системы при нарушении временных ограничений этих заданий.

–

Структура подзадач. Задача может быть разбита на обязательные

и необязательные подзадачи, при этом жесткие предельные сроки

имеют только обязательные подзадачи.

Для заданной стратегии вытеснения и использования либо

предельного времени начала выполнения, либо предельного времени

завершения применение планирования, выбирающего для выполнения

задание с наиболее ранним предельным временем, позволяет

минимизировать

долю

заданий

с

нарушенными

временными

ограничениями.

Если определяется предельное время начала работы, то

целесообразно применять невытесняющее планирование. В таком

случае желательно, чтобы задания после завершения обязательной

или критической части самостоятельно блокировались и позволяли

выполняться другим заданиям с предельным временем начала работы.

Для системы с предельным временем завершения больше подходит

вытесняющая стратегия.

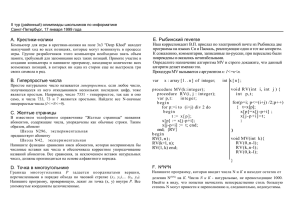

Рассмотрим пример планирования периодических заданий с

предельным временем завершения.

Пусть система собирает и обрабатывает данные от двух

датчиков, A и B. Сроки сбора данных от датчика A – каждые 20 мс,

от датчика B – каждые 50 мс. Процесс снятия данных, включая

накладные расходы ОС, занимает: для датчика A – 10 мс, для

датчика B – 25 мс.

B1

A1

A:

B:

A1

A2

A2

A3

A3

B1

0

предельные сроки

A4

A4

B2

B2

A5

A5

t

10 20 30 40 50 60 70 80 90 100

Время поступления, выполнения и предельное время

Предположим, что используется схема с приоритетами. В случае

более высокого приоритета A задание B получит только 20 мс

процессорного времени в двух смежных интервалах по 10 мс, после

этого будет достигнуто его предельное время выполнения, а

задание еще не выполнится (см. иллюстрацию ниже). Если более

высокий приритет назначить заданию B, то (что очевидно) в срок

не успеет выполниться задание A.

B1 – опоздание

A:

B:

A1

A2

B1

A3

B1

A4

B2

A5

B2

t

56

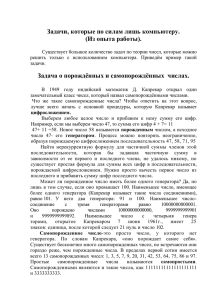

В данной ситуации наиболее целесообразно использовать

вытесняющее планирование с предельным временем завершения. В

момент времени t=0 поступают задания A1 и B1. Поскольку

предельный срок A1 наступает раньше, сначала выполняется A1.

После его завершения начинает выполняться B1, но после появления

в момент t=20 задания A2 его предельное время завершения

оказывается меньшим, поэтому выполнение B1 прерывается и не

продолжается, пока не выполнится A2 (к моменту t=30). В момент

времени t=40 появляется очередное задание A3, но его предельное

время завершения больше, чем у выполняющегося B1, поэтому

сначала оно завершится (в момент t=45), и только затем начнет

выполняться A3. Данная схема проиллюстрирована на рисунке.

B1

A1

A2

предельные сроки

A3

B2

A4

A5

t

A:

B:

A1

A2

B1

B1

0

10

20

A3

30

A4

B2

40

50

60

A5

B2

70

80

90

100

ЛЕКЦИЯ 10 (31.03.04)

§2 Организация параллельных взаимодействующих

процессов

2.1 Взаимодействие процессов

Основной особенностью мультипрограммных вычислительных систем

является то, что в их среде параллельно развивается несколько

(последовательных) вычислительных процессов. С точки зрения

внешнего наблюдателя эти процессы выполняются одновременно,

поэтому будем считать их работающими параллельно независимо от

того, реально они используют в некоторый момент времени

различные процессоры, каналы, устройства или разделяют одни и те

же ресурсы во времени. Любая мультипрограммная ОС вместе с

параллельно выполняющимися в ней задачами пользователей может

быть

логически

описана

как

совокупность

последовательных

процессов. Эти процессы, с одной стороны, состязаются за

использование ресурсов, переходя из одного состояния в другое, а

с другой – действуют почти независимо друг от друга, но образуют

систему вследствие установления всевозможных связей между ними

путем пересылки сообщений и синхронизирующих сигналов.

Два параллельных

взаимодействующими.

процесса

могут

быть

независимыми

или

Независимыми являются процессы, множества переменных которых

не пересекаются. Под переменными в этом случае понимают файлы

данных, а также области оперативной памяти, сопоставленные

определенным в программе переменным. Независимые процессы не

влияют на результаты работы друг друга, т.к. не могут изменить

значение переменных другого независимого процесса. Они могут

57

только являться причиной задержек исполнения других процессов,

т.к. вынуждены разделять ресурсы системы.

Взаимодействующие процессы совместно используют некоторые

общие переменные, и выполнение одного процесса может повлиять на

выполнение другого.

Взаимодействовать могут либо конкурирующие процессы, либо

совместно выполняющие общую работу. Конкурирующие процессы на

первый взгляд действуют относительно независимо, но имеют доступ

к общим переменным. Процессы, работа которых построена на обмене

данными (результат вычислений одного процесса в явном виде

передается другому), называют сотрудничающими.

Многие

ресурсы

системы

могут

использоваться

совместно

несколькими процессами, но к разделяемым ресурсам в каждый

момент времени может иметь доступ только один процесс. Ресурсы,

которые не допускают одновременного использования несколькими

процессами, называют

критическими. В системе должна быть

предусмотрена защита от одновременного доступа процессов к

критическим

ресурсам,

иначе

в

ней

могут

возникать

непрогнозируемые и трудно обнаруживаемые ошибки.

В мультипрограммной системе потоки и процессы протекают

асинхронно, с различными скоростями, на которые могут влиять еще

и решения планировщиков относительно других процессов. Поэтому

влияние взаимодействующих процессов друг на друга невозможно

спрогнозировать. Чтобы предотвратить порчу общих данных и

исключить

взаимную

блокировку,

потокам

необходимо

синхронизировать

свою

работу.

Синхронизация

заключается

в

согласовании скоростей потоков путем приостановки потока до

наступления некоторого события и последующей его активизации,

когда это событие произойдет.

Взаимодействие сотрудничающих потоков удобно рассматривать в

схеме

"производитель–потребитель":

Поток-получатель

должен

обращаться за данными только после того, как они помещены в

буфер потоком-отправителем. Если же поток-получатель обратился

за данными раньше, то он должен быть приостановлен до момента

поступления данных.

При отсутствии синхронизации возможны следующие проблемы:

Возникновение гонок. Гонками называется такая ситуация, когда

два или более потоков обрабатывают разделяемые данные и конечный

результат зависит от соотношения скоростей потоков.

Взаимные блокировки, или тупики (дедлоки, клинчи – разные

термины для обозначения одного события). Тупик – это состояние,

когда несколько процессов ждут событий, которые могут быть

вызваны только одним из этих процессов. Так как все процессы

находятся в состоянии ожидания, то эти события не произойдут

никогда, следовательно, без вмешательства системы ожидание будет

бесконечным.

Например, процесс P1 занимает ресурс X и для дальнейшей

работы нуждается в ресурсе Y, а процесс P2 занимает ресурс Y и

для дальнейшей работы нуждается в ресурсе X. Возникает

ситуация тупика (взаимной блокировки), поскольку ни один из

процессов не может завершить работу из-за нехватки ресурса,

который, в свою очередь, никогда не освободится.

58

Существует

ряд

механизмов

синхронизации

потоков

и

процессов. Они могут образовывать иерархию, когда на основе

более простых средств строятся более сложные, а также могут быть

функционально

специализированными,

например,

средства

для

синхронизации

потоков

одного

процесса,

средства

для

синхронизации потоков разных процессов при обмене данными и т.п.

Для синхронизации потоков прикладных программ программист может

использовать

как

средства

операционной

системы,

так

и

собственные приемы синхронизации.

Механизмы синхронизации различаются в зависимости от того,

относятся они к потокам одного или разных процессов. Для

синхронизации

потоков

одного

процесса

можно

использовать

глобальные

блокирующие

переменные,

которые

позволяют

контролировать работу потоков в критической секции (мониторы,

семафоры). Для потоков разных процессов ОС использует системные

семафоры, события, сигналы, таймеры и пр. В распределенных

системах, состоящих из нескольких процессоров, синхронизация

может быть реализована только посредством передачи сообщений.

Рассмотрим несколько более подробно некоторые названные средства

синхронизации и связанные с ними понятия.

2.2 Критическая секция. Взаимоисключение

Критическая

секция

–

это

часть

программы,

результат

выполнения

которой

может

непредсказуемо

меняться,

если

переменные, относящиеся к этой части программы, изменяются

другими потоками, когда выполнение этой части еще не завершено.

Критическая

секция

всегда

определяется

по

отношению

к

критическим данным, при несогласованном изменении которых могут

возникнуть нежелательные эффекты.

Общие данные, разделяемые несколькими потоками, удобно

описывать

как

ресурс,

а

обновление

данных

соответствует

распределению или освобождению элементов ресурса.

Рассмотрим примеры.

1. Пусть два потока p1 и p2 асинхронно увеличивают значение

общей

целочисленной

переменной

x,

которая

представляет

количество общих единиц ресурса:

p1: ... ; x:=x+1; ... ; ...

p2: ... ; x:=x+1; ... ; ...

Если бы потоки выполнялись на разных процессорах C1 и C2,

имеющих внутренние регистры R1 и R2 и разделяемую основную

память, то могла бы возникнуть любая из следующих двух

последовательностей:

(1)p1: R1:=x; R1:=R1+1; x:=R1; ...

p2: ... ; R2:=x; R2:=R2+1; x:=R2; ...

t0

(2)p1: R1:=x; R1:=R1+1; x:=R1; ...

p2:

t1

... ; R2:=x; R2:=R2+1; x:=R2; ...

Пусть x содержит значение V в момент времени t0. Тогда, если

бы

выполнение

потоков

p1

и

p2

происходило,

как

в

59

последовательности (1), то в момент t1 переменная x содержала

бы значение V+1 , если же – как в последовательности (2), то

переменная x содержала бы значение V+2. Точно такие же

результаты были бы получены, если бы потоки p1 и p1 разделяли

во времени единственный процессор с переключением управления

между

потоками

посредством

прерываний.

В

этом

примере

проиллюстрирован эффект гонок.

2. Рассмотрим другой пример – задачу ведения базы данных

клиентов некоторого предприятия. Каждому клиенту отводится

отдельная запись в базе данных, в которой среди прочих полей

имеются поля ЗАКАЗ и ОПЛАТА. Программа, ведущая базу данных,

оформлена как единый процесс, имеющий несколько потоков, в том

числе поток A, который заносит в базу информацию о заказах,

поступивших от клиентов, и поток B, который фиксирует в базе

сведения об оплате клиентами выставленных счетов. Оба эти

потока совместно работают над общим файлом базы данных,

используя однотипные алгоритмы, включающие три шага:

Считать из файла базы данных в буфер запись о клиенте с

заданным идентификатором;

Внести новое значение в поле ЗАКАЗ (для потока A) или ОПЛАТА

(для потока B);

Вернуть модифицированную запись в файл базы данных.

Обозначим соответствующие шаги для потока A как A1, A2, A3, а

для потока B – B1, B2, B3. Предположим, что тому и другому

потоку потребовалось изменить сведения о заказе и оплате

одного и того же клиента N. В некоторый момент времени поток A

считывает

соответствующую

клиенту

запись

в

буфер

и

поток A

A1

считать запись

в буфер

A2

внести изменения

в поле "заказ"

A3

сохранить запись

в файле

критическая

секция

поток B

B1

считать запись

в буфер

B2

внести изменения

в поле "оплата"

B3

сохранить запись

в файле

заказ

оплата

запись о

клиенте N

критическая

секция

Возникновение гонок при доступе к разделяемым данным

60

модифицирует значение поля ЗАКАЗ (шаги A1, A2), но внести эту

запись в базу (выполнить шаг A3) не успевает, т.к. его

выполнение

прерывается,

например,

вследствие

завершения

отведенного ему кванта времени. Когда подходит очередь потока

B, он тоже успевает только считать запись в буфер и произвести

изменения в поле ОПЛАТА (шаги B1, B2), а внести измененную

запись (шаг B3) в базу не успевает.

В такой ситуации окончательный результат, занесенный в базу,

будет зависеть от того, какой из потоков – A или B – первым

получит возможность закончить свою работу. Но как в том, так и

в другом случае часть информации окажется потерянной, хотя все

исправления были успешно внесены. Сохранится только изменение,

сделанное потоком, который последним занесет запись о клиенте

в базу данных. Здесь также имеет место эффект гонок.

В данном примере критической секцией потока A являются A1,

A2, A3, а потока B – B1, B2, B3.

Для исключения описанного эффекта по отношению к критическим

данным необходимо обеспечить, чтобы в каждый момент времени в

критической секции, связанной с этими данными, находился только

один поток. При этом неважно, в активном или приостановленном

состоянии

он

находится.

Этот

прием

называют

взаимным

исключением. Следует отметить, что вне критических секций потоки

должны иметь возможность работать параллельно.

Более точно проблема формулируется так.

Пусть имеется мультипрограммная система с общей памятью.

Каждая

из

программ,

выполняемых

процессором,

содержит

критическую секцию, в которой организован доступ к общим данным.

Программы

выполняются

циклически.

Необходимо

так

запрограммировать доступ к общей памяти, чтобы в любой момент

только одна из программ находилась в своей критической секции.

Относительно системы сделаны следующие предположения:

1) Считывание из общей памяти и запись в нее – неделимые

операции. Одновременные обращения (на запись или на считывание)

к одной и той же ячейке памяти более чем одного процесса

приведут к последовательным обращениям в произвольном порядке.

2) Критические

секции

не

могут

иметь

связанных

с

ними

приоритетов.

3) Относительные скорости процессов неизвестны.

4) Программа может останавливаться вне критической секции (КС).

Требования к критическим секциям:

в любой момент времени только один процесс может находиться в

своей критической секции;

ни один процесс не должен находиться в своей критической

секции бесконечно долго;

ни один процесс не должен ждать бесконечно долго входа в свой

критический интервал;

если процесс, находящийся в своем критическом интервале,

завершается либо естественным, либо аварийным путем, то режим

взаимоисключения должен быть отменен, с тем, чтобы другие

процессы получили возможность входить в свои критические

секции.

61

ЛЕКЦИЯ 11 (2/04/04)

2.3 Способы реализации взаимного исключения

Будем предполагать, что система циклических потоков для

проблемы критической секции имеет следующие программные формы:

parbegin

P1: while true do

Begin CS1; program_1; end;

P2: while true do

Begin CS2; program_2; end;

...

Pn: while true do

Begin CSn; program_n; end;

parend

Здесь

управляющая

конструкция

parbegin

...

parend

используется

для

указания

на

то,

что

часть

программы,

заключенная

между

этими

операторами,

должна

выполняться

параллельно. Через идентификатор

CS с номером обозначены

критические секции каждого потока, program_1, program_2, …,

program_n

представляют собой те части потоков, которые не

обращаются к общим данным и могут работать параллельно без каких

бы то ни было ограничений.

Самый простой и самый неэффективный способ обеспечения

взаимного исключения состоит в том, что ОС позволяет потоку

запрещать любые прерывания на время его нахождения в критической

секции. Но доверять управление системой пользовательскому потоку

опасно – он может надолго занять процессор, а при крахе потока в

критической секции крах потерпит вся система, т.к. прерывания

никогда не будут разрешены.

Пусть проблема ограничена двумя потоками. Нашей целью

является недопущение одновременного вхождения обоих потоков в их

критические секции, т.е. взаимное исключение. В то же время

должны быть устранены два возможных типа блокировки:

1) Поток, нормально работающий вне своей КС, не должен

блокировать другой поток при вхождении последнего в свою КС.

2) Два потока, готовые войти в свои КС, не должны откладывать

неопределенно долго решение вопроса о том, который из них войдет

в свою КС первым.

Рассмотрим различные методы решения данной проблемы и покажем

ловушки, которые при этом возникают.

62

1) Проблема решается легко, если потребовать, чтобы потоки

входили в свои КС попеременно. Одна общая переменная может

хранить указатель на то, чья очередь войти в КС. Рассмотрим

программную реализацию этого варианта (назовем его вариант 1).

Здесь переменная turn указывает то, какой поток должен

входить в критическую секцию. Каждый из потоков работает в

бесконечном цикле.

Program Variant1;

Var turn : integer; {общая переменная}

Procedure process_1;

Begin

While true Do

Begin

While turn=2 Do;

{активное ожидание}

CS1;

turn:=2;

program_1;

End;

End;

Procedure process_2;

Begin

While true Do

Begin

While turn=1 Do;

CS2;

turn:=1;

program_2;

End;

End;

Begin

turn:=1;

Parbegin

process_1;

process_2;

Parend

End.

{активное ожидание}

{процессы работают параллельно}

Возможные неприятности: если первый из потоков гораздо медленнее

другого, такое решение будет неэффективным. Может возникнуть

ситуация, когда поток 2, выполнив работу в своей КС, передаст

очередь первому потоку, затем выполнит действия вне своей КС и

снова начнет на нее претендовать, а тот еще даже не соберется

заходить в КС. Тем самым он блокирует второй поток по первому

типу, хотя программа и не может оказаться в состоянии полного

тупика. Если же один из процессов завершится раньше другого, то

второй вообще окажется не в состоянии продолжить выполнение. В

рассмотренном примере мы имеем дело с жесткой синхронизацией.

2) Во второй версии программы делается попытка устранить

указанные недостатки путем введения двух общих переменных

CS1_in, CS2_in – флагов, которые будут указывать на то,

63

находится ли каждый поток внутри своей критической секции. При

такой организации более быстрый поток может несколько раз подряд

войти в свой критический интервал, если другому потоку это пока

не нужно. Рассмотрим текст программы.

Program Variant2;

Var CS1_in, CS2_in: Boolean;

Procedure process_1;

Begin

While true Do

Begin

While CS2_in Do;

{активное ожидание}

CS1_in:=true; CS1; CS1_in:=false;

program_1;

End;

End;

Procedure process_2;

Begin

While true Do

Begin

While CS1_in Do;

CS2_in:=true; CS2;

program_2;

End;

End;

{активное ожидание}

CS2_in:=false;

Begin

CS1_in:=false;

CS2_in:=false;

Parbegin

process_1;

process_2;

Parend

End.

В данном варианте process_1 остается в состоянии активного

ожидания до тех пор, пока

CS2_in

имеет значение "истина".

Когда process_2 выйдет из своего критического участка, он

выполняет собственный код "выход взаимоисключения", устанавливая

для переменной CS2_in значение "ложь". После этого process_1

устанавливает для переменной CS1_in значение "истина" и входит в

свой критический участок. Недостатки предыдущего варианта здесь

устранены, взаимное блокирование теперь невозможно, но зато оба

процесса могут оба одновременно начать выполнять свои входные

последовательности взаимоисключения.

Пусть первый процесс проверил переменную CS2_in и обнаружил,

что она имеет значение "ложь", но изменить значение своей

переменной CS1_in не успел, в то время как второй процесс

проделал то же самое. Тогда в результате выполненных проверок

они оба одновременно войдут в свои критические интервалы, так

что программа данной версии не гарантирует взаимного исключения.

Существует еще ряд вариантов взаимоисключения, но все они не

свободны

от

недостатков.

Рассмотрим

алгоритм

реализации

взаимоисключения, предложенный Деккером. Он не требует никаких

специальных аппаратно-реализованных команд и позволяет избежать

64

недостатков рассмотренных алгоритмов.

В

этом

алгоритме

каждому

из

процессов

соответствует

логическая переменная, принимающая значение "истина", если этот

процесс претендует на вход в критический интервал. Переменная

turn принимает значения, соответствующие номеру выбранного на

выполнение процесса.

Program Variant_Dekker;

Var turn : 1,2;

p1_wants_to_come, p2_wants_to_come : Boolean;

Procedure process_1;

Begin

While true Do

Begin

p1_wants_to_come:=true;

{претендует на вход в КС}

While p2_wants_to_come Do {второй тоже}

If turn=2 Then

Begin

p1_wants_to_come:=false; {отказ от входа в КС}

While turn=2 Do;

{активное ожидание}

p1_wants_to_come:=true; {снова претендует на КС}

End

CS1;

turn:=2;

p1_wants_to_come:=false;

{отказ от входа в КС}

program_1;

End;

End;

Procedure process_2;

Begin

While true Do

Begin

p2_wants_to_come:=true;

{претендует на вход в КС}

While p1_wants_to_come Do {второй тоже}

If turn=1 Then

Begin

p2_wants_to_come:=false; {отказ от входа в КС}

While turn=1 Do;

{активное ожидание}

p2_wants_to_come:=true; {снова претендует на КС}

End

CS2;

turn:=1;

p2_wants_to_come:=false;

{отказ от входа в КС}

program_2;

End;

End;

Begin

p1_wants_to_come:=false;

p2_wants_to_come:=false;

turn:=1;

Parbegin

process_1; process_2;

Parend

End.

65

Рассмотрим, как работает такой вариант. Первый процесс

сообщает

о

своем

желании

войти

в

критическую

секцию,

устанавливая

свой

флаг

(p1_wants_to_come:=true).

Затем

он

переходит к циклу, в котором проверяет, не хочет ли и другой

процесс войти в свою критическую секцию, т.е. каково значение

переменной p2_wants_to_come. Если нет (переменная имеет значение

"ложь"), то он пропускает тело цикла ожидания и успешно входит в

свою критическую секцию. Если же первый процесс обнаруживает,

что флаг второго процесса тоже установлен, то он входит в цикл

ожидания. Здесь он проверяет, какой процесс выбран – анализирует

значение переменной turn. Если turn=1, т.е. его очередь

выполняться, он пропускает тело своего цикла и снова выполняет

цикл проверки в ожидании того момента, когда второй процесс

сбросит свой флаг. Если же выбран второй процесс (turn=2), то

первый процесс сбрасывает свой флаг и блокируется в цикле

ожидания, пока избранным остается второй процесс. Сбрасыванием

своего флага он дает возможность второму процессу войти в свой

критический интервал.

Со временем второй процесс выйдет из критической секции и

выполнит свой код "выход взаимоисключения" – отдаст приоритет

первому процессу и сбросит свой флаг. Теперь у первого процесса

появляется возможность выйти из внутреннего цикла ожидания и

снова установить собственный флаг. Затем он выполняет внешний

цикл проверки. Если флаг второго процесса по-прежнему сброшен,

первый успешно входит в свою критическую секцию. Если же второй

процесс успел снова выразить желание попасть в критическую

секцию и поднял свой флаг, то первому придется войти в тело

внешнего цикла проверки, убедиться в своем преимущественном

праве на выполнение и подождать, пока второй процесс откажется

от входа и сбросит флаг.

Предложенный алгоритм представляет собой программное решение

проблемы

взаимоисключения.

В

нем

решены

как

проблема

взаимодействия потоков с разными скоростями, так и проблемы

бесконечного откладывания и взаимного выполнения. Существуют и

способы аппаратного решения

Недостатком алгоритма Деккера является то, что во время

нахождения одного из процессов в критической секции, другой

впустую циклится и проверяет общие переменные, тем самым вызывая

общее замедление системы, не выполняя при этом никакой полезной

работы.

ЛЕКЦИЯ 12 (9/04/04)

2.4 Семафоры и их применение

Понятия, относящиеся к проблеме взаимоисключения, Дейкстра

обобщил в своей концепции семафоров. Семафор – это переменная

специального типа, которая доступна параллельным процессам для

проведения

над

ней

только

двух

операций:

"закрытия"

и

"открытия", названных соответственно P- и V-операциями. Значение

семафора можно опрашивать и менять только при помощи примитивов

P и V и операции инициализации. Семафоры могут быть двоичными

(принимать значения только 0 или 1) или считающими (принимать

целые неотрицательные значения). Операции P и V неделимы в своем

66

выполнении и взаимно исключают друг друга. Примитивы P и V

значительно упростили синхронизацию процессов.

Семафорный механизм работает по схеме, в которой сначала

исследуется состояние критического ресурса, идентифицируемое

значением семафора, а затем уже осуществляется допуск к

критическому ресурсу или отказ от него на некоторое время. При

отказе доступа к критическому ресурсу используется режим

"пассивного ожидания". Поэтому в состав механизма включаются

средства

формирования

и

обслуживания

очереди

ожидающих

процессов,

которые

реализуются

супервизором

операционной

системы. Находясь в списке заблокированных, процесс не проверяет

семафор непрерывно, как в случае активного ожидания. Вместо

этого процессор занимается полезной работой, что повышает

эффективность работы системы.

Пусть S – семафор. Операция V над семафором S записывается

как V(S) и увеличивает переменную S на единицу одним неделимым

действием, т.е. выборка, инкремент и запоминание не могут быть

прерваны, и к S нет доступа другим процессам во время операции

V(S). Операция P над семафором S записывается как P(S) и

уменьшает переменную S на единицу, если это возможно. Если было

S=0, то уменьшение S невозможно и процесс, вызвавший P-операцию,

ждет, пока значение S не увеличится. Проверка и уменьшение

значения S также являются одним неделимым действием.

Рассмотрим вариант реализации семафорных примитивов:

P(S): S:=S-1;

If S<0 Then

{остановить процесс и поместить его в

очередь ожидания к семафору S}

V(S): If S<0 Then

{поместить один из ожидающих процессов

очереди семафора S в очередь готовности};

S:=S+1;

Если несколько процессов одновременно запрашивают P- или Vоперации над одним и тем же семафором, то эти операции будут

выполняться последовательно в произвольном порядке. Аналогично,

если несколько процессов ожидают выполнения

P-операции и

изменяемый семафор становится положительным, то процесс на

продолжение выполнения может выбираться по произвольному закону.

Участки взаимоисключения по семафору S в параллельных процессах

обрамляются операциями P(S) и V(S).

Для работы с семафорными переменными необходимо еще иметь

операцию инициализации самого семафора, т.е. операцию задания

ему начального значения. Обычно эту операцию называют InitSem и

она, как правило, имеет два параметра – имя семафорной

переменной и ее начальное значение. Обращение к ней тогда будет

иметь, например, следующий вид: InitSem(S,1).

В настоящее время используется много различных видов

семафорных

механизмов.

Варьируемыми

параметрами,

которые

отличают различные виды примитивов, являются начальное значение

и

диапазон

изменения

значений

семафора,

логика

действий

семафорных

операций,

количество

семафоров,

доступных

для

обработки при исполнении отдельного примитива. В некоторых

реализациях семафорные переменные могут быть отрицательными, и

67

величина отрицательного значения в таком случае указывает на

длину очереди процессов, стоящих в состоянии ожидания открытия

семафора.

Семафоры и операции над ними могут быть реализованы как

программно,

так

и

аппаратно.

Программно

они

могут

быть

реализованы с использованием режима активного ожидания, однако

это сопряжено с потерей эффективности. Как правило, они

реализуются в ядре операционной системы, где осуществляется

управление сменой состояния процессов.

Семафорные операции дают простое решение проблемы КС. Пусть S

– семафор, используемый для защиты КС. Тогда примитив P(S)

представляет собой вход взаимоисключения, а примитив V(S) –

выход

взаимоисключения.

Рассмотрим

пример

программы,

обеспечивающей взаимоисключение при помощи семафора.

Program example_semaphore1;

Var S : semaphore;

Procedure process_1;

Begin

While true Do

Begin

P(S);

CS1;

V(S);

program_1;

End;

End;

Procedure process_2;

Begin

While true Do

Begin

P(S);

CS2;

V(S);

program_2;

End;

End;

Begin

InitSem(S,1);

Parbegin

process_1; process_2;

Parend

End.

Семафор имеет начальное значение, равное 1. Если первый и

второй процессы попытаются одновременно выполнить примитив P(S),

то

это

удастся

успешно

сделать

только

одному

из

них.

Предположим, что это сделал первый процесс. Он закрыл семафор,

т.е. значение семафора стало S = 0, после чего данный процесс

вошел в свой критический интервал. Второй процесс при этом

оказывается заблокированным на семафоре – при попытке выполнения

операции P(S) он "засыпает". Взаимное исключение гарантировано,

т.к. только один процесс может уменьшить значение S до нуля с

68

помощью

P-операции.

Очевидным

образом

это

решение

распространяется на случай n процессов – тогда все другие

процессы, пытающиеся войти в свои КС при S = 0, будут вынуждены

ожидать

по

P(S).

Взаимное

блокирование

невозможно,

т.к.

одновременные попытки войти в свои КС при S = 0 должны, по

определению, преобразовываться в последовательные P-операции.

После выхода из своей КС процесс выполняет V-операцию, тем самым

открывая

семафор

и

предоставляя

возможность

"пробуждения"

блокированным процессам. Тогда один из блокированных процессов

переводится в очередь готовности.

При реализации возможно одно из двух решений в отношении

процессов, которые переводятся из очереди ожидания в очередь

готовности при выполнении примитива V(S):

процесс при его активизации вновь пытается выполнить

примитив P, считая предыдущую попытку неуспешной;

процесс при помещении его в очередь готовности отмечается

как успешно выполнивший примитив P. Тогда при его активизации

управление будет передано не на повторное выполнение

примитива P, а на команду, следующую за ним.

При первом способе возможна следующая последовательность

событий. Предположим, что начальное значение семафора было равно

единице. Пусть процесс2 в какой-то момент времени выполнит

операцию P(S), семафор S станет равным нулю, а процесс2 войдет в

свою КС. Далее процесс1 тоже попытается выполнить операцию P(S)

и "заснет" на семафоре, поскольку значение семафора теперь

станет равным –1. После выхода из КС процесс2 выполнит V(S), при

этом значение семафора станет равным 0, а процесс1 переведется в

очередь готовности. После активизации процесс1 снова выполнит

P(S) и опять "уснет", то же самое произойдет с процессом2, если

он пожелает войти в свою КС. "Пробуждать" процессы станет

некому.

Таким

образом,

возможно

возникновение

тупиковой

ситуации.

При втором способе реализации тупиковой ситуации не будет.

Действительно, при аналогичном варианте развития событий отличие

начнется с момента активизации процесса1. Он сразу войдет в свою

КС. При этом никакой другой процесс не попадет в критическую

секцию, т.к. семафор остается закрытым (его значение равно 0).

После окончания работы процесса1 в КС в результате выполнения им

операции V(S) значение семафора установится в единицу, если

другие процессы не совершали попыток попасть в КС. Если

процесс2, а также и другие процессы в случае их большего

количества, во время работы процесса1 в КС также выполнят

примитив P(S), то после выполнения процессом1 V-операции семафор

установится в 0. Следовательно, он будет закрыт для всех

процессов кроме того, который успел выполнить P-операцию, т.е.

сделал заявку на КС. Таким образом, тупик не возникнет, а

взаимоисключение гарантировано.

Возникновение тупиков возможно в случае несогласованного

выбора механизма реактивации процессов из очереди, с одной

стороны, и выбора алгоритмов семафорных операций – с другой (как

мы видим в первом способе реализации).

69

Реализация семафорных примитивов

В однопроцессорной вычислительной системе неделимость P- и Vопераций можно обеспечить с помощью простого запрета прерываний.

Сам семафор S можно реализовать записью с двумя полями. В одном

поле хранится целое значение S, во втором – указатель на список

процессов, заблокированных на семафоре S. Рассмотрим схематичное

представление

одного

из

программных

вариантов

реализации

рассмотренных примитивов и процедуры инициализации.

Program semaphore_release;

Type Semaphore : Record

счетчик : Integer;

указатель : Pointer;

end;

Var S : Semaphore;

Procedure P(Var S:Semaphore);

Begin

ЗАПРЕТИТЬ ПРЕРЫВАНИЯ;

S.счетчик:= S.счетчик-1;

If S.счетчик<0 Then

WAIT(S); {ПОСТАВИТЬ

ОБРАТИВШИЙСЯ

ПРОЦЕСС

В

СПИСОК

S.указатель И

УСТАНОВИТЬ НА ПРОЦЕССОР ГОТОВЫЙ

ВЫПОЛНЕНИЮ ПРОЦЕСС}

РАЗРЕШИТЬ ПРЕРЫВАНИЯ;

End;

Procedure V(Var S:Semaphore);

Begin

ЗАПРЕТИТЬ ПРЕРЫВАНИЯ;

S.счетчик:= S.счетчик+1;

If S.счетчик<=0 Then

RELEASE(S);

{ДЕБЛОКИРОВАТЬ

S.указатель}

РАЗРЕШИТЬ ПРЕРЫВАНИЯ;

End;

ПЕРВЫЙ

ПРОЦЕСС

ИЗ

СПИСКА

ПО

К

ПО

Procedure InitSem(Var S:Semaphore, n:Integer);

Begin

S.счетчик:=n;

S.указатель:=nil;

End;

2.5 Проблема производителя и потребителя

Каждый процесс в ВС может быть охарактеризован числом и типом

ресурсов, которые он использует (потребляет) и освобождает

(производит). Это могут быть различные ресурсы – основная

память, заполненные буферы, критические секции и т.п. Семафоры

могут быть использованы для учета ресурсов и для синхронизации

процессов, а также для запирания критических секций.

В случае, когда один процесс для своего продолжения должен

получить некоторое сообщение от другого процесса, для их

синхронизации

используются

семафоры.

Тогда

первый

процесс

блокируется, выполняя P-операцию, а пробуждается выполнением V-

70

операции другим процессом. Рассмотрим пример программы с такой

синхронизацией.

Program example_semaphore2;

Var S : semaphore;

Procedure process_1;

Begin

While true Do

Begin

. . .

P(S);

{ждать сигнала от процесса 2}

. . .

End;

End;

Procedure process_2;

Begin

While true Do

Begin

. . .

V(S);

. . .

End;

End;

{послать сигнал процессу 1}

Begin

InitSem(S,1);

Parbegin

process_1;

process_2;

Parend

End.

Процесс_1 можно рассматривать как потребляющий некоторый

ресурс, обозначенный S, посредством команды P(S), а процесс_2 –

как производящий этот ресурс посредством команды V(S).

Процесс-производитель

вырабатывает

информацию

и

затем

добавляет ее в буферную память; параллельно с этим процесспотребитель удаляет информацию из буферной памяти и затем

обрабатывает

ее.

Например,

потребитель

является

процессом

вывода, удаляющим запись асинхронно из буферной памяти и затем

печатающим ее.

ЛЕКЦИЯ 13 (16/04/04)

Эту задачу можно обобщить на случай нескольких буферов.

Пусть буферная память состоит из n буферов одинакового

размера, причем каждый буфер может хранить одну запись.

Предположим, что добавление к буферу и изъятие из него